【R语言GPU计算入门】:一步解锁gpuR包的10大基础应用

发布时间: 2024-11-11 03:46:43 阅读量: 9 订阅数: 18

# 1. GPU计算简介与R语言基础

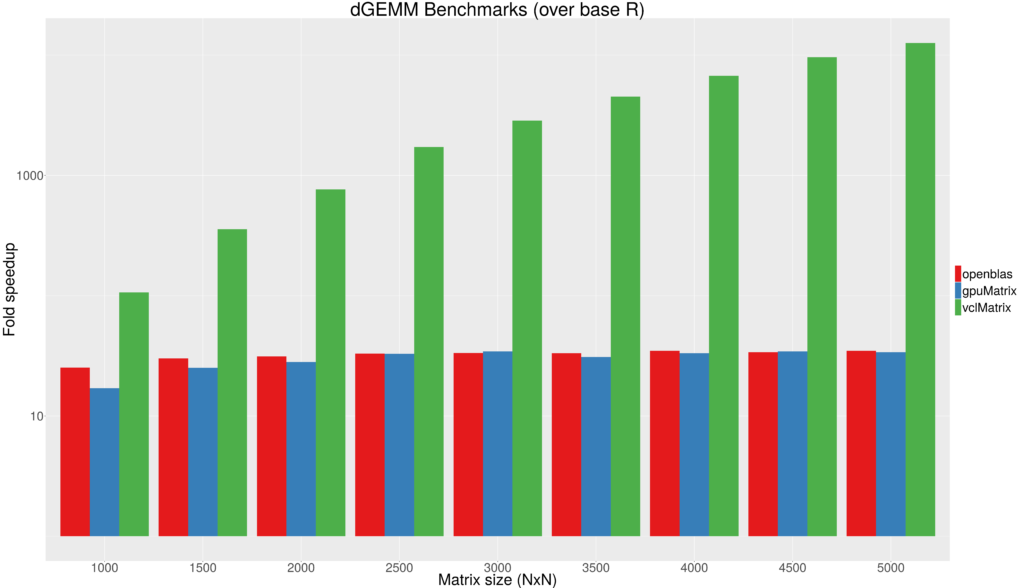

在现代计算机系统中,GPU(图形处理单元)已经超越了其传统的图形处理角色,发展成为强大的并行计算设备。GPU的高吞吐量和多核心架构特别适合处理高度并行化的任务,如图形渲染、深度学习和数据分析。R语言作为一种广泛应用于统计分析和数据科学的编程语言,其社区积极推动了R与GPU计算的融合。

## 1.1 GPU计算的优势

GPU计算通过利用其成百上千的核心同时工作,实现了数据处理的显著加速。相比于CPU,GPU在处理高度并行的任务时可以提供更高的性能。

## 1.2 R语言的特性

R语言具备强大的数据处理、统计分析和图形显示功能,但其原生计算能力受限于单线程的执行模型。随着 gpuR 包的出现,R用户现在可以利用GPU来加速其数据分析任务。

## 1.3 结合GPU计算与R语言

将GPU计算集成到R语言中,使得数据分析变得更加高效,尤其在处理大规模数据集时,可以实现前所未有的速度提升。接下来的章节将会详细介绍如何在R中使用gpuR包,以及如何通过GPU加速向量化和并行计算。

# 2. R语言中的gpuR包安装与配置

## 2.1 安装gpuR包的基本步骤

安装`gpuR`包是一个直接且高效的过程,因为它是R语言的开源包,允许用户在支持CUDA的GPU上进行数值计算。首先,确保您的系统已经安装了CUDA Toolkit。以下是安装`gpuR`包的基本步骤:

```R

# 在R环境中安装gpuR包

install.packages("gpuR")

```

为了确保安装成功,你可以运行以下命令检查`gpuR`包是否正确加载:

```R

library(gpuR)

```

若系统返回没有错误,则意味着gpuR包已成功安装在你的R环境中。

### 2.1.1 CUDA Toolkit安装和配置

在安装`gpuR`包之前,需要确保CUDA Toolkit已经安装在你的系统中。以下是CUDA Toolkit的安装步骤:

1. 访问NVIDIA的CUDA下载页面,根据你的GPU架构和操作系统下载相应的CUDA Toolkit版本。

2. 运行下载的安装程序,并遵循安装向导完成安装。

3. 配置环境变量,确保`PATH`和`LD_LIBRARY_PATH`包括CUDA的bin和lib64目录。

### 2.1.2 检查GPU硬件与CUDA兼容性

安装CUDA后,你需要验证你的GPU硬件与CUDA版本的兼容性。你可以使用NVIDIA提供的`deviceQuery`示例程序来检查:

```bash

# 将以下代码保存为 deviceQuery.cu

#include <stdio.h>

#include <cuda_runtime.h>

int main() {

printf("%s Starting...\n", CUTSignature());

int count;

cudaGetDeviceCount(&count);

printf("There are %d CUDA Devices.\n", count);

for (int i = 0; i < count; i++) {

cudaDeviceProp deviceProp;

cudaGetDeviceProperties(&deviceProp, i);

printf("Device %d: %s\n", i, deviceProp.name);

printf(" CUDA Capability Major/Minor version number: %d.%d\n", deviceProp.major, deviceProp.minor);

printf(" Total amount of global memory: %zu bytes\n", deviceProp.totalGlobalMem);

// 其他需要的信息

}

printf("%s Completed.\n", CUTEndSignature());

return 0;

}

```

然后在命令行中编译并运行它:

```bash

nvcc deviceQuery.cu -o deviceQuery

./deviceQuery

```

这段程序将列出所有检测到的设备,并打印出它们的CUDA兼容性信息。

## 2.2 gpuR包的高级配置选项

安装`gpuR`包并确认CUDA环境无误后,你可能还需要进行一些高级配置以确保最佳性能。`gpuR`包提供了多种选项来优化GPU计算性能。

### 2.2.1 GPU设备选择

如果系统中有多块GPU,可以通过`gpuDevice`函数来选择特定的GPU设备进行计算。

```R

# 显示所有可用设备

gpuDevices()

# 选择特定的GPU设备

gpuDevice(1) # 选择第一块GPU

```

### 2.2.2 GPU内存管理

`gpuR`包允许你设置内存分配大小,以适应不同的工作负载需求。

```R

# 分配特定大小的GPU内存

gmem <- gpuMemory(size = 1e9) # 为计算分配1GB的GPU内存

```

### 2.2.3 错误检查与处理

在GPU计算过程中,错误检查是保证程序稳定运行的重要环节。`gpuR`包提供了一些函数来检查和处理可能发生的CUDA错误。

```R

# 检查是否有CUDA错误发生

gpuErrchk昆仑( cudaMalloc((void**)&d_a, size) )

```

在上述代码中,`gpuErrchk`函数被用来检查`cudaMalloc`操作是否成功,如果发生错误,它将打印错误信息。

### 2.2.4 性能调试

调试GPU程序时,了解性能瓶颈是优化的关键。`gpuR`包提供了一些工具来进行性能分析。

```R

# 开始性能计时

gpuTimerStart()

# 结束性能计时并返回时间

gpuTimerEnd()

```

通过记录操作前后的计时,你可以获得GPU执行代码的时间,这有助于识别和优化性能瓶颈。

通过以上步骤,`gpuR`包就能在R语言中被有效安装和配置,为你在GPU计算上的研究和工作提供支持。在下章中,我们将深入了解`gpuR`包的向量化计算功能,并探讨其在R语言中的具体应用。

# 3. gpuR包的向量化计算

在数据科学领域,向量化操作一直是提升性能的关键技术。在本章节中,我们将深入探讨向量化操作的基本概念,特别是它们在R语言中的实现,以及如何利用gpuR包来优化这些计算。

## 3.1 向量化操作的基本概念

### 3.1.1 向量化与R语言的兼容性

向量化是一个允许向量元素以并行方式操作的特性,与传统的循环遍历数组或列表相比,向量化通常能大幅提高计算效率。R语言是一种矢量化编程语言,这意味着它在设计时就考虑到了对向量化操作的支持。然而,R语言默认的执行环境是在CPU上,这在处理大数据集时可能会导致性能瓶颈。

gpuR包提供了一种方式,可以在R环境中利用GPU的并行计算能力。gpuR包中的向量化函数可以直接在GPU上执行,避免了将数据传输回CPU的开销,从而显著提升了计算性能。

### 3.1.2 向量化操作的优势和限制

向量化操作的优势在于其简洁性和效率。它允许一次性对整个数据集执行操作,而不是一次处理一个数据点。在CPU上,这通常涉及到SIMD(单指令多数据)技术;而在GPU上,则是利用成百上千的核心进行并行处理。

然而,向量化也有其局限性。并非所有的操作都可以向量化,一些复杂的、依赖于顺序数据的操作可能无法有效地利用向量化。此外,向量化操作虽然在GPU上效率很高,但启动GPU计算仍有一定的开销,对于极小的数据集而言,向量化可能不会带来预期的性能提升。

## 3.2 向量化计算的实例应用

### 3.2.1 矩阵和数组的GPU加速运算

在矩阵运算中,向量化尤其有用,因为它可以利用GPU的并行架构来同时执行大量的矩阵操作。以下是一个使用gpuR包中的`gpu_matrix_mult`函数实现的矩阵乘法示例:

```r

library(gpuR)

# 创建两个GPU矩阵

m1 <- gpu_matrix(rnorm(10000), nrow=100)

m2 <- gpu_matrix(rnorm(10000), nrow=100)

# 在GPU上执行矩阵乘法

result <- gpu_matrix_mult(m1, m2)

# 将结果移回CPU内存

result_cpu <- as.array(result)

```

在上述代码中,我们首先创建了两个GPU矩阵,然后使用`gpu_matrix_mult`函数将它们相乘。最后,我们使用`as.array`函数将结果从GPU内存中复制回CPU内存。请注意,对于大规模矩阵运算,数据在CPU和GPU之间的传输可能成为瓶颈,因此实际操作中可能需要考虑这一点。

### 3.2.2 大数据集的快速处理

处理大数据集时,向量化计算可以显著减少计算时间。下面是一个使用gpuR包处理大型数据集的示例,我们将对一个大型矩阵进行转置操作:

```r

library(gpuR)

# 创建一个大型GPU矩阵

large_matrix <- gpu_matrix(rnorm(1000000), nrow=1000)

# 在GPU上执行矩阵转置

transpose_matrix <- gpu_transpose(large_matrix)

# 将结果移回CPU内存

transpose_cpu <- as.array(transpose_matrix)

```

在此示例中,我们生成了一个含有100万个元素的大型矩阵,并使用gpuR包中的`gpu_transpose`函数来执行转置操作。相较于在CPU上进行同样操作,GPU版本可以大幅提升处理速度,尤其是在矩阵规模非常大的情况下。

我们可以通过比较GPU和CPU执行这些操作所需的时间来进行性能测试:

```r

# CPU版本的矩阵乘法

start_time_cpu <- Sys.time()

cpu_result <- m1 %*% m2

end_time_cpu <- Sys.time()

cpu_duration <- end_time_cpu - start_time_cpu

# GPU版本的矩阵乘法

start_time_gpu <- Sys.time()

gpu_result <- gpu_matrix_mult(m1, m2)

end_time_gpu <- Sys.time()

gpu_duration <- end_time_gpu - start_time_gpu

# 输出时间对比

print(paste("CPU Duration:", cpu_duration))

print(paste("GPU Duration:", gpu_duration))

```

通过这种比较,我们可以直观地看到GPU加速的效果。实际上,向量化操作的性能提升在处理更大规模的数据时更为显著。

以上示例展示了如何在R语言中使用gpuR包进行向量化计算,以及如何通过这些操作来优化大数据集的处理。在后续的章节中,我们将进一步探讨gpuR包的并行计算能力,以及如何将其应用于深度学习和机器学习任务中,实现更高级的计算优化。

# 4. gpuR包的并行计算

并行计算是高性能计算的核心,它通过同时使用多个计算资源来加速计算任务的执行。在本章中,我们将深入探讨并行计算的理论框架,并通过实际操作展示如何在R语言中利用gpuR包实现并行计算,从而显著提高数据分析和模型训练的效率。

## 4.1 并行计算理论框架

并行计算不仅仅是硬件的问题,它同样涉及到算法设计、任务调度等多个层面。在展开实例操作之前,我们需要了解一些并行计算的基本原理以及GPU在其中的应用。

### 4.1.1 并行计算的原理

并行计算的核心在于将任务分割为可以同时执行的多个子任务,并通过多线程或多进程的方式,在多个计算节点上同时处理这些子任务。这样可以充分利用现代计算机的多核处理器、多处理器系统或分布式计算集群的能力,大幅缩短计算时间。

在并行计算中,有几个关键概念需要掌握:

- **任务分割(Decomposition)**:将一个大任务分解为多个小任务。

- **任务分配(Assignment)**:将这些小任务分配给不同的计算资源。

- **同步(Synchronization)**:处理任务间的数据依赖和协作。

- **负载平衡(Load balancing)**:确保计算资源的合理利用,避免某些资源空闲而其他资源过载。

### 4.1.2 GPU架构在并行计算中的角色

GPU(图形处理器)最初是为图形渲染而设计的,但其架构特别适合处理可以并行化的任务。GPU具有成百上千的核心,使得它可以在每个核心上执行不同的线程,适合执行高度并行的任务,如矩阵运算、深度学习等。

GPU的并行计算能力使其在科学计算、机器学习等领域得到广泛应用。NVIDIA的CUDA架构和AMD的ROCm平台为GPU提供了丰富的并行计算开发工具,而gpuR包则将这些功能暴露给R语言用户,使得并行计算变得更加简单和高效。

## 4.2 并行计算的实际操作

现在,我们将通过一系列具体操作来展示如何在R语言中使用gpuR包来实现并行计算。

### 4.2.1 gpuR包实现的简单并行示例

我们首先通过一个简单的向量运算来演示gpuR包如何实现并行计算。

```r

# 安装并加载gpuR包

if (!require(gpuR)) {

install.packages("gpuR")

library(gpuR)

}

# 创建一个较大的向量

vector_size <- 1e6

vec_a <- runif(vector_size)

vec_b <- runif(vector_size)

# 使用gpuR包中的gpuMatrix进行并行向量加法

gpu_a <- gpuMatrix(vec_a, nrow=1)

gpu_b <- gpuMatrix(vec_b, nrow=1)

# 执行并行计算

result <- gpu_a + gpu_b

```

在上述代码中,我们首先创建了两个随机浮点数向量,然后使用`gpuMatrix`函数将这些向量加载到GPU内存中。通过直接对GPU中的矩阵进行操作,R语言能够利用GPU的并行计算能力来加速运算。在实际操作中,你可能会注意到并行计算后的结果会比在CPU上逐个计算要快得多。

### 4.2.2 高级并行计算应用案例

接下来,我们通过一个更复杂的示例来展示如何利用gpuR包来处理大规模数据集的并行计算。我们将实现一个简单的神经网络,用以演示GPU在深度学习任务中的加速作用。

```r

# 定义一个简单的神经网络结构

neural_network <- function(input, weights1, weights2) {

hidden_layer <- input %*% weights1

hidden_layer <- pmax(hidden_layer, 0) # ReLU激活函数

output_layer <- hidden_layer %*% weights2

return(output_layer)

}

# 生成随机权重矩阵

weights1 <- gpuMatrix(rnorm(vector_size^2), nrow=vector_size)

weights2 <- gpuMatrix(rnorm(vector_size), nrow=1)

# 模拟一个较大的输入数据集

input_data <- gpuMatrix(rnorm(vector_size^2), nrow=vector_size)

# 执行并行神经网络计算

system.time(output <- neural_network(input_data, weights1, weights2))

```

在这个案例中,我们首先定义了一个简单的两层神经网络结构,其中包含一个隐藏层和一个输出层。通过在GPU上创建矩阵,并使用矩阵运算来模拟神经网络的前向传播过程,我们可以在几秒钟内完成百万量级数据的处理和模型运算。

以上代码展示了gpuR包在并行计算方面的强大功能,特别是在处理大规模数据集和复杂的机器学习模型时。这仅仅是一个简单的例子,实际应用中可以将 gpuR包与深度学习框架如TensorFlow或Keras结合,进一步提升计算效率。

以上就是gpuR包在并行计算方面的应用介绍,通过理论框架和实际操作的结合,希望读者能够对R语言中的并行计算有一个全面而深入的理解。

# 5. gpuR包的深度学习与机器学习应用

## 5.1 gpuR包在深度学习中的应用

深度学习作为AI领域的一个重要分支,在图像识别、自然语言处理、预测分析等众多领域都有广泛的应用。GPU的并行处理能力非常适合深度学习中对大规模矩阵运算和复杂网络训练的需求。R语言虽然不是深度学习的主流编程语言,但借助于 gpuR 包,我们可以在 R 环境中实现深度学习模型的加速。

### 5.1.1 深度学习模型构建与GPU加速

在使用 gpuR 包进行深度学习模型构建时,我们首先需要了解 GPU 加速在深度学习中的作用。GPU 加速可以大幅提升模型训练时的矩阵运算速度,尤其是对于包含多个隐藏层的神经网络。在 gpuR 包中,可以使用 `gpuArray` 函数将数据集转换到 GPU 中进行加速计算。

以下是一个简单的神经网络训练示例,使用 gpuR 包加速:

```R

library(gpuR)

library(gpuTensorflow) # 在 gpuR 环境中使用 TensorFlow

# 将数据加载到 GPU 中

x_train <- gpuArray(x_train)

y_train <- gpuArray(y_train)

# 构建模型

model <- keras_model_sequential() %>%

layer_dense(units = 64, activation = 'relu', input_shape = c(input_shape)) %>%

layer_dense(units = 10, activation = 'softmax')

# 编译模型

model %>% compile(

loss = 'categorical_crossentropy',

optimizer = optimizer_adam(),

metrics = 'accuracy'

)

# 训练模型

model %>% fit(x_train, y_train, epochs = 10, batch_size = 32)

```

### 5.1.2 实际案例分析:GPU加速的神经网络训练

下面通过一个实际案例,进一步说明 gpuR 包在神经网络训练中的应用。假设我们使用卷积神经网络 (CNN) 对手写数字进行分类。

```R

library(keras)

library(gpuTensorflow)

# 加载 MNIST 数据集

mnist <- dataset_mnist()

train_images <- mnist$train$x / 255

train_labels <- mnist$train$y

# 将数据加载到 GPU 中

train_images <- gpuArray(train_images)

train_labels <- gpuArray(train_labels)

# 构建 CNN 模型

model <- keras_model_sequential() %>%

layer_conv_2d(filters = 32, kernel_size = c(3,3), activation = 'relu', input_shape = c(28, 28, 1)) %>%

layer_max_pooling_2d(pool_size = c(2, 2)) %>%

layer_conv_2d(filters = 64, kernel_size = c(3,3), activation = 'relu') %>%

layer_max_pooling_2d(pool_size = c(2, 2)) %>%

layer_flatten() %>%

layer_dense(units = 10, activation = 'softmax')

# 编译模型

model %>% compile(

loss = 'sparse_categorical_crossentropy',

optimizer = optimizer_adadelta(),

metrics = 'accuracy'

)

# 训练模型

model %>% fit(train_images, train_labels, epochs = 5, batch_size = 128)

```

在这个案例中,我们使用了 `layer_conv_2d` 和 `layer_max_pooling_2d` 来构建卷积层和池化层,这在处理图像数据时非常有效。通过 `gpuArray` 函数将输入数据加载到 GPU,模型训练速度得到显著提升。GPU 加速不仅使得模型训练时间缩短,还使得深度学习变得可行,特别是在处理大规模数据集时。

## 5.2 gpuR包在机器学习中的应用

虽然 gpuR 主要是为了支持深度学习和大规模矩阵运算而设计,但它同样可以加速某些机器学习算法的训练过程。

### 5.2.1 GPU加速的机器学习算法实现

GPU 加速的机器学习算法主要集中在那些可以并行化的算法上,比如随机森林、梯度提升树等。以下是一个使用 gpuR 包加速随机森林算法的例子:

```R

library(gpuR)

library(gpuRandomForest)

# 生成一些模拟数据

set.seed(123)

x <- matrix(rnorm(1e5 * 100), nrow = 1e5)

y <- factor(sample(0:1, 1e5, replace = TRUE))

# 将数据转换为 gpuArray

x <- gpuArray(x)

y <- gpuArray(y)

# 训练随机森林模型

rf_model <- gpuRandomForest(x, y, ntree = 100, mtry = 10)

```

在这个例子中,`gpuRandomForest` 函数执行了随机森林的训练过程。尽管相较于深度学习,机器学习算法通常不会受益于同样程度的 GPU 加速,但在大数据集上,即使是有限的加速也是很有意义的。

### 5.2.2 机器学习模型的评估与优化

机器学习模型的评估和优化是任何数据科学项目的关键步骤。在使用 gpuR 包进行机器学习模型训练后,我们需要评估模型性能并对模型进行优化。

评估模型性能通常包括对模型的准确度、召回率、精确度、F1 分数等指标的计算。优化过程可能涉及到调整模型参数、使用交叉验证等技术。

由于篇幅限制,这里不详细展示评估与优化的代码,但这些步骤在 R 语言中与其他类型的机器学习模型是类似的。借助于 GPU 加速,我们可以更快地完成这些流程,尤其在进行大规模超参数搜索和模型验证时。

通过第五章的内容,我们可以看出 gpuR 包在 R 语言中的深度学习和机器学习领域的应用潜力。尽管在一些方面,它可能不像专门的深度学习框架那样强大,但 gpuR 包为那些喜欢使用 R 语言的用户提供了一种加速计算的可行方式。下一章我们将探讨 gpuR 包在实际工作流程中的优化策略和最佳实践。

0

0