【揭秘递归神经网络(RNN)的奥秘】:从入门到精通,掌握RNN建模核心技术

发布时间: 2024-08-20 09:25:54 阅读量: 22 订阅数: 40

# 1. 递归神经网络(RNN)基础理论

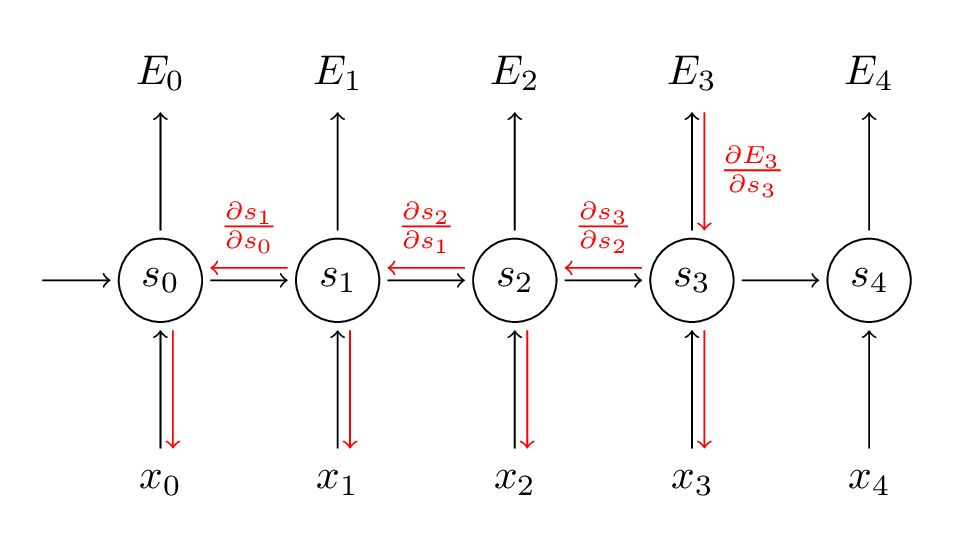

递归神经网络(RNN)是一种特殊类型的神经网络,它能够处理序列数据,例如文本、语音和时间序列。RNN通过将前一时间步的信息传递到当前时间步,从而捕获序列中的依赖关系。

### RNN的基本结构

RNN的基本结构是一个循环单元,它由一个隐藏状态和一个输出状态组成。隐藏状态存储了序列中过去的信息,而输出状态则表示当前时间步的输出。在每个时间步,循环单元接收一个输入并更新其隐藏状态和输出状态。

### RNN的优点

RNN的优点包括:

* 能够处理任意长度的序列数据

* 可以捕获序列中的长期依赖关系

* 适用于各种序列处理任务,例如自然语言处理、计算机视觉和时间序列分析

# 2. RNN建模技术实践

### 2.1 RNN的变种和应用

#### 2.1.1 LSTM

**长短期记忆网络(LSTM)**是RNN的一种变体,它通过引入记忆单元来解决梯度消失和梯度爆炸问题。LSTM的记忆单元包含三个门:输入门、遗忘门和输出门。

**输入门**控制新信息进入记忆单元的程度。

**遗忘门**控制现有记忆单元中信息的保留程度。

**输出门**控制记忆单元中信息输出到隐藏状态的程度。

LSTM的结构如下:

```python

def lstm_cell(x, h, c):

"""LSTM单元。

参数:

x: 输入数据。

h: 隐藏状态。

c: 记忆单元。

返回:

h: 更新后的隐藏状态。

c: 更新后的记忆单元。

"""

f = sigmoid(W_f @ [x, h] + b_f) # 遗忘门

i = sigmoid(W_i @ [x, h] + b_i) # 输入门

o = sigmoid(W_o @ [x, h] + b_o) # 输出门

g = tanh(W_g @ [x, h] + b_g) # 新的候选值

c = f * c + i * g # 更新记忆单元

h = o * tanh(c) # 更新隐藏状态

return h, c

```

**参数说明:**

* `W_f`, `W_i`, `W_o`, `W_g`: 权重矩阵。

* `b_f`, `b_i`, `b_o`, `b_g`: 偏置向量。

**逻辑分析:**

LSTM单元通过门控机制控制信息流,从而避免了梯度消失和梯度爆炸问题。输入门决定了新信息的引入程度,遗忘门决定了现有信息的保留程度,输出门决定了信息输出到隐藏状态的程度。

#### 2.1.2 GRU

**门控循环单元(GRU)**是另一种RNN变体,它通过合并LSTM的输入门和遗忘门来简化结构。GRU的结构如下:

```python

def gru_cell(x, h):

"""GRU单元。

参数:

x: 输入数据。

h: 隐藏状态。

返回:

h: 更新后的隐藏状态。

"""

z = sigmoid(W_z @ [x, h] + b_z) # 更新门

r = sigmoid(W_r @ [x, h] + b_r) # 重置门

g = tanh(W_g @ [x, r * h] + b_g) # 新的候选值

h = (1 - z) * h + z * g # 更新隐藏状态

return h

```

**参数说明:**

* `W_z`, `W_r`, `W_g`: 权重矩阵。

* `b_z`, `b_r`, `b_g`: 偏置向量。

**逻辑分析:**

GRU单元通过更新门和重置门来控制信息流。更新门决定了新信息的引入程度,重置门决定了现有信息的保留程度。GRU的结构比LSTM更简单,但性能与LSTM相当。

### 2.2 RNN的训练和优化

#### 2.2.1 梯度消失和梯度爆炸

RNN训练中遇到的一个主要挑战是梯度消失和梯度爆炸问题。

**梯度消失**是指随着RNN层数的增加,梯度在反向传播过程中逐渐减小,导致网络难以学习长距离依赖关系。

**梯度爆炸**是指梯度在反向传播过程中逐渐增大,导致网络不稳定。

#### 2.2.2 训练技巧和超参数调优

为了解决梯度消失和梯度爆炸问题,可以使用以下训练技巧:

* **梯度截断:**将梯度的范数限制在一定范围内。

* **梯度正则化:**对梯度进行正则化,以防止其过大或过小。

* **学习率衰减:**随着训练的进行,逐渐降低学习率,以防止梯度爆炸。

此外,超参数调优也是优化RNN训练的关键。需要调整的超参数包括:

* **学习率:**控制梯度更新的步长。

* **批次大小:**训练数据的批次大小。

* **隐藏单元数:**RNN隐藏层的单元数。

* **层数:**RNN的层数。

# 3.1 RNN在文本分类中的应用

#### 3.1.1 文本预处理和表示

在将文本数据输入到RNN模型之前,需要进行预处理,以将文本转换为模型可以理解的格式。文本预处理通常包括以下步骤:

- **分词:**将文本分割成一个个单词或词组。

- **去除停用词:**去除常见的、不具有信息量的单词,如“the”、“and”、“of”。

- **词干提取:**将单词还原为其基本形式,如“running”还原为“run”。

- **词嵌入:**将单词转换为稠密向量表示,以捕获单词之间的语义关系。

#### 3.1.2 RNN模型的构建和训练

构建用于文本分类的RNN模型涉及以下步骤:

1. **选择RNN变种:**根据任务选择合适的RNN变种,如LSTM或GRU。

2. **定义网络结构:**确定RNN层的数量、隐藏单元的数量以及激活函数。

3. **初始化权重:**随机初始化模型权重或使用预训练的词嵌入。

4. **训练模型:**使用交叉熵损失函数和反向传播算法训练模型。

```python

import tensorflow as tf

# 定义RNN模型

model = tf.keras.Sequential([

tf.keras.layers.Embedding(vocab_size, embedding_dim),

tf.keras.layers.LSTM(units=128),

tf.keras.layers.Dense(num_classes)

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=10)

```

**代码逻辑分析:**

- `Embedding`层将单词转换为稠密向量表示。

- `LSTM`层处理序列数据,捕获文本中的时序关系。

- `Dense`层将RNN输出转换为分类概率。

- `compile`方法指定优化器、损失函数和评估指标。

- `fit`方法使用训练数据训练模型。

#### 3.1.3 优化和评估

优化RNN模型的文本分类性能涉及以下技巧:

- **超参数调优:**调整学习率、批次大小和隐藏单元数量等超参数。

- **正则化:**使用L1或L2正则化来防止过拟合。

- **数据增强:**使用数据增强技术,如随机丢弃和添加噪声,来增加训练数据的多样性。

- **评估指标:**使用准确率、召回率和F1分数等指标来评估模型性能。

# 4. RNN在计算机视觉中的应用

### 4.1 RNN在图像分类中的应用

#### 4.1.1 卷积神经网络(CNN)与RNN的结合

卷积神经网络(CNN)在图像分类任务中表现出色,但其对时间信息的建模能力有限。RNN可以弥补这一缺陷,通过处理图像序列或图像的局部区域来捕获时间信息。

#### 4.1.2 RNN在图像分类中的应用

RNN在图像分类中的应用主要有以下几种:

- **图像序列分类:**RNN可以处理图像序列,例如视频帧或图像序列,并预测序列的类别。

- **局部图像分类:**RNN可以应用于图像的局部区域,例如对象或区域,以预测区域的类别。

- **图像分类与时序信息:**RNN可以将图像分类与时序信息相结合,例如图像序列中的时间顺序或图像中对象的运动轨迹。

### 4.2 RNN在视频分析中的应用

#### 4.2.1 视频序列建模

RNN可以对视频序列进行建模,捕获视频帧之间的时序关系。这对于视频分析任务至关重要,例如:

- **动作识别:**RNN可以识别视频中的人体动作,例如走路、跑步或跳跃。

- **行为分析:**RNN可以分析视频中的人类行为,例如社交互动、手势识别或异常行为检测。

#### 4.2.2 动作识别和行为分析

RNN在动作识别和行为分析中的应用包括:

- **双向RNN (Bi-RNN):**Bi-RNN可以同时处理视频序列的过去和未来帧,从而提高动作识别的准确性。

- **卷积LSTM (ConvLSTM):**ConvLSTM结合了CNN和LSTM,利用卷积操作提取空间特征,同时利用LSTM捕获时序信息。

- **注意力机制:**注意力机制允许RNN关注视频序列中重要的区域或帧,从而提高动作识别和行为分析的性能。

### 代码示例

#### 图像分类

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class ImageClassifier(nn.Module):

def __init__(self, num_classes):

super(ImageClassifier, self).__init__()

self.cnn = nn.Conv2d(3, 64, 3)

self.rnn = nn.LSTM(64, 128)

self.fc = nn.Linear(128, num_classes)

def forward(self, x):

x = self.cnn(x)

x = x.view(x.size(0), -1)

x, _ = self.rnn(x)

x = self.fc(x)

return x

```

#### 视频分析

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class VideoAnalyzer(nn.Module):

def __init__(self, num_classes):

super(VideoAnalyzer, self).__init__()

self.convlstm = nn.ConvLSTM(3, 64, 3)

self.rnn = nn.LSTM(64, 128)

self.fc = nn.Linear(128, num_classes)

def forward(self, x):

x = self.convlstm(x)

x = x.view(x.size(0), -1)

x, _ = self.rnn(x)

x = self.fc(x)

return x

```

### 逻辑分析

#### 图像分类

- CNN提取图像的空间特征,而RNN捕获序列或局部区域的时间信息。

- RNN的输出被输入到全连接层,以预测图像的类别。

#### 视频分析

- ConvLSTM结合CNN和LSTM,提取空间和时序特征。

- RNN进一步处理ConvLSTM的输出,捕获更高级别的时序关系。

- 全连接层将RNN的输出映射到视频的类别。

# 5. RNN在时间序列分析中的应用

### 5.1 RNN在预测中的应用

#### 5.1.1 时间序列预测的基本原理

时间序列预测是指根据过去一段时间的数据,预测未来某个时刻的值。它广泛应用于金融、气象、医疗等领域。

时间序列预测通常采用以下步骤:

1. **数据收集和预处理:**收集相关的时间序列数据,并进行预处理,如缺失值填充、数据平滑等。

2. **特征提取:**从时间序列数据中提取特征,如趋势、季节性、周期性等。

3. **模型选择和训练:**选择合适的预测模型,如RNN、ARMA、SARIMA等,并使用历史数据训练模型。

4. **模型评估和预测:**使用验证集评估模型的性能,并对未来数据进行预测。

#### 5.1.2 RNN在时间序列预测中的应用

RNN在时间序列预测中具有优势,因为它能够捕捉时间序列中的序列依赖性。以下是一些常见的RNN时间序列预测模型:

- **SimpleRNN:**最简单的RNN模型,适用于短期预测。

- **LSTM:**长短期记忆网络,适用于长期预测,能够处理梯度消失问题。

- **GRU:**门控循环单元,类似于LSTM,但结构更简单,训练速度更快。

```python

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.preprocessing import MinMaxScaler

from keras.models import Sequential

from keras.layers import LSTM, Dense

# 加载数据

df = pd.read_csv('time_series_data.csv')

data = df['value'].values

# 归一化数据

scaler = MinMaxScaler(feature_range=(0, 1))

data = scaler.fit_transform(data.reshape(-1, 1))

# 划分训练集和测试集

train_size = int(len(data) * 0.8)

train_data = data[:train_size]

test_data = data[train_size:]

# 创建LSTM模型

model = Sequential()

model.add(LSTM(units=50, return_sequences=True, input_shape=(train_data.shape[1], 1)))

model.add(LSTM(units=50))

model.add(Dense(units=1))

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error')

# 训练模型

model.fit(train_data, train_data, epochs=100, batch_size=32)

# 预测未来值

predictions = model.predict(test_data)

# 反归一化预测值

predictions = scaler.inverse_transform(predictions)

# 绘制预测结果

plt.plot(test_data, label='真实值')

plt.plot(predictions, label='预测值')

plt.legend()

plt.show()

```

### 5.2 RNN在异常检测中的应用

#### 5.2.1 异常检测的基本原理

异常检测是指识别与正常数据模式明显不同的数据点。它在欺诈检测、故障诊断等领域有着重要的应用。

异常检测通常采用以下步骤:

1. **数据收集和预处理:**收集相关的时间序列数据,并进行预处理,如缺失值填充、数据平滑等。

2. **特征提取:**从时间序列数据中提取特征,如趋势、季节性、周期性等。

3. **模型选择和训练:**选择合适的异常检测模型,如RNN、Isolation Forest、One-Class SVM等,并使用正常数据训练模型。

4. **异常检测:**使用训练好的模型对新数据进行异常检测,并识别出异常数据点。

#### 5.2.2 RNN在异常检测中的应用

RNN在异常检测中具有优势,因为它能够捕捉时间序列中的序列依赖性。以下是一些常见的RNN异常检测模型:

- **LSTM-AE:**LSTM自编码器,将正常数据编码为低维表示,异常数据会产生较大的重建误差。

- **GRU-OCSVM:**GRU与One-Class SVM相结合,利用GRU提取特征,并使用One-Class SVM进行异常检测。

- **RNN-Isolation Forest:**RNN与Isolation Forest相结合,利用RNN捕捉序列依赖性,并使用Isolation Forest进行异常检测。

```python

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.preprocessing import StandardScaler

from keras.models import Sequential

from keras.layers import LSTM, Dense

# 加载数据

df = pd.read_csv('time_series_data.csv')

data = df['value'].values

# 归一化数据

scaler = StandardScaler()

data = scaler.fit_transform(data.reshape(-1, 1))

# 划分训练集和测试集

train_size = int(len(data) * 0.8)

train_data = data[:train_size]

test_data = data[train_size:]

# 创建LSTM-AE模型

model = Sequential()

model.add(LSTM(units=50, return_sequences=True, input_shape=(train_data.shape[1], 1)))

model.add(LSTM(units=50))

model.add(Dense(units=1))

# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error')

# 训练模型

model.fit(train_data, train_data, epochs=100, batch_size=32)

# 预测重建误差

reconstruction_errors = np.mean(np.square(model.predict(test_data) - test_data), axis=1)

# 阈值设定

threshold = np.quantile(reconstruction_errors, 0.99)

# 异常检测

anomalies = np.where(reconstruction_errors > threshold)[0]

# 绘制异常检测结果

plt.plot(test_data, label='真实值')

plt.scatter(anomalies, test_data[anomalies], color='red', label='异常点')

plt.legend()

plt.show()

```

# 6. RNN的最新进展和未来展望

### 6.1 RNN的变种和创新

近年来,RNN的研究取得了显著进展,出现了多种RNN的变种和创新,极大地扩展了RNN的应用范围。

**6.1.1 Transformer**

Transformer是谷歌在2017年提出的神经网络模型,它完全基于注意力机制,抛弃了RNN的循环结构。Transformer通过自注意力机制,能够捕捉序列中元素之间的远程依赖关系,在自然语言处理任务中取得了突破性的进展。

**6.1.2 Graph Neural Networks**

图神经网络(GNN)是一种专门用于处理图结构数据的深度学习模型。GNN通过将图结构信息编码到神经网络中,可以有效地处理复杂关系和交互。GNN在社交网络分析、推荐系统和药物发现等领域有着广泛的应用。

### 6.2 RNN的应用拓展

RNN的应用领域也在不断拓展,除了在自然语言处理、计算机视觉和时间序列分析等传统领域之外,RNN还被应用到生物信息学和金融领域。

**6.2.1 生物信息学**

RNN在生物信息学中被用于分析基因序列、预测蛋白质结构和识别疾病生物标记。例如,循环神经网络(RNN)可以用来预测基因表达水平,帮助研究人员了解基因调控机制。

**6.2.2 金融领域**

RNN在金融领域被用于预测股票价格、分析市场趋势和识别欺诈行为。例如,长短期记忆网络(LSTM)可以用来预测股票价格的未来走势,帮助投资者做出更明智的决策。

0

0