Python日志与微服务:在分散日志中保持一致性策略

发布时间: 2024-10-06 22:01:39 阅读量: 35 订阅数: 41

# 1. Python日志系统的理论基础

## 1.1 Python日志的概念和重要性

日志记录是任何软件开发过程中的关键组成部分,它允许开发者追踪软件运行过程中的各种事件,包括错误、警告和系统活动。Python作为一种流行的编程语言,同样内置了强大的日志记录机制。日志的重要性体现在其对于问题诊断、监控系统健康、性能优化、安全审计以及合规性要求等方面的价值。

## 1.2 日志级别和格式标准

Python中的日志级别从高到低依次为CRITICAL、ERROR、WARNING、INFO和DEBUG。合理设置日志级别可以帮助开发人员根据需求筛选出重要信息。同时,日志格式通常遵循一定的标准,比如ISO8601日期和时间格式,以保证信息的可读性和一致性。

## 1.3 Python日志系统的构成

一个典型的Python日志系统由记录器(Logger)、处理器(Handler)、格式化器(Formatter)和过滤器(Filter)四个主要组件构成。记录器负责产生日志消息,处理器决定如何处理这些消息,格式化器定义了消息的格式,而过滤器则用于控制哪些日志消息应该被处理。

```python

import logging

# 创建一个记录器

logger = logging.getLogger('my_logger')

logger.setLevel(logging.DEBUG) # 设置日志级别

# 创建一个控制台处理器

console_handler = logging.StreamHandler()

# 创建一个格式化器

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

# 将格式化器添加到处理器

console_handler.setFormatter(formatter)

# 将处理器添加到记录器

logger.addHandler(console_handler)

# 记录不同级别的日志消息

logger.debug('This is a debug message')

***('This is an info message')

logger.warning('This is a warning message')

logger.error('This is an error message')

logger.critical('This is a critical message')

```

以上代码创建了一个日志系统,演示了如何使用Python标准库中的logging模块来创建日志记录器、处理器、格式化器,并记录不同级别的日志。

# 2. 微服务架构下的日志管理

在现代IT架构中,微服务架构由于其灵活性和扩展性,已经成为了企业构建应用的首选模式。不过,随着服务拆分的细化,日志管理也变得复杂。本章节我们将深入探讨微服务架构下的日志管理,从其重要性到具体的构建方法,再到一致性日志的实践,为读者提供一套完整的微服务日志管理方案。

## 2.1 微服务日志的重要性

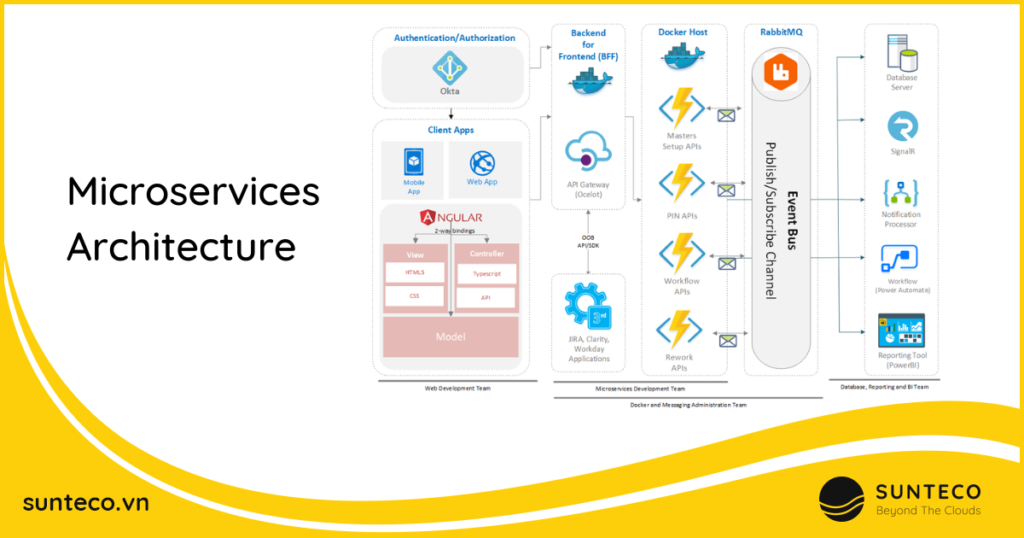

### 2.1.1 微服务架构简介

微服务架构是一种将单一应用程序开发为一组小服务的方法,每个服务运行在自己的进程中,并使用轻量级的通信机制相互通信。服务通常围绕业务能力构建,并通过完全自动化部署机制独立部署。这些服务的集中管理很少,可以使用不同的编程语言编写,并使用不同的数据存储技术。

微服务架构的提出旨在解决单体应用的复杂性问题,让大型系统的开发、部署和维护变得更加容易。每个微服务都可以独立开发、测试、部署和扩展,提高了系统的可维护性和可扩展性。

### 2.1.2 日志在微服务中的作用

在微服务架构中,日志的作用尤为重要。日志是服务运行时信息的记录,是系统健康状况的“体检报告”。在微服务架构中,每一个服务都可能是独立的个体,服务间的通信、服务的状态变化、错误信息都需要通过日志来记录和追踪。

此外,微服务架构中的服务数量众多,因此日志的可追踪性、可查询性和可聚合性变得极为关键。在发生故障或性能瓶颈时,能够迅速定位问题所在,往往依赖于日志的记录质量与搜索效率。

## 2.2 分布式日志系统的构建

### 2.2.1 分布式日志系统的组成

分布式日志系统通常由以下几个关键组件构成:

- **日志收集器**:负责从各个服务实例中收集日志数据。它可以是文件监听、API调用或者代理服务。

- **日志聚合器**:负责接收来自收集器的日志数据,对数据进行清洗和预处理,然后将处理后的数据进行存储。

- **日志存储**:负责存储经过处理的日志数据,这些存储可以是传统的数据库,也可以是适合于日志存储的分布式文件系统,如HDFS。

- **日志查询接口**:允许用户通过特定的查询语言,如ELK的Kibana中的Lucene Query,查询日志数据。

### 2.2.2 日志收集和聚合策略

为了有效地收集和聚合日志数据,可以采用以下策略:

- **集中式日志收集**:将所有日志集中到一个日志聚合平台,如ELK(Elasticsearch, Logstash, Kibana)或Fluentd+InfluxDB。

- **日志路由**:根据日志的重要性级别、来源服务等对日志进行路由,路由到不同的处理流程。

- **批处理与流处理**:对日志数据进行批处理以支持大规模的日志分析,或者使用流处理实时处理日志数据。

### 2.2.3 日志索引和搜索机制

建立一个高效的日志索引和搜索机制,是分布式日志系统的关键。使用倒排索引可以加快日志搜索的速度,使得基于关键字的搜索变得非常高效。搜索机制应该支持复杂的查询语句,并能够提供时间范围、关键字、字段等多维度的搜索功能。

## 2.3 一致性日志实践

### 2.3.1 CAP理论与日志一致性

CAP理论指出,分布式系统不可能同时满足以下三个条件:

- 一致性(Consistency):每次读取都能获得最新的数据或者错误。

- 可用性(Availability):每个请求都能得到一个(无论成功或者失败的)响应。

- 分区容错性(Partition tolerance):系统可以在任何网络分区的情况下继续运行。

在分布式日志系统中,我们通常会选择一致性(CP)或者可用性(AP)策略。选择时需要考虑到业务的需求以及系统的设计目标。

### 2.3.2 一致性哈希在日志管理中的应用

一致性哈希是一种将哈希值映射到数据节点的分布式算法。在日志管理中,一致性哈希可以用于数据的分片和负载均衡,确保数据均匀分布在不同的服务器上,即使在节点增加或减少的情况下,也能最小化数据的迁移。

### 2.3.3 实现日志一致性的技术选型

实现一致性的技术选型通常包括以下几种:

- **基于Raft或Paxos算法的分布式一致性协议**:确保日志数据在各节点间保持一致性。

- **使用数据库事务保证写入一致性**:确保单个写入操作在所有副本上都成功或失败。

- **采用消息队列保障日志传输的一致性**:使用消息队列的事务性消息机制,确保消息被正确地顺序处理。

在本章节中,我们通过深入讨论了微服务架构下日志管理的必要性,并详细剖析了分布式日志系统的构建方法。本章节的后面部分,我们还将探讨一致性日志在实际操作中的实践,确保系统的稳定性和可靠性。

# 3. Python与日志系统的实践应用

### 3.1 Python日志记录的实践技巧

#### 3.1.1 Python内置日志模块的使用

Python的内置日志模块`logging`提供了一种灵活的机制来记录应用程序中的事件信息。我们可以使用该模块记录警告、错误、调试信息以及常规的信息日志。

下面是一个基本的使用案例:

```python

import logging

# 创建一个logger

logger = logging.getLogger('my_logger')

logger.setLevel(logging.DEBUG)

# 创建一个handler,用于写入日志文件

fh = logging.FileHandler('my_log.log')

fh.setLevel(logging.DEBUG)

# 再创建一个handler,用于将日志输出到控制台

ch = logging.StreamHandler()

ch.setLevel(logging.WARN)

# 定义handler的输出格式

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

fh.setFormatter(formatter)

ch.setFormatter(formatter)

# 给logger添加handler

logger.addHandler(fh)

logger.addHandler(ch)

# 记录不同级别的日志

logger.debug('This is a debug message')

***('This is an info message')

logger.warn('This is a warning message')

logger.error('This is an error message')

logger.critical('This is a critical message')

```

在上面的代码中,我们首先创建了一个logger对象,并通过`getLogger`方法获取了一个名为`my_logger`的logger实例。然后,我们设置该logger的级别为DEBUG,这意味着所有

0

0