Python日志管理全攻略:基础到高级的18个实用技巧

发布时间: 2024-10-06 20:57:56 阅读量: 5 订阅数: 8

# 1. Python日志管理概述

Python是一种广泛使用的高级编程语言,它以简洁明了的语法著称。随着应用复杂性的增加,对于日志管理的需求也就越加复杂。Python中的日志管理是指通过记录程序运行过程中的相关信息,以便于开发者或系统管理员能够监控应用运行状态,快速定位问题,同时确保系统安全和稳定性。

在Python中,日志管理主要依赖于`logging`模块,该模块提供了一系列灵活的工具来记录不同级别(如DEBUG、INFO、WARNING、ERROR和CRITICAL)的日志信息。一个良好的日志管理策略不仅可以帮助开发者记录和调试程序,还可以在生产环境中监控和分析系统性能,甚至协助企业满足合规性要求。

为了全面地掌握Python日志管理,我们将从基础配置开始,深入探讨日志轮转、高级日志处理技巧以及性能优化等方面。本章将为读者提供一个整体的概览,为后续章节的深入学习打下坚实的基础。

# 2. 日志管理基础

## 2.1 Python中的日志模块

### 2.1.1 logging模块的基本使用

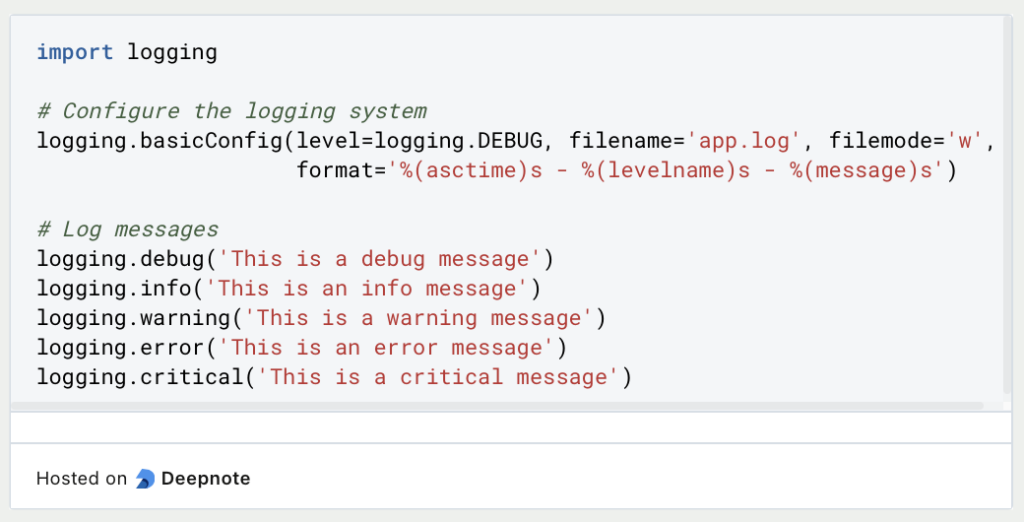

在Python程序中,日志记录是一个重要的组成部分,它可以帮助开发者监控程序运行状态,排查错误。Python标准库提供了`logging`模块,用于日志记录。

下面是一个简单的例子展示如何使用`logging`模块。

```python

import logging

# 配置日志的基本信息

logging.basicConfig(level=logging.DEBUG, format='%(asctime)s %(name)-12s %(levelname)-8s %(message)s')

# 记录不同级别的日志

logging.debug('This is a debug message')

***('This is an info message')

logging.warning('This is a warning message')

logging.error('This is an error message')

logging.critical('This is a critical message')

```

上述代码中,`basicConfig`函数用于设置日志的基础配置,其中`level`参数用于设置日志的级别,`format`参数用于定义日志的输出格式。日志级别从低到高分为`DEBUG`, `INFO`, `WARNING`, `ERROR`, `CRITICAL`。在Python中,默认的级别是`WARNING`,也就是说,只有`WARNING`级别以上的日志才会被输出。

### 2.1.2 配置日志的格式和级别

如上面的示例所示,通过`basicConfig`可以进行基本的配置,但`logging`模块支持更灵活的配置方式,允许我们对不同的级别、不同的模块或类定义不同的日志处理。

```python

import logging

# 创建一个日志器

logger = logging.getLogger('my_logger')

logger.setLevel(logging.DEBUG) # 设置日志级别

# 创建一个文件处理器

fh = logging.FileHandler('my_log.log')

# 设置文件处理器的日志级别

fh.setLevel(logging.DEBUG)

# 创建一个格式器

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

# 将格式器添加到文件处理器

fh.setFormatter(formatter)

# 将文件处理器添加到日志器

logger.addHandler(fh)

# 记录日志

logger.debug('This is a debug message')

***('This is an info message')

```

在这个配置中,我们首先创建了一个日志器对象`logger`。通过调用`setLevel`方法,我们指定了只有大于或等于`DEBUG`级别的日志才会被处理。接下来,我们创建了一个文件处理器`FileHandler`,并将其级别同样设置为`DEBUG`,这表示该处理器也将只处理`DEBUG`级别及以上的日志。通过设置一个格式器`formatter`并将其绑定到文件处理器上,我们可以自定义日志消息的输出格式。最后,通过`addHandler`方法将文件处理器添加到日志器对象,使日志器将日志消息输出到文件`my_log.log`中。

## 2.2 日志记录的最佳实践

### 2.2.1 如何选择合适的日志级别

选择合适的日志级别是日志记录的重要部分。以下是一些建议:

- **DEBUG**: 这个级别用于调试目的,记录了程序中所有的调试信息。在开发环境中,这些信息可以帮助开发者理解程序的运行流程,找出代码中的问题。

- **INFO**: 用于记录程序正常运行时的重要事件,但不是错误。这通常包括程序启动、关闭或是关键动作的发生。

- **WARNING**: 这个级别的信息表示可能出现问题,但程序依然可以运行。例如,使用了过时的API。

- **ERROR**: 用于记录程序运行中遇到的错误,但并不妨碍程序的继续运行。

- **CRITICAL**: 是最高级别的日志信息,这表示发生严重错误,程序可能无法继续运行。

在生产环境中,推荐只记录`WARNING`级别以上的日志,以避免产生过多的日志信息,影响系统的性能和日志文件的可读性。然而,在开发和调试阶段,更详尽的`DEBUG`和`INFO`级别日志可以帮助开发者快速定位问题。

### 2.2.2 日志记录的常见误区和优化

在进行日志记录时,以下是一些常见的错误和相应的优化策略:

- **日志级别滥用**: 不要将所有日志都记录在同一级别上,例如,始终使用`INFO`级别。这会导致重要的日志信息被忽略。优化策略是根据日志的重要性合理选择级别,并在不同的开发阶段调整日志级别。

- **过度详细**: 过度详细地记录日志(比如记录每一行代码执行情况)会大量增加磁盘I/O操作,占用更多的存储空间,影响程序性能。优化策略是只在需要调试时开启详细日志,并在生产环境中关闭。

- **硬编码日志信息**: 如果在代码中硬编码日志信息,如文件路径、日志级别等,这会导致代码的可配置性和可维护性变差。优化策略是使用配置文件或环境变量来管理这些信息。

- **不记录异常**: 记录异常是帮助开发者快速定位问题的有力工具。优化策略是在捕获异常时,将异常信息记录到日志中。

- **不考虑日志文件的管理**: 随着时间推移,日志文件可能会增长到非常大的尺寸,这将占用大量的磁盘空间。优化策略是实现日志轮转,定期清理旧的日志文件。

## 2.3 自定义日志处理

### 2.3.1 创建自定义日志处理器

Python允许开发者创建自定义的日志处理器,以便更灵活地控制日志消息的处理。下面是一个简单的自定义日志处理器的例子:

```python

import logging

# 自定义日志处理器

class CustomLogHandler(logging.Handler):

def emit(self, record):

msg = self.format(record)

print(f'[CustomLogHandler] {msg}') # 将日志输出到控制台

# 创建日志器

logger = logging.getLogger('CustomLogger')

logger.setLevel(logging.DEBUG)

# 创建自定义日志处理器实例

custom_handler = CustomLogHandler()

# 添加自定义处理器到日志器

logger.addHandler(custom_handler)

# 记录日志

logger.debug('This is a custom handler message')

```

在这个例子中,我们创建了一个名为`CustomLogHandler`的自定义日志处理器类,继承自`logging.Handler`。通过覆盖`emit`方法,我们可以定义日志信息的输出方式。在这个例子中,我们将日志输出到控制台。

### 2.3.2 集成第三方日志处理工具

除了使用Python标准库外,还可以集成第三方的日志处理工具,例如`Logbook`、`structlog`等,这些库提供了一些更为强大的功能和更好的性能。

```python

# 使用Logbook库

import logbook

# 创建一个日志记录器

logger = logbook.Logger('MyApp')

# 使用日志记录器记录日志

with logger:

***('This is a log message using Logbook')

# 查看日志输出

print(logbook.handlers日记志处理器中的日志)

```

在这个例子中,我们使用`logbook`库创建了一个日志记录器,并记录了一条信息。`logbook`库使用了Python的上下文管理器特性,这使得日志记录更为方便和清晰。集成第三方日志处理工具可以根据特定的项目需求提供更灵活和高效的日志管理方案。

# 3. 高级日志处理技巧

日志管理不仅仅是记录事件,更是一种确保系统透明度和可靠性的重要手段。在这一章节中,我们将深入探讨如何实现高级日志处理技巧,包括日志轮转和压缩、处理复杂的日志场景、以及高效地利用日志分析工具。

## 3.1 日志轮转和压缩

日志文件随着时间推移而增长,如果不进行适当的管理,将占用大量的存储空间。因此,日志轮转和压缩成为了提高日志存储效率的关键技术。

### 3.1.1 使用TimedRotatingFileHandler实现日志轮转

在Python中,logging模块提供了一个非常方便的方式来实现定时轮转日志文件。`TimedRotatingFileHandler`是实现这一功能的一个很好的例子。它会在指定的时间间隔后轮转日志文件。以下是如何使用`TimedRotatingFileHandler`实现日志轮转的代码示例:

```python

import logging

import logging.handlers

logger = logging.getLogger('TimedRotatingFileHandler Example')

logger.setLevel(logging.DEBUG)

# 创建一个日志处理器,设置文件名为"timed_example.log",并每隔5秒轮转一次

handler = logging.handlers.TimedRotatingFileHandler('timed_example.log', when='S', interval=5, backupCount=3)

logger.addHandler(handler)

# 记录日志信息

for _ in range(10):

logger.debug('A debug message')

```

参数说明:

- `when`:指定时间间隔的单位,可选值包括S(秒)、M(分钟)、H(小时)等。

- `interval`:时间间隔的数值。

- `backupCount`:保留的旧日志文件的最大数量。

在上面的代码中,每5秒会创建一个新的日志文件,并且旧的日志文件会被保留3个。超过这个数量的日志文件将被删除。

### 3.1.2 日志文件的压缩策略

日志文件的压缩可以通过多种方式实现,常见的策略包括在日志轮转时压缩旧的日志文件,并将它们移动到备份目录。压缩可以使用如`gzip`、`bzip2`等工具。下面是一个使用`gzip`来压缩日志文件的示例:

```python

import os

import logging.handlers

# 定义一个压缩日志的函数

def compress_log(log_path):

if not os.path.exists(log_path):

return

import gzip

import shutil

import time

# 获取当前时间戳

timestamp = int(time.time())

compressed_file_name = f"{log_path}.gz"

# 移动并压缩文件

shutil.move(log_path, compressed_file_name)

with open(compressed_file_name, 'rb') as f_in:

with gzip.open(f"{compressed_file_name}.gz", 'wb') as f_out:

shutil.copyfileobj(f_in, f_out)

# 删除原文件

os.remove(log_path)

# 假设有一个日志文件 "example.log"

compress_log('example.log')

```

在实际应用中,这个函数可以集成到日志轮转的流程中,例如,在删除旧的日志文件前先进行压缩处理。

## 3.2 处理复杂的日志场景

随着应用程序变得越来越复杂,日志管理也需要适应更多复杂场景。

### 3.2.1 异常情况下的日志记录

在异常情况下,应用程序可能会以非预期的方式崩溃,或者在运行中遇到错误。这种时候,异常日志就显得尤为重要。Python的`logging`模块提供了异常捕获和记录的功能。以下是如何在日志中记录异常信息的代码示例:

```python

import logging

logger = logging.getLogger('Exception Logger')

logger.setLevel(logging.ERROR)

# 创建一个处理器,将日志记录发送到控制台

handler = logging.StreamHandler()

formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')

handler.setFormatter(formatter)

logger.addHandler(handler)

try:

# 模拟一个错误

raise ValueError('This is a ValueError')

except Exception as e:

logger.error("An error occurred", exc_info=True)

```

参数说明:

- `exc_info`:当此参数为True时,将异常信息作为日志信息的一部分记录。

### 3.2.2 多线程或多进程环境下的日志同步

在多线程或多进程环境下记录日志时,需要考虑到线程安全和日志同步的问题。Python的日志模块提供了一个`Thread-safe`的方法来确保在多线程环境下的日志记录不会相互干扰。但是,对于多进程环境,通常需要使用文件锁来避免多个进程同时写入日志文件。

这里是一个简单的文件锁示例代码,用于在多进程环境中同步写入日志:

```python

import logging

import fcntl

def setup_logging():

# 创建一个日志记录器

logger = logging.getLogger('MultiProcess Logger')

logger.setLevel(***)

# 创建一个文件处理器

fh = logging.FileHandler('multiprocess.log')

fh.setLevel(***)

# 创建一个日志格式化器

formatter = logging.Formatter('%(asctime)s - %(message)s')

fh.setFormatter(formatter)

# 将处理器添加到记录器

logger.addHandler(fh)

return logger

def logging_worker(logger):

while True:

***('Process %s is logging' % os.getpid())

time.sleep(1)

if __name__ == "__main__":

logger = setup_logging()

processes = []

for i in range(5):

p = multiprocessing.Process(target=logging_worker, args=(logger,))

p.start()

processes.append(p)

for p in processes:

p.join()

```

上面的代码创建了5个进程,每个进程都会写入同一个日志文件。为了防止多个进程同时写入导致的日志损坏问题,我们需要实现一个锁机制。在Python中,可以使用`fcntl`模块来创建锁。

## 3.3 日志分析工具应用

日志分析工具可以帮助我们从大量的日志数据中提取有价值的信息,例如,识别错误模式、检测安全威胁等。

### 3.3.1 日志分析工具的选择和使用

市场上有许多日志分析工具可供选择,例如ELK Stack(Elasticsearch, Logstash, Kibana)、Splunk、Graylog等。这些工具提供了从日志收集、索引、搜索到可视化的全栈解决方案。

ELK Stack是一个强大的日志分析平台,可以处理TB级别的日志数据,并提供实时分析能力。下面是使用Filebeat和ELK Stack收集和分析日志的基本步骤:

1. 在需要监控日志文件的服务器上安装Filebeat。

2. 配置Filebeat的`filebeat.yml`文件,指定要监控的日志文件路径。

3. 配置输出到Elasticsearch或Logstash。

4. 启动Filebeat服务,开始发送日志数据。

5. 在Kibana中创建索引模式,开始搜索和分析日志。

### 3.3.2 日志数据的可视化展示

可视化工具能够帮助我们更直观地理解日志数据。Kibana是一个常用的可视化工具,它与ELK Stack结合使用可以创建仪表板,展示实时日志数据。通过创建图表、地图和表格等可视化组件,可以直观地展示日志数据的趋势和模式。以下是在Kibana中创建一个条形图的简单示例:

1. 在Kibana中,选择“Visualize”选项卡。

2. 点击“Create new visualization”按钮。

3. 选择“Bar chart”可视化类型。

4. 从字段列表中选择你想要展示的字段,比如日志级别。

5. 设置合适的聚合方式(比如计数)。

6. 调整可视化选项,比如图表的标题和轴标签。

7. 保存图表,并将其添加到仪表板中。

可视化工具可以提高日志分析的效率和准确性,帮助运维人员快速定位问题。

这一章节到此结束,我们已经探讨了如何通过高级技巧实现有效的日志管理,包括日志轮转、压缩以及复杂的日志场景处理,同时也介绍了如何运用日志分析工具进行数据可视化。在下一章节中,我们将深入了解日志管理实践案例,包括Web应用和分布式系统中的日志管理。

# 4. 日志管理实践案例

在当今的 IT 环境中,日志管理不仅仅是记录事件的简单实践,它是确保应用程序性能、安全和合规性的关键组成部分。本章节将深入探讨在不同应用场景下的日志管理实践案例,包括Web应用、分布式系统以及监控与报警机制的实现。

## 4.1 Web应用中的日志管理

Web应用是现代网络环境中的基石。Flask和Django作为Python中最流行的两个Web框架,它们对日志管理有着各自的支持和要求。

### 4.1.1 Flask和Django的日志配置

Flask框架使用Python的内置logging模块来处理日志记录。开发者通常通过配置logging模块来定义日志的格式和输出方式。一个基本的Flask应用配置示例如下:

```python

import logging

from flask import Flask

app = Flask(__name__)

# 定义日志记录器

app.logger.setLevel(***)

handler = logging.StreamHandler()

formatter = logging.Formatter('%(asctime)s %(name)-12s %(levelname)-8s %(message)s')

handler.setFormatter(formatter)

app.logger.addHandler(handler)

@app.route("/")

def home():

***("访问首页")

return "Hello World!"

if __name__ == "__main__":

app.run()

```

在Django中,日志系统也由logging模块提供,但Django也提供了高级的配置选项来增强日志记录。Django的默认日志配置可以通过修改`settings.py`中的`LOGGING`配置项来实现。

### 4.1.2 确保Web应用日志的安全和隐私

Web应用的日志记录需要特别注意隐私和安全问题。敏感信息不应直接记录在日志中,而应采取措施进行脱敏处理。此外,日志文件应存储在安全的位置,并通过加密等方式保护,以防未授权访问。

## 4.2 分布式系统的日志追踪

分布式系统为日志管理带来了新的挑战,包括跨服务的日志一致性、性能影响等问题。

### 4.2.1 集成分布式追踪系统(如Zipkin或Jaeger)

Zipkin和Jaeger等分布式追踪系统可以集成到微服务架构中,通过跨服务追踪请求的生命周期来帮助开发者理解系统行为。这些系统通常会收集和展示跨服务调用的延迟和流量信息,为性能优化和故障排除提供数据支撑。

### 4.2.2 分布式日志的一致性和完整性

在分布式系统中,确保日志的一致性和完整性是至关重要的。一种常见的做法是使用集中式日志存储解决方案,例如ELK Stack(Elasticsearch, Logstash, Kibana)。这种方法不仅能够保证日志的统一管理,还能够提高检索效率。

## 4.3 日志监控与报警机制

有效的日志监控和报警机制是快速响应系统问题和避免服务中断的关键。

### 4.3.1 利用日志触发实时报警

日志事件可以触发报警,及时通知开发或运维团队采取行动。使用如Alertmanager这样的工具,可以根据日志事件的严重性自动发送警报。

### 4.3.2 集成监控系统对日志进行分析和报警

现代监控系统如Prometheus配合Grafana可以有效地集成日志分析,提供实时的仪表盘和报警机制。这些系统可以检测异常模式,并在检测到异常时发送通知,帮助运维人员快速定位和解决问题。

在下一章节,我们将进一步深入探讨如何通过性能优化技术来提高日志系统的效率和可靠性。

# 5. Python日志管理的性能优化

## 5.1 日志系统的性能考量

### 5.1.1 I/O性能对日志记录的影响

日志记录是一个频繁进行I/O操作的过程。由于日志文件通常需要写入磁盘,所以I/O性能会直接影响到日志记录的效率。特别是当应用程序需要高频次记录日志时,I/O成为瓶颈的可能性更大。

为了避免I/O操作对日志记录造成性能瓶颈,可以采用以下策略:

- 使用异步日志记录来减少等待I/O操作完成的时间。

- 使用日志缓冲机制,将日志先存入内存,然后批量写入磁盘。

- 利用文件系统的特性,比如Linux下的`O_DIRECT`标志,绕过缓存直接写入磁盘。

以上措施能够有效提升日志系统的I/O性能,进而提高整体的应用性能。

### 5.1.2 日志级别对性能的影响

日志级别定义了日志信息的重要程度,对性能有着重要影响。在生产环境中,如果设置过低的日志级别(例如DEBUG),系统将会记录大量的细节信息,这不仅会增加磁盘I/O负担,还有可能影响性能。

为了减少不必要的性能开销,应当:

- 在开发和测试环境中使用较低的日志级别来帮助调试。

- 在生产环境中适当提高日志级别,只记录关键信息。

- 根据应用的需要,定制日志级别,确保记录的是最有用的信息。

合理地调整日志级别,可以提高应用的运行效率和日志记录的可维护性。

## 5.2 性能优化技巧

### 5.2.1 异步日志记录

在Python中,可以使用`logging`模块提供的异步处理功能,来减少I/O操作对应用性能的影响。`concurrent.futures`模块中的`ThreadPoolExecutor`和`ProcessPoolExecutor`可以用来创建线程池或进程池来异步执行日志记录操作。

例如,下面的代码展示了如何使用`ThreadPoolExecutor`来异步记录日志:

```python

from concurrent.futures import ThreadPoolExecutor

import logging

def setup_async_logging():

# 设置日志格式和级别

logging.basicConfig(format='%(asctime)s - %(levelname)s - %(message)s', datefmt='%Y-%m-%d %H:%M:%S', level=***)

# 创建一个线程池

pool = ThreadPoolExecutor(max_workers=1)

# 定义一个异步处理器

handler = logging.handlers.QueueHandler(pool)

# 获取并设置根日志器

logger = logging.getLogger()

logger.addHandler(handler)

# 使用logger进行日志记录

***('This is a test log entry')

setup_async_logging()

```

在这个例子中,`QueueHandler`将日志记录任务放入到队列中,并由线程池中的一个线程异步处理这些记录,这样可以有效避免日志记录造成的阻塞。

### 5.2.2 日志缓存策略和批量写入

为了减少日志记录时的I/O操作次数,可以使用日志缓存策略和批量写入技术。在`logging`模块中,可以使用`TimedRotatingFileHandler`或者`RotatingFileHandler`来实现日志文件的按时间或大小轮转。而`logging.handlers.MemoryHandler`可以实现将日志缓存在内存中,并在达到一定条件后批量写入磁盘。

下面是一个使用`MemoryHandler`的示例:

```python

import logging

from logging.handlers import MemoryHandler, RotatingFileHandler

def setup_memory_logging():

# 基础设置

formatter = logging.Formatter('%(asctime)s - %(levelname)s - %(message)s')

# 创建内存处理器,大小为100条日志

mem_handler = MemoryHandler(100, target=RotatingFileHandler('example.log', maxBytes=1000, backupCount=2))

mem_handler.setFormatter(formatter)

mem_handler.setLevel(***)

# 创建并设置根日志器

logger = logging.getLogger()

logger.setLevel(***)

logger.addHandler(mem_handler)

# 记录一些日志

for i in range(50):

***(f'Log entry #{i}')

# 当缓存满了以后,内存处理器会批量写入

mem_handler.flush()

setup_memory_logging()

```

在使用`MemoryHandler`时,应当注意选择合适的缓存大小,以保证应用的性能和内存使用不会受到影响。

## 5.3 优化案例分析

### 5.3.1 高流量应用的日志优化实例

对于需要处理高流量请求的应用程序,如大型电商平台或社交网络服务,日志记录会对性能产生较大影响。一个常见的优化策略是使用高性能的日志库,如`logbook`。

`logbook`使用了更灵活的日志记录机制,并提供了异步处理能力。以下是`logbook`的一个简单使用示例:

```python

from logbook import Logger, StreamHandler, handler

log = Logger('MyApp')

with handler(StreamHandler(sys.stdout)):

for _ in range(10000):

***('This is an info message')

```

在这个例子中,日志通过流处理器写入标准输出,可以实现异步处理。

### 5.3.2 大数据量下的日志处理策略

当应用产生大量日志数据时,传统的日志处理方式可能无法满足需求。此时,可以考虑使用分布式日志处理系统,如Apache Flume或Kafka,这些系统能够提供高吞吐量的日志数据传输能力。

下面是一个使用Apache Flume来处理大量日志数据的例子:

```bash

flume-conf.properties:

# 定义agent,包含一个source和一个sink

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# 配置source,这里使用exec源,用于监听文件变化

a1.sources.r1.type = ***

***mand = tail -F /var/log/syslog

# 配置sink,这里使用hdfs sink,用于将日志写入HDFS

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = /flume/events/%y-%m-%d/%H%M/%S

# 配置channel,这里使用memory channel

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# 将source和sink以及channel连接起来

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

```

在这个配置中,Flume配置了一个从`exec`源获取数据的agent,通过配置的命令`tail -F /var/log/syslog`不断监听系统日志文件的变化,并通过`hdfs` sink写入HDFS系统中。这样,即使日志数据量非常大,也能保证快速且稳定的处理。

以上案例展示了在特定情况下,针对高流量应用和大数据量日志的性能优化策略。正确的优化可以大幅提升日志系统的性能,同时保证系统的稳定性和可靠性。

# 6. 未来日志管理技术趋势

随着信息技术的快速发展,日志管理技术也在持续演进,为企业提供了更加现代化、智能化和安全合规的解决方案。本章节将深入探讨这些未来的技术趋势,并分析它们对企业日志管理实践的潜在影响。

## 6.1 日志管理的现代化工具

### 6.1.1 ELK Stack在日志管理中的应用

ELK Stack是一个由Elasticsearch、Logstash和Kibana组成的日志处理技术栈,它能够高效地收集、处理和展示日志数据。

- **Elasticsearch**:作为核心的搜索引擎,它能够索引日志数据,提供快速的数据检索能力。

- **Logstash**:负责收集和处理日志数据,支持多种输入源和数据格式。

- **Kibana**:提供可视化界面,帮助用户以图表和仪表板的形式查看和分析日志数据。

在应用ELK Stack时,通常需要配置Logstash以匹配企业日志的特定格式和要求,并将Elasticsearch设置为大规模数据的存储和索引解决方案。Kibana则用于构建直观的仪表板,使运维人员和开发者能够实时监控和分析日志数据。

```mermaid

flowchart LR

Logstash -.-> Elasticsearch -.-> Kibana

```

### 6.1.2 云服务和容器环境下的日志管理

随着云计算和容器技术的普及,日志管理也逐渐从传统服务器转向云端和容器化环境。

- **云服务提供商**:如AWS、Azure、Google Cloud等提供日志管理工具和服务,例如AWS CloudWatch和Azure Monitor。

- **容器化环境**:Docker和Kubernetes等容器管理平台通常与日志管理系统紧密集成,如Kubernetes可以通过日志聚合器(如Fluentd、Elasticsearch等)来统一管理容器日志。

云服务和容器环境对日志管理带来了新的挑战,例如分布式日志收集、动态资源管理等问题。然而,它们同时也提供了可伸缩性高、易于维护和按需付费的优势。

## 6.2 日志管理的智能化

### 6.2.1 人工智能在日志分析中的应用前景

人工智能(AI)技术已经开始渗透到日志管理领域,特别是在日志分析和监控方面。

- **异常检测**:利用机器学习算法可以从大量日志数据中检测出异常行为或潜在的安全威胁。

- **预测性分析**:AI可以学习和预测系统行为,帮助提前识别和预防问题。

随着AI技术的进步,我们可以预见未来日志管理将越来越多地依赖自动化智能分析,从而大大减轻运维人员的负担并提升系统稳定性。

### 6.2.2 预测性日志分析的实现方法

预测性日志分析是一种主动管理日志数据的技术,其核心目标是通过分析历史日志数据来预测未来的趋势或问题。

- **数据模型**:构建基于历史数据的行为模型,这些模型可以基于统计分析或机器学习算法。

- **实时分析**:结合实时日志流,模型可以实时评估系统状态,并预测即将发生的问题。

例如,日志分析工具可以设置阈值,一旦检测到某些指标超过阈值,就可以触发报警,从而提前采取措施。

## 6.3 安全性与合规性在日志管理中的重要性

### 6.3.1 日志数据的安全性保障措施

安全性是日志管理中的关键因素,需要确保敏感信息不被未授权访问和泄露。

- **加密**:对存储和传输中的日志数据进行加密处理,以防止数据被窃取。

- **访问控制**:实现基于角色的访问控制(RBAC),确保只有授权用户才能访问日志数据。

加强日志数据的安全性需要企业投入相应的资源和工具,同时也要进行定期的安全审计。

### 6.3.2 遵守数据保护法规的日志管理策略

随着全球数据保护法规的日益严格,如欧盟的通用数据保护条例(GDPR),企业必须确保日志管理策略符合法律要求。

- **数据保留**:明确规定日志数据的保留期限,以及过期后安全删除的流程。

- **数据主权**:确保日志管理符合地理区域的数据主权法规,例如在欧洲存储的数据应遵守GDPR。

企业应建立相应的合规性检查机制,以确保日志管理实践不会违反相关的法律法规,并能够在必要时提供日志记录作为合规性审计的证据。

0

0