实时识别算法的性能提升术:GPU加速与CPU调度实战演练

发布时间: 2024-09-07 04:48:50 阅读量: 104 订阅数: 64

# 1. 实时识别算法的理论基础

实时识别算法广泛应用于各个领域,例如安全监控、医疗成像、自动驾驶等。为了设计高效、准确的实时识别系统,需要对算法的理论基础有深入的理解。本章将首先介绍实时识别算法所需的基础知识,包括图像处理、机器学习和深度学习等。紧接着,会深入探讨如何利用这些理论基础构建实时识别系统。我们还将分析实时识别中遇到的主要挑战和问题,以及这些问题对算法选择和设计的影响。通过本章的学习,读者将能够对实时识别算法的理论基础有一个全面的认识,为后续章节中GPU加速技术和CPU多核优化技术的学习打下坚实的基础。

# 2. GPU加速技术详解

### 2.1 GPU加速的基本原理

#### 2.1.1 GPU架构与并行计算

现代GPU(图形处理单元)是高度优化的并行计算设备,其架构专为处理图形渲染和科学计算任务中的大量相似计算而设计。GPU架构相较于CPU,拥有大量的核心,能够同时处理多个任务(线程),这种能力称为并行性。

GPU的架构包括:

- 流处理器(Streaming Multiprocessors,SMs)

- 共享内存(Shared Memory)

- 寄存器文件(Register Files)

- 全局内存(Global Memory)

- 高速缓存(Caches)

这些组件紧密配合,实现高效的并行数据处理。在GPU架构中,线程被组织成多个块(Block),多个块又被组织成网格(Grid)。这种分块策略允许GPU优化资源使用,提高计算效率。

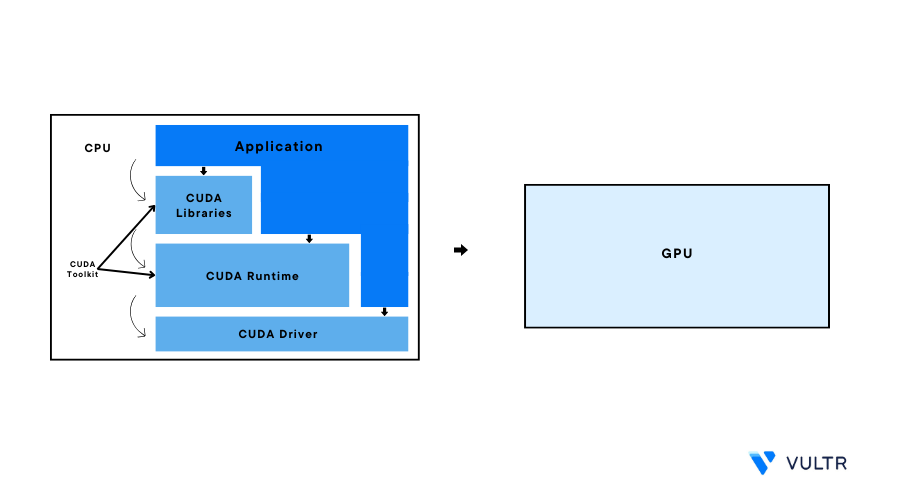

#### 2.1.2 CUDA编程模型和核心概念

CUDA(Compute Unified Device Architecture)是NVIDIA推出的并行计算平台和编程模型。它允许开发者使用C语言,将复杂的算法和数据处理任务并行化,直接在GPU上运行。

CUDA编程模型的核心概念包括:

- **Kernel函数**: 在CUDA中,Kernel函数是可以在GPU上运行的函数,它会被多个线程并行执行。

- **线程层次结构**: 包括线程、块和网格。线程是并行计算的基本单位,块是线程的集合,网格是块的集合。

- **内存层次结构**: 包括全局内存、共享内存、常量内存和纹理内存等。合理使用内存层次结构是优化CUDA程序性能的关键。

### 2.2 GPU加速在实时识别中的应用

#### 2.2.1 实时识别算法的GPU优化策略

实时识别算法往往涉及大量数据处理和模式匹配,这正是GPU并行计算的专长。GPU优化策略通常包括:

- **数据并行**: 将输入数据分配到多个GPU线程进行并行处理。

- **任务并行**: 将算法的不同部分分配给GPU的不同线程块,实现任务级并行。

- **内存优化**: 利用GPU内存层次结构,减少全局内存访问次数,利用共享内存和寄存器存储中间数据。

下面是一个简单的CUDA Kernel函数示例,展示如何利用GPU加速矩阵加法操作:

```c

__global__ void matrixAdd(float *A, float *B, float *C, int numElements) {

int i = blockDim.x * blockIdx.x + threadIdx.x;

if (i < numElements) {

C[i] = A[i] + B[i];

}

}

```

在这个示例中,每个线程负责一个矩阵元素的加法操作。`blockDim`和`blockIdx`联合决定了每个线程处理的数据索引。

#### 2.2.2 并行算法设计与案例分析

在并行算法设计中,关键步骤包括:

- **问题分解**: 将大问题分解为小的子问题,每个子问题能独立于其他子问题解决。

- **任务分配**: 将子问题映射到GPU的线程和块上。

- **同步与通信**: 在需要的时候进行线程间同步,确保数据一致性。

- **资源管理**: 合理分配内存资源,避免资源竞争。

考虑一个实时图像识别算法,图像数据可以分解为多个小块,每个小块对应一个图像区域。每个线程处理一个块,实现并行识别。此时,需要确保图像块间的依赖关系得到妥善处理,避免处理一个图像块时还需等待其他块的信息。

### 2.3 GPU性能调优与监控

#### 2.3.1 性能瓶颈分析与优化

在GPU性能调优中,常见的性能瓶颈及优化策略包括:

- **全局内存访问延迟**: 使用共享内存、常量内存缓存频繁访问的数据以减少全局内存访问延迟。

- **计算资源不均衡**: 通过合理划分任务,保证每个SM中的线程块数量均衡,避免某些SM过载,而其他SM空闲。

- **线程束分歧**: 尽量避免线程束内的条件分支,因为它们会导致线程束中的部分线程空闲。

#### 2.3.2 实时监控GPU资源使用

监控GPU资源的使用情况,可帮助开发者及时发现资源瓶颈。一些常用的监控工具有:

- **nvidia-smi**: NVIDIA提供的系统监控工具,可以查看GPU的运行状态和利用率。

- **nvprof**: 一个命令行分析工具,用于分析CUDA程序的性能。

- **NVIDIA Visual Profiler**: 提供图形化界面的性能分析工具。

使用这些工具,开发者可以实时观察GPU的内存使用情况、计算性能、运行时间等重要参数,为优化算法提供依据。

```bash

# 使用nvidia-smi命令查看GPU状态

$ nvidia-smi

```

下面是一个使用`nvprof`工具分析CUDA程序执行时间的示例:

```bash

# 使用nvprof分析矩阵加法程序的性能

$ nvprof --print-gpu-trace ./matrixAdd

```

通过监控工具的反馈,开发者可以了解程序在GPU上的实际运行情况,调整线程数量、内存使用策略等,提高算法性能。

以上内容详细介绍了GPU加速技术的基础原理、实时识别中的应用、性能调优以及监控方法。通过具体的应用案例和代码示例,本章节展示了如何在实时识别算法中实现GPU加速以及如何优化和监控GPU性能。这些内容为IT从业者提供了一套完备的GPU加速技术知识体系,有助于

0

0