声学模型压缩与部署:在资源受限下优化模型的7种方法

发布时间: 2024-09-06 20:18:41 阅读量: 30 订阅数: 26

# 1. 声学模型压缩与部署概述

在现代语音识别技术中,声学模型扮演着至关重要的角色。然而,随着模型复杂性的增加,它们往往需要庞大的计算资源和存储空间,这在资源受限的设备上,如智能手机、嵌入式系统和IoT设备上,构成了一大挑战。为了克服这些限制,声学模型压缩应运而生,它能够减少模型大小,同时保持或者仅轻微影响识别准确率。

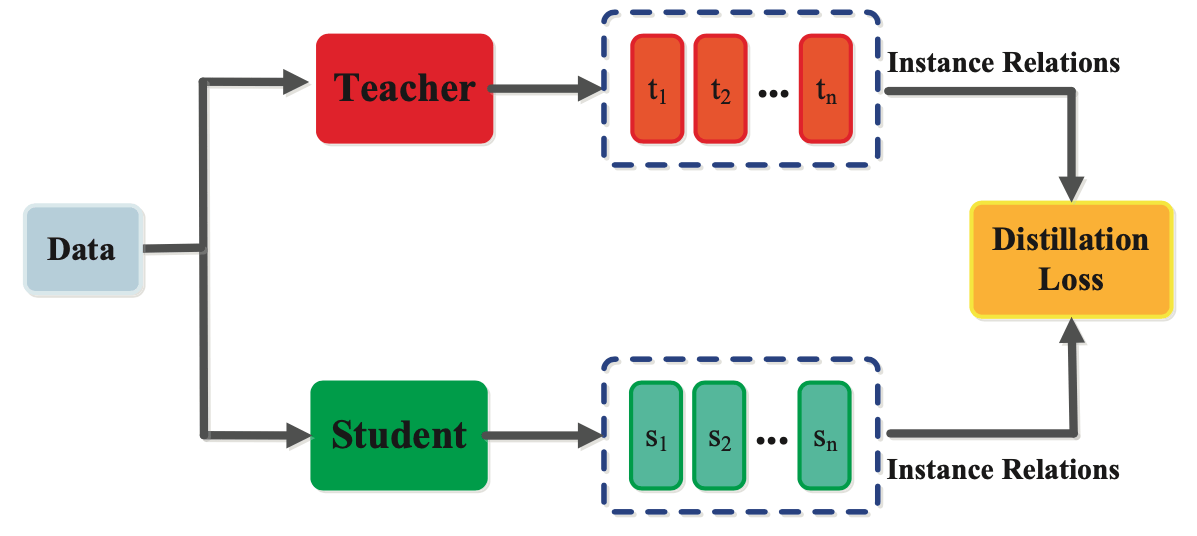

模型压缩技术,如权重剪枝、量化、知识蒸馏以及参数共享和低秩分解等,可以大幅度降低模型的存储需求和计算负担,使其更加适合在资源受限的环境中运行。理解这些技术的原理和应用对于IT专业人士来说至关重要,因为它们直接影响到产品的性能和用户体验。

在本章中,我们将介绍声学模型压缩与部署的基础知识,并概述实现高效压缩和部署的关键步骤。接下来的章节将更深入地探讨每种技术的细节,并提供实际应用案例。通过这些内容,我们旨在为读者提供全面了解如何在各种设备上实现高效声学模型部署的途径。

# 2. 模型压缩的基础理论

## 2.1 声学模型及其在语音识别中的作用

### 2.1.1 声学模型的概念

声学模型是语音识别系统的核心组成部分,它旨在从语音信号中提取有意义的语言信息。声学模型通过数学和统计方法,建立语音信号与语言单元之间的映射关系。在语音识别的背景下,模型学习如何根据发音(或声音的数字化表示)来预测相应的文字或词汇。

一个典型的声学模型会基于马尔可夫链或深度神经网络(DNNs)等理论来构建,这些模型可以捕捉到语音信号的时序特性。声学模型通常在大规模数据集上进行训练,以便能够准确地反映语言的真实用法和发音变体。

### 2.1.2 声学模型在语音识别中的应用

在语音识别系统中,声学模型用于将捕捉到的语音波形信号转换成一系列可能的字符或音素序列。这一过程是高度复杂的,因为它需要处理各种语言的发音差异、口音、说话速度和噪音等因素。

声学模型的应用范围包括但不限于智能助手、电话语音识别、实时字幕生成、语音搜索和自动语音转文本。在这些应用中,声学模型通常与其他类型的模型(如语言模型)协同工作,以提高识别的准确性。

## 2.2 模型压缩的必要性与挑战

### 2.2.1 资源受限环境下的挑战

在资源受限的设备(如手机、嵌入式系统和IoT设备)上部署大型声学模型是一大挑战。这些设备受限于内存大小、处理能力及电池续航等问题,无法直接承载高计算成本和高存储要求的复杂模型。

在这样的背景下,模型压缩技术成为了必须考虑的选择。它通过减少模型的大小和计算需求来适应有限的硬件资源,同时尽量保持模型的性能。

### 2.2.2 模型压缩的必要性分析

模型压缩技术允许在不显著牺牲识别准确度的情况下,将声学模型部署到资源受限的环境中。通过使用压缩技术,可以实现在移动设备上进行实时的语音识别,以及提高设备处理语音信号的速度和效率。

此外,模型压缩还有助于减少对带宽的需求,这对于需要在云端和客户端之间频繁交换数据的应用尤为重要。压缩模型同样可以减少部署时间和成本,同时在一些对隐私要求较高的场景下,提供了一种在本地处理数据的可能。

在下一节中,我们将详细介绍模型压缩的几种关键技术,包括权重剪枝、量化、知识蒸馏以及参数共享和低秩分解等策略,并探讨它们如何克服这些挑战,以实现高效的声学模型压缩。

# 3. 深度学习模型压缩技术

在当今数字化时代,深度学习模型已经成为许多应用程序的支柱,尤其在语音识别、图像处理等领域表现突出。然而,深度学习模型往往需要大量的计算资源和存储空间,这限制了它们在资源受限设备上的应用。因此,模型压缩技术应运而生,旨在减少模型的大小和计算需求,同时尽量保持模型的性能。

## 3.1 权重剪枝与量化

### 3.1.1 权重剪枝的方法与效果

权重剪枝是通过移除神经网络中不重要的权重来减少模型大小的一种技术。剪枝可以通过不同的策略实现,例如基于权重重要性的剪枝、基于稀疏性的剪枝或基于结构的剪枝。

**基于权重重要性的剪枝**通常涉及计算权重的某种度量,比如权重的绝对值大小或敏感性,然后移除那些对输出影响最小的权重。通常使用阈值策略来确定哪些权重应当被剪枝。

```python

import torch

import torch.nn as nn

def prune_layer(model, layer_name, amount):

"""

剪枝指定层中不重要的权重。

参数:

model -- 指定的模型

layer_name -- 要剪枝的层名

amount -- 要剪枝的权重比例

返回:

无

"""

layer = getattr(model, layer_name)

threshold = torch.sort(torch.abs(layer.weight.flatten()))[0][int(len(layer.weight.flatten()) * (1 - amount))]

for name, weight in layer.named_parameters():

if name == 'weight':

mask = torch.abs(weight) > threshold

layer.weight.data = weight * mask

layer.weight.grad = layer.weight.grad * mask

layer.out_channels = int(mask.sum())

print(f"层 {layer_name} 剪枝后保留的通道数: {layer.out_channels}")

```

**基于稀疏性的剪枝**依赖于模型的稀疏表示能力,通常通过正则化项或超参数来鼓励模型学习到稀疏的权重。

**基于结构的剪枝**则是将整个神经元或滤波器从网络中移除。这通常在卷积层中更为常见。

剪枝效果评估通常依据两个主要标准:模型性能的保持度和模型大小的缩减比例。实验表明,合理的剪枝能够在保持较高精度的同时显著减少模型的大小。

### 3.1.2 量化的策略与精度影响

量化是另一种模型压缩技术,它通过将模型中的浮点数权重转换为低位宽的整数来减少模型的存储需求和计算复杂度。常见的量化策略包括线性量化和对数量化。

**线性量化**将浮点数范围映射到整数范围。例如,如果我们选择使用8位无符号整数(0-255)来表示浮点数范围[-1,1],那么每个整数可以表示为原始浮点数

0

0