声学模型自适应技术:4个步骤提升模型在各种环境下的鲁棒性

发布时间: 2024-09-06 19:51:28 阅读量: 170 订阅数: 41

java计算器源码.zip

# 1. 声学模型自适应技术概述

声学模型自适应技术是现代语音识别技术中的重要组成部分,它通过改进声学模型,使得语音识别系统在不同的使用环境和不同的用户场景下都能提供准确的识别结果。自适应技术的发展,极大地提高了语音识别系统的可靠性和用户体验。

在详细讨论声学模型自适应技术之前,本章将先对这一领域进行宏观的介绍。我们将从声学模型的基本概念说起,包括定义、作用和常见模型类型。接着,本章将概括介绍自适应技术的理论分类,包括基于统计学和基于机器学习的方法,并探讨自适应技术在各种应用场景下的重要性和挑战。

通过本章的学习,读者将建立起对声学模型自适应技术的初步了解,并为进一步深入研究和应用该技术打下坚实基础。

# 2. 理论基础与自适应技术分类

### 2.1 声学模型的基本原理

#### 2.1.1 声学模型的定义和作用

声学模型是将语音信号映射到语言学信息的数学表达方式。在自动语音识别(ASR)系统中,声学模型的作用是捕捉发音特征和语言元素(如音素)之间的对应关系。这种模型通常基于大量的语音数据来训练,并且可以将声音信号转化为可识别的文本信息。它们通常用概率模型(如高斯混合模型GMM、隐马尔可夫模型HMM)来表达,能够通过计算音素在某个语音段落出现的概率来预测最可能的音素序列。

#### 2.1.2 常见声学模型介绍

高斯混合模型(GMM)是早期声学模型中常见的一种,使用多个高斯分布的混合来表示语音特征的统计特性。隐马尔可夫模型(HMM)则结合时间动态特性,通过状态转移来模拟语音的时序特性。而深度神经网络(DNN)的引入,显著提高了声学模型的性能,它们能够从数据中直接学习复杂的非线性特征表示。近年来,卷积神经网络(CNN)和循环神经网络(RNN)因其在处理图像和序列数据方面的优势,也被逐渐应用于声学模型中。

### 2.2 自适应技术的理论分类

#### 2.2.1 基于统计学的自适应方法

基于统计学的自适应方法通常涉及对模型参数的更新,以更好地匹配新环境下的数据分布。这包括但不限于最大似然线性回归(MLLR)和相关矩阵调整(CMA)。MLLR是一种可以调整高斯混合模型中均值和协方差矩阵的算法,使得模型能够适应新的环境和说话人的变化。CMA则通过调整协方差矩阵来适应新的环境噪声。

#### 2.2.2 基于机器学习的自适应技术

机器学习方法主要关注于从数据中自动学习和适应。在声学模型自适应方面,支持向量机(SVM)和决策树等算法被用来进行特征选择和数据分类。深度学习技术,如长短期记忆网络(LSTM)和卷积神经网络(CNN),可用于学习更深层次的特征表示,提高对复杂环境的适应能力。这些技术通过识别和利用数据中的模式,使声学模型能够适应语音数据的变化。

### 2.3 自适应技术的应用场景

#### 2.3.1 实时语音识别的挑战

实时语音识别要求系统能够快速处理和识别语音信号,同时保持高度的准确性和鲁棒性。语音信号的多变性、背景噪声、说话人差异以及环境因素都对实时语音识别提出了巨大挑战。自适应技术可以实时地调整和优化声学模型,以应对这些变化,确保系统在不同条件下都能保持高性能。

#### 2.3.2 不同环境下语音识别的需求分析

不同环境对语音识别系统的需求是多样化的。例如,在嘈杂的街道环境中,语音识别系统需要能够抑制背景噪声,并提取说话人的语音信号;在会议室环境中,系统可能需要区分多个说话人的声音,并进行准确的语音分离。这些不同的需求需要通过自适应技术,根据特定场景调整声学模型和信号处理策略,以达到最佳的识别效果。

```mermaid

graph LR

A[初始声学模型] --> B[数据收集与预处理]

B --> C[选择自适应算法]

C --> D[训练与评估]

D --> E[自适应模型部署]

E --> F[持续性能监控与优化]

```

在上述流程图中,我们可以看到自适应技术应用于声学模型的基本步骤,从初始声学模型的建立到持续的性能监控与优化。每一个步骤都对最终的自适应声学模型的成功至关重要。通过持续的监控和优化,声学模型能够适应不断变化的环境,以提供更加准确的语音识别服务。

在接下来的章节中,我们将深入探讨自适应技术的实施步骤,包括数据的收集和预处理,如何选择和应用自适应算法,以及模型训练与评估的具体流程。这些步骤构成了自适应技术实施的核心环节,对实现高质量的语音识别至关重要。

# 3. 自适应技术的实施步骤

### 3.1 数据收集与预处理

在声学模型自适应技术的实施过程中,数据收集与预处理是至关重要的步骤。精确的数据是构建稳健声学模型的基础,而数据预处理能极大地影响模型训练的效果。

#### 3.1.1 数据采集的策略和方法

为了使声学模型适应特定的环境或者用户群体,数据采集应围绕实际应用场景进行。这通常意味着需要收集该场景下可能遇到的各种声音样本,例如在嘈杂的公共场所中录音,或者针对特定说话人进行采样。数据采集策略包括:

- **多样化样本**:确保样本覆盖所有预期使用的场景和说话人特征。

- **长时间录音**:在不同时间段进行录音,以获取时间上的变化性。

- **环境模拟**:在模拟实际应用场景的环境下进行录音,如在模拟的噪声环境中采集语音数据。

数据采集后,通常需要将音频文件转换为标准格式(例如WAV),并统一采样率和位深,以便于后续处理。

#### 3.1.2 数据清洗和特征提取技术

数据清洗的目的是移除录音中的无用部分、噪声干扰和其他非目标信号。这通常包括:

- **去除静音段落**:通过计算能量阈值,识别并删除长时间无声或接近无声的部分。

- **噪声消除**:使用自适应滤波算法(如谱减法)减少背景噪声的影响。

特征提取则关注于从原始音频信号中提取出对识别任务有用的特征。常见的特征包括:

- **MFCC(梅尔频率倒谱系数)**:反映人耳的听觉特性,是语音识别中广泛使用的特征。

- **谱特征**:如线性预测编码(LPC)系数,能量谱等。

### 3.2 自适应算法的选择和应用

选定数据预处理方法之后,接下来需要选择合适的自适应算法来调整声学模型。本节将介绍两种主流自适应算法:最小均方误差(MMSE)方法和主成分分析(PCA)结合线性判别分析(LDA)。

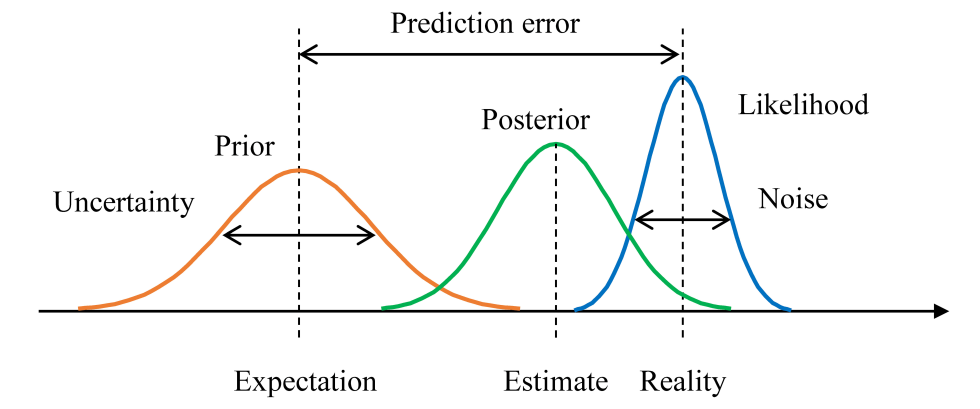

#### 3.2.1 最小均方误差(MMSE)方法

最小均方误差(MMSE)方法是一种基于统计学的自适应技术,它通过最小化误差平方的期望值来估计信号的最佳估计。在声学模型自适应中,MMSE常用于对模型参数进行估计,从而使得模型更好地匹配目标环境。

MMSE方法的实现通常涉及以下几个步骤:

1. **确定误差函数**:定义一个反映模型差异的误差函数。

2. **求解最优参数**:对误差函数求导并令导数为零,求解最优参数。

3. **迭代更新**:利用收集到的数据不断迭代更新模型参数。

以下是MMSE方法的一个简化的伪代码示例:

```python

# 假设我们已经有一个初步的声学模型参数theta和目标环境的数据集X

def mmse_adaptation(theta, X):

theta_new = theta

for iteration in range(num_iterations):

# E-step: 计算期望误差

expected_error = compute_expected_error(theta_new, X)

# M-step: 更新模型参数以最小化期望误差

theta_new = update_parameters(theta_new, expected_error)

return theta_new

```

#### 3.2.2 主成分分析(PCA)和线性判别分析(LDA)

PCA和LDA是两种常见的降维技术,它们在数据预处理阶段非常有用,有助于消除数据中的冗余信息,提高模型的性能。

- **PCA(主成分分析)**:通过线性变换将可能相关的多维数据转换到新的线性无关的坐标系中,以降维为主要目的。

- **LDA(线性判别分析)**:不仅降维,还尝试保持类别之间的分离性,是一种监督学习方法。

在声学模型的自适应中,我们通常先使用PCA对特征进行降维,再应用LDA进一步提取分类信息。以下是PCA和LDA联合使用的示例代码:

```python

from sklearn.decomposition import PCA

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis

# 假设已经完成数据预处理,有一个特征集X和标签y

pca = PCA(n_components=0.95) # 保留95%的方差信息

X_pca = pca.fit_transform(X)

lda = LinearDiscriminantAnalysis(n_components=n_classes - 1) # 假设有n_classes个类别

X_lda = lda.fit_transform(X_pca, y)

```

在实际应用中,PCA和LDA的参数如降维后的维数需要根据具体任务进行调整。

### 3.3 模型训练与评估

实施

0

0