声学模型的端到端解决方案:直接从声音到文字的革命性方法

发布时间: 2024-09-06 19:47:59 阅读量: 83 订阅数: 26

# 1. 端到端声学模型概述

## 1.1 声学模型的定义与重要性

在自动语音识别(Automatic Speech Recognition, ASR)领域,声学模型扮演着至关重要的角色。端到端声学模型是一种新兴技术,它摒弃了传统流水线式的处理方法,通过直接从声学特征到文字的映射,减少了处理流程中的误差累积,并能够更有效地学习语言的复杂性。端到端系统旨在简化模型设计,并提高识别准确率,对语音技术的发展具有深远影响。

## 1.2 端到端声学模型的演变

端到端声学模型经历了从早期基于规则的方法到基于统计模型,再到如今基于深度学习的变革。早期的声学模型,如隐马尔可夫模型(HMM),在处理连续语音时遇到了许多挑战。随着深度学习技术的发展,如长短期记忆网络(LSTM)和注意力机制(Attention Mechanism),端到端模型开始兴起,为语音识别带来了前所未有的准确性提升。然而,端到端模型的设计和优化也带来了新的挑战,例如模型的解释性、计算成本和对大数据的依赖。

## 1.3 端到端声学模型的应用与前景

端到端声学模型已经在诸多实际应用中展现出了巨大的潜力,包括智能助手、语音翻译和实时字幕生成等场景。其最显著的优势是简化了处理流程,减少了多个独立组件的复杂交互,从而提升了系统的整体性能。未来,随着模型结构的优化、计算能力的增强以及数据收集技术的改进,端到端声学模型有望进一步推动语音识别技术的发展,为用户提供更加丰富、准确和便捷的语音交互体验。

# 2. 端到端声学模型的理论基础

### 2.1 端到端系统的核心架构

#### 2.1.1 自动语音识别系统的演变

自动语音识别(ASR)系统从最初基于规则的模型,经历了统计模型的阶段,发展到今天的深度学习模型。早期的ASR系统依靠复杂的规则和语法来解析声音信号,但其适用性有限,难以应对现实世界中的复杂性和多样性。随着统计方法的引入,尤其是隐马尔可夫模型(HMM)的使用,ASR系统开始能够从数据中学习模式,但仍然受限于手工制作的特征。

深度学习的出现,特别是端到端的声学模型,标志着ASR系统的一个重大转变。这些模型可以直接从原始音频数据中学习到从声学特征到文字的映射,省略了传统模型中多个独立模块(如特征提取、声学模型、语言模型)的复杂串联。这种从声音到文字的一体化处理使得ASR系统更加健壮,性能得到显著提高。

```mermaid

graph LR

A[原始音频信号] -->|提取特征| B[特征提取模块]

B -->|转换为文本| C[统计模型或传统模型]

C -->|解析| D[最终文本输出]

A -->|输入到深度学习模型| E[端到端声学模型]

E -->|直接输出| F[最终文本输出]

```

在上述的Mermaid流程图中,我们可以看到端到端模型相较于传统模型的优势:简化了处理流程,并能够更直接地从原始数据中学习到有效的特征和模式。

#### 2.1.2 端到端模型与传统模型的比较

端到端模型与传统模型之间的主要差异在于信息处理的方式和复杂性。传统模型通常由多个单独的组件构成,如预处理、特征提取、声学模型、语言模型和解码器。每个组件都需要专家的知识来设计和调整。而端到端模型将所有这些组件集成到一个统一的框架内,学习端到端的映射。

端到端模型的一个显著优点是减少了对专家设计特征的依赖,可以更灵活地处理各种语言和口音。它通过深度神经网络自动学习到从音频信号到文字序列的复杂映射。例如,循环神经网络(RNN)和长短期记忆网络(LSTM)能够处理时间序列数据,并捕捉音频信号中随时间变化的依赖关系。

### 2.2 深度学习在声学模型中的应用

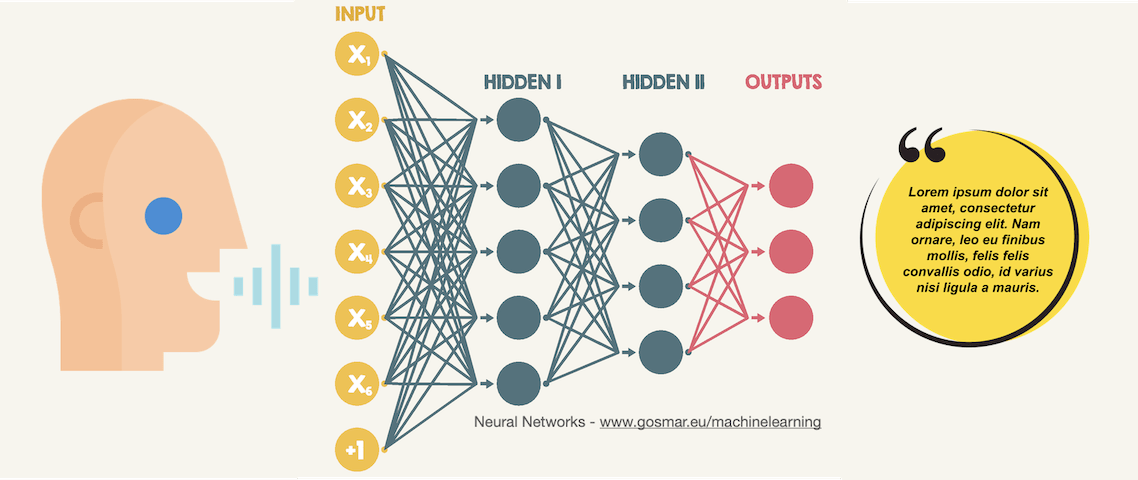

#### 2.2.1 神经网络基础

神经网络是深度学习的核心技术,它模仿了人脑的工作方式,通过简单的计算单元——神经元的集合来执行复杂的任务。在声学模型中,神经网络能够学习到声音信号中的复杂模式,并将其转化为文本。

一个基本的神经网络由输入层、隐藏层和输出层组成。输入层接收特征数据,隐藏层通过权重矩阵和非线性激活函数进行数据转换,输出层则生成最终的预测结果。神经网络的训练是通过反向传播算法不断调整权重来最小化预测误差。

```mermaid

graph LR

A[输入层] -->|数据和权重| B[隐藏层]

B -->|数据和权重| C[隐藏层]

C -->|数据和权重| D[输出层]

D -->|预测结果| E[最终输出]

```

上图展示了神经网络的一个简化的层级结构。在声学模型的应用中,每一层都可能包含数百到数千个神经元,而且通常会有多个隐藏层。

#### 2.2.2 循环神经网络(RNN)和长短期记忆(LSTM)

循环神经网络(RNN)特别适用于处理序列数据,比如文本和音频信号。RNN通过其隐藏层中的循环连接,能够记住序列中的先前信息,从而在当前步骤中使用这些信息。然而,RNN存在梯度消失或梯度爆炸的问题,这限制了其处理长期依赖关系的能力。

长短期记忆(LSTM)网络是对RNN的一种改进,它引入了称为“门”的机制,有效地解决了梯度消失问题。LSTM能够捕捉长距离的依赖关系,适合处理和记忆长时间序列中的信息。这使得LSTM在处理语音信号,尤其是长句子的语音识别时表现得更为出色。

#### 2.2.3 卷积神经网络(CNN)在声学特征提取中的作用

卷积神经网络(CNN)主要用于图像处理领域,近年来也被引入到声学特征提取中。CNN能够自动地从原始音频信号中提取有用的特征,这在传统的手工特征提取方法中是非常困难的。

CNN通过卷积层来提取局部特征,并使用池化层来降低特征维度,保留最重要的信息。在声学模型中,CNN能够高效地从频谱图中学习到音素级别的特征,这些特征对于区分不同的音素非常有用。

### 2.3 损失函数和优化算法

#### 2.3.1 常见损失函数的原理和选择

损失函数,也称为目标函数,用于衡量模型预测值与真实值之间的差异。在训练深度学习模型时,损失函数是调整模型参数以最小化预测错误的关键。对于端到端的声学模型,交叉熵损失是最常见的选择之一,特别是在处理多类别分类问题时。

交叉熵损失衡量了模型预测概率分布与真实标签的概率分布之间的差异。在语音识别任务中,每个时间步的输出可以看作是一个概率分布,交叉熵损失能够有效地指导模型在训练过程中减少这种预测分布与实际分布之间的差距。

#### 2.3.2 优化算法对模型性能的影响

优化算法用于更新深度学习模型中的权重,以便最小化损失函数。不同的优化算法对模型的收敛速度和最终性能有显著影响。常用的优化算法包括随机梯度下降(SGD)、Adam、RMSprop等。

SGD是最基本的优化算法,它通过计算损失函数相对于模型参数的梯度,并按照一定的学习率进行更新。Adam算法结合了RMSprop和梯度的动量估计,对SGD进行了改进,使其能够更快地收敛,并且对学习率的选择不那么敏感。这使得Adam在许多深度学习任务中成为首选的优化器。

```python

# 伪代码示例:使用Adam优化器进行模型训练

from keras.optimizers import Adam

model = build_model() # 构建声学模型

optimizer = Adam(lr=0.001) # 初始化Adam优化器

***pile(loss='categorical_crossentropy', optimizer=optimizer) # 编译模型,指定损失函数和优化器

model.fit(x_train, y_train, epochs=50, batch_size=32) # 训练模型

```

在上述伪代码中,我们构建了一个声学模型并选择了Adam优化器。我们指定了损失函数为`categorical_crossentropy`,这是因为我们的目标是多类别分类。然后我们通过`model.fit`方法来训练模型,这个方法会根据损失函数和优化器调整模型权重。

# 3. 端到端声学模型的实践技术

## 3.1 声学特征提取技术

声学特征提取是自动语音识别中的关键步骤,它涉及到从原始音频信号中提取出对语音内容有区分能力的特征向量。这些特征向量随后被用于训练和识别阶段。本节我们将深入了解端到端声学模型中常用的声学特征提取方法。

### 3.1.1 频谱特征(如MFCC)的提取方法

**梅尔频率倒谱系数(MFCC)** 是自动语音识别系统中最常用的特征之一。MFCC的提取过程大致如下:

1. **预加重(Pre-emphasis)**: 预加重用于增强高频部分,通过一阶滤波器来实现:`y[n] = x[n] - α * x[n-1]`,其中`α`(通常介于0.9到1之间)是预加重系数。

2. **分帧(Framing)**: 将连续的语音信号分割成一系列重叠的小段,通常每帧10-30毫秒。

3. **窗函数(Windowing)**: 应用窗函数(如汉明窗或汉宁窗)来减少帧两端的不连续性。

4. **快速傅里叶变换(FFT)**: 对每一帧执行FFT来获取频谱信息。

5. **梅尔滤波器组(Mel Filters)**: 在频域使用一组梅尔尺度的三角滤波器来模拟人类听觉系统的特性。

6. **对数能量(Log Energy)**: 对滤波器组输出取对数能量。

7. **离散余弦变换(DCT)**: 对对数能量进行DCT来获取MFCC系数。

以下是一个MFCC特征提取的Python代码示例:

```python

import numpy as np

from scipy.signal import hamming

from scipy.fftpack import dct

import librosa

def extract_mfcc(signal, sampling_rate, num_mfcc=13, n_fft=2048, n_mels=128, n_frames=5):

# 预加重

pre_emphasis_filter = np.array([1.0, -0.97])

signal = np.convolve(signal, pre_emphasis_filter, mode='same')

# 分帧

frames = librosa.util.frame(signal, frame_length=

```

0

0