提升HDFS写入吞吐量:并发控制与性能调优策略

发布时间: 2024-10-28 00:23:48 阅读量: 28 订阅数: 34

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. HDFS写入吞吐量概述

## 1.1 HDFS的基本概念与特点

Hadoop分布式文件系统(HDFS)是Hadoop框架的核心组件,专为处理大规模数据而设计。它的高容错性和低成本存储使其成为大数据存储解决方案的首选。HDFS具备良好的横向扩展能力,能够在商用硬件上实现高吞吐量的数据访问。

## 1.2 写入吞吐量的重要性

写入吞吐量指的是单位时间内系统能够写入数据的量。在大数据处理场景中,高写入吞吐量尤为重要,因为它直接决定了数据处理的速度和效率。提升HDFS的写入吞吐量可以缩短数据处理周期,提高整体系统的性能。

## 1.3 影响HDFS写入吞吐量的因素

影响HDFS写入吞吐量的因素很多,包括但不限于:硬件性能(CPU、内存和存储设备)、网络带宽、NameNode与DataNode的数量和配置、以及HDFS的配置参数(如块大小、副本数量等)。深入分析这些因素对于优化HDFS写入性能至关重要。

# 2. HDFS并发控制机制

## 2.1 HDFS的基本并发模型

### 2.1.1 数据块与NameNode的关系

Hadoop分布式文件系统(HDFS)是一种高度容错的系统,适用于在通用硬件上存储大量数据。为了实现高吞吐量的数据访问,HDFS支持大块数据的存储,这些数据块被切分成固定大小的单元,称为数据块(block)。数据块默认大小为128MB(Hadoop 2.x版本之后),这样设计是为了最小化寻址开销,同时适应网络传输,因为大量数据传输的效率通常优于小块数据的传输。

NameNode是HDFS的核心组件,它负责管理文件系统的命名空间(namespace)和客户端对文件的访问。每个文件和目录都由一个唯一的inode来表示,并且在NameNode上存储。一个关键的细节是,数据块本身并不直接存储在NameNode上,而是存储在一系列的DataNode中。DataNode通常分布在各个物理服务器上,这些服务器称为数据节点。

并发控制机制的重点在于合理管理对数据块的访问,以保证数据的完整性和一致性。当客户端请求写入数据时,NameNode将决定哪些DataNode可以存储新的数据块副本,同时管理数据块的复制过程。在数据块的创建和复制过程中,HDFS会使用一系列内部机制来确保数据的并发读写安全。

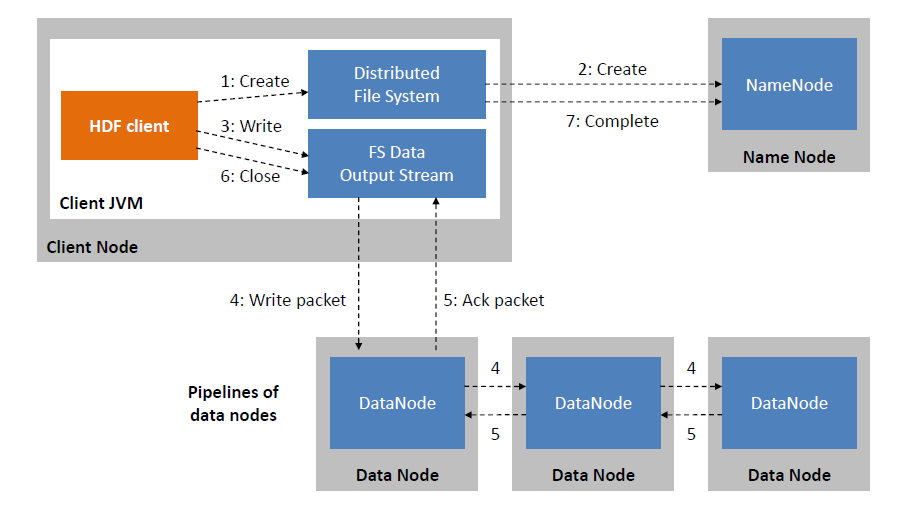

### 2.1.2 写入流程中的并发控制点

写入数据到HDFS是一个涉及多个组件的复杂过程。在此过程中,并发控制点尤为重要,以防止数据损坏和数据丢失。当一个客户端发起写操作时,会经历以下几个步骤:

1. **客户端与NameNode通信**:首先,客户端通过与NameNode通信来获取数据块的存储位置。NameNode返回可用的DataNode列表,通常是一个副本链表,根据策略选择副本位置。

2. **并发写入DataNode**:随后,客户端将数据分成块,并发地写入到选定的DataNode上。为了确保数据一致性,HDFS采用了一种称为“一次写入多次读取”(Write-Once-Read-Many,WORM)的模型。这意味着一旦数据块被写入,它不会被更改,只会被读取,这降低了并发控制的复杂性。

3. **副本同步**:一旦数据块被写入所有的DataNode,客户端通知NameNode此操作已完成。随后,NameNode负责将新数据块复制到其他DataNode上,以保证数据块的冗余性。

在写入流程中,HDFS使用租约(lease)机制来控制对数据块的并发写入。租约是一种确保数据一致性的方式,当客户端获得租约后,它就获得了写入数据块的权限。如果在租约有效期内,有其他客户端尝试写入同一个数据块,NameNode将拒绝该请求。

此外,HDFS通过心跳(heartbeat)机制监控DataNode的健康状况。心跳消息允许NameNode确认DataNode是否正在运行,并且可用于发送命令或获取数据块的状态信息。如果NameNode在一段时间内未收到心跳消息,它将认为该DataNode已经宕机,并立即采取措施来复制该节点上的数据块到其他健康节点上,以维持数据块的副本数。

## 2.2 提升并发写入效率的策略

### 2.2.1 增加数据块副本策略

HDFS架构允许用户通过调整副本因子(replication factor)来控制数据冗余度,副本因子是一个配置参数,定义了每个数据块应该存储的副本数。增加数据块的副本因子可以提高数据的容错性和可靠性,但也意味着更多的存储空间和写入操作的开销。

副本因子的设置需要根据实际需求平衡性能和可靠性。副本数太少可能会导致数据丢失的风险增加,而副本数过多会增加存储成本,并可能降低写入性能。HDFS默认的副本因子是3,意味着每个数据块都会被复制3次,存储在不同的DataNode上。

为了提升并发写入效率,用户可以考虑调整副本因子的设置。例如,在一个高带宽的网络环境中,可以适当增加副本因子来提高写入速率,因为写入的带宽消耗将被多个DataNode分摊。这通常适用于需要高吞吐量但对数据可靠性要求不是极端严格的场景。

值得注意的是,在读取密集型的工作负载中,较高的副本因子可以提升读取性能,因为它允许更多的DataNode同时服务于读请求。而在写入密集型的工作负载中,增加副本因子可能会成为性能瓶颈,因为写入操作需要在多个DataNode之间同步数据。

### 2.2.2 流水线写入机制详解

HDFS的流水线写入机制是为了优化并发写入性能而设计的。这种机制允许多个DataNode之间形成一个写入流水线,数据块可以在DataNode之间以流水线的方式进行传输,而不需要等待前一个DataNode完全接收数据块后再传递给下一个DataNode。

在流水线写入机制中,客户端将数据块分成多个包,每个包依次写入流水线中的下一个DataNode。写入操作完成后,DataNode会返回一个确认信息给客户端,表明它已经接收到了数据包。这样,客户端不需要等待整个数据块写入完成即可发送下一个数据包,极大提高了写入效率。

例如,如果有三个副本需要写入,客户端只需要向第一个副本所在的DataNode发送数据包,当该DataNode完成接收后,它会继续将数据包发送到下一个DataNode,最后到达第三个副本所在的DataNode。在这个过程中,客户端可以同时向不同的DataNode发送不同的数据包,形成一个数据流动的链路。

流水线写入机制的使用场景适用于高带宽、低延迟的网络环境。然而,如果网络条件不佳,比如网络延迟较高,那么流水线写入的性能优势将不明显,因为网络延迟可能成为瓶颈,限制了数据包的传输速率。

## 2.3 并发控制实践案例分析

### 2.3.1 传统HDFS与并行文件系统对比

传统HDFS设计的初衷是解决大规模数据集的存储和处理问题。然而,随着大数据技术的发展,传统的HDFS在某些场景中遇到了性能瓶颈,特别是在需要高度并发访问和低延迟的场景。为了应对

0

0