云原生HDFS文件写入攻略:挑战应对与解决方案

发布时间: 2024-10-28 00:14:08 阅读量: 3 订阅数: 7

# 1. 云原生HDFS文件系统概述

随着云计算的迅猛发展,云原生应用成为了企业数字化转型的重要趋势。HDFS(Hadoop Distributed File System)作为一个高度可扩展的分布式文件系统,其在云原生环境下的应用与优化已经成为行业关注的焦点。本章将为大家介绍HDFS的基础概念、架构组件,以及其在云原生环境下的特点和挑战,为后续章节奠定基础。

HDFS是一种存储大规模数据集的分布式系统,它采用高容错机制设计,特别适合于处理大量的、非结构化的数据。在传统的Hadoop环境中,HDFS以其简单稳定的操作模型被广泛应用。然而,在云原生架构中,HDFS面临着许多新的需求和挑战,比如如何更好地利用云服务的弹性、如何保证数据的安全性和可靠性、如何提高系统的性能和资源利用效率等。

为了应对这些挑战,我们需要对HDFS进行深入的理解,并在此基础上探索创新的解决方案。接下来,我们将深入探讨HDFS的基本概念、架构组件,以及在云原生环境下的新应用,为读者提供全面的云原生HDFS知识体系。

# 2. 理论基础与架构解读

## 2.1 HDFS的基本概念和数据存储原理

### 2.1.1 HDFS的设计目标和应用场景

HDFS(Hadoop Distributed File System)是一个高度容错性的系统,适合在廉价硬件上运行的应用。HDFS的设计目标是通过简单、高容错的方式,在大型集群上存储大量数据。其设计目标包括:

- 处理大容量数据集:HDFS适合存储海量数据,它能够水平扩展到数百个节点的集群。

- 硬件容错:HDFS假定硬件故障是常态,它通过数据副本的形式来保证数据的可靠性和持久性。

- 高吞吐量:HDFS最适合具有高数据吞吐量的应用,而不是低延迟的数据访问。

- 简单的一致性模型:HDFS提供了一个写一次、读多次的模型,这意味着文件一旦创建和写入完成,就不能被修改。

应用场景方面,HDFS广泛应用于:

- 大数据处理:在大数据框架如Hadoop MapReduce中,HDFS作为数据存储层,提供海量数据的存储。

- 数据仓库:构建数据仓库,支持复杂的数据分析和查询。

- 日志文件存储:收集和存储大量的日志数据。

### 2.1.2 HDFS的数据块和副本机制

HDFS将文件分割成一系列的块(block),每个块的大小是固定的,通常是64MB或128MB。每个块被存储在集群的不同DataNode上,且默认情况下会有三个副本(可配置),以提高数据的可靠性和容错能力。

副本机制提供了以下几个关键优势:

- 高容错性:即便某一部分存储硬件发生故障,数据副本依然可以被访问,从而保证了数据的高可用性。

- 高效的数据读取:由于文件的不同部分可以由不同的副本提供,所以读取操作可以并行化,提高了读取性能。

但是,副本机制也有其缺点,例如存储空间的增加以及对网络带宽的高要求。因此,在实际部署中,副本数量和块大小需要根据实际需求进行优化。

## 2.2 HDFS的架构组件解析

### 2.2.1 NameNode的角色和功能

NameNode是HDFS的核心组件之一,它在HDFS架构中承担着“大脑”的角色。具体来说:

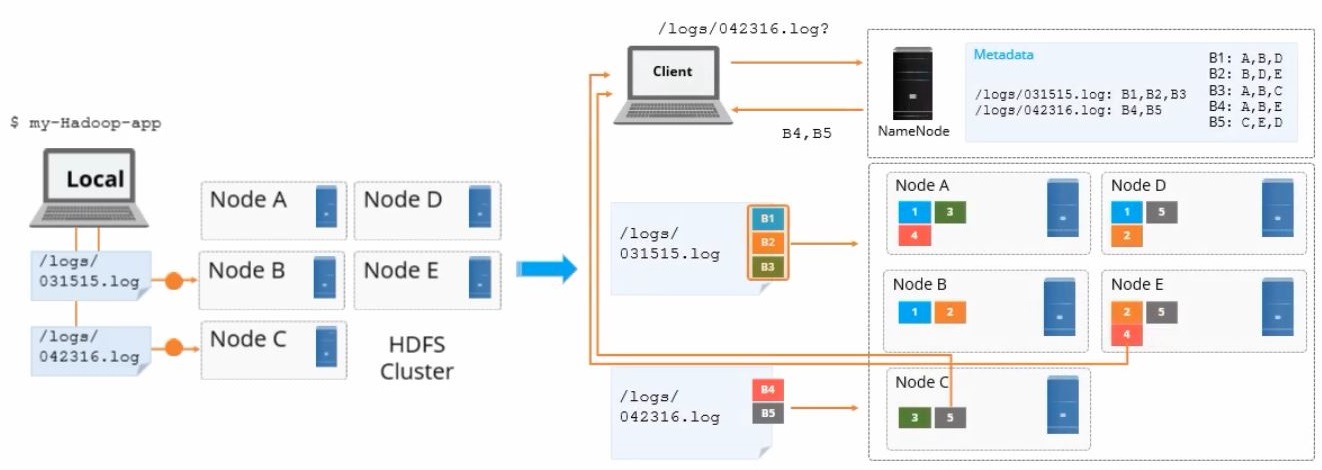

- 元数据管理:NameNode负责存储文件系统的命名空间,管理文件系统的元数据,如文件目录树、文件和目录属性、每个文件的数据块和副本存放位置等信息。

- 负载均衡:NameNode优化数据块的放置,尝试平衡集群中的存储和负载。

- 命名空间的元数据持久化:为了防止元数据丢失,NameNode将文件系统的命名空间镜像(fsimage)和编辑日志(editlog)持久化存储到本地磁盘,并通过Secondary NameNode定期合并这两个文件,形成新的命名空间镜像。

### 2.2.2 DataNode的工作原理和存储管理

DataNode是HDFS的另一个主要组件,负责文件系统数据块的实际存储:

- 数据存储:DataNode管理存储的数据块,并根据NameNode的指示对这些数据块执行创建、删除和复制等操作。

- 数据读写:客户端通过DataNode访问HDFS中的数据块,进行文件的读写操作。

- 负载均衡:DataNode能够对本地存储进行优化,例如通过数据压缩和合理利用存储空间。

### 2.2.3 客户端与HDFS的交互过程

客户端与HDFS的交互通常涉及以下步骤:

1. 客户端通过NameNode获取文件元数据和数据块的位置信息。

2. 客户端直接与DataNode通信,进行数据块的读写操作。

3. 写操作:客户端将数据块写入到DataNode后,DataNode将数据块信息反馈给NameNode,由NameNode进行状态更新。

4. 读操作:客户端从DataNode读取数据,DataNode直接向客户端提供所需的数据块。

## 2.3 云原生对HDFS的影响

### 2.3.1 云原生环境的特点

云原生(Cloud Native)是指应用能够在云计算环境下以一种可移植、可扩展的方式运行。云原生环境的特点包括:

- 容器化:使用容器技术,如Docker,简化了应用打包和部署的过程。

- 微服务架构:将应用拆分为一系列细粒度的服务,使得应用易于维护、扩展和更新。

- 自动化运维:使用自动化工具进行服务部署、扩展、监控和管理。

- 弹性和可扩展性:云环境提供了按需分配资源的能力,使得应用能够自动扩展以适应负载变化。

### 2.3.2 云原生下HDFS的优势与挑战

#### 优势:

- 弹性与资源优化:云原生环境使得HDFS能够更灵活地使用计算资源,并根据需求进行动态扩展。

- 成本效益:使用云服务可减少物理硬件的投资,实现按需付费,降低总体拥有成本。

#### 挑战:

- 安全性:在多租户环境中,数据的隔离和安全性成为云原生HDFS的一个挑战。

- 管理复杂性:云原生环境下的HDFS管理变得更加复杂,需要考虑资源调度、监控和服务发现等问题。

接下来的章节将会深入探讨HDFS在云原生环境下的文件写入机制和优化策略。

# 3. HDFS文件写入机制与优化

## 3.1 HDFS文件写入流程

### 3.1.1 文件创建和写入步骤

HDFS文件写入操作可以分为几个关键步骤,以确保数据的可靠性和高效性。首先,客户端发起写入请求到NameNode。NameNode负责管理文件系统的命名空间,并维护文件到DataNode的映射关系。在文件创建阶段,NameNode会检查请求文件是否已经存在以及用户是否有相应的权限。如果文件不存在并且授权无误,NameNode将为文件分配一个唯一的标识符,并创建一个新的文件条目。

随后,客户端会收到NameNode的响应,并开始将数据写入DataNode。在实际写入之前,NameNode会为客户端提供一系列DataNode的列表,客户端将数据分块写入这些DataNode节点。数据首先写入客户端缓存,然后在一定条件下被批量刷新到DataNode。在这个过程中,NameNode会根据配置的副本策略,指示客户端在多个DataNode上存储数据副本,以保证数据的高可用性。

写入流程需要在客户端与DataNode之间建立安全的通信连接,以确保数据传输的安全性。为了平衡系统的负载并防止数据丢失,副本通常会被分配到不同的机架上。写入操作完成后,NameNode会更新文件的元数据,包括文件大小、副本信息等,并将写入完成的消息返回给客户端。

### 3.1.2 写入过程中的数据流和复制

在HDFS中,数据块的复制是保证数据可靠性的关键机制。每个文件被切分成一系列块,缺省情况下每个块的大小为128MB(可配置)。写入数据时,数据会按照配置的副本数进行存储,缺省副本数为3。

数据写入时,客户端会首先写入第一个副本,称为“主副本”。当主副本写入完成后,HDFS开始复制数据到其他副本。数据流通过DataNode之间建立的管道来传输,这样可以有效地并行处理多个块的复制任务。

数据复制采用的是“流水线”(pipeline)技术。客户端写入主副本后,DataNode会并行地将数据块传输到其他DataNode。传输过程中,每个DataNode都会收到数据的一部分,并将其转发到下一个DataNode,直到所有的副本都被写入完成。

在此过程中,NameNode监控所有的DataNode节点状态和网络带宽的使用情况,确保复制过程高效且可靠。如果在复制过程中某个DataNode发生故障,NameNode会检测到,并重新调度任务到其他健康的DataNode,以保证所有副本最终达到指定数量。

## 3.2 文件写入性能优化策略

### 3.2.1 磁盘I/O优化

在大规模分布式存储系统中

0

0