数据校验核心:HDFS如何避免数据损坏

发布时间: 2024-10-28 06:08:29 阅读量: 24 订阅数: 40

dnSpy-net-win32-222.zip

# 1. 数据校验核心概念和HDFS概述

## 1.1 数据校验的必要性

数据校验是确保数据准确性的重要环节,尤其在大数据处理领域,数据的完整性直接影响着分析结果的可靠性。随着企业对数据依赖性的增强,数据校验在数据仓库和分布式文件系统中变得越来越重要。

## 1.2 HDFS简介

Hadoop分布式文件系统(HDFS)是大数据存储的关键技术之一,它采用主从架构,以高容错性和高吞吐量支持大规模数据集的存储。HDFS通过数据块的复制机制保证数据的可靠性,适合运行在廉价的硬件上,非常适合大数据的分布式存储和计算。

## 1.3 数据校验在HDFS中的作用

在HDFS中,数据校验起着至关重要的作用,通过计算和验证数据块的校验和(Checksum),系统可以有效地检测数据在存储和传输过程中是否发生损坏,并及时进行修复。这不仅能保证数据的可靠性,还能提高数据的可用性。

# 2. 数据校验的理论基础

### 2.1 数据完整性的重要性

#### 2.1.1 数据损坏的危害

数据完整性是信息存储和传输过程中最为关键的要素之一。在存储系统中,数据损坏可以源自多种原因,如硬件故障、软件缺陷、操作失误甚至恶意攻击。数据损坏的危害极大,一旦发生,可能会导致以下几个主要问题:

- **业务中断**:对于依赖数据的业务系统,数据损坏可能会导致系统无法正常启动或运行,从而造成业务中断。

- **数据不一致**:损坏的数据可能导致数据库中出现不一致,进而影响数据的准确性和可靠性。

- **资产损失**:数据损坏可能会导致企业损失大量的关键信息资产,包括知识产权、财务信息、客户数据等。

- **信任危机**:频繁的数据损坏事件会影响用户对企业或服务的信任,从而对品牌造成负面影响。

数据损坏对企业的潜在风险由此可见一斑,因此确保数据的完整性显得尤为重要。

#### 2.1.2 数据完整性保障的方法

为了保障数据完整性,可以采取以下方法:

- **备份与冗余**:定期备份数据并采用冗余存储策略,如RAID技术,可以在硬件出现问题时迅速恢复。

- **事务日志**:使用事务日志可以追踪数据更改记录,一旦数据损坏,可以利用日志恢复到最近的一致状态。

- **校验和机制**:通过计算数据块的校验和,可以在数据读取时快速检测到数据是否损坏。

- **访问控制和权限管理**:严格的访问控制和权限管理可以防止未授权的修改,从而保护数据不被意外或恶意破坏。

- **定期完整性检查**:周期性的对数据进行完整性检查,能够及时发现并修复潜在的问题。

### 2.2 校验码技术简介

#### 2.2.1 校验码的定义

校验码是一种用于检测数据在传输或存储过程中是否发生错误的算法。它通过一个校验码来表示数据块的特征,从而允许数据接收方验证数据的准确性。校验码通常用于存储介质、网络传输和文件系统中,如HDFS。

校验码技术基于数学原理,通过将数据块转换为固定长度的字符串,这个字符串就是校验码。校验码具有一定的容错能力,可以在一定程度上检测并纠正错误。

#### 2.2.2 常用校验算法分析

数据校验领域存在多种校验算法,下面介绍几种常用的校验算法:

- **CRC(循环冗余校验)**:CRC算法通过将数据视为一个大的整数,然后除以一个固定的预设多项式,余数作为校验码。CRC算法能够检测出大部分的单、双位错误,以及突发错误。

- **MD5(消息摘要算法5)**:MD5算法产生一个128位(16字节)的校验和,广泛用于数据完整性验证和数字签名。但MD5的安全性已经不如从前,容易受到碰撞攻击。

- **SHA(安全哈希算法)**:SHA算法是一系列哈希函数,从SHA-1到最新的SHA-3。这些算法生成一个固定的长度输出,常用于保证数据的完整性。

在HDFS中,通常采用CRC来进行数据校验,以确保数据在存储过程中的准确性和一致性。

### 2.3 HDFS数据校验原理

#### 2.3.1 HDFS的数据块复制机制

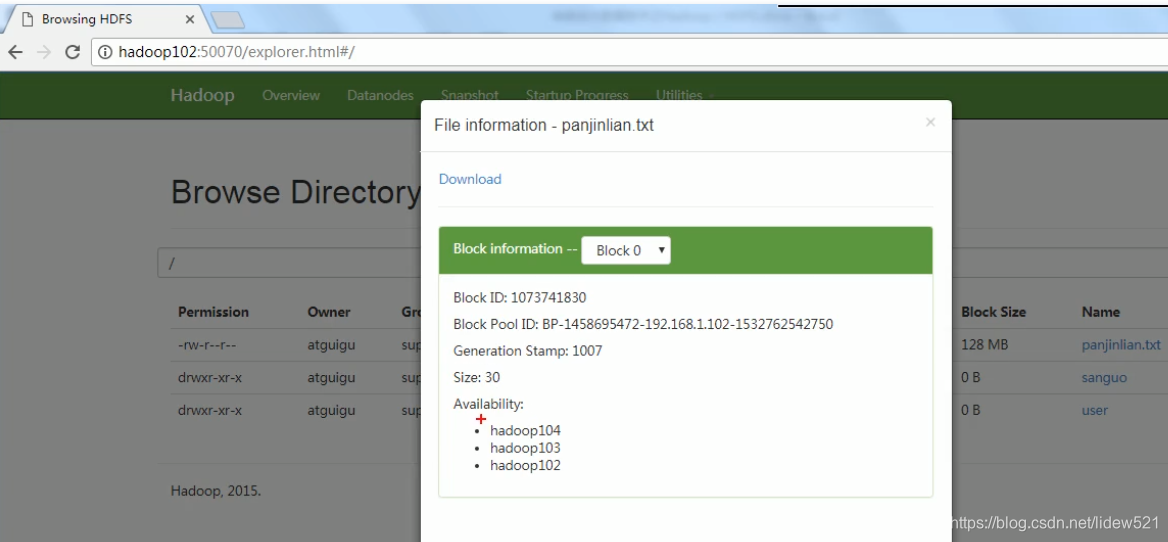

Hadoop的分布式文件系统(HDFS)是为存储大数据而设计的。它将大文件分割成若干个数据块(默认大小为128MB),然后跨多个服务器存储这些数据块的副本。这些副本的数量可以配置,常见的配置是3个副本,一个主副本和两个备份副本。

HDFS的这种复制机制本质上是冗余的一种形式,能够在单点故障情况下保障数据不丢失。每个数据块都存储有CRC校验和,用于数据完整性检测。

#### 2.3.2 HDFS校验和模型概述

HDFS校验和模型是其数据完整性的核心部分。每个数据块在写入的时候都会计算出一个CRC校验和,并将该校验和与数据块一并存储。在读取数据块时,HDFS会重新计算校验和并与存储的值进行比对,如果发现不一致,则说明数据在存储或传输过程中可能已经损坏。

当客户端读取数据时,会进行校验和验证。如果数据块损坏,HDFS会自动从其他副本中获取正确的数据块,并将损坏的副本替换。这一过程对于终端用户是透明的,确保了数据的可靠性。

由于篇幅限制,以下是针对第二章内容的表格、mermaid流程图、代码块示例等。

**表格示例**

| 校验算法 | 优点 | 缺点 | 应用场景 |

|---------|-------|-------|------------|

| CRC | 检测能力较强 | 较容易被伪造 | 网络传输、文件系统 |

| MD5 | 使用广泛 | 存在安全漏洞 | 数据完整性验证 |

| SHA-256 | 安全性高 | 计算速度较慢 | 数字签名、数据完整性验证 |

**mermaid流程图示例**

```mermaid

graph TD

A[开始校验] --> B[读取数据块]

B --> C[计算校验和]

C --> D{校验和是否匹配}

D -- 是 --> E[数据未损坏]

D -- 否 --> F[获取备份数据块]

F --> G[重新计算校验和]

G --> H{新校验和是否匹配}

H -- 是 --> E

H -- 否 --> I[报告错误]

I --> J[数据损坏处理流程]

```

**代码块示例**

```bash

# Hadoop fsck命令使用示例

hadoop fsck /path/to/hdfs/directory -files -blocks -locations

```

该

0

0