HDFS高可用性配置:打造坚如磐石的文件系统

发布时间: 2024-10-28 06:15:06 阅读量: 4 订阅数: 10

# 1. HDFS高可用性架构概述

随着大数据应用的不断深入,数据的可用性和可靠性成为企业关注的焦点。HDFS(Hadoop Distributed File System)作为大数据技术栈中核心的分布式文件存储系统,其高可用性架构对于保证大规模数据的持续服务至关重要。

## 1.1 HDFS的挑战与高可用性的重要性

HDFS设计之初就考虑到了容错性,其数据冗余策略能够有效地对抗单点故障。但是,传统的单NameNode架构在面临NameNode自身故障时,会导致整个集群不可用。随着业务的扩展,这种单点故障的风险变得无法接受。因此,HDFS的高可用性架构应运而生,它通过冗余NameNode来避免单点故障,并引入自动故障转移机制,确保数据的高可用性和业务的连续性。

## 1.2 HDFS高可用性架构的基本组成

HDFS高可用性架构主要由以下几个关键组件构成:

- **NameNode**:HDFS的核心组件,负责管理文件系统的命名空间,记录文件系统树及其属性。

- **DataNode**:存储数据块的节点,响应客户端的读写请求。

- **JournalNode**:在ZooKeeper的辅助下,负责维护HDFS的元数据状态一致性。

- **ZooKeeper**:一个分布式的协调服务,用于管理高可用性NameNode之间的状态同步。

HDFS高可用性架构的核心是将NameNode的职能分为两个角色:**Active NameNode**和**Standby NameNode**。当Active NameNode故障时,Standby NameNode能够迅速接管,实现无缝的服务切换。

在下一章节中,我们将深入探讨HDFS高可用性架构的配置理论基础,以及搭建HDFS高可用性集群的具体步骤和实践案例。

# 2. HDFS高可用性配置理论基础

## 2.1 HDFS高可用性原理

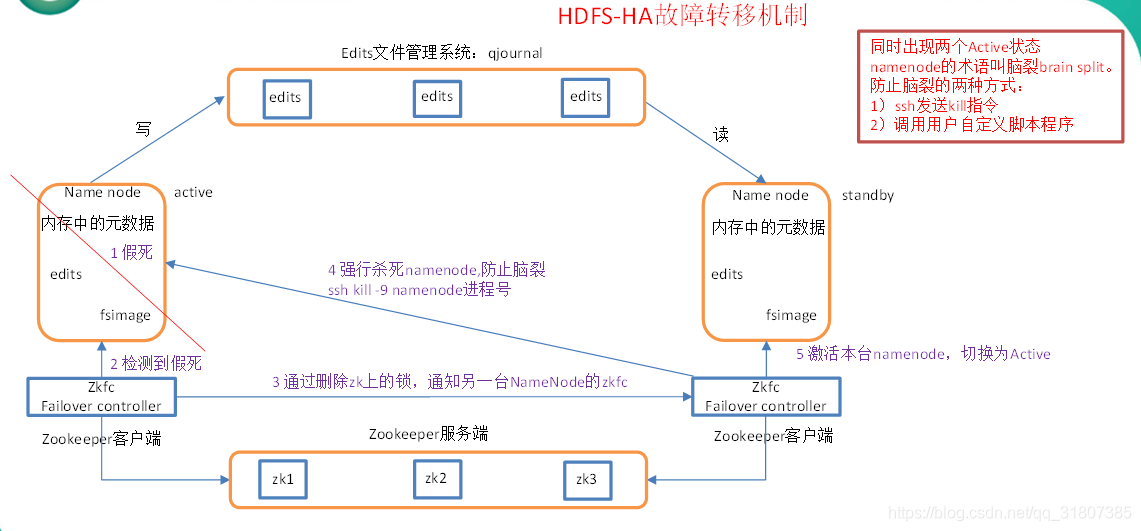

### 2.1.1 NameNode的故障转移机制

在Hadoop分布式文件系统(HDFS)中,NameNode承担着管理文件系统的元数据和命名空间的关键作用。为了提高系统的可靠性,HDFS引入了高可用性(High Availability,简称HA)架构,允许多个NameNode同时运行,以实现故障转移。

故障转移机制的核心是两个NameNode:一个处于Active状态,处理所有的客户端请求;另一个则处于Standby状态,随时准备接管。当Active NameNode出现故障,Standby会通过一种被称为“快速故障转移”的过程接管其职责,继续提供服务,从而避免单点故障。

为了实现快速故障转移,HDFS使用了ZooKeeper和JournalNodes组件来保证两个NameNode之间元数据的一致性。JournalNodes保存最近的修改日志(EditLog),而ZooKeeper则负责处理故障检测和状态变更通知。

### 2.1.2 ZooKeeper在HDFS中的作用

ZooKeeper在HDFS高可用性中的作用是至关重要的。它是一个分布式协调服务,用于维护配置信息、提供分布式锁以及进行命名空间的监视。

在HDFS的高可用性配置中,ZooKeeper集群负责管理NameNode的状态信息。当Active NameNode发生故障时,Standby NameNode将查询ZooKeeper集群,获取最新的状态信息,并据此执行故障转移操作。

ZooKeeper的选举机制确保了即使在部分节点故障的情况下,集群仍能正常工作。客户端也可以通过ZooKeeper来获取最新的NameNode状态,从而连接到当前处于Active状态的NameNode。

## 2.2 配置前的准备

### 2.2.1 硬件环境与网络要求

在搭建HDFS高可用性集群之前,必须仔细规划硬件和网络环境。每个NameNode节点应当具备足够的内存和处理能力,因为它们需要处理大量的读写请求和元数据操作。同样,ZooKeeper集群中的节点也应具备高性能硬件配置,以确保集群的稳定运行。

网络方面,所有的集群节点应该位于同一局域网内,以减少网络延迟和保证数据传输的可靠性。网络的稳定性对于避免脑裂(Split-Brain)问题也至关重要。

### 2.2.2 软件依赖和版本兼容性

搭建HDFS高可用性集群还需要对各种软件依赖和版本进行严格的兼容性检查。Hadoop集群的各个组件,包括HDFS、YARN、MapReduce等,以及ZooKeeper和相关Java库,都必须与所选的Hadoop版本兼容。

此外,集群的各个节点上的操作系统版本也应当保持一致,以便于管理和维护。进行组件升级时,应按照正确的顺序和步骤进行,以避免版本冲突或运行时错误。

## 2.3 高可用性组件详解

### 2.3.1 Active/Standby NameNode架构

HDFS高可用性配置主要依赖于Active/Standby架构。在这种模式下,两个NameNode节点之一被选举为Active节点,负责处理所有的文件系统操作和客户端请求。另一个NameNode则处于Standby状态,它同步Active节点的元数据,以便在故障转移时迅速接管。

为了实现Active和Standby NameNode之间的状态切换,引入了多个辅助组件。这些组件包括ZooKeeper用于管理故障转移和状态切换,以及JournalNodes用于同步NameNode之间的元数据操作日志。

### 2.3.2 JournalNode与Quorum的构成

JournalNode是HDFS高可用性架构中的关键组件,它负责维护一个共享编辑日志(EditLog)。在高可用性模式下,所有的元数据更改都会先写入JournalNode的共享存储中,然后再由Active NameNode和Standby NameNode进行读取和应用。

Quorum是一种多节点同步机制,确保在出现故障时,集群能达成一致的决策。在JournalNode集群中,Quorum由多个JournalNode节点构成。只有当大多数节点同意某个操作时,该操作才会被执行。这就意味着即使有部分节点失效,集群仍然能够正常工作。

```mermaid

graph LR

A[客户端] -->|请求| B[Active NameNode]

B -->|写操作| C[JournalNode集群]

C -->|同步| D[Standby NameNode]

D -->|准备| E[故障转移]

```

为了展示JournalNode集群与NameNode之间的交互,以上是一个简化的mermaid流程图,描述了客户端请求、NameNode操作和故障转移的逻辑关系。

在后续章节中,我们将具体介绍如何配置和实现这些组件,以确保HDFS集群的高可用性。

# 3. 搭建HDFS高可用性集群

搭建HDFS高可用性集群是确保大数据处理环境稳定性和可靠性的关键步骤。本章节将详细探讨如何安装和配置一个高可用的Hadoop集群,包括配置NameNode的高可用性以及启动和验证集群的各个环节。

## 3.1 安装配置Hadoop集群

### 3.1.1 安装步骤与环境准备

在搭建高可用HDFS集群之前,首先需要确保已经满足了硬件环境和网络要求。随后,我们可以开始按照以下步骤进行安装:

1. 选择合适的操作系统和版本,推荐使用类Unix系统。

2. 确保安装了Java运行环境,Hadoop需要Java来运行。

3. 解压Hadoop安装包,并配置环境变量。

4. 配置SSH免密登录,以简化后续操作。

下面是一个简化的Hadoop安装示例:

```bash

# 下载并解压Hadoop

wget ***

* 配置Hadoop环境变量

export HADOOP_HOME=/path/to/hadoop-3.3.1

export PATH=$PATH:$HADOOP_HOME/bin

# 配置SSH免密登录

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

```

### 3.1.2 配置文件详解与关键参数设置

安装完成后,需要对Hadoop的配置文件进行详细设置。主要

0

0