Kafka与HDFS集成指南:流数据高效写入技巧

发布时间: 2024-10-28 00:08:01 阅读量: 28 订阅数: 34

kafka_hdfs_consumer

# 1. Kafka与HDFS集成概述

Kafka与HDFS的集成是大数据处理领域的一个重要议题,它将流式处理和批处理两种数据处理方式结合起来,以满足日益增长的数据处理需求。集成的核心在于将Kafka作为实时数据流的处理管道,同时利用HDFS作为大数据的稳定存储解决方案。在本章节中,我们将简要介绍集成的概念、背景以及它在业务流程中的重要作用。这为后续深入探讨Kafka与HDFS集成的技术细节和优化策略打下基础,使读者能够全面理解集成架构的复杂性和实施过程中的关键考虑因素。

随着实时数据处理的普及,Kafka和HDFS的集成已成为许多公司技术栈中不可或缺的一环。本章将为读者概述集成的宏观意义,并介绍它的业务价值以及实现该集成所面对的挑战和机遇。通过掌握这些基础知识,读者可以为后续章节中的深入技术和实践打下坚实的基础。

# 2. Kafka与HDFS集成的理论基础

### 2.1 Kafka基础介绍

#### 2.1.1 Kafka架构和工作原理

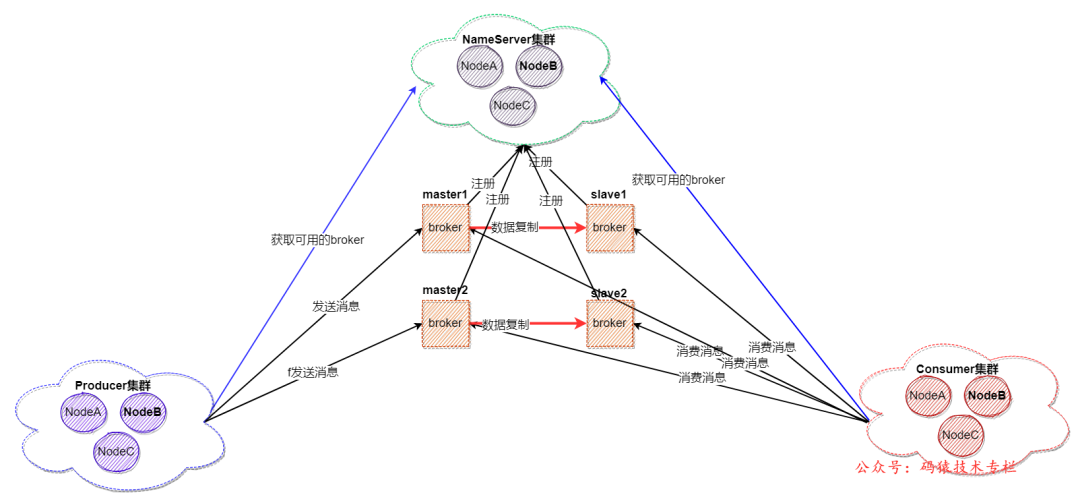

Apache Kafka是一个分布式流处理平台,主要用于构建实时数据管道和流应用程序。Kafka的核心架构设计包括生产者(Producers)、消费者(Consumers)、代理(Brokers)、主题(Topics)、分区(Partitions)以及副本(Replicas)等组件。

Kafka的工作原理基于发布/订阅(publish-subscribe)模型。生产者负责发送消息到Kafka的主题中,主题可以分为多个分区,这样可以提供并行处理消息的能力。每个分区可以有多个副本,这些副本分布在不同的Kafka代理上,以实现高可用性和容错能力。消费者组(Consumer Groups)中的消费者会订阅感兴趣的分区,并从这些分区中拉取(pull)数据进行处理。

Kafka架构如下图所示:

```mermaid

graph LR

P[生产者Producers] -->|发送消息| T[主题Topics]

T -->|多个分区| P

B[代理Brokers] -->|保存副本| P

C[消费者Consumers] -->|订阅并拉取数据| B

G[消费者组Consumer Groups] -->|协调| C

```

#### 2.1.2 Kafka的数据模型和消息传递机制

Kafka中的数据模型非常简单:数据以消息的形式进行传输,而消息则被组织进主题(Topics)。每个主题可以有一个或多个分区(Partition),这些分区分布于不同的服务器上,以平衡负载和存储需要。

消息传递机制是通过拉取(pull)的方式实现的。消费者使用拉取模型从Kafka获取数据,这样消费者可以根据自身的处理能力动态调整数据消费速率,而不需要代理推送消息。这种模式也有助于在消费者负载过高时进行流量控制。

### 2.2 HDFS基础介绍

#### 2.2.1 HDFS架构和设计特点

Hadoop分布式文件系统(HDFS)是Hadoop项目的核心组件之一,其设计目标是存储大量数据,支持高吞吐量的数据访问,并且实现高容错性。HDFS具有以下架构特点:

- **高容错性**:HDFS允许存储大量数据,并通过数据块(block)的概念以及数据副本的策略提供高容错性。

- **高吞吐量**:HDFS优化了批处理而不是低延迟的数据访问,并且在读写操作上进行优化以提高吞吐量。

- **简单的一致性模型**:HDFS使用一种写一次,读多次的模型,确保一次写入的数据在读取时不会改变。

#### 2.2.2 HDFS的数据存储机制和读写流程

HDFS将大文件分割成固定大小的数据块(默认为128MB),然后将这些数据块分别存储在多个数据节点(DataNodes)上。每一个数据块都至少有一个副本保存在不同的数据节点上,以保证数据的可靠性和容错性。

读取文件时,客户端首先与名称节点(NameNode)通信,以获取数据块的位置信息,然后直接与包含所需数据块的数据节点通信进行数据读取。写入文件时,客户端首先向名称节点请求写入数据,名称节点确定数据块存储位置后,客户端将数据直接发送给数据节点,并由数据节点负责数据的存储和副本的创建。

### 2.3 Kafka与HDFS集成的必要性

#### 2.3.1 流数据处理的需求分析

随着大数据应用的发展,对于实时流数据的处理和存储需求日益增长。Kafka能够高效地处理和转发流数据,而HDFS则为存储大量历史数据提供了良好的支持。通过将Kafka和HDFS集成,可以实现流数据的实时处理和历史数据的存储,这对于需要复杂分析和实时决策支持的应用场景至关重要。

#### 2.3.2 集成架构的比较和选择

在选择集成架构时,需要考虑系统的需求、性能以及可扩展性。比较常见的集成方式包括使用Kafka直接写入HDFS、利用Flume作为中介进行数据传输,以及使用Kafka Streams将数据处理后直接存储到HDFS。每种方式都有其优势和适用场景,通过综合考虑,可以为特定的应用需求选择最合适的集成方式。

在下一章,我们将进入Kafka与HDFS集成的配置实践,这将包括Kafka集成HDFS的准备工作、具体配置步骤,以及集成后的验证测试。

# 3. Kafka与HDFS集成的配置实践

## 3.1 Kafka集成HDFS的准备工作

### 3.1.1 环境搭建和组件安装

在开始集成Kafka和HDFS之前,需要确保环境搭建正确,并且组件安装无误。首先,需要准备一个运行Linux操作系统的服务器集群,确保集群具有足够的计算资源和存储空间。然后,按照以下步骤安装和配置相关组件:

1. 安装Java环境:Kafka和Hadoop都需要Java环境,因此需要先安装Java。可以使用包管理器安装OpenJDK。

```bash

# 安装OpenJDK

sudo yum install -y java-1.8.0-openjdk

```

2. 下载并解压Kafka和Hadoop安装包:

```bash

# 下载Kafka

wget ***

* 下载Hadoop

wget ***

* 解压安装包

tar -zxvf kafka_2.12-2.7.0.tgz

tar -zxvf hadoop-3.3.0.tar.gz

```

3. 配置环境变量,以便在命令行中直接调用Kafka和Hadoop命令:

```bash

# 设置Kafka和Hadoop的环境变量

export KAFKA_HOME=/path/to/kafka_2.12-2.7.0

export HADOOP_HOME=/path/to/hadoop-3.3.0

# 将Kafka和Hadoop的bin目录添加到PATH中

export PATH=$PATH:$KAFKA_HOME/bin:$HADOOP_HOME/bin

```

### 3.1.2 Kafka与HDFS的版本兼容性

在集成Kafka和HDFS之前,了解组件之间的版本兼容性是至关重要的。错误的版本组合可能导致集成失败或者运行时错误。下面是一些关于版本兼容性的指导:

- Kafka 2.x 与

0

0