实时监控HDFS写入:Nagios和Grafana配置全教程

发布时间: 2024-10-28 00:20:12 阅读量: 30 订阅数: 25

# 1. 实时监控HDFS写入的重要性与挑战

随着大数据技术的飞速发展,Hadoop分布式文件系统(HDFS)已成为存储海量数据的标准解决方案之一。监控HDFS的实时写入操作对于确保数据的完整性和系统的稳定性至关重要。本章将探讨实时监控HDFS写入的重要性,并分析实现此监控功能所面临的挑战。

## 1.1 HDFS写入监控的必要性

HDFS作为大数据处理的基础设施,其数据的写入操作不仅影响着数据仓库的即时性,还关乎数据存储的可靠性。实时监控可以即时发现写入过程中的异常,如硬件故障、网络问题或软件缺陷,从而避免数据丢失或损坏,确保系统的高可用性。

## 1.2 HDFS监控面临的挑战

尽管监控HDFS写入的重要性显而易见,但在实践中仍面临不少挑战。例如,Hadoop集群可能部署在不同的物理或虚拟服务器上,这要求监控解决方案能够跨节点同步监控数据。另外,监控系统需要能够高效处理大规模数据的流动,而不会成为系统性能的瓶颈。

## 1.3 监控技术选型与优化

针对这些挑战,选择合适的监控工具和技术至关重要。后续章节中将详细探讨如何使用Nagios和Grafana集成解决方案来构建高效、实时的HDFS写入监控系统。通过这些工具的组合使用,可以实现对HDFS写入活动的深入监控和可视化,为运维团队提供实时报警和历史数据分析。

以上便是第一章对实时监控HDFS写入重要性的概述,以及为何我们需要特别关注其面临的挑战,并探讨了选型监控工具的策略。在后续章节中,我们将深入讲解如何具体实现这一监控系统的配置和优化。

# 2. Nagios基础与配置

### 2.1 Nagios概述

#### 2.1.1 监控系统的作用和原理

监控系统在IT运维管理中扮演着至关重要的角色。它确保了数据中心、服务器和应用程序的稳定运行,及时发现和响应问题。Nagios作为一种开源的监控工具,其核心作用是检测网络和应用服务的状态,通过主动测试的方式识别潜在问题。当监控到异常时,Nagios会通过邮件、短信或自定义方式通知运维人员,从而实现快速响应。

监控系统通常基于以下原理工作:

- **轮询(Polling)**:监控系统周期性地检查目标设备或服务是否正常运行。

- **事件触发(Event-driven)**:监控系统响应特定事件,如日志文件的变更或特定系统性能指标。

- **代理和非代理(Agent-based and agentless)**:代理模式使用在被监控设备上安装的代理软件进行数据收集,而非代理模式通过网络协议直接访问被监控设备。

- **阈值管理**:监控系统会设定阈值,当系统状态超出正常范围时触发告警。

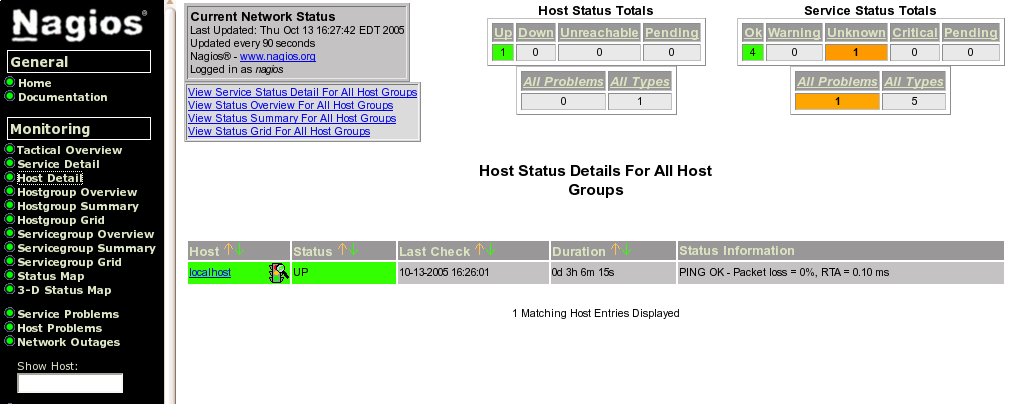

#### 2.1.2 Nagios的核心组件解析

Nagios的核心组件主要包括:

- **Nagios核心(Nagios Core)**:Nagios的主程序,负责监控、调度、产生告警。

- **Nagios插件(Nagios Plugins)**:扩展Nagios功能的工具集合,用于检查各种服务和资源状态。

- **Nagios Web界面(Nagios Web Interface)**:用于查看监控状态、历史记录、告警等的网页界面。

- **Nagios配置文件**:用于定义监控的资源、检查命令、通知规则等。

- **NRPE(Nagios Remote Plugin Executor)**:允许Nagios在远程机器上执行插件检查。

Nagios通过这些组件的高效协作,实现对IT基础架构的全面监控。

### 2.2 Nagios安装与配置

#### 2.2.1 安装Nagios及其插件

安装Nagios前,请确保已安装所有必需的依赖库和组件。下面提供在基于Debian的Linux系统中安装Nagios核心和插件的基本步骤:

1. 添加Nagios仓库(如使用apt包管理器的系统):

```bash

echo "deb ***" > /etc/apt/sources.list.d/nagios.list

wget -O - ***

```

2. 安装Nagios核心和插件:

```bash

apt-get install nagios3 nagios-nrpe-plugin

```

3. 在安装过程中,系统会要求您配置一些基本设置,如管理员密码、邮件服务器等。

#### 2.2.2 配置Nagios监控主机和服务

配置Nagios以监控主机和服务涉及编辑Nagios的配置文件。以下是一个基础示例,用于设置监控本机的HTTP服务:

1. 打开Nagios配置文件 `/etc/nagios3/conf.d/localhost_nagios2.cfg` 并添加以下内容:

```cfg

define service {

use generic-service

host_name localhost

service_description HTTP

check_command check_http

}

```

2. 这里定义了一个新的服务,`use generic-service` 指明了继承通用服务的配置,`check_command` 指定了Nagios使用的插件。

3. 重启Nagios服务以应用新配置:

```bash

service nagios3 restart

```

4. 访问Nagios Web界面(默认URL通常是 `***`),使用安装时设置的管理员凭据登录,您应该可以看到新添加的服务状态。

### 2.3 Nagios监控策略与实践

#### 2.3.1 定义监控模板

模板在Nagios中用于定义通用的配置选项,使得监控项的管理更为高效。例如,您可以通过定义一个模板来为所有服务指定相同的检查命令、通知方式等。

创建一个新的模板 `template.cfg` 文件,并添加以下内容:

```cfg

define service {

name generic-service

active_checks_enabled 1

passive_checks_enabled 1

parallelize_check 1

obsess_over_service 1

check_freshness 0

notifications_enabled 1

notification_options w,u,c,r

notification_interval 60

notification_period 24x7

contact_groups admins

register 0

}

define service{

use generic-service

host_name localhost

service_description SSH

check_command check_ssh

}

```

这里的模板 `generic-servic

0

0