HDFS写入数据连接超时问题:深入解析与应对策略

发布时间: 2024-10-30 04:49:04 阅读量: 29 订阅数: 39

# 1. HDFS写入数据连接超时问题概述

在大数据的生态系统中,Hadoop分布式文件系统(HDFS)是存储和处理大量数据的核心组件。然而,随着数据规模的不断增长,HDFS在写入数据时经常遇到连接超时的问题。这一现象不仅会影响数据处理的效率,还可能导致系统稳定性问题,对于需要进行大数据分析的企业来说,解决这类问题显得至关重要。

## 1.1 HDFS写入连接超时的定义

当客户端尝试向HDFS写入数据时,若超过预设的时间限制而没有得到响应,则会引发超时异常。这通常意味着数据节点(DataNode)未能在指定时间内与名称节点(NameNode)完成数据的确认交换。

## 1.2 超时问题的影响

连接超时问题可能导致数据写入失败,引发一系列连锁反应,包括业务流程中断、数据不一致等问题。在企业级应用中,这样的问题往往会给业务带来不可接受的风险。

## 1.3 超时问题的普遍性

尽管HDFS非常成熟且广泛部署在众多企业中,但由于各种原因,如硬件限制、网络配置不当或不合理的系统配置,超时问题普遍存在。因此,对这些问题的深入理解与应对策略的制定,对于保障系统的可靠性至关重要。

# 2. HDFS写入流程与超时理论基础

## 2.1 HDFS写入数据流程解析

### 2.1.1 HDFS架构与数据写入机制

Hadoop分布式文件系统(HDFS)作为大数据处理的存储基础,其架构设计遵循高容错性、高吞吐量的特点,特别适合在廉价硬件上运行大数据集。HDFS通过NameNode和DataNode的分层架构,将元数据管理和数据存储分离,保证了系统的可靠性和可扩展性。

在数据写入HDFS时,首先客户端会向NameNode发起写入请求,NameNode会根据数据副本策略确定数据存储的目标DataNode。客户端随后与这些目标DataNode进行直接通信,分块写入数据。数据在写入的同时会被复制到多个DataNode以防止数据丢失。

```mermaid

graph LR

A[客户端] -->|写入请求| B(NameNode)

B -->|分配存储| C[DataNode 1]

B -->|分配存储| D[DataNode 2]

B -->|分配存储| E[DataNode 3]

A -->|数据块| C

A -->|数据块| D

A -->|数据块| E

```

### 2.1.2 数据节点与名称节点的通信过程

数据节点(DataNode)与名称节点(NameNode)之间的通信是HDFS高效运作的关键。DataNode会定时向NameNode发送心跳信号,报告自身状态。NameNode会响应心跳并指示DataNode进行数据的复制、删除等操作。在数据写入时,客户端通过NameNode获取可用的DataNode列表后,将数据以流的形式直接传输给DataNode进行存储。这个过程中,NameNode不直接参与数据的传输,从而降低了其负载。

## 2.2 超时问题的理论分析

### 2.2.1 网络延迟与超时的关系

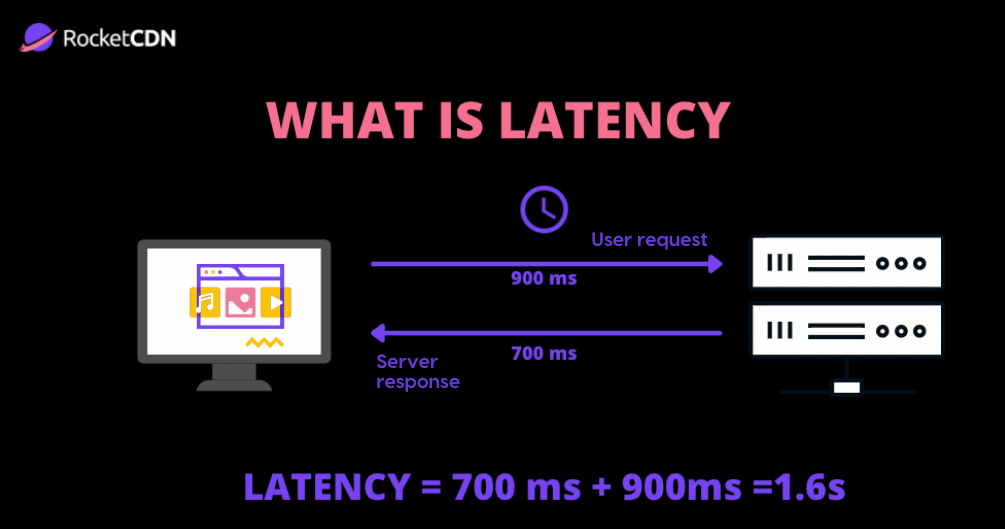

网络延迟是数据在源和目的地之间传输所需的总时间。在HDFS的数据写入过程中,网络延迟将直接影响到数据块的传输速度。如果网络延迟过高,那么数据传输过程中的超时风险也会随之增加。这种超时可能会导致数据写入失败,需要重试,增加了系统的开销和写入延迟。

### 2.2.2 超时设置的考量因素

在分布式系统设计中,超时设置需要综合考虑多个因素,包括网络质量、硬件性能、系统负载等。太短的超时时间会导致正常的网络波动或负载波动被误判为超时,而过长的超时时间则会使系统对外部异常的响应变得迟缓。因此,合理的超时设置应能够适应系统的实际运行环境,并留有一定的调整空间。

## 2.3 影响写入超时的主要因素

### 2.3.1 硬件性能对超时的影响

硬件性能,尤其是DataNode所在服务器的I/O性能,直接影响着数据写入的速度。如果硬件性能不足,例如磁盘读写速度慢,那么数据写入操作将会受到影响,导致超时。此外,CPU和内存资源的不足也会影响数据处理和网络通信,间接导致超时问题。

### 2.3.2 网络配置与超时的相关性

网络配置,包括带宽、网络拓扑结构和路由策略等,对HDFS的性能有着直接的影响。不良的网络配置会导致数据传输过程中出现延迟或丢包,增加超时发生的概率。例如,如果网络带宽不足,数据块在传输过程中可能出现拥堵,进而导致超时。

### 2.3.3 负载与流量对超时的影响

HDFS在高负载或高流量的情况下,系统的响应时间会有所增加。高负载可能会导致数据节点处理能力饱和,影响数据写入的速度。同时,高流量意味着网络通道被大量数据占据,数据传输的效率会下降,从而增加了超时的风险。

```mermaid

graph LR

A[客户端] -->|高负载| B(NameNode)

B -->|高负载| C[DataNode 1]

B -->|高负载| D[DataNode 2]

B -->|高负载| E[DataNode 3]

A -->|高流量| C

A -->|高流量| D

A -->|高流量| E

```

通过分析HDFS的数据写入流程和超时问题的理论基础,我们可以更加深入地理解超时问题发生的环境和条件。在下一章节中,我们将具体探讨如何诊断和定位HDFS中的超时问题,以及如何运用实际案例来进行分析。

# 3. 超时问题的诊断与定位

## 3.1 超时问题的诊断方法

### 3.1.1 日志分析技术

在分布式系统中,日志分析是诊断问题的第一步。HDFS作为分布式文件系统,其日志记录了从客户端到数据节点和名称节点的所有交互信息。通过分析HDFS的日志文件,可以获取系统运行时的状态信息,定位到可能的超时问题源头。

首先,开启HDFS的调试日志,可以使用以下命令:

```bash

hdfs --daemon loglevel nn

```

0

0