MongoDB性能调优指南:提升数据库效率和响应速度

发布时间: 2024-07-16 21:48:50 阅读量: 48 订阅数: 38

# 1. MongoDB性能调优概述**

MongoDB性能调优对于提升数据库效率和响应速度至关重要。通过优化硬件、数据库配置、索引、查询和数据建模,可以显著提高MongoDB的性能。本文将全面介绍MongoDB性能调优的最佳实践,帮助读者了解如何优化MongoDB数据库以满足其需求。

MongoDB性能调优涉及多个方面,包括:

- **硬件优化:**优化服务器配置、存储和网络设置可以提高MongoDB的整体性能。

- **数据库配置:**调整数据库配置参数,如内存分配和线程池大小,可以优化MongoDB的资源利用率。

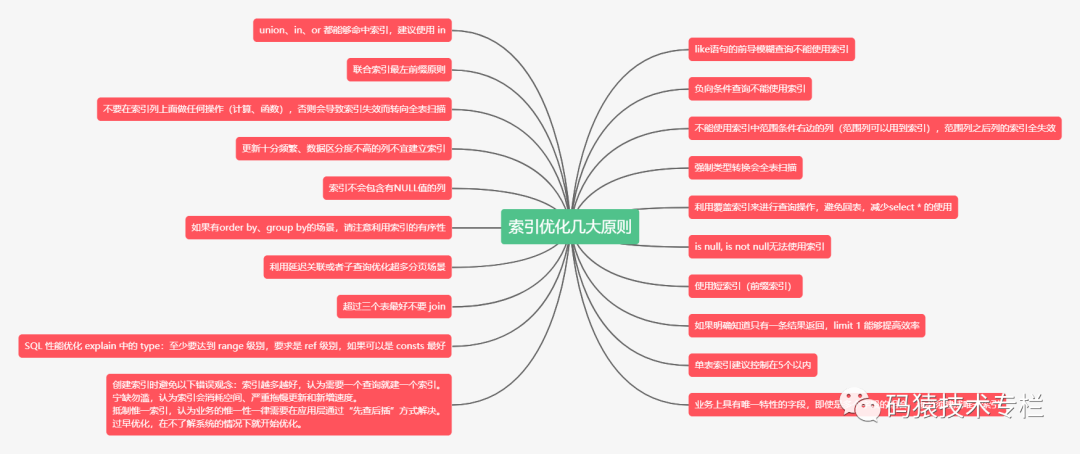

- **索引优化:**创建和维护适当的索引可以显著提高查询性能。

# 2. 硬件和基础设施优化

### 2.1 服务器配置和硬件选择

**服务器配置**

MongoDB的性能与服务器配置密切相关。以下是一些重要的配置参数:

| 参数 | 描述 |

|---|---|

| `wiredTigerCacheSizeGB` | 内存中分配给WiredTiger存储引擎的缓存大小 |

| `storage.dbPath` | 数据文件存储路径 |

| `storage.journal.enabled` | 是否启用日志记录 |

| `net.port` | MongoDB监听的端口号 |

| `replication.replSetName` | 复制集名称 |

**硬件选择**

选择合适的硬件对于MongoDB性能至关重要。以下是一些关键考虑因素:

* **CPU:**选择具有足够内核和时钟速度的CPU,以处理查询和写入负载。

* **内存:**分配足够的内存以容纳数据和索引,并避免内存不足的情况。

* **存储:**选择具有高IOPS和低延迟的存储设备,例如SSD或NVMe。

* **网络:**确保网络连接稳定且带宽充足,以支持数据传输和复制。

### 2.2 存储和网络优化

**存储优化**

MongoDB使用WiredTiger存储引擎,它提供多种存储选项。以下是一些优化技巧:

* **使用WiredTiger压缩:**启用压缩以减少数据文件的大小和提高性能。

* **选择合适的存储格式:**根据数据类型和访问模式选择合适的存储格式,例如JSON、BSON或CSV。

* **预分配文件:**预先分配数据文件,以避免在插入数据时出现文件碎片。

**网络优化**

网络延迟和带宽会影响MongoDB的性能。以下是一些优化技巧:

* **使用TCP连接池:**启用TCP连接池以减少建立和关闭连接的开销。

* **调整TCP缓冲区大小:**根据网络带宽调整TCP缓冲区大小,以优化数据传输。

* **使用Jumbo帧:**使用Jumbo帧以减少网络开销并提高吞吐量。

**代码块示例:**

```

# 启用WiredTiger压缩

db.adminCommand({ setParameter: 1, parameters: { storage: { compression: "snappy" } } })

# 预分配数据文件

db.adminCommand({ setParameter: 1, parameters: { storage: { preallocateFiles: true } } })

# 调整TCP缓冲区大小

sysctl -w net.core.rmem_max=16777216

sysctl -w net.core.wmem_max=16777216

```

**逻辑分析:**

* 启用WiredTiger压缩可以减少数据文件的大小,从而提高读取和写入性能。

* 预分配数据文件可以防止文件碎片,从而提高插入性能。

* 调整TCP缓冲区大小可以优化数据传输,减少网络延迟。

# 3. 数据库配置和索引优化**

**3.1 数据库配置参数调优**

MongoDB 提供了广泛的配置参数来调整数据库的行为和性能。优化这些参数可以显著提高数据库的吞吐量、响应时间和稳定性。

**参数说明:**

| 参数 | 描述 | 默认值 |

|---|---|---|

| `wiredTigerCacheSizeGB` | WiredTiger 缓存大小,以千兆字节为单位 |

0

0