【掌讯3158多核性能优化】:核心调度与任务管理的高效策略

发布时间: 2024-12-03 10:11:08 阅读量: 25 订阅数: 23

多核系统的实时任务调度算法研究

参考资源链接:[掌讯3158规格书安卓导航主板掌](https://wenku.csdn.net/doc/6412b700be7fbd1778d48bd3?spm=1055.2635.3001.10343)

# 1. 多核处理器的基本原理与架构

## 1.1 基本原理概述

多核处理器,顾名思义,是包含多个计算核心的微处理器。每个核心都是一个相对独立的CPU,可以同时处理多个任务,显著提高了处理能力。这种架构的出现,是为了满足日益增长的计算需求,同时突破单核处理器频率提升带来的功耗和热效应限制。

## 1.2 核心架构解析

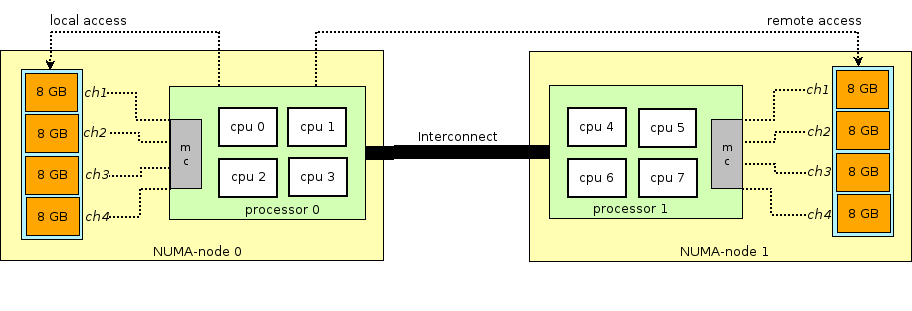

在多核处理器架构中,每个核心通常拥有独立的ALU(算术逻辑单元)、寄存器和缓存,但共享更高级别的缓存(如L2或L3),以及内存控制器等资源。多个核心通过高速互连(如Intel的QPI或AMD的HyperTransport)来通信,保证数据在核心间有效传输。

## 1.3 核心间的同步机制

多核处理器在执行并行任务时,核心间的同步机制至关重要。通过使用锁、信号量、事件标志等同步原语,确保数据的一致性和完整性,防止竞态条件和资源冲突。例如,缓存一致性协议如MESI(修改、独占、共享、无效)确保多个核心对共享缓存行的访问不会出现数据不一致的问题。

# 2. 核心调度的基础理论与策略

## 核心调度理论

### 多核处理器的同步机制

多核处理器同步机制是保证在多核环境中各处理单元能够高效、有序地协调工作的重要保障。传统同步机制包括互斥锁、信号量、条件变量等,这些都是基于软件的解决方案。然而,随着硬件技术的发展,诸如原子操作、事务内存等硬件级别的同步机制也在逐渐被应用。

### 调度算法的基本类型与应用场景

核心调度算法是决定任务在处理器核心间如何分配的关键,其目标是最大化资源的利用率和程序性能。常见的调度算法包括轮转调度、优先级调度、先来先服务(FCFS)和最短作业优先(SJF)等。每种算法都有其适用的场景,例如,实时系统可能更偏好于优先级调度算法,而通用的多任务操作系统可能使用更为复杂的调度策略。

## 核心调度技术

### 负载平衡策略

负载平衡是指在多核系统中,通过动态分配任务到各个核心,使得所有核心的工作负载大致相等。有效的负载平衡策略能够提高系统的整体性能,并减少由于核心间负载不均造成的性能瓶颈。

### 优先级调度与实时性保障

实时系统对调度算法有更高的要求,必须保证任务在特定时间内完成。优先级调度算法将任务按照优先级进行排序,确保高优先级任务能够得到优先处理。同时,实时调度策略如速率单调调度(RM)和最早截止时间优先(EDF)常被用于实时系统以保证任务的实时性。

### 多级队列调度机制

多级队列调度是一种更为复杂但有效的调度策略,它将任务划分为多个队列,每个队列根据特定的调度规则运行。例如,可以有高优先级队列和低优先级队列,不同队列内部使用不同的调度算法。这种方式使得系统可以同时满足不同的性能目标,如公平性、响应性和吞吐量。

## 核心调度的实践分析

### 实际案例研究:Linux内核调度器

Linux内核调度器是研究核心调度的绝佳范例。Linux内核使用了CFS(完全公平调度器)算法,它旨在为每个运行的进程提供完全公平的处理器时间。CFS考虑了进程的虚拟运行时间,使得调度器根据这个度量而非时间片来进行调度决策。通过分析Linux内核调度器的源码和调度策略,我们可以深入理解现代操作系统的调度机制。

### 性能评估与调优方法

性能评估通常包括吞吐量、响应时间、CPU使用率等指标。对核心调度进行调优时,首先需要确定性能瓶颈,然后根据具体应用场景选择合适的调度策略。例如,对于I/O密集型应用,可能需要优化I/O等待时间,减少上下文切换,而对CPU密集型应用则应优化计算资源的分配。调优工具如htop, iotop等可以帮助监控和分析系统性能,进一步指导调优实践。

本章节的第二部分详细介绍了核心调度的理论基础,涉及了多核处理器中重要的同步机制、调度算法类型及其应用场景。接下来,深入到核心调度技术的实现细节,包括负载平衡策略、优先级调度、多级队列机制等。最后,通过实际案例和性能评估方法,揭示了核心调度在实际应用中的具体操作和优化手段,为理解和优化多核处理器性能提供了宝贵的经验和工具。

# 3. ```

# 第三章:任务管理的优化策略

任务管理作为操作系统中的核心功能,不仅涉及到任务的创建、执行,还包含任务调度、同步、通信以及资源分配等关键环节。优化任务管理是提升系统整体性能、保证系统稳定性的重要手段。本章节深入探讨任务管理的理论基础、技术实现和实践经验。

## 3.1 任务管理理论

任务管理理论是指导任务管理实践的基石。理解任务划分与分配原则,以及并行与并发模型,对构建高效的多任务执行环境至关重要。

### 3.1.1 任务划分与分配原则

任务划分是将大的工作负载分解成更小的可管理单元。这有助于更高效地利用系统资源,同时也可以提高系统的可靠性。一个好的任务划分应该遵循以下原则:

1. **任务粒度的均衡**:过大或过小的任务粒度都可能导致资源浪费或调度开销增大。根据工作负载的特性和系统能力,找到最佳的粒度平衡点是关键。

2. **任务依赖性最小化**:减少任务间的依赖可以提高系统的并行能力,同时降低因同步和等待导致的延迟。

3. **数据局部性原则**:保证任务在处理数据时尽可能访问本地资源,从而减少网络或内存访问延迟。

### 3.1.2 并行与并发模型解析

并行和并发是多任务处理的两种不同模型。并行是指在同一时刻有多个任务在执行,而并发是指看起来像是同时在执行,但实际上是在不同时间间隔内快速切换,给用户一种同时运行的错觉。

1. **并行模型**:通过多核处理器或其他并行硬件资源,可以实现真正的任务并行执行。并行模型通常用于科学计算和大数据处理等领域,其中计算密集型任务可以通过并行化显著减少执行时间。

2. **并发模型**:并发模型在单核处理器或者无法实现硬件级并行的系统中常见。操作系统通过调度算法模拟出任务的并行执行,这对于提高用户体验和系统资源利用率至关重要。

## 3.2 任务管理技术

任务管理技术关注任务同步与通信机制的设计与实现,以及如何处理任务依赖与调度限制。

### 3.2.1 任务同步与通信机制

任务同步与通信是保证任务间正确协作的关键。为了确保数据一致性,系统必须实现有效的同步机制,如互斥锁、信号量、条件变量等。

1. **互斥锁**:保证某一时刻只有一个任务可以访问共享资源。

2. **信号量**:管理多个资源的访问,允许一定数量的任务并发地访问资源。

3. **条件变量**:用于任务之间的协调,使得任务能够在某些条件未

```

0

0