KNN算法原理解析及推广:从距离度量到K值选择

发布时间: 2024-04-15 05:04:52 阅读量: 388 订阅数: 61

KNN算法原理及应用.pdf

# 1. 引言

#### 1.1 介绍

K最近邻(KNN)算法是一种简单而有效的机器学习算法,常用于分类和回归问题。它基于实例的学习,通过计算两个样本数据之间的距离来进行分类或回归预测。KNN算法在模式识别、数据挖掘和推荐系统等领域广泛应用。

#### 1.2 研究背景

随着大数据时代的到来,KNN算法因其易实现、直观简单的特点备受关注。但在实际应用中,如何选择合适的K值、优化模型性能,以及处理数据特征选择等问题仍然值得探讨。本文将深入探讨KNN算法的原理、应用拓展及案例分析,旨在帮助读者更好地理解和应用KNN算法。

# 2. KNN算法基础

- #### 2.1 KNN算法概述

KNN(K-Nearest Neighbors)算法是一种常见的监督学习算法,用于解决分类和回归问题。该算法主要思想是通过测量不同特征值之间的距离来对数据进行分类。在分类问题中,对于一个未知类别的数据点,通过与其最近邻的K个训练样本对其进行分类,多数投票机制决定其类别。在回归问题中,K个最近邻的平均值被用来预测未知数据点的值。

- #### 2.2 KNN算法原理解析

- ##### 2.2.1 特征空间与距离度量

KNN算法中采用距离度量来计算不同数据点之间的距离。常用的距离度量方法包括欧氏距离、曼哈顿距离、闵可夫斯基距离等。特征空间中的每个维度代表数据的一个特征,距离度量帮助算法确定数据点在多维空间中的相似程度。

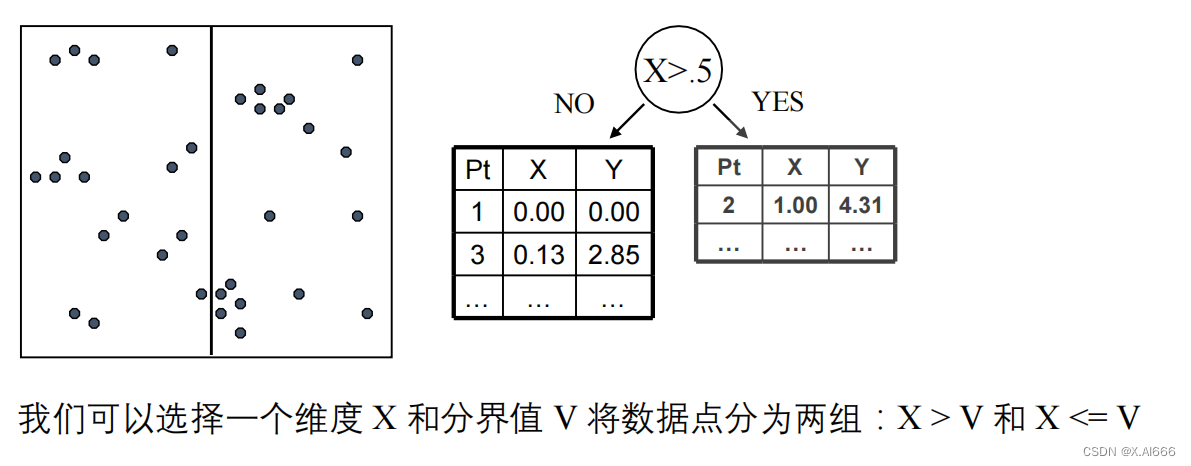

- ##### 2.2.2 KNN分类过程

在KNN分类过程中,对于一个未知类别的数据点,首先计算其与所有已知数据点的距离。然后选取与该数据点距离最近的K个数据点,利用多数投票原则确定该数据点的类别。即选择K个数据点中占比最多的类别作为预测结果。

- ##### 2.2.3 KNN回归过程

KNN回归过程与分类过程类似,但是不同之处在于预测值的计算方式。对于一个未知的数据点,同样找出与其距离最近的K个数据点,然后以这K个数据点的平均值作为未知数据点的预测值。

根据数据点间的距离计算分类并预测结果的KNN算法,在特征空间中的度量和决策过程中,采用了丰富的理论知识进行数据点间的比较,从而准确判断未知数据点的类别或值。

# 3. KNN算法应用拓展

#### 3.1 特征选择与预处理

在机器学习领域,特征选择与预处理是构建高效模型的重要步骤。数据标准化是特征预处理中的一项基本操作,通过将各个特征的分布转化为均值为0,方差为1的标准正态分布,有利于加快模型收敛速度。特征降维则是为了减少特征空间的维度,剔除冗余信息,简化模型复杂度,提高算法效率。数据平衡处理则着重解决数据不平衡带来的问题,确保算法能更好地学习到数据分布情况。

##### 3.1.1 数据标准化

数据标准化通常包括 Z-score 标准化和 Min-Max 标准化两种方式。Z-score 标准化通过减去均值后再除以标准差的方法将特征数据转换为标准正态分布。Min-Max 标准化则通过线性变换将特征数据缩放到 [0, 1] 的范围内。

```python

# 示例代码:Z-score 标准化

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

```

##### 3.1.2 特征降维

特征降维可以通过主成分分析(PCA)等方法实现,PCA通过线性变换将原始特征空间映射到新的低维空间,保留原始数据集中的主要信息。这有助于减少特征的冗余性,提高算法的运行效率。

##### 3.1.3 数据平衡处理

数据平衡处理主要针对类别不平衡问题,其中一种常见的方法是过采样(over-sampling)和欠采样(under-sampling)。过采样通过增加少数类样本的复制来平衡数据集,而欠采样则通过减少多数类样本的数量来达到平衡。

#### 3.2 模型优化与性能提升

在应用 KNN 算法时,模型的优化与性能提升是至关重要的。交叉验证与参数调优可以帮助我们选择最优的超参数,提升模型泛化能力。加权 KNN 算法可以根据样本间的距离赋予不同的权重,更加灵活地适应各种情况。距离加权 KNN 是一种改进的 KNN 算法,通过赋予距离较近的样本更高的权重,提高对周围样本的关注程度。

##### 3.2.1 交叉验证与参数调优

交叉验证通过将数据集分为训练集和验证集,在不同子集上训练模型并评估性能,从而选出最优参数。参数调优则是指根据交叉验证的结果,调整模型的超参数,如 K 值、距离度量方式等。

```python

# 示例代码:KNN 参数调优

from sklearn.model_selection import GridSearchCV

from sklearn.neighbors import KNeighborsClassifier

param_grid = {'n_neighbors': [3, 5, 7, 9]}

grid_search = GridSearchCV(KNeighborsClassifier(), param_grid, cv=5)

grid_search.fit(X_train, y_train)

best_k = grid_search.best_params_['n_neighbors']

```

##### 3.2.2 加权KNN算法

加权 KNN 算法通过赋予样本不同的权重,可以更准确地捕捉样本之间的相似度。距离较近的样本将拥有更高的权重,从而影响最终的分类或回归结果。

##### 3.2.3 距离加权KNN

距离加权 KNN 是对传统 KNN 算法的改进,通过对每个邻居样本的权重进行加权求和,距离较近的样本权重更大,反之权重更小,从而提高模型的准确性和泛化能力。

通过特征处理与模型优化,KNN 算法在实际应用中能够更好地服务于各种场景,并取得更加准确的预测效果。

# 4. KNN算法应用案例

- #### 4.1 图像识别

- ##### 4.1.1 特征提取与图像表示

对于图像识别任务,首先需要进行特征提取和图像表示。在KNN算法中,常用的特征包括颜色直方图、灰度直方图、边缘直方图等。通过这些特征的提取,可以将图像转换为向量形式,便于算法计算和比较。

- ##### 4.1.2 K值选择在图像识别中的应用

KNN算法中的K值选择在图像识别中尤为关键。选择较小的K值可能会导致过拟合,而选择较大的K值可能会导致欠拟合。针对图像识别任务,需要通过交叉验证等方法来选择最优的K值,以确保模型的泛化能力和准确性。

- ##### 4.1.3 实际案例分析

在图像识别领域,KNN算法有着广泛的应用。例如,在人脸识别中,可以利用KNN算法对提取的人脸特征进行比对和识别。通过对图像数据进行特征提取,然后利用KNN算法进行匹配,可以快速准确地识别不同的人脸。

- #### 4.2 推荐系统

- ##### 4.2.1 用户-物品关联建模

推荐系统中的用户-物品关联建模是推荐算法的基础。通过分析用户对物品的行为数据,可以建立用户和物品之间的关联关系。在KNN算法中,可以根据用户对物品的喜欢程度来计算用户之间的相似度,从而进行推荐。

- ##### 4.2.2 基于KNN的推荐算法

KNN算法在推荐系统中常用于基于用户的协同过滤。通过计算用户之间的相似度,可以找到与目标用户相似的邻居用户群体,然后根据邻居用户对物品的喜好程度进行推荐。这种方法简单直观,易于实现。

- ##### 4.2.3 推荐系统应用场景

在电商平台、社交网络等应用场景中,推荐系统起着至关重要的作用。利用KNN算法可以为用户推荐个性化的商品、信息或好友关系,提高用户体验和平台的粘性。通过不断地优化推荐算法,可以提升系统的推荐准确度和用户满意度。

# 5. 结语

#### 5.1 总结与展望

在本文中,我们深入探讨了KNN算法在机器学习领域的应用和原理。通过对KNN算法的概述和基础原理的解析,我们了解了特征空间与距离度量、KNN分类过程以及KNN回归过程。同时,我们拓展了KNN算法的应用,包括特征选择与预处理、模型优化与性能提升等方面。最后,我们通过KNN算法在图像识别和推荐系统中的应用案例,展示了算法在实际场景中的表现和价值。

通过对KNN算法的深入研究和应用实例的分析,我们可以得出以下结论和展望:

1. **优点和局限性**:

- 优点:KNN算法简单易理解,适用于多种类型的数据,对异常值不敏感。

- 局限性:在处理大规模数据时效率低下,需要较多的内存空间。同时,对于维度较高的数据集,也容易受到维数灾难的影响。

2. **改进空间**:

- 在特征选择方面,可以进一步研究如何选择更具代表性的特征,提升模型的泛化能力。

- 在模型优化方面,可以探索更多的参数调优方法,例如使用更复杂的距离加权策略。

3. **未来展望**:

- 随着大数据和人工智能技术的快速发展,KNN算法在实践中将会得到更广泛的应用,尤其是在个性化推荐、图像识别等领域。

4. **实践中的建议**:

- 在使用KNN算法时,需要注意选择合适的K值,进行数据预处理和模型评估,以保证算法的准确性和稳定性。

5. **总结**:

通过本文的学习,读者可以对KNN算法有一个全面的了解,并且能够在实际项目中灵活应用。我们希望本文可以帮助读者更好地理解KNN算法,并且激发更多关于机器学习算法的学习和探索。

#### 5.2 参考文献

1. Han, J., Kamber, M., & Pei, J. (2011). Data mining: concepts and techniques. Elsevier.

2. Hastie, T., Tibshirani, R., & Friedman, J. (2009). The elements of statistical learning: data mining, inference, and prediction. Springer Science & Business Media.

3. Zhang, P., & Tjhi, W. C. (2010). Domain-driven data mining in action. Springer Science & Business Media.

4. Bishop, C. M. (2006). Pattern recognition and machine learning. springer.

0

0