A3C算法的代码实现:Python实战,快速上手强化学习

发布时间: 2024-08-20 07:01:24 阅读量: 47 订阅数: 46

pytorcha3c是A3C算法的一个PyTorch实现

# 1. 强化学习与A3C算法**

强化学习是一种机器学习范式,它允许智能体通过与环境交互并获得奖励来学习最佳行为策略。它特别适用于解决具有延迟奖励和不确定性等挑战的复杂决策问题。

A3C(异步优势行动者-评论家)算法是强化学习中一种流行的算法,它结合了优势行动者-评论家方法和异步并行执行。A3C算法允许多个智能体同时探索环境,从而提高训练效率并加快收敛速度。此外,它还利用神经网络来近似价值函数和策略,使其能够处理高维和连续的动作空间。

# 2. Python实战:A3C算法的代码实现

### 2.1 环境搭建与代码结构

**环境搭建**

- 安装必要的库:`pip install gym tensorflow numpy`

- 创建一个名为`a3c`的项目目录

- 在`a3c`目录下创建以下文件:

```

- main.py

- actor_critic.py

- environment.py

```

**代码结构**

- `main.py`:主脚本,负责环境初始化、算法训练和评估

- `actor_critic.py`:Actor-Critic网络模型,定义神经网络结构和训练方法

- `environment.py`:环境封装,定义环境交互和奖励计算

### 2.2 Actor-Critic网络模型

**神经网络结构**

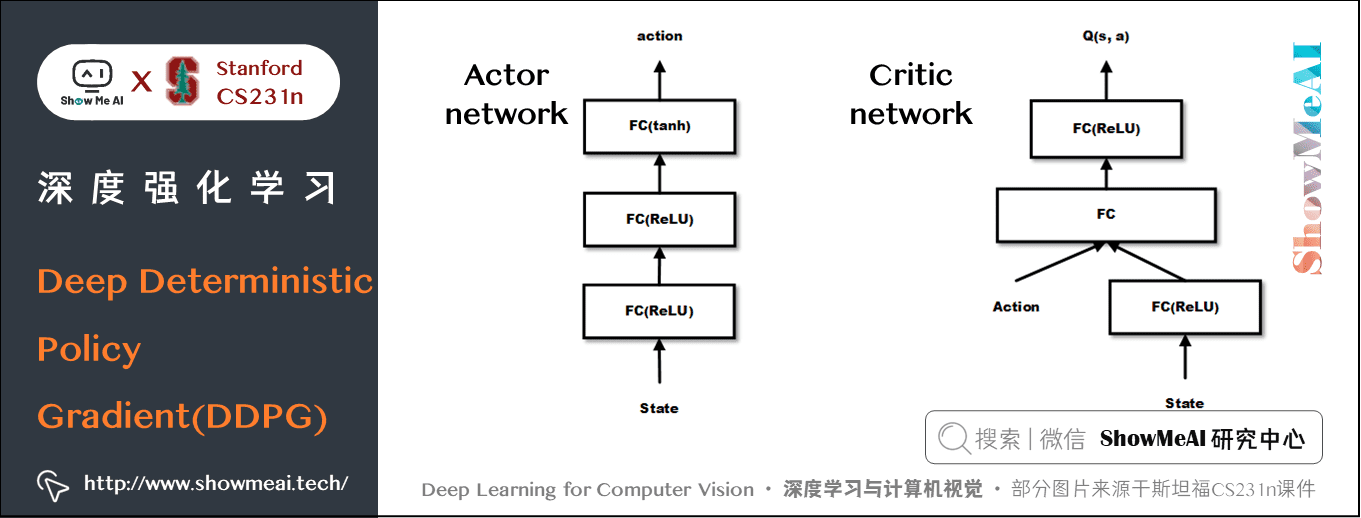

Actor-Critic网络由两个神经网络组成:

- **Actor网络:**输出动作概率分布

- **Critic网络:**估计状态价值函数

网络结构如下:

```python

class ActorCriticNetwork(nn.Module):

def __init__(self, state_dim, action_dim):

super(ActorCriticNetwork, self).__init__()

self.actor = nn.Sequential(

nn.Linear(state_dim, 256),

nn.ReLU(),

nn.Linear(256, action_dim),

nn.Softmax(dim=-1)

)

self.critic = nn.Sequential(

nn.Linear(state_dim, 256),

nn.ReLU(),

nn.Linear(256, 1)

)

```

**训练方法**

网络训练使用策略梯度算法:

- **Actor网络:**最大化动作概率与奖励的期望值

- **Critic网络:**最小化状态价值函数与实际奖励的均方误差

训练代码如下:

```python

def train_actor_critic(actor_critic, optimizer, state, action, reward):

# 计算策略梯度

log_prob = actor_critic.actor(state).log_prob(action)

advantage = reward - actor_critic.critic(state)

actor_loss = -torch.mean(log_prob * advantage)

# 计算价值函数误差

critic_loss = torch.mean((reward - actor_critic.critic(state)) ** 2)

# 更新网络

optimizer.zero_grad()

actor_loss.backward()

critic_loss.backward()

optimizer.step()

```

### 2.3 训练过程与参数优化

**训练过程**

1. 初始化环境和Actor-Critic网络

2. 循环执行以下步骤:

- 与环境交互,获取状态、动作、奖励

- 计算动作概率和状态价值

- 更新Actor-Critic网络

3. 评估算法性能

**参数优化**

训练过程中的超参数包括:

- 学习率

- 衰减率

- 梯度裁剪

- 经验回放池大小

可以通过网格搜索或贝叶斯优化等方法优化这些参数。

**代码示例**

```python

# 设置超参数

learning_rate = 0.001

gamma = 0.99

entropy_coef = 0.01

value_loss_coef = 0.5

# 训练算法

for episode in range(num_episodes):

state = env.reset()

done = False

while not done:

# 与环境交互

action = actor_critic.actor(state).sample()

next_state, reward, done, _ = env.step(action)

# 计算策略梯度和价值函数误差

log_prob = actor_critic.actor(state).log_prob(action)

advantage = reward - actor_critic.critic(state)

actor_loss = -torch.mean(log_prob * advantage)

critic_loss = torch.mean((reward - actor_critic.critic(state)) ** 2)

# 更新网络

optimizer.zero_grad()

actor_loss.backward()

critic_loss.backward()

optimizer.step()

# 更新状态

state = next_state

```

# 3.1 A3C算法原理及优势

**A3C算法原理**

A3C算法(Asynchronous Advantage Actor-Critic)是一种异步并行的强化学习算法,它将Actor-Critic方法与异步更新相结合。Actor网络负责根据当前状态选择动作,而Critic网络负责评估动作的价值。

A3C算法的训练过程如下:

1. **环境初始化:**初始化环境并重置状态。

2. **Actor网络选择动作:**根据当前状态,Actor网络选择一个动作。

3. **执行动作:**在环境中执行所选动作,并观察奖励和下一个状态。

4. **计算梯度:**计算Actor网络和Critic网络的梯度,用于更新网络权重。

5. **更新网络:**

0

0