A3C算法的变体:探索不同版本,解锁强化学习新可能

发布时间: 2024-08-20 06:54:10 阅读量: 47 订阅数: 46

强化学习算法-基于python的强化学习a3c算法实现

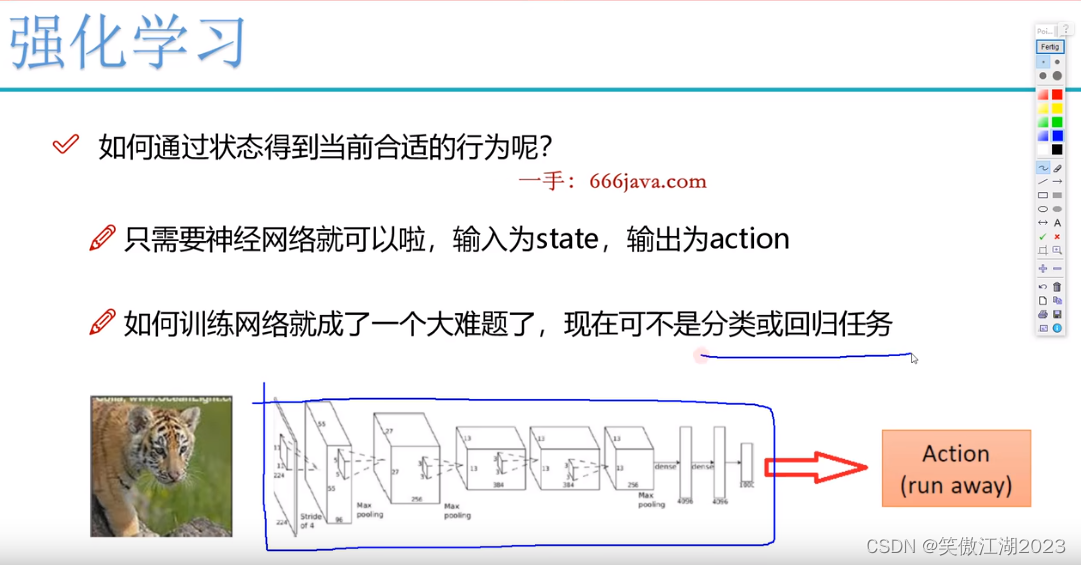

# 1. 强化学习简介

强化学习是机器学习的一个分支,它允许代理在与环境的交互中学习最优行为。与监督学习不同,强化学习中没有明确的标签数据,代理必须通过试错来探索环境并学习奖励最大的动作。强化学习算法通常使用价值函数或策略函数来表示代理的知识,并通过与环境交互不断更新这些函数,以提高代理的性能。

# 2. A3C算法原理及变体

### 2.1 A3C算法的核心思想

A3C(Asynchronous Advantage Actor-Critic)算法是一种强化学习算法,它结合了策略梯度和值函数方法。A3C算法的核心思想是使用多个异步并行的actor-critic网络来估计值函数和策略梯度。

在A3C算法中,actor网络负责生成动作,而critic网络负责评估actor网络生成的动作的价值。actor和critic网络都通过与环境的交互来更新。

A3C算法的并行性使其能够在多个环境中同时学习,从而提高了学习效率。此外,A3C算法还使用了一个全局网络来存储所有actor和critic网络的更新,这有助于稳定学习过程。

### 2.2 A3C算法的优势和局限性

**优势:**

* **并行性:**A3C算法可以并行运行多个actor-critic网络,从而提高学习效率。

* **稳定性:**使用全局网络存储更新可以稳定学习过程,防止actor和critic网络之间的偏差。

* **适用性:**A3C算法可以应用于各种强化学习任务,包括连续和离散动作空间。

**局限性:**

* **通信开销:**A3C算法需要在actor-critic网络和全局网络之间进行大量的通信,这可能会成为瓶颈。

* **超参数调优:**A3C算法需要仔细调优超参数,例如学习率和步长,以获得最佳性能。

* **样本效率:**A3C算法的样本效率可能低于其他强化学习算法,例如DQN。

### 2.3 A3C算法的变体及其特点

A3C算法有多种变体,旨在解决其局限性或提高其性能。一些常见的变体包括:

* **A2C算法:**A2C(Advantage Actor-Critic)算法是A3C算法的简化版本,它不使用全局网络。

* **AC3算法:**AC3(Asynchronous Advantage Actor-Critic with Value Trace)算法使用值跟踪来提高A3C算法的样本效率。

* **IMPALA算法:**IMPALA(Importance Weighted Actor-Learner Architecture)算法使用重要性加权来提高A3C算法的稳定性和样本效率。

**变体特点对比表:**

| 变体 | 特点 |

|---|---|

| A2C | 简化版本,不使用全局网络 |

| AC3 | 使用值跟踪提高样本效率 |

| IMPALA | 使用重要性加权提高稳定性和样本效率 |

# 3.1 A3C算法在游戏中的应用

### 3.1.1 Atari游戏中的应用

A3C算法在Atari游戏中取得了显著的成功。Atari游戏是一类经典的街机游戏,具有高维度的状态空间和稀疏的奖励。

```python

import gym

import numpy as np

import torch

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

from torch.distributions import Categorical

class ActorCritic(nn.Module):

def __init__(self, state_dim, action_dim):

super(ActorCritic, self).__init__()

self.actor = nn.Sequential(

nn.Linear(state_dim, 256),

nn.ReLU(),

nn.Linear(256, action_dim),

nn.Softmax(dim=-1)

)

self.critic = nn.Sequential(

nn.Linear(state_dim, 256),

nn.ReLU(),

nn.Linear(256, 1)

)

def forward(self, state):

action_probs = self.actor(state)

value = self.critic(state)

return action_probs, value

```

**代码逻辑分析:**

* `ActorCritic`类定义了一个Actor-Critic网络,用于Atari游戏中策略的学习。

* `actor`网络是一个多层感知器(MLP),将状态映射到动作概率分布。

* `critic`网络也是一个MLP,将状态映射到价值函数。

* `forward`方法返回动作概率分布和价值函数。

### 3.1.2 Go游戏中的应用

A3C算法

0

0