A3C算法在金融领域的应用:强化学习赋能金融决策,提升投资回报

发布时间: 2024-08-20 07:06:14 阅读量: 42 订阅数: 46

2022年中国工业互联网在供应链中的应用概览:持续赋能.pdf

# 1. A3C算法概述

A3C算法(Actor-Critic with Asynchronous Advantage Actor-Critic)是一种强化学习算法,它将策略梯度方法与值函数方法相结合。在A3C算法中,actor网络负责生成动作,而critic网络负责评估动作的价值。actor和critic网络同时运行,通过异步更新机制来优化策略。

A3C算法具有以下特点:

- **异步更新:**actor和critic网络可以并行运行,从而提高训练效率。

- **策略梯度方法:**actor网络通过最大化动作价值来更新策略。

- **值函数方法:**critic网络通过最小化动作价值与真实价值之间的差异来更新值函数。

# 2. A3C算法在金融领域的应用

### 2.1 强化学习在金融领域的优势

强化学习是一种机器学习范式,它通过与环境交互来学习最优行为。与监督学习和无监督学习不同,强化学习不需要标记数据或明确的指导,而是通过试错和奖励机制来学习。这种方法非常适合金融领域,因为金融市场是一个动态且复杂的环境,其中很难获得标记数据或明确的指导。

强化学习在金融领域的优势包括:

- **适应性:**强化学习算法可以适应不断变化的市场条件,而无需进行显式重新训练。

- **鲁棒性:**强化学习算法对噪声和不确定性具有鲁棒性,这在金融市场中很常见。

- **探索性:**强化学习算法可以探索不同的行动策略,以找到最佳解决方案。

- **可扩展性:**强化学习算法可以扩展到具有大量状态和动作的大型问题。

### 2.2 A3C算法的原理和架构

A3C(异步优势演员-批评家)算法是一种强化学习算法,它特别适用于分布式环境。它由两个主要组件组成:

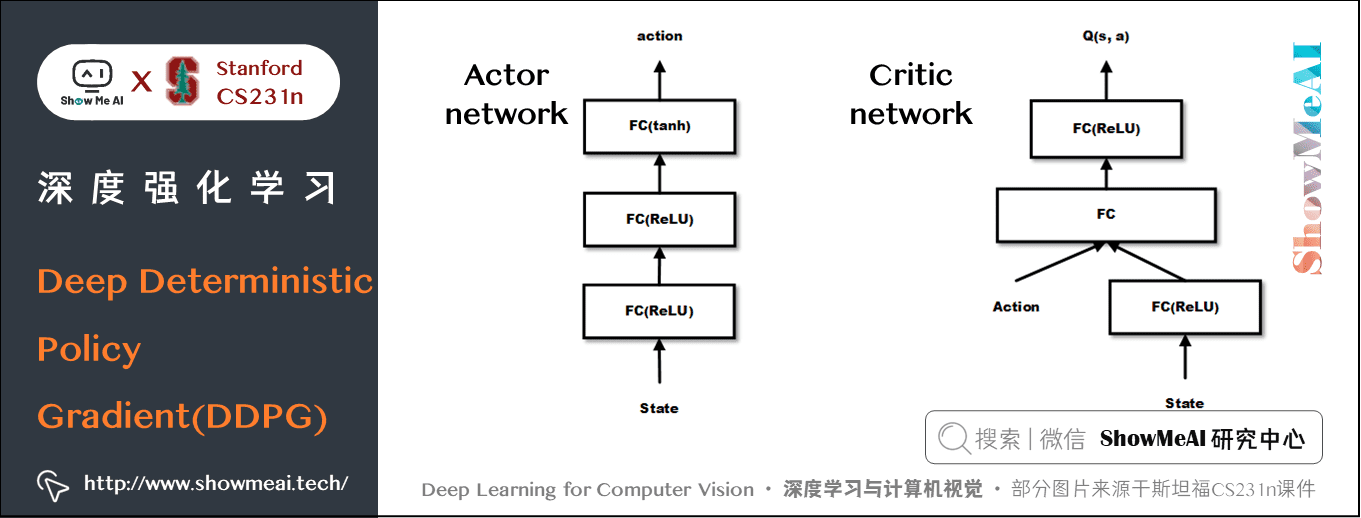

- **演员网络:**演员网络是一个神经网络,它根据给定的状态输出动作。

- **批评家网络:**批评家网络是一个神经网络,它评估演员网络输出动作的价值。

A3C算法通过以下步骤工作:

1. **演员网络**根据当前状态输出动作。

2. **环境**根据动作执行转换并返回奖励。

3. **批评家网络**评估动作的价值。

4. **演员网络**和**批评家网络**使用奖励和价值估计更新其权重。

### 2.3 A3C算法在金融决策中的实践

A3C算法已成功应用于各种金融决策问题,包括:

- **股票交易:**A3C算法可用于学习最佳股票交易策略,以最大化投资回报。

- **风险管理:**A3C算法可用于学习最佳风险管理策略,以最大程度地减少投资组合的风险。

- **投资组合优化:**A3C算法可用于学习最佳投资组合优化策略,以最大化投资组合的回报和风险调整收益。

**代码示例:**

```python

import tensorflow as tf

# 定义演员网络

class ActorNetwork(tf.keras.Model):

def __init__(self, state_size, action_size):

super(ActorNetwork, self).__init__()

self.state_size = state_size

self.action_size = action_size

self.hidden_layer1 = tf.keras.layers.Dense(128, activation='relu')

self.hidden_layer2 = tf.keras.layers.Dense(64, activation='relu')

self.output_layer = tf.keras.layers.Dense(action_size, activation='softmax')

def call(self, state):

x = self.hidden_layer1(state)

x = self.hidden_layer2(x)

return self.output_layer(x)

# 定义批评家网络

class CriticNetwork(tf.keras.Model):

def __init__(self, state_size):

super(CriticNetwork, self).__init__()

self.state_size = state_size

self.hidden_layer1 = tf.keras.layers.Dense(128, activation='relu')

self.hidden_layer2 = tf.keras.layers.Dense(64, activation='relu')

self.output_layer = tf.keras.layers.Dense(1)

def call(self, state):

x = self.hidden_layer1(state)

x = self.hidden_layer2(x)

return self.output_layer(x)

# 训练A3C算法

def train_a3c(actor_network, critic_network, environment):

optimizer = tf.keras.optimizers.Adam(learning_rate=0.001)

for episode in range(1000):

state = environment.reset()

done = False

while not done:

# 根据状态选择动作

action_probs = actor_network(state)

action = np.random.choice(range(action_p

```

0

0