Sklearn自然语言处理实战:文本分析与处理的艺术,掌握自然语言处理技术

发布时间: 2024-06-22 02:08:51 阅读量: 65 订阅数: 45

# 1. 自然语言处理简介**

自然语言处理(NLP)是一门计算机科学领域,它旨在让计算机理解、解释和生成人类语言。NLP 涉及广泛的技术,用于处理文本数据,从文本预处理到文本生成。

NLP 在各种行业中都有着广泛的应用,包括:

* **信息检索:**搜索引擎和文档管理系统使用 NLP 来理解用户查询并检索相关信息。

* **机器翻译:**NLP 系统可以将文本从一种语言翻译成另一种语言。

* **情感分析:**NLP 技术可以分析文本中的情绪和情感,用于市场研究和客户体验管理。

# 2. Sklearn文本分析基础

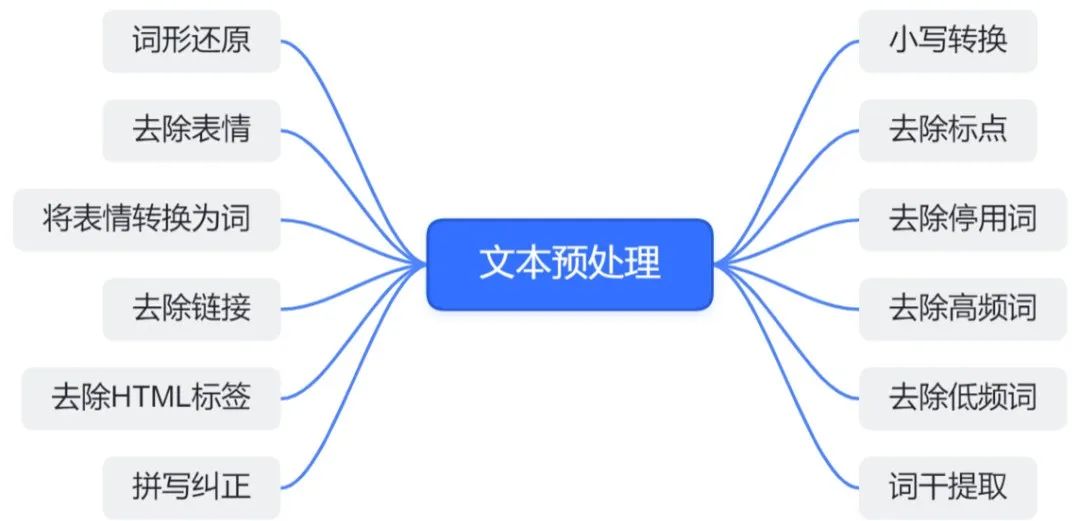

### 2.1 文本预处理

文本预处理是文本分析的第一步,旨在将原始文本转换为机器可读的格式。Sklearn提供了丰富的文本预处理工具,包括分词、去停用词和词干提取。

#### 2.1.1 文本分词

文本分词将文本分解为单个单词或词组。Sklearn的`CountVectorizer`类可以执行此任务,它使用正则表达式或自定义词汇表将文本分割成标记。

```python

from sklearn.feature_extraction.text import CountVectorizer

# 创建CountVectorizer对象

vectorizer = CountVectorizer()

# 分词文本

text = "自然语言处理是一种计算机科学领域"

X = vectorizer.fit_transform([text])

# 获取特征名称

feature_names = vectorizer.get_feature_names_out()

# 打印特征和计数

for feature, count in zip(feature_names, X.toarray()[0]):

print(f"{feature}: {count}")

```

**代码逻辑分析:**

* `CountVectorizer`类使用正则表达式将文本分割成标记。

* `fit_transform`方法将文本转换为稀疏矩阵,其中每个元素表示单词在文本中出现的次数。

* `get_feature_names_out`方法获取特征名称(单词)。

* 循环打印特征名称和计数。

#### 2.1.2 去停用词

停用词是常见且不重要的单词,如“the”、“and”、“of”。去停用词可以减少特征空间的维度,提高模型的效率。Sklearn的`TfidfVectorizer`类提供了去停用词的功能。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 创建TfidfVectorizer对象

vectorizer = TfidfVectorizer(stop_words="english")

# 分词和去停用词

text = "自然语言处理是一种计算机科学领域"

X = vectorizer.fit_transform([text])

# 获取特征名称

feature_names = vectorizer.get_feature_names_out()

# 打印特征和TF-IDF权重

for feature, weight in zip(feature_names, X.toarray()[0]):

print(f"{feature}: {weight}")

```

**代码逻辑分析:**

* `TfidfVectorizer`类使用正则表达式将文本分割成标记并去停用词。

* `fit_transform`方法将文本转换为稀疏矩阵,其中每个元素表示单词的TF-IDF权重。

* `get_feature_names_out`方法获取特征名称(单词)。

* 循环打印特征名称和TF-IDF权重。

#### 2.1.3 词干提取

词干提取将单词归约为其词根或基本形式。这有助于减少同义词和词形的数量,提高模型的泛化能力。Sklearn的`PorterStemmer`类提供了词干提取的功能。

```python

from sklearn.feature_extraction.text import PorterStemmer

# 创建PorterStemmer对象

stemmer = PorterStemmer()

# 词干提取

text = "自然语言处理是一种计算机科学领域"

words = text.split()

stemmed_words = [stemmer.stem(word) for word in words]

# 打印词干提取后的单词

print(stemmed_words)

```

**代码逻辑分析:**

* `PorterStemmer`类将单词归约为其词根。

* 将文本分割成单词。

* 使用`stem`方法提取每个单词的词根。

* 打印词干提取后的单词。

# 3. Sklearn文本分类

### 3.1 分类算法概述

文本分类是自然语言处理中一项基本任务,其目标是将文本文档分配到预定义的类别中。Sklearn提供了多种分类算法,包括:

#### 3.1.1 朴素贝叶斯

朴素贝叶斯是一种基于贝叶斯定理的分类器。它假设特征之间是独立的,这通常在文本分类中不成立。然而,朴素贝叶斯在处理高维稀疏数据时仍然有效,这在文本分类中很常见。

**参数:**

* `alpha`: 平滑参数,用于防止过拟合。

* `fit_prior`: 是否拟合类先验概率。

**代码块:**

```python

from sklearn.naive_baye

```

0

0