【AdaBoost调优实战】:掌握参数调整与模型选择的艺术

发布时间: 2024-11-20 23:50:17 阅读量: 34 订阅数: 35

machine learning adaboost

# 1. AdaBoost算法概述

在机器学习领域,AdaBoost算法是一种强大的分类技术,它属于集成学习方法中的提升策略。提升方法通过组合多个学习器来构建一个强大的集成器,以提高预测性能。AdaBoost,全称为Adaptive Boosting,通过迭代过程增强模型,特别适用于二分类问题。它不断地关注之前分类器未正确分类的样例,以此来调整它们在后续过程中的权重,逐步提升整体模型的分类准确性。本章节将为读者概述AdaBoost算法的基本概念和优势,为更深入的理论和应用探讨打下坚实基础。

# 2. ```

# 第二章:理论基础与AdaBoost原理

## 2.1 提升方法的理论基础

### 2.1.1 弱学习器与强学习器的概念

在机器学习领域,弱学习器与强学习器的定义是理解提升方法和AdaBoost算法的前提。弱学习器(Weak Learner)通常指那些性能略好于随机猜测的分类器,其预测准确率可能只是略微高于50%。在实际应用中,任何可以产生分类决策的模型都可能被视为弱学习器,包括简单的决策树、线性回归模型等。

相比之下,强学习器(Strong Learner)则是一个假设的理想化模型,它能够以很高的准确率对任何数据分布进行分类。强学习器通常难以直接构建,因为这需要对问题具有非常深入的理解。

### 2.1.2 提升算法的演进历史

提升方法(Boosting)是一类通过集成多个弱学习器来构建一个强学习器的算法。提升算法的演进始于1988年,由Yoav Freund和Robert Schapire提出了最初的提升方法,随后发展出了多种变体,其中最著名的就是AdaBoost(Adaptive Boosting)。

自AdaBoost被提出以来,它成为了研究和应用的热点,并产生了许多改进算法,如Gradient Boosting Machine(GBM)和XGBoost等。这些算法不仅在理论研究中取得了突破,也在实际应用中展现了极佳的性能。

## 2.2 AdaBoost算法详解

### 2.2.1 AdaBoost算法的工作原理

AdaBoost算法的核心思想是通过迭代地训练弱学习器来逐步提升模型的性能。具体来说,在每一轮迭代中,AdaBoost会根据上一轮的错误率来调整数据集的权重,错误分类的样本权重增加,正确分类的样本权重减少。

这样,在下一轮迭代时,弱学习器会更加关注那些前一轮中被错误分类的样本。如此循环,直至达到预定的迭代次数或弱学习器的性能不再提升为止。

### 2.2.2 算法的数学模型和权重更新规则

数学上,AdaBoost可以表示为一系列弱学习器的加权组合。对于一系列的弱分类器\(h_t(x)\),每个分类器的权重\(\alpha_t\)是根据其性能来计算的。第\(t\)轮迭代的权重计算公式为:

\[

\alpha_t = \frac{1}{2} \ln \left( \frac{1 - e_t}{e_t} \right)

\]

其中,\(e_t\)是第\(t\)轮弱学习器的错误率。最后,所有弱学习器的加权组合构成AdaBoost模型:

\[

H(x) = \sum_{t=1}^{T} \alpha_t h_t(x)

\]

## 2.3 AdaBoost算法的优化目标

### 2.3.1 损失函数的选取与优化

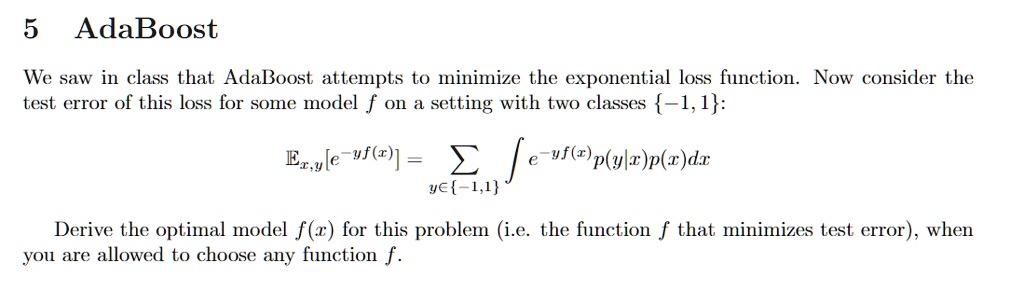

在AdaBoost算法中,损失函数的作用是评价当前模型的预测效果,并指导模型的优化方向。常见的损失函数有指数损失、对数损失等。对于分类问题,指数损失函数因其与模型的预测概率直接相关而被广泛使用。

在AdaBoost算法中,通过对每个弱学习器的错误率进行加权,优化了整体模型的性能。这个过程可以看作是连续地最小化加权指数损失函数。

### 2.3.2 过拟合与欠拟合问题分析

AdaBoost通过集成多个弱学习器的方式,天然具有对抗过拟合的特性,因为它不断地关注那些之前被错误分类的样本。然而,如果迭代次数过多,模型可能会因为过度关注难以分类的样本而开始过拟合。

为了防止过拟合,通常采用早停策略,即在验证集上的性能开始下降时停止迭代。此外,还可以通过限制迭代次数或引入正则化项来控制模型的复杂度,避免欠拟合。

```

在这段文本中,我们详细讨论了AdaBoost算法的理论基础,包括弱学习器与强学习器的定义,以及提升算法的历史发展。我们也深入分析了AdaBoost的工作原理,阐述了其数学模型和权重更新规则。同时,我们还探讨了损失函数在优化AdaBoost模型时的重要性,并对过拟合与欠拟合问题进行了分析。这个章节的内容逐步深入,旨在帮助读者全面理解AdaBoost算法的核心概念和机制。

# 3. AdaBoost算法实战技巧

在机器学习的实践中,理解和应用算法是基础,而掌握其实战技巧则是提高模型性能的关键。AdaBoost算法作为提升方法的经典代表,其在实战中的应用和调优尤为重要。本章节将深入探讨AdaBoost算法在实际应用中的调优技巧,以及如何解决实际问题。

## 3.1 参数调整的艺术

### 3.1.1 学习率的影响与调节

学习率是AdaBoost算法中的一个关键超参数,它控制着每一轮迭代中基分类器错误分类样本的权重更新程度。如果学习率设置得太低,模型可能需要很多轮迭代才能收敛;而如果学习率过高,可能导致模型过拟合,对异常值敏感。

在实际应用中,通常采用交叉验证的方法来选择最优的学习率。交叉验证是一种统计方法,用于评估并选择机器学习模型的参数,它将数据集分成k个大小相似的子集,一个子集作为验证集,其余的作为训练集。

```python

from sklearn.model_selection import cross_val_score

from sklearn.ensemble import AdaBoostClassifier

# 定义基分类器

base_estimator = DecisionTreeClassifier(max_depth=1)

# 创建AdaBoost分类器实例

ada_clf = AdaBoostClassifier(base_estimator=base_estimator, n_estimators=500, learning_rate=0.01)

# 进行交叉验证并输出平均准确度

cross_val_scores = cross_val_score(ada_clf, X_train, y_train, cv=5)

print(f"Average cross-validation score: {cross_val_scores.mean()}")

```

### 3.1.2 基分类器的选择与配置

在AdaBoost算法中,基分类器的选择同样至关重要。理想情况下,基分类器应当具有较低的方差和偏差,并且能够相互补充,以提高整体模型的预测能力。决策树是最常见的基分类器之一,但其他算法,如支持向量机、神经网络等,也可以作为基分类器。

不同类型的基分类器将影响AdaBoost的最终性能。例如,决策树的深度可以调整以控制模型复杂度,防止过拟合。

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import AdaBoostClassifier

# 定义基分类器的深度参数范围

max_depths = range(1, 11)

# 记录每种深度对应的交叉验证分数

cv_scores = []

for depth in max_depths:

base_estimator = DecisionTreeClassifier(max_depth=depth)

ada_clf = AdaBoostClassifier(base_estimator=base_estimator, n_estimators=500, learning_rate=0.01)

scores = cross_val_score(ada_clf, X_train, y_train, cv=5)

cv_scores.append(scores.mean())

# 选

```

0

0