机器学习算法的优化策略:从参数调优到模型选择的终极指南

发布时间: 2024-09-01 10:57:02 阅读量: 281 订阅数: 95

# 1. 机器学习算法优化概述

机器学习算法优化是提高模型性能和泛化能力的关键过程。优化不仅包括算法的选择和参数调整,还涉及数据处理、特征工程、模型评估等多个层面。本章将对优化算法的必要性进行概述,并简要介绍后续章节中将深入探讨的参数调优、模型选择、算法层面优化策略等内容。

## 1.1 优化的必要性

机器学习项目中,模型往往需要处理数据集中的各种噪声和异常值,因此优化工作至关重要。通过优化,可以确保模型在未知数据上的表现尽可能接近在训练集上的表现,提高其预测准确性。

## 1.2 优化的目标

优化的主要目标是提升模型性能,同时避免过拟合和欠拟合的问题。在特定应用场景下,优化可能还需要考虑模型的可解释性、计算效率和资源消耗等因素。

## 1.3 优化的范围

从宏观角度而言,机器学习优化包括数据预处理、特征选择、模型选择、参数调优等多方面。每一个环节都可能影响最终模型的性能和效率。接下来的章节中,我们将逐一分解这些环节,探讨具体的优化策略。

# 2. 参数调优的基础与技巧

## 2.1 参数调优的概念与重要性

### 2.1.1 什么是参数调优

在机器学习中,参数调优是一个关键步骤,它涉及到对模型内部参数的细致调整,以期达到最优的性能表现。模型的参数可以分为两大类:可学习参数和超参数。可学习参数是指那些在训练过程中通过优化算法自动学习得到的参数,例如神经网络中的权重和偏置。而超参数则是指在模型训练之前设置的参数,它们控制着学习的过程,例如学习率、批次大小、迭代次数以及正则化项等。

超参数调优的目的在于找到最适合当前数据集和问题的超参数组合,使得模型在给定的任务上表现出最佳的性能。这通常是一个探索性和试错性的过程,需要在模型的可解释性、训练时间、资源消耗以及最终性能之间进行权衡。

### 2.1.2 参数调优对模型性能的影响

合适的参数设置对于模型性能至关重要。参数设置不当可能导致模型欠拟合或过拟合。欠拟合意味着模型过于简单,无法捕捉数据中的模式,而过拟合则是因为模型太复杂,以至于它对训练数据的噪声和异常值过度敏感。

例如,如果学习率设置得太高,模型可能无法收敛到最小损失,因为每次参数更新都太过激进,导致在最优解附近震荡;反之,如果学习率太低,训练过程将会非常缓慢,且有可能陷入局部最小值。因此,合理的超参数调优能够帮助我们找到一个平衡点,从而提高模型的泛化能力。

## 2.2 常见的参数调优方法

### 2.2.1 网格搜索法

网格搜索(Grid Search)是一种基本的超参数优化方法,它通过枚举指定的参数值来进行穷举搜索。具体而言,网格搜索会遍历超参数空间中的每一个组合,并针对每一个组合训练模型,并通过交叉验证来评估模型性能。

这种方法的优点在于简单直观,能够保证找到全局最优解,但缺点是计算成本高,尤其是当参数空间很大时,网格搜索的计算量呈指数级增长。

### 2.2.2 随机搜索法

随机搜索(Random Search)是一种类似于网格搜索的方法,但是它随机选择参数值而不是系统地遍历每一个组合。随机搜索的优势在于,当搜索空间很大时,它通常能够更快地找到一个良好的参数组合,因为它允许在高维空间中有更多的“跳跃”。

该方法的效率较高,但无法保证找到全局最优解,只能期望找到近似最优解。它特别适用于参数空间非常高维的情况,因为在这种情况下,网格搜索的计算成本可能变得不切实际。

### 2.2.3 贝叶斯优化

贝叶斯优化(Bayesian Optimization)是一种基于概率模型的全局优化算法,它使用贝叶斯推断来构建一个关于目标函数的模型,这个模型可以预测给定超参数组合时的性能指标,并使用这个模型来决定下一次参数搜索的位置。

贝叶斯优化的搜索过程通常更为高效,因为它能够根据已经搜索过的点来智能地指导下一个搜索位置,避免了不必要的计算。这种方法特别适合于那些训练开销很大的模型,因为它能够在更少的尝试次数中找到更优的超参数。

## 2.3 实战:参数调优的代码实现

### 2.3.1 实际案例分析

假设我们要使用随机森林分类器解决一个二分类问题,我们将使用网格搜索和随机搜索两种方法来进行超参数调优。以下是使用Python的`GridSearchCV`和`RandomizedSearchCV`进行超参数优化的示例代码。

```python

from sklearn.datasets import make_classification

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV, RandomizedSearchCV

from sklearn.metrics import accuracy_score

# 生成一个简单的分类数据集

X, y = make_classification(n_samples=1000, n_features=10, n_informative=5, n_redundant=0, random_state=42)

# 初始化模型

rf = RandomForestClassifier(random_state=42)

# 网格搜索参数空间

param_grid = {

'n_estimators': [10, 50, 100],

'max_depth': [None, 10, 20, 30],

'min_samples_split': [2, 5, 10]

}

# 使用网格搜索法

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5, n_jobs=-1, verbose=2)

grid_search.fit(X, y)

best_grid = grid_search.best_estimator_

# 使用随机搜索法

random_search = RandomizedSearchCV(estimator=rf, param_distributions=param_grid, n_iter=10, cv=5, verbose=2, random_state=42, n_jobs=-1)

random_search.fit(X, y)

best_random = random_search.best_estimator_

# 比较两种方法得到的最佳模型的准确度

best_grid_accuracy = accuracy_score(y, best_grid.predict(X))

best_random_accuracy = accuracy_score(y, best_random.predict(X))

print(f'Best Grid Search model accuracy: {best_grid_accuracy}')

print(f'Best Random Search model accuracy: {best_random_accuracy}')

```

在这个例子中,我们首先创建了一个随机森林分类器,然后定义了一个参数空间,包括了三个主要的超参数:`n_estimators`(森林中树的数量)、`max_depth`(树的最大深度)、以及`min_samples_split`(分割内部节点所需的最小样本数)。我们接着使用`GridSearchCV`和`RandomizedSearchCV`进行超参数的优化,并比较了两种方法得到的最佳模型在验证集上的准确度。

### 2.3.2 调优过程中的注意事项

在进行参数调优时,有几个关键的注意事项:

- **交叉验证**:使用交叉验证可以减少评估模型性能时的随机性,确保选出的超参数组合是稳健的。

- **验证集或测试集的使用**:确保超参数优化过程中不使用测试集,避免模型过拟合到测试数据上。

- **计算资源**:参数调优是一个计算密集型的过程,尤其是在使用网格搜索时。合理分配计算资源,考虑使用云计算服务等。

- **并行计算**:使用并行计算可以在多个核或多个机器上同时进行模型的训练和验证,从而缩短调优时间。

- **超参数空间的界定**:合理的超参数空间范围和离散程度对于搜索效率至关重要。太大或太细的空间都会增加计算负担。

- **先验知识的利用**:在进行搜索之前,尽可能利用先验知识或文献推荐来设置超参数的合理初始范围,这可以有效指导搜索过程。

通过上述代码和说明,我们可以看到如何使用网格搜索和随机搜索来进行参数调优。在实际应用中,这些方法需要根据具体问题进行调整,以获得最佳的模型性能。

# 3. 模型选择的标准与方法

## 3.1 模型选择的重要性

### 3.1.1 正确模型选择的影响因素

在机器学习项目的构建过程中,模型的选择是一个关键步骤,它的影响因素众多,且每个因素对最终模型的性能都有直接或间接的作用。以下几个是主要考虑的影响因素:

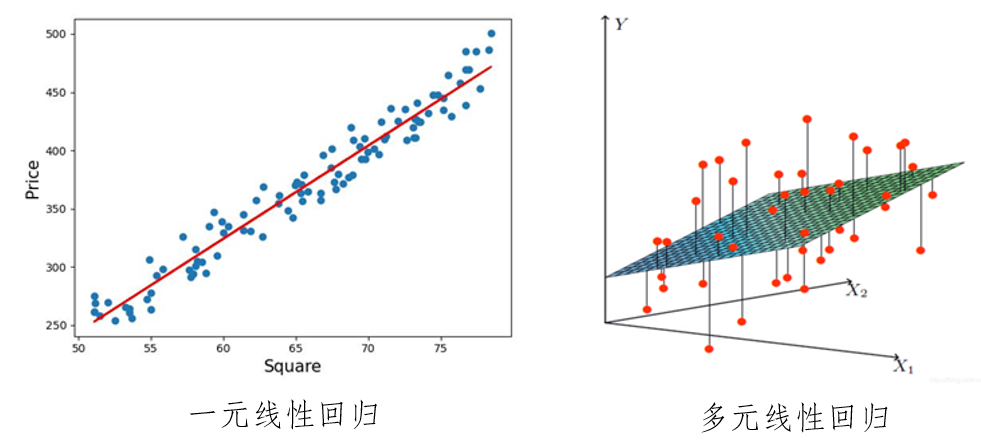

1. **问题类型:**不同的问题需要不同类型的模型。例如,分类问题可能倾向于使用决策树、支持向量机或神经网络,而回归问题则可能更适合线性回归、决策树回归或岭回归等。

2. **数据集大小和特征:**模型的选择也受到可用数据集大小的影响。一般而言,数据量大时,复杂的模型如神经网络可能表现得更好。同时,特征数量的多少也会直接影响模型选择,一些模型可能对高维数据表现得更好。

3. **计算资源:**不同的模型对计算资源的要求也不同。对于资源受限的环境,可能需要选择更为轻量级的模型,如逻辑回归或决策树。

4. **模型的解释性:**在某些行业,例如医疗或金融,模型的解释性可能比性能更重要。在这种情况下,决策树或线性回归可能比神经网络更受青睐。

5. **模型的训练和预测时间:**对于实时系统,模型的预测速度至关重要。简单模型如线性模型在预测时通常很快,而复杂的模型可能需要更长的计算时间。

### 3.1.2 模型选择的常见错误与避免

在机器学习实践中,模型选择是一个复杂且容易出错的过程。一些常见的错误以及如何避免它们:

1. **过度拟合:**选择过于复杂模型可能导致在训练集上表现良好,但在未见数据上表现不佳。为了避免过度拟合,可以采用交叉验证、正则化等技术。

2. **忽略问题的实际需求:**选择模型时不应只看重性能指标,还应考虑实际应用场景的需求。例如,医学诊断中模型的错误代价极高,因此模型需要有高的置信度和准确性。

3. **忽略模型的可维护性:**在选择模型时,应考虑到模型的维护和更新的难易程度。过于复杂的模型可能难以维护。

4. **不充分的模型评估:**选择模型之前,必须用多个不同的指标和方法对模型进行全面评估,包括在独立测试集上的性能测试。

## 3.2 模型选择的策略

### 3.2.1 交叉验证

交叉验证是一种评估模型泛化能力的技术,通过将数据集分成多份(称为折),轮流使用其中一份作为验证集,其余作为训练集,从而得到一个模型性能的较为稳定估计。最常用的是 k 折交叉验证。

```python

from sklearn.mod

```

0

0