【朴素贝叶斯分类器】:与其它分类算法的比较分析与实战应用

发布时间: 2024-09-01 10:37:29 阅读量: 170 订阅数: 104

朴素贝叶斯实战.pptx贝叶斯分类器ppt代码全

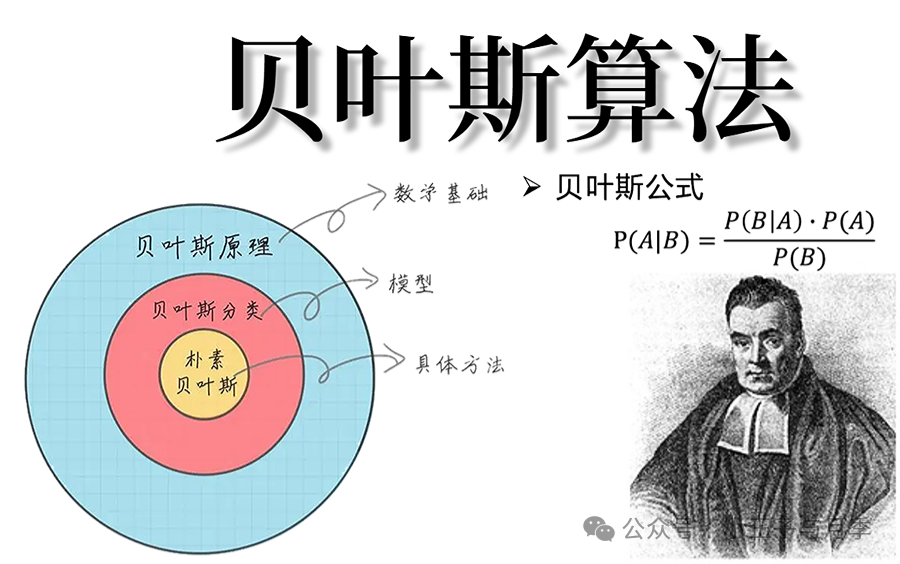

# 1. 朴素贝叶斯分类器简介

## 1.1 机器学习中的分类任务

朴素贝叶斯分类器是机器学习领域中一种简单而又强大的分类算法。它的核心思想是通过统计学中的贝叶斯定理来计算样本属于各个类别的后验概率,并将样本分配到具有最高后验概率的类别中。在众多的分类算法中,朴素贝叶斯因其简洁性和相对较高的准确率而受到广泛的欢迎。

## 1.2 朴素贝叶斯的优势

与复杂的分类器相比,朴素贝叶斯分类器的优势在于它对小规模数据的优越性,且对于缺失数据不太敏感。此外,朴素贝叶斯模型的训练过程简单快速,适合于分类特征数量较多但每个特征的取值种类不多的情况。

## 1.3 朴素贝叶斯的应用场景

朴素贝叶斯分类器在实际应用中非常广泛,尤其是在文本分类、垃圾邮件检测、情感分析和医疗诊断等领域,它可以快速且有效地解决分类问题。例如,在垃圾邮件过滤中,朴素贝叶斯算法能够帮助区分正常邮件与垃圾邮件,提高用户的邮件阅读体验。

# 2. ```

# 第二章:理论基础与算法原理

## 2.1 贝叶斯定理的数学概念

### 2.1.1 条件概率和联合概率基础

条件概率是指在已知一些条件的情况下,某个事件发生的概率。例如,我们想计算在已知邮件是垃圾邮件的情况下,邮件被错误地标记为正常邮件的概率。数学上,我们可以将条件概率表示为 P(A|B),其中A是垃圾邮件被错误标记为正常邮件的事件,B是邮件是垃圾邮件的事件。

联合概率则是指两个或两个以上事件同时发生的概率。例如,我们要计算一封邮件同时是垃圾邮件并且被标记为垃圾邮件的概率,可以表示为 P(A ∩ B)。在贝叶斯定理中,联合概率的概念也非常重要,因为我们需要用它来计算后验概率。

### 2.1.2 贝叶斯定理的推导和解释

贝叶斯定理的数学表达形式为:

\[ P(A|B) = \frac{P(B|A) \cdot P(A)}{P(B)} \]

这个公式的意义在于,它让我们能够在已知B发生的条件下计算A发生的概率。这一点在机器学习中特别有用,因为在实际应用中我们往往知道一些结果,并且想要推断这些结果发生的可能原因。

**公式解释:**

- \( P(A|B) \):在已知B发生的条件下,A发生的概率,也被称作后验概率。

- \( P(B|A) \):在已知A发生的条件下,B发生的概率。

- \( P(A) \):在任何条件下,A发生的概率,也就是先验概率。

- \( P(B) \):在任何条件下,B发生的概率。

贝叶斯定理的直观解释是,后验概率是通过先验概率和条件概率的结合来得出的。在没有更多信息的情况下,我们通常无法确定某个事件发生的准确概率,但如果我们有一定背景信息或先验知识,结合新信息,我们可以更准确地估计事件发生的概率。

## 2.2 朴素贝叶斯分类器的工作原理

### 2.2.1 特征独立性的假设

朴素贝叶斯分类器的一个关键假设是所有特征在数据集中都是相互独立的,即给定分类标签的条件下,各个特征之间没有任何依赖关系。这个假设被称为“朴素性”假设,尽管在现实世界中,特征之间往往存在一定的相关性,但在很多情况下,这个简化的模型依然能够提供很好的分类性能。

### 2.2.2 后验概率的计算方法

朴素贝叶斯分类器的核心是计算给定特征集合下,各个分类标签的后验概率,并选择具有最高后验概率的分类作为最终的预测结果。在计算后验概率时,我们通常使用如下公式:

\[ P(Y|X) = \frac{P(X|Y) \cdot P(Y)}{P(X)} \]

其中,Y是分类标签,X是特征集合,P(Y)是先验概率,表示在没有任何条件的情况下,Y发生的概率。P(X|Y)是给定分类标签Y的条件下,特征集合X出现的条件概率。P(X)是特征集合X出现的概率,通常在计算中作为归一化因子使用,以便使所有后验概率的和为1。

## 2.3 朴素贝叶斯分类器的数学模型

### 2.3.1 概率分布的选择和应用

朴素贝叶斯分类器的一个重要组成部分是选择合适的概率分布来表示特征的条件概率。不同的分布适用于不同的数据类型:

- 对于离散型特征,通常使用多项式分布或伯努利分布。

- 对于连续型特征,则可能采用高斯分布。

选择哪种分布取决于数据的性质和分布情况。例如,如果特征是布尔值(是或否),则伯努利分布可能是合适的选择。如果特征可以取多个离散值,那么多项式分布可能更合适。

### 2.3.2 分类决策规则的制定

在朴素贝叶斯中,分类决策规则非常直接。对于一个新的数据实例,我们计算它属于每个分类的后验概率,并选择具有最高后验概率的分类。数学表达如下:

\[ \text{Classify}(X) = \arg\max_{Y} P(Y|X) = \arg\max_{Y} \left( \frac{P(X|Y) \cdot P(Y)}{P(X)} \right) \]

由于分母对于所有的Y都是一样的,因此我们实际上只需要最大化分子:

\[ \arg\max_{Y} P(X|Y) \cdot P(Y) \]

这个规则告诉我们,对于给定的数据实例,只需要找到一个分类Y,使得在该分类下数据实例X的条件概率乘以该分类的先验概率最大。这通常通过计算得出,无需实际对P(X)进行归一化处理。

通过以上的分析,我们可以看到朴素贝叶斯分类器是如何通过一些基本的概率原理来实现分类决策的,尽管它的“朴素性”假设在实际应用中可能受到挑战,但它提供了简洁且实用的算法框架。

```

# 3. 与其它分类算法的比较分析

在机器学习领域,不同的分类算法因其各自的特点和适用场景而被广泛应用。朴素贝叶斯分类器作为一种基于概率的算法,在与其它算法的对比中可以展现出其独特的性能和适用范围。本章节将深入比较朴素贝叶斯与决策树、支持向量机、随机森林等几种主流分类算法,并从算法结构、训练数据要求、泛化能力等多个维度进行分析。

### 3.1 朴素贝叶斯与决策树的对比

决策树是通过学习数据的特征和特征之间的关系来构建的模型,它的每一步决策都是基于对特征值的询问。决策树易于理解和解释,而且在分类问题中表现良好。但是,决策树容易过拟合,并且对数据集中的微小变化非常敏感。

#### 3.1.1 算法结构和决策边界

朴素贝叶斯和决策树的算法结构有很大的不同。朴素贝叶斯基于贝叶斯定理和特征独立性假设,而决策树通常使用信息增益或基尼不纯度等准则来划分数据。朴素贝叶斯的决策边界是线性的,即使在特征空间复杂的情况下也保持线性。相比之下,决策树可以构建非线性的决策边界,允许它在特征空间中划分出更复杂的形状。

```mermaid

graph TD;

A[数据集] --> B[朴素贝叶斯];

A --> C[决策树];

B --> D[线性决策边界];

C --> E[非线性决策边界];

```

#### 3.1.2 训练数据的要求和处理

决策树对训练数据的要求较高,因为它可能会捕捉到数据中的噪声和异常值,导致过拟合。在决策树模型训练之前,数据通常需要进行详细的预处理,包括特征缩放、缺失值处理等。而朴素贝叶斯模型对训练数据的容错性更好,尤其是在面对缺失值时,它可以通过忽略缺失特征来简化计算。

### 3.2 朴素贝叶斯与支持向量机的比较

支持向量机(SVM)是另一种强大的分类方法,它通过找到最优边界来最大化不同类别的间隔。SVM在高维数据中表现尤为出色,但其计算复杂度较高,特别是对于大规模数据集。

#### 3.2.1 核技巧的应用差异

朴素贝叶斯使用概率分布来构建模型,而SVM通常采用核技巧来处理非线性可分的问题。核技巧允许SVM在原始特征空间的更高维空间中寻找最优边界。相比之下,朴素贝叶斯不使用核技巧,且通常假设特征之间的独立性,这在许多情况下是不现实的。

#### 3.2.2 泛化能力与过拟合问题

朴素贝叶斯通常具有良好的泛化能力,部分原因在于其对模型复杂度的限制。尽管基于特征独立性的假设可能限制了模型的表达能力,但也减少了过拟合的风险。SVM通过选择合适的核函数和正则化参数可以在一定程度上避免过拟合,但仍然需要仔细的参数选择和调优。

### 3.3 朴素贝叶斯与随机森林的差异

随机森林是一种集成学习算法,它通过构建多个决策树并进行投票来提高预测准确性。随机森林可以处理高维数据,并且对于噪声和异常值有一定的鲁棒性。

#### 3.3.1 集成学习的优势分析

随机森林在构建模型时使用了多个决策树,因此它可以从多个角度考虑特征和数据。这种集成方法使得随机森林在某些情况下优于单一的朴素贝叶斯模型。然而,由于随机森林的模型更为复杂,它需要更多的计算资源和时间。

```mermaid

graph TD;

A[数据集] --> B[朴素贝叶斯];

A

```

0

0