机器学习算法实战:12个基础到高级算法的深度对比分析

发布时间: 2024-09-01 10:04:12 阅读量: 437 订阅数: 104

# 1. 机器学习算法入门

## 简介:机器学习的定义和重要性

在当今数据驱动的世界中,机器学习已经成为IT和相关行业中的一个重要领域。机器学习涉及构建算法和统计模型,这些模型可以让计算机系统从数据中学习并作出预测或决策而无需明确编程。对于经验丰富的专业人士来说,了解机器学习的基础不仅是拓宽知识面的需要,也是提升自身竞争力的关键。

## 机器学习的分类

机器学习可以分为监督学习、无监督学习和强化学习三类。监督学习涉及已标记的数据,算法在这些数据上进行训练以预测未来的输出。无监督学习处理未标记的数据,目的是发现数据中的隐藏结构或模式。强化学习侧重于如何在环境中采取行动以最大化某种累积奖励。

## 基础工具和语言

机器学习领域广泛使用Python、R、Java等编程语言。Python因其简洁性和丰富的数据科学库(如scikit-learn、TensorFlow、PyTorch)成为入门首选。同时,学习基础的统计学和线性代数知识也是理解机器学习算法的必备条件。

总结第一章,机器学习是IT行业的一个重要分支,其核心在于构建算法模型从数据中学习和作出决策。掌握基础知识和选择合适的工具是深入学习机器学习的第一步。

# 2. 线性回归和逻辑回归

## 2.1 线性回归基础与应用

### 2.1.1 线性回归的数学原理

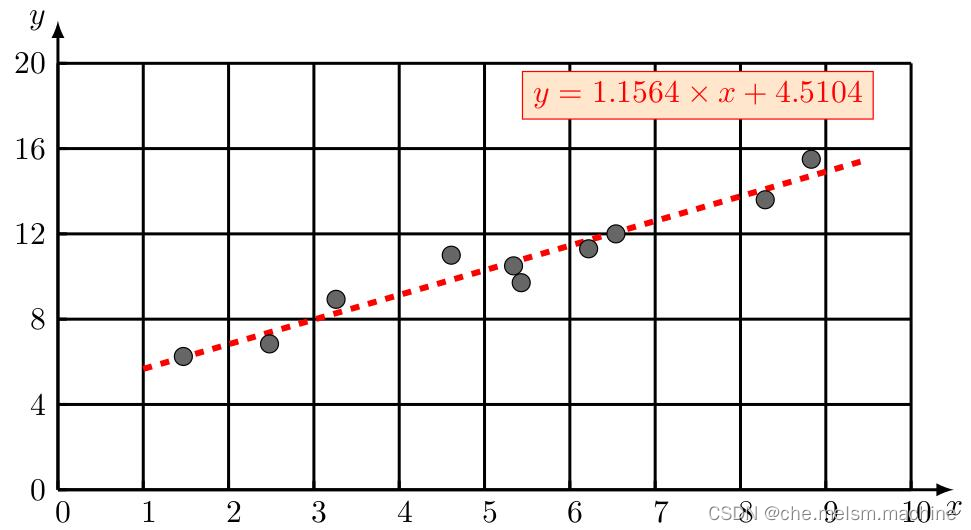

线性回归是统计学中一种研究两个或多个变量间线性关系的方法。在机器学习中,线性回归通常用来预测连续的数值输出。其基本模型可以表示为:

\[ Y = \beta_0 + \beta_1X_1 + \beta_2X_2 + \dots + \beta_nX_n + \epsilon \]

其中,\(Y\) 是因变量,\(X_1, X_2, \dots, X_n\) 是自变量,\(\beta_0, \beta_1, \dots, \beta_n\) 是模型的参数,而 \(\epsilon\) 是误差项。

### 2.1.2 实践案例:房价预测

假设我们有一组房屋数据,想要根据房屋的大小(平方英尺)来预测房屋价格。我们可以使用线性回归模型进行预测。

#### 数据准备

首先,我们需要收集数据,并将其划分为训练集和测试集。在Python中,我们通常使用`scikit-learn`库来进行数据划分:

```python

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

import pandas as pd

# 假设df是包含房屋大小和价格的DataFrame

X = df[['HouseSize']]

y = df['Price']

# 划分数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

#### 模型构建与训练

接下来,我们构建线性回归模型,并使用训练集数据进行训练:

```python

# 创建线性回归实例

model = LinearRegression()

# 训练模型

model.fit(X_train, y_train)

```

#### 模型评估

模型训练完成后,我们使用测试集对模型进行评估:

```python

from sklearn.metrics import mean_squared_error

# 预测测试集结果

y_pred = model.predict(X_test)

# 计算均方误差

mse = mean_squared_error(y_test, y_pred)

print(f'Mean Squared Error: {mse}')

```

通过计算均方误差(MSE),我们可以量化模型预测的准确度。MSE越小,说明模型的预测性能越好。

## 2.2 逻辑回归的理论与实践

### 2.2.1 逻辑回归的模型推导

逻辑回归是处理二分类问题的一种广义线性模型。它使用逻辑函数(如sigmoid函数)将线性回归模型的输出映射到0和1之间,实现概率预测。

逻辑函数的表达式为:

\[ \sigma(z) = \frac{1}{1 + e^{-z}} \]

其中,\(z\) 是线性回归的输出。如果\(\sigma(z)\) 大于等于0.5,则我们预测类别为1,否则为0。

### 2.2.2 分类问题的应用示例

假设我们需要根据患者的各种生理指标来预测心脏病的存在与否。这是一个典型的二分类问题。

#### 数据预处理

我们使用`pandas`和`scikit-learn`进行数据预处理:

```python

# 假设df是包含生理指标和心脏病标签的DataFrame

X = df.drop('HeartDisease', axis=1)

y = df['HeartDisease']

# 由于是分类问题,使用逻辑回归时,不需要对标签进行编码

# 训练集和测试集划分

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

#### 模型训练与评估

我们继续使用逻辑回归模型,并评估其性能:

```python

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 创建逻辑回归模型实例

logreg = LogisticRegression()

# 训练模型

logreg.fit(X_train, y_train)

# 预测测试集结果

y_pred = logreg.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print(f'Accuracy: {accuracy}')

```

逻辑回归模型的准确率告诉我们模型在测试集上的分类性能。通过进一步的性能评估,如混淆矩阵、ROC曲线等,可以更全面地了解模型的预测能力。

### 结语

在本章中,我们从理论和实践两个方面探讨了线性回归和逻辑回归。通过实际案例,我们学习了如何使用这些基础模型来解决实际问题。接下来,我们将继续探讨决策树、随机森林等更高级的机器学习算法。

# 3. 决策树和随机森林

## 3.1 决策树的原理与构建

### 3.1.1 信息增益和决策树的剪枝

决策树是一种常见的分类与回归方法,它的基本思想是从根节点开始,对特征进行测试,根据测试结果将数据划分到子节点中,在子节点上递归地进行这个划分过程,直到达到叶子节点。在决策树的构建过程中,信息增益是一个非常重要的概念,它是衡量特征对数据集分类能力的一个指标。

信息增益是基于信息熵的概念,信息熵是度量数据集纯度的一种方式,纯度越高,信息熵越小。信息增益则是指原始数据集的熵与划分后的数据集熵的差值。在构建决策树时,我们通常会选择信息增益最大的特征来进行分割。

然而,决策树如果过度拟合训练数据,那么它在未知数据上的泛化能力就会大大降低。为了避免过拟合,我们需要进行决策树的剪枝。剪枝主要有预剪枝和后剪枝两种方式。预剪枝是在树的构建过程中,提前停止树的生长。后剪枝是先生成一个完整的决策树,然后将一些子树删除,用叶节点替代,从而简化树结构。

为了减少过拟合的风险,常用的剪枝技术包括:

- 成本复杂度剪枝(Cost Complexity Pruning)

- 最小误差剪枝(Reduced Error Pruning)

- 错误复杂度剪枝(Error Complexity Pruning)

### 3.1.2 构建决策树解决实际问题

构建决策树解决实际问题通常包括以下步骤:

1. 数据准备:收集并预处理数据集,包括处理缺失值、异常值、数据归一化等。

2. 特征选择:选择对目标变量有预测能力的特征,使用如信息增益等方法。

3. 构建树模型:递归地选择最优特征进行分割,生成决策树模型。

4. 剪枝处理:应用剪枝技术优化决策树,提升模型泛化能力。

5. 模型评估:使用验证集或交叉验证等方法评估决策树性能。

6. 模型部署:将训练好的模型应用于实际问题中,并进行监控和维护。

在实际操作中,我们可以使用一些成熟的机器学习库来辅助我们构建决策树模型,如scikit-learn。以下是一个简单的使用scikit-learn构建决策树的Python代码示例:

```python

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 构建决策树模型

clf = DecisionTreeClassifier(criterion='gini', random_state=42)

clf.fit(X_train, y_train)

# 预测

y_pred = clf.predict(X_test)

# 评估模型

print("Accuracy: ", accuracy_score(y_test, y_pred))

```

在这段代码中,我们首先导入了必要的库,并加载了鸢尾花(Iris)数据集。接着,我们将数据集划分为训练集和测试集。之后,我们创建了一个决策树分类器,并用训练集数据训练它。最后,我们使用测试集数据对模型进行了评估,并打印出准确率。

通过使用scikit-learn等库,我们可以更加方便地实现决策树模型的构建和评估。然而,对于更复杂的数据集或者特定的业务问题,可能需要我们自定义决策树模型,包括调整算法参数,选择不同的特征选择方法等。

## 3.2 随机森林的高级特性

### 3.2.1 集成学习与随机森林的原理

随机森林是一种集成学习方法,它基于多个决策树的集合来进行预测。集成学习的核心思想是通过构建并结合多个学习器来解决同一个问题,从而获得比单个学习器更佳的预测性能。随机森林通过引入随机性来构造不同的决策树,并最终将这些树的预测结果进行集成。

在随机森林中,每棵树都是在原始数据集的一个子集上训练得到的,这个子集是通过有放回抽样(bootstrap sampling)获得的。此外,随机森林在每次分割时,只会考虑所有特征的一个随机子集,而不是使用所有特征。这种随机性有助于减少模型的方差,提高泛化能力。

### 3.2.2 随机森林的优化与调参

随机森林的性能受到多种因素的影响,包括树的数量、树的深度、每棵树分割时考虑的特征数量等。为了得到最佳的模型性能,我们通常需要对随机森林进行优化和调参。

调整随机森林参数的常用策略包括:

- **网格搜索(Grid Search)**:通过遍历预定义的参数值组合来找到最佳参数。

- **随机搜索(Random Search)**:在参数空间中随机选择参数组合,有时比网格搜索更高效。

- **贝叶斯优化(Bayesian Optimization)**:利用贝叶斯理论来指导参数搜索,通常能找到更好的参数组合。

在scikit-learn中,我们可以使用`GridSearchCV`或`RandomizedSearchCV`来进行网格搜索和随机搜索。以下是一个使用网格搜索进行随机森林参数优化的代码示例:

```python

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV

# 设置随机森林分类器

rf = RandomForestClassifier(random_state=42)

# 定义参数网格

param_grid = {

'n_estimators': [50, 100, 200], # 树的数量

'max_depth': [None, 10, 20, 30], # 树的深度

'min_samples_split': [2, 5, 10] # 内部节点再划分所需的最小样本数

}

# 使用网格搜索

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5, verbose=2)

grid_search.fit(X_train, y_train)

# 输出最佳参数

print("Best parameters: ", grid_search.best_params_)

```

在这段代码中,我们首先创建了一个随机森林分类器,并定义了一个参数网格。接着,我们使用`GridSearchCV`来对随机森林的参数进行优化,并指定了交叉验证的方式。最后,我们打印出了最佳参数组合。

在实际工作中,我们还需要关注模型的性能评估指标,如准确率、召回率、F1分数等。在参数调优的过程中,应该以验证集或交叉验证的结果作为依据,从而选择出最合适的模型参数。

通过以上的分析和实际代码操作,我们可以看到决策树和随机森林在处理分类和回归问题中的实际应用,以及如何优化模型以获得更好的性能。在下一章节中,我们将继续探索支持向量机与核技巧在机器学习中的应用。

# 4. 支持向量机与核技巧

## 4.1 支持向量机的原理与分类

### 4.1.1 SVM的核心概念与数学模型

支持向量机(Support Vector Machine, SVM)是一种监督学习的方法,常用于分类和回归。SVM的主要思想是找到一个超平面,它能将不同类别的样本尽可能准确地分割开来。在最简单的情况下,可以想象一个二维空间的直线或一个三维空间的平面。对于更高维的空间,这个超平面是一个抽象的概念,通常无法直观表示。

在数学上,SVM寻求的是一个最优超平面,其定义为能使得距离它最近的几个样本点(支持向量)到该超平面的距离最大。这些支持向量就决定了最终的超平面的位置和方向。

对于非线性可分的数据,SVM通过引入松弛变量(slack variables)和惩罚项(penalty term)来寻找一个尽可能满足分类要求的超平面。松弛变量允许一些数据点在错误的一侧,但对这些错误分类的点会进行惩罚。

### 4.1.2 实际案例:文本分类问题

在文本分类问题中,SVM可以用来区分不同类别的文本数据,比如垃圾邮件识别。文本数据首先需要转换成数值型特征,通常采用词袋模型或TF-IDF(Term Frequency-Inverse Document Frequency)方法。处理后的数据是一个向量空间模型。

当文本数据被转换成特征向量后,可以使用SVM进行分类。以垃圾邮件识别为例,模型训练时需要标记好的邮件数据,这些数据构成了训练集。在训练过程中,SVM会寻找一个能够最大化分类边界的同时正确分类邮件的超平面。

在实际应用中,SVM具有很强的泛化能力,即便是在高维空间中也如此。一旦模型训练完成,就可以用它来预测新邮件是否为垃圾邮件。

## 4.2 核技巧与非线性问题的处理

### 4.2.1 核函数的选择与应用

核技巧是SVM中用于处理非线性问题的一个关键技术。其核心思想是将原始的输入空间映射到一个更高维的特征空间中,在这个新空间中原本线性不可分的数据可能会变得线性可分。

核函数的核心功能是计算两个向量在高维空间中的内积,而不需要显式地进行向量空间的变换。这意味着使用核函数可以避免在高维空间进行复杂的计算。常见的核函数包括:

- 线性核(Linear Kernel)

- 多项式核(Polynomial Kernel)

- 径向基函数核(Radial Basis Function, RBF或Gaussian Kernel)

- Sigmoid核

核函数的选择对于SVM的性能至关重要,不同的核函数适用于不同类型的数据分布。RBF核是最常用的核函数,对于解决大多数非线性问题都有不错的效果。

### 4.2.2 SVM在复杂问题中的应用实例

在一些复杂的问题中,比如图像识别或生物信息学,数据往往是高维和非线性的。这些领域中的问题通常需要更多的计算资源和更复杂的数据预处理。SVM通过核技巧可以很好地处理这些问题。

以图像识别为例,核SVM可以用于人脸检测或手写数字识别。这些应用中,图像被转换成高维的特征向量,而核函数则用于处理高维特征空间的非线性分类问题。核函数的选择对于结果有显著影响,RBF核在处理这些数据时表现出色。

下面提供一个简单的例子,使用核函数支持向量机对数据进行分类。假设我们有如下数据集:

```python

import numpy as np

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.svm import SVC

from sklearn.metrics import classification_report

# 加载数据集,这里以鸢尾花数据集为例

iris = datasets.load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 数据标准化

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

# 使用SVM,核函数为RBF核进行分类

clf = SVC(kernel='rbf', gamma=1)

clf.fit(X_train, y_train)

# 预测结果

y_pred = clf.predict(X_test)

# 输出分类结果

print(classification_report(y_test, y_pred, target_names=iris.target_names))

```

代码中首先导入了必要的库,然后加载了鸢尾花数据集。使用`train_test_split`将数据集分成训练集和测试集,并通过`StandardScaler`进行了标准化处理。之后创建了一个`SVC`实例,并使用了RBF核函数进行训练和预测。最后输出了分类报告,评估了模型的性能。

通过上述示例,可以看出使用SVM解决非线性分类问题的流程和关键点。核函数的选择、数据预处理以及模型参数的调整是实现优秀分类性能的关键步骤。

# 5. 神经网络与深度学习

在数据科学和机器学习的领域中,神经网络与深度学习是极其重要的一部分。它们能够从大量复杂的数据中学习并作出准确的预测或决策。这一章节将深入探讨神经网络的基本结构和学习算法,以及深度学习框架下高级神经网络的应用实例。

## 5.1 神经网络的基本结构和学习算法

### 5.1.1 感知机、多层感知机和反向传播算法

感知机是神经网络中最基础的组成部分,其可以看作一个简单的二分类器。它接收多个输入,并通过一个激活函数产生一个输出。在上世纪50年代,感知机的发明标志着人工神经网络研究的开始。

#### 多层感知机(MLP)

随着研究的深入,多层感知机(MLP)被提出来解决非线性问题。MLP通常由输入层、若干隐藏层和输出层构成。每一层由多个神经元组成,相邻层之间全连接。与单层感知机不同,多层感知机可以捕捉数据中更复杂的模式。

##### 反向传播算法(Backpropagation)

神经网络的训练依赖于反向传播算法,它通过计算损失函数的梯度来更新网络中的权重和偏置。算法的核心是链式法则,用以计算每个参数对损失的影响。随着算法的执行,网络参数会不断调整,直到模型性能达到一个满意的水平。

```python

# 示例:使用Python实现一个简单的反向传播算法

import numpy as np

def sigmoid(x):

"""Sigmoid激活函数"""

return 1 / (1 + np.exp(-x))

def sigmoid_derivative(x):

"""Sigmoid激活函数的导数"""

return sigmoid(x) * (1 - sigmoid(x))

# 输入数据

inputs = np.array([[0,0], [0,1], [1,0], [1,1]])

# 随机初始化权重

weights = np.random.uniform(size=(2,1))

# 设置学习率

learning_rate = 0.1

# 训练过程

for epoch in range(10000):

inputs_dot_weights = np.dot(inputs, weights)

outputs = sigmoid(inputs_dot_weights)

# 计算误差

error = (1 - outputs) * sigmoid_derivative(outputs)

# 反向传播:梯度下降

adjustments = np.dot(inputs.T, error * learning_rate)

# 更新权重

weights -= adjustments

print("经过训练后的权重:", weights)

```

上述代码演示了反向传播算法如何在Python中实现,并用于训练一个简单的神经网络。通过迭代地调整权重,最小化预测与真实值之间的误差。

### 5.1.2 实践中的网络初始化和激活函数

在实践中,神经网络的初始化和选择合适的激活函数对于模型的训练至关重要。不恰当的初始化可能导致训练过程中的梯度消失或梯度爆炸问题,而正确的激活函数则能帮助网络学习更复杂的表示。

#### 网络初始化

通常,权重初始化有多种方法,如零初始化、随机初始化以及使用特定分布的初始化等。例如,He初始化和Xavier初始化是两种在训练深度网络时常用的初始化策略,它们能够缓解梯度消失和梯度爆炸的问题。

```python

# 使用He初始化作为权重初始化的示例

def he_init(shape):

"""He初始化方法"""

return np.random.randn(shape[0], shape[1]) * np.sqrt(2. / shape[0])

# 例如初始化一个5x3的权重矩阵

weights = he_init((5, 3))

print("初始化的权重矩阵:\n", weights)

```

#### 激活函数

激活函数的选择对于网络性能也有极大的影响。常见的激活函数包括ReLU、tanh和Sigmoid等。ReLU由于其简洁和有效性,特别是在深层网络中,已经成为最广泛使用的激活函数。

```python

# ReLU激活函数的示例

def relu(x):

"""ReLU激活函数"""

return np.maximum(0, x)

# 示例使用ReLU激活函数

x = np.array([-1.0, 2.0, 3.0])

activated = relu(x)

print("ReLU激活后的结果:", activated)

```

## 5.2 深度学习框架下的高级神经网络

### 5.2.1 卷积神经网络(CNN)和循环神经网络(RNN)

在深度学习领域,CNN和RNN是处理不同类型数据的核心网络结构。CNN擅长处理具有网格状拓扑结构的数据,比如图像;而RNN则适用于处理序列数据,如语音或文本。

#### 卷积神经网络(CNN)

CNN通过卷积层提取图像的局部特征,并通过池化层降维和减少参数数量。它通常包括多个卷积层、激活层、池化层以及全连接层。CNN在图像识别、分类、检测等任务上展现了卓越的性能。

```python

# 使用Keras构建一个简单的CNN模型作为示例

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential()

model.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

# 打印模型架构

model.summary()

```

上述代码展示了如何使用Keras构建一个简单的卷积神经网络。每一层的参数和操作都被详细定义,用于处理输入数据。

#### 循环神经网络(RNN)

RNN通过其循环机制,将信息从一个步骤传递到下一个步骤,这让RNN能够处理时间序列数据。在自然语言处理领域,RNN以及其变种如LSTM和GRU,是处理序列数据的首选模型。

```python

# 使用Keras构建一个简单的LSTM模型作为示例

from keras.models import Sequential

from keras.layers import LSTM, Dense

model = Sequential()

model.add(LSTM(64, input_shape=(None, 50), return_sequences=True))

model.add(LSTM(32, return_sequences=False))

model.add(Dense(1, activation='sigmoid'))

# 打印模型架构

model.summary()

```

上述代码演示了如何构建一个具有LSTM层的循环神经网络模型。这种网络非常适合处理语音、文本等序列数据。

### 5.2.2 应用实例:图像识别与自然语言处理

CNN和RNN在图像识别与自然语言处理两个领域的应用实例凸显了深度学习技术的强大能力。在图像识别中,CNN可以识别并分类不同对象,而RNN在文本生成、机器翻译以及语音识别中扮演着关键角色。

#### 图像识别

CNN已经在多个图像识别任务中达到了人类水平的性能。以卷积层和池化层为核心构建的深度卷积神经网络,能够学习图像中的层次化特征,从而进行准确的图像分类。

#### 自然语言处理

在自然语言处理领域,RNN及其变种由于能够处理序列数据,成为了许多任务的首选模型。例如,在机器翻译任务中,LSTM能够捕捉长距离依赖关系,生成语法和语义上都更接近人类的翻译结果。

```python

# 示例:使用LSTM进行文本生成的伪代码

from keras.models import Sequential

from keras.layers import LSTM, Dense

from keras.preprocessing.text import Tokenizer

# 假设我们已经有一个训练好的模型和一些预处理好的文本数据

model = ... # 加载或创建模型

tokenizer = ... # 加载或创建Tokenizer

# 生成文本的函数

def generate_text(seed_text, next_words, model, tokenizer, max_sequence_len):

for _ in range(next_words):

token_list = tokenizer.texts_to_sequences([seed_text])[0]

token_list = pad_sequences([token_list], maxlen=max_sequence_len, padding='pre')

predicted = model.predict_classes(token_list, verbose=0)

output_word = ""

for word, index in tokenizer.word_index.items():

if index == predicted:

output_word = word

break

seed_text += " " + output_word

return seed_text

# 使用函数生成文本

print(generate_text("深度学习技术", 5, model, tokenizer, max_sequence_len))

```

上述伪代码展示了如何使用LSTM模型生成文本。在实际应用中,模型的训练需要大量的文本数据,并且模型的结构可能需要进行多次调整和优化。

# 6. 聚类分析与降维技术

聚类分析和降维技术是数据挖掘和机器学习领域中非常重要的无监督学习方法。聚类能够发现数据中的内在结构,将相似的对象聚集在一起。降维技术则用于简化数据集,同时尽可能保留重要信息。

## 6.1 聚类算法的基本概念和应用

### 6.1.1 K-means算法和层次聚类

K-means算法是一种常见的聚类方法,它的目标是最小化簇内方差,即使得每个簇中的点尽可能地靠近。算法开始时随机选择K个中心点,然后将数据点分配到最近的中心点所代表的簇中。之后重新计算每个簇的中心点,并重复以上过程,直到中心点不再变化。

层次聚类则通过构建一个层次的簇树来组织数据。它可以是自底向上的聚合方法(凝聚型),也可以是自顶向下的分裂方法(分裂型)。层次聚类的一个优点是不需要事先指定簇的数量。

### 6.1.2 聚类算法在市场细分中的应用

聚类分析在市场细分中具有广泛的应用。例如,零售商可以使用聚类算法将顾客分为不同的群体,基于购买历史、收入水平、地理位置等特征。然后,可以针对性地向每个群体提供定制化的营销策略和产品。

## 6.2 降维技术的原理与方法

### 6.2.1 主成分分析(PCA)和t-SNE

主成分分析(PCA)是一种线性降维技术,通过正交变换将数据从原坐标系转换到新的坐标系,使之成为一组线性无关的表示,最常用的是通过特征值分解实现。其目的是将多变量数据转换到几个主要成分上,这些成分可以解释大部分数据的变异性。

t-SNE(t-distributed Stochastic Neighbor Embedding)是一种非线性降维方法,特别适用于高维数据的可视化。它将高维数据点映射到二维或三维空间中,使得相似的数据点在低维空间中也相互靠近,而不相似的数据点则相互远离。

### 6.2.2 降维技术在数据可视化中的应用

降维技术极大地促进了数据可视化的发展。在实际应用中,通过PCA和t-SNE等方法可以将复杂的数据结构直观地展示在二维或三维空间中,帮助人们理解数据的基本结构和模式。例如,在生物学中,基因表达数据经常通过PCA来分析不同样本间的差异,或使用t-SNE来查看细胞类型的分布。在社交媒体分析中,t-SNE可用于可视化社交媒体用户的兴趣偏好等。

在实现PCA时,可以使用Python中的`sklearn.decomposition`模块,而t-SNE可以通过`sklearn.manifold`模块实现。下面是一个简单的示例,展示如何使用t-SNE对二维数据进行降维和可视化:

```python

import matplotlib.pyplot as plt

from sklearn import datasets

from sklearn.manifold import TSNE

# 加载iris数据集

iris = datasets.load_iris()

X = iris.data

y = iris.target

# 使用t-SNE对数据降维

tsne = TSNE(n_components=2, random_state=0)

X_tsne = tsne.fit_transform(X)

# 绘制降维后的数据

plt.scatter(X_tsne[:, 0], X_tsne[:, 1], c=y, cmap='viridis', edgecolor='k')

plt.colorbar()

plt.show()

```

以上代码加载了iris数据集,使用t-SNE将数据集从原始维度降维到二维,并绘制出散点图。通过颜色区分,我们可以直观地看到不同类别数据点的分布情况。

0

0