【支持向量机(SVM)VS 决策树】:优缺点深度剖析与实战选择指南

发布时间: 2024-09-01 10:13:57 阅读量: 296 订阅数: 128

# 1. 支持向量机(SVM)与决策树基础概览

在机器学习领域,支持向量机(SVM)和决策树是两种极为重要的监督学习模型。SVM擅长处理非线性问题并提供结构风险最小化原则,而决策树则以其易解释性和直观的决策过程受到青睐。本章我们将对这两种模型的基础知识进行概览,包括它们的定义、基本原理以及在数据挖掘和机器学习中的常见用途。

## 1.1 SVM和决策树的定义

**支持向量机(SVM)**是一种二分类模型,它的基本模型定义为特征空间上间隔最大的线性分类器,其学习策略就是间隔最大化。对于非线性问题,SVM通过使用核技巧将样本映射到高维空间,从而实现非线性分类。

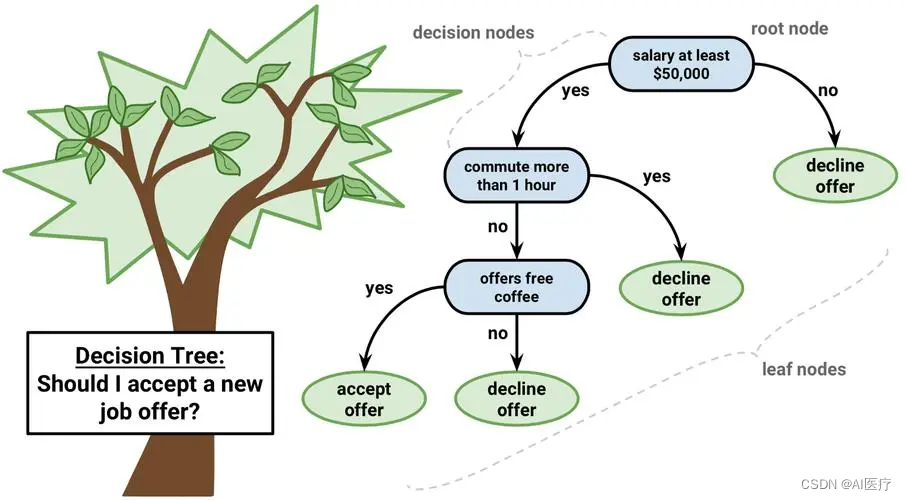

**决策树**则是一种树形结构,其中每个内部节点表示一个属性上的判断,每个分支代表一个判断结果的输出,而每个叶节点代表一种分类结果。通过构建决策树可以对样本进行分类或回归。

## 1.2 SVM与决策树在数据挖掘中的角色

在数据挖掘的实际应用中,SVM经常被用于文本分类、生物信息学以及复杂系统的分类问题。它对于高维数据表现良好,并且可以通过核函数的选择来处理非线性关系。

相比之下,决策树在处理具有大量属性的数据集时具有优势,且能够提供直观的分类规则。在信贷评分、医疗诊断等领域,决策树模型可以帮助专家系统做出决策,因为它们的规则容易被理解。

本章内容提供了一个对SVM和决策树基础知识的初步了解。在接下来的章节中,我们将深入探讨SVM和决策树的理论和实践应用,以及如何在面对实际问题时选择合适的模型。

# 2. 支持向量机(SVM)的理论与实践

## 2.1 SVM的核心理论

### 2.1.1 SVM的工作原理

支持向量机(SVM)是一种监督学习方法,它在分类和回归分析中表现优异。SVM的核心思想是找到一个决策边界(超平面),这个超平面能够最好地区分不同类别的数据点。在特征空间中,这个决策边界会根据训练数据集中数据点的位置,最大化不同类别之间的边界(margin)。

为了理解SVM的工作原理,首先需要介绍一些基本概念:

- **超平面**:在n维特征空间中,一个超平面可以看作是一个n-1维的子空间,它用于分割特征空间,并根据数据点的特征值分配类别。

- **支持向量**:位于边界边缘上的数据点被称为支持向量。它们是决定超平面位置的关键数据点,因为超平面的调整依赖于这些点。

- **边界(Margin)**:支持向量到超平面的最短距离称为边界。SVM的目标是最大化这个边界,因为一个更大的边界意味着更好的泛化能力。

根据优化问题的性质,SVM分为两类:

- **线性可分SVM**:当数据是线性可分的,存在一个超平面可以完美地将不同类别的数据分开。

- **非线性SVM**:当数据不是线性可分的,我们使用所谓的核技巧将数据映射到更高维的空间,在这个新空间中,数据可能是线性可分的。

在处理非线性问题时,SVM通过引入核函数来实现将原始特征映射到更高维的空间。核函数允许我们在高维空间中进行计算,而不必直接计算高维空间的坐标,这被称为核技巧。

接下来,我们将通过数学公式和逻辑详细阐述SVM的工作原理。

```python

# 示例代码块展示如何使用Python和scikit-learn库创建一个简单的线性SVM模型

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.svm import SVC

# 加载数据集

iris = datasets.load_iris()

X = iris.data[:, :2] # 仅使用两个特征进行简化

y = iris.target

# 分割数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 特征标准化

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

# 创建SVM模型

svm_model = SVC(kernel='linear', C=1.0)

# 训练模型

svm_model.fit(X_train, y_train)

# 预测测试集

predictions = svm_model.predict(X_test)

```

**代码逻辑分析及参数说明:**

- `SVC(kernel='linear', C=1.0)` 创建了一个使用线性核函数的支持向量机分类器,参数`C`是正则化项,用于控制错误分类的程度。较小的值倾向于选择更复杂的模型,较大的值倾向于限制错误分类。

### 2.1.2 核函数的概念及选择

核函数是SVM中非常核心的概念,它允许算法在高维空间中有效地执行运算。核函数避免了直接在高维空间中进行复杂度较高的计算。核函数的核心作用是将低维空间中的数据点映射到高维空间,使得原本非线性可分的数据在新的空间中可以被线性分开。

核函数的选择基于数据本身的特性。如果数据集在原始空间中是线性可分的,那么使用线性核函数就足够了。但是,对于大多数实际应用问题,数据往往是非线性的,这时就需要选择合适的非线性核函数,常见的有:

- **多项式核(Polynomial Kernel)**:适合于具有相似度量关系的数据。

- **径向基函数核(Radial Basis Function Kernel,RBF)**:也就是高斯核,最常用的核函数之一,适用于不确定数据的分布状况。

- **sigmoid核**:模拟神经网络的激活函数。

在实际应用中,选择合适的核函数需要依据数据特性,包括特征的数量、数据分布等。通常首先尝试RBF核,因为它在没有先验知识的情况下表现良好,但如果数据的特征数量非常大,可以尝试线性核函数。

```python

from sklearn.svm import SVC

# 使用RBF核创建SVM模型

svm_rbf_model = SVC(kernel='rbf', gamma=0.7, C=1.0)

# 使用多项式核创建SVM模型

svm_poly_model = SVC(kernel='poly', degree=3, coef0=1, C=1.0)

# 使用sigmoid核创建SVM模型

svm_

```

0

0