CNN模型调优秘技:超参数调整与模型选择的终极指南

发布时间: 2024-11-20 15:48:02 阅读量: 58 订阅数: 21

如何选择图像识别模型的架构:深入分析与实践指南

# 1. CNN模型调优的理论基础

## 1.1 模型调优的重要性

深度学习模型尤其是卷积神经网络(CNN)在图像和视频分析、语音识别等领域表现出色。然而,要达到预期的性能,模型调优必不可少。调优能够提高模型准确率、加快训练速度,并防止过拟合。

## 1.2 模型调优的基本步骤

CNN模型调优通常涉及以下步骤:数据预处理、网络架构选择、超参数调整、损失函数选择以及评估与测试。这些步骤相互依赖,合理的调整能极大提升模型表现。

## 1.3 模型泛化与过拟合

模型泛化指的是在未知数据上的表现能力,而过拟合是指模型在训练数据上表现良好,但在新数据上表现不佳。模型调优的目的是实现最佳的泛化能力,避免过拟合现象。

在模型泛化与过拟合的讨论中,我们会分析为什么模型会过拟合,例如网络太复杂或训练数据不够多样化,然后探讨如何通过调优手段解决这个问题。

# 2. 超参数调整的核心技术

### 2.1 权重初始化与正则化

#### 2.1.1 权重初始化方法

权重初始化是深度学习模型训练前的重要步骤,它对模型的收敛速度和最终性能有着显著的影响。权重初始化方法的选择应考虑到网络的深度、激活函数的类型以及输入数据的分布。

**常见的权重初始化方法包括:**

1. **零初始化(Zero Initialization)**:简单地将所有权重初始化为0。这会导致梯度消失问题,因为对称权重会使得网络的每一层都得到相同的更新。

2. **随机初始化(Random Initialization)**:使用小的随机数或高斯分布初始化权重。这可以打破对称性,有助于梯度流动。

3. **Xavier初始化(Glorot Initialization)**:根据前一层的神经元数量来调整权重的方差,旨在保持激活函数的输入方差不变。

4. **He初始化(He Initialization)**:是针对ReLU激活函数的Xavier初始化变种,考虑到ReLU非负输出的特点,对权重的方差进行了调整。

**代码示例:**

```python

import tensorflow as tf

# 定义一个2层的简单神经网络

def create_model(weights_initializer):

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu', input_shape=(784,), kernel_initializer=weights_initializer),

tf.keras.layers.Dense(10, activation='softmax')

])

return model

# 使用Xavier初始化

model_with_xavier = create_model(tf.keras.initializers.glorot_uniform())

```

**参数说明:**

- `kernel_initializer`:用于权重矩阵的初始化方法,`glorot_uniform`代表Xavier初始化方法。

**逻辑分析:**

选择合适的权重初始化方法能够加速模型的收敛,并防止梯度消失或爆炸问题。Xavier和He初始化特别针对深度网络设计,对于激活函数的选择也有较好的兼容性。

#### 2.1.2 正则化策略

正则化是防止模型过拟合的重要技术手段之一。在权重初始化之后,正则化策略会进一步影响模型的泛化能力。

**常用的正则化方法包括:**

1. **L1正则化(Lasso)**:添加权重绝对值之和作为损失函数的一部分。

2. **L2正则化(Ridge)**:添加权重平方之和作为损失函数的一部分。

3. **丢弃法(Dropout)**:在训练过程中随机“丢弃”一部分神经元,强制模型学习更加鲁棒的特征。

**代码示例:**

```python

from tensorflow.keras.layers import Dropout

from tensorflow.keras import regularizers

# 定义带有正则化的模型

def create_regularized_model(reg_type, reg_value):

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu', kernel_regularizer=regularizers.l1_l2(l1=reg_value, l2=reg_value) if reg_type=='l1_l2' else regularizers.l2(reg_value)),

Dropout(0.5),

tf.keras.layers.Dense(10, activation='softmax')

])

return model

# 使用L2正则化

model_with_l2 = create_regularized_model('l2', 0.01)

```

**参数说明:**

- `kernel_regularizer`:权重正则化器,可以是L1、L2或它们的组合。

- `Dropout`:正则化层,参数`0.5`表示在训练过程中有50%的概率将输入单元设为0。

**逻辑分析:**

正则化方法通过在损失函数中添加额外项来约束模型的复杂度,从而防止过拟合。L1和L2正则化直接作用于权重,而Dropout通过在训练时随机移除神经元来工作。在实际应用中,可以根据模型的需要和过拟合的程度灵活选择和调整正则化策略。

### 2.2 学习率的选择与调整

#### 2.2.1 学习率的基本概念

学习率是深度学习模型训练中非常关键的超参数之一。它决定了在梯度下降优化算法中更新权重的步长。一个合适的学习率能够加速模型的收敛速度,而不合适的学习率可能会导致训练过程缓慢、震荡甚至发散。

**学习率的选择原则:**

1. **足够小**:以确保梯度下降的稳定性。

2. **足够大**:以避免训练过程中陷入局部最小值或过慢的收敛速度。

**代码示例:**

```python

# 定义学习率衰减的回调函数

lr_decay = tf.keras.callbacks.LearningRateScheduler(lambda epoch: 1e-3 * 0.95 ** epoch)

```

**参数说明:**

- `LearningRateScheduler`:定义一个学习率调度器,根据训练的轮数动态调整学习率。

**逻辑分析:**

在实践中,通常需要根据模型和数据集的特性进行多次实验来确定最佳学习率。在初始阶段,可以使用较大的学习率以快速探索参数空间,随着训练的进行逐步降低学习率以精细化参数调整。

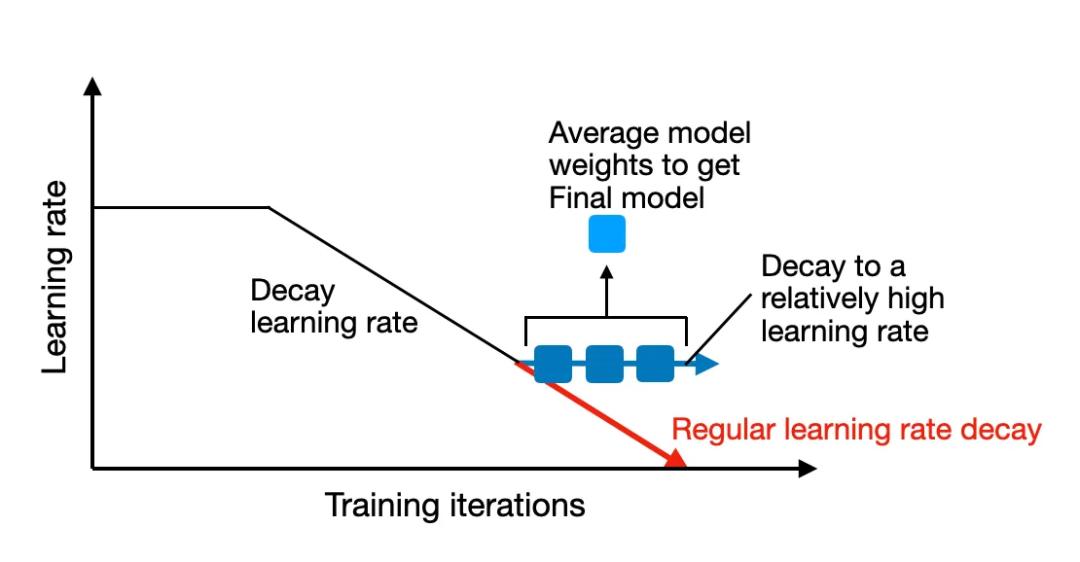

#### 2.2.2 动态学习率调整方法

动态调整学习率是提高模型训练效率和性能的有效手段。学习率的调整策略多种多样,如学习率衰减、周期性调整、根据验证集表现自适应调整等。

**常用的学习率调整方法包括:**

1. **步长衰减(Step Decay)**:每经过一定数量的训练轮次,学习率按照固定比例减少。

2. **指数衰减(Exponential Decay)**:学习率按照指数函数降低。

3. **余弦退火(Cosine Annealing)**:学习率在训练过程中以余弦函数的形式周期性变化。

**代码示例:**

```python

# 使用指数衰减策略调整学习率

lr_schedule = tf.keras.optimizers.schedules.ExponentialDecay(

initial_learning_rate=0.01,

decay_steps=10000,

decay_rate=0.9,

staircase=True

)

optimizer = tf.keras.optimizers.Adam(learning_rate=lr_schedule)

```

**参数说明:**

- `initial_learning_rate`:初始学习率。

- `decay_steps`:在多少训练步之后进行学习率衰减。

- `decay_rate`:每次衰减后学习率乘以的衰减系数。

- `staircase`:是否按照阶梯函数形式进行衰减。

**逻辑分析:**

动态调整学习率使得模型在训练初期快速学习,在后期可以更加细致地调整权重。它是一种高效的超参数优化策略,能够帮助模型更好地收敛并避免陷入局部最小值。

### 2.3 优化器的选择与对比

0

0