CNN模型瘦身术:权重量化、剪枝与知识蒸馏的高效策略

发布时间: 2024-11-20 16:02:54 阅读量: 50 订阅数: 21

YOLOv8模型优化:量化与剪枝的实战指南

# 1. 深度学习模型优化概述

在深度学习领域,随着模型变得日益复杂,训练和部署这些模型所需的成本越来越高。优化深度学习模型,特别是对于资源受限的环境,比如移动设备和边缘计算,已经成为了研究的热点。本章节将概述深度学习模型优化的重要性、目的以及常用的优化策略。

深度学习模型优化的目标是提升模型的运行效率,同时尽可能地保持模型的性能。这通常涉及到减少模型的计算资源需求、减少内存消耗以及缩短推理时间。优化可以分为两个主要方向:模型压缩和模型加速。

模型压缩旨在减少模型的大小,从而减少存储需求,加快模型的加载和传输时间。权重量化、模型剪枝、参数共享等技术都是压缩模型的常用方法。而模型加速则侧重于提升计算效率,这通常涉及到算法优化、并行计算和硬件加速等策略。

在后续章节中,我们将详细探讨这些优化技术,并通过实例分析它们的实施方法和效果评估。这将为我们提供一个全面的视角,以便于在实际应用中选择和组合不同的优化技术,达到最佳的优化效果。

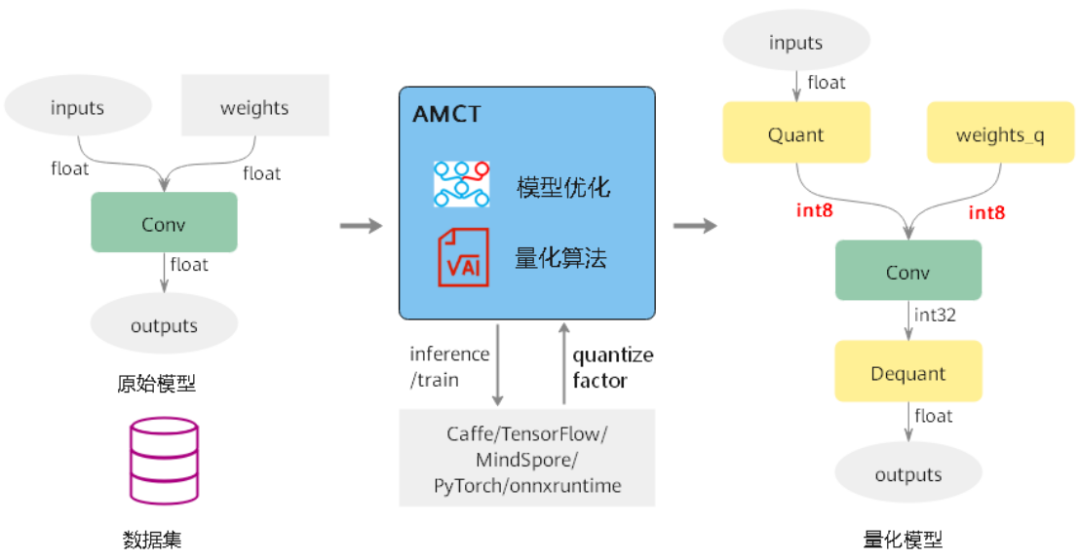

# 2. CNN模型的权重量化技术

## 2.1 权重量化的基本原理

### 2.1.1 量化类型和影响因素

量化是深度学习模型优化中的一项重要技术,它通过减少模型权重和激活值的表示精度,来减小模型的存储占用和加速推理速度。在权重量化中,主要存在两类量化方式:离线量化和训练后量化(PTQ, Post-Training Quantization)。

- **离线量化**:在训练模型之前就确定了量化方案,所有权重和激活值在模型训练前就已经被量化了。这种方法需要对整个数据集进行一次遍历,收集统计信息来决定量化参数。但是,它会增加训练前的预处理工作量,并且可能需要重新调整超参数。

- **训练后量化**:在模型训练完成后进行量化。这种方法简单易行,而且不需要修改训练过程。但是它可能会牺牲一些模型的精度,因为量化可能会导致模型无法恢复到原始的精度水平。

量化的影响因素包括:

- **量化级别**:通常量化级别取决于位宽,常见的有16位、8位和更低的位宽,比如4位。随着位宽的降低,量化带来的精度损失可能会增加。

- **量化的动态范围**:在确定如何将浮点数映射到固定位宽的整数时,量化动态范围是一个重要参数。动态范围的选择影响了量化精度和模型性能。

- **量化感知训练**:某些情况下,可以在训练过程中引入量化误差,这样训练出的模型会更适应量化后的精度损失,从而获得更好的量化性能。

### 2.1.2 训练期间与训练后的量化

**训练期间量化**:训练期间量化(QAT, Quantization-Aware Training)是另一种结合量化的训练方法,它在模型训练期间模拟量化过程,让模型适应量化带来的精度损失。QAT通常会引入fake quantization操作,即在训练时模拟量化效果,但不实际改变数值,从而让模型在训练时就学会应对量化误差。

**训练后量化**:训练后量化则是在模型已经训练完成之后,根据模型权重和激活值的统计特性来确定量化参数。这种做法不需要对训练过程做任何改变,实施起来较为简单。

## 2.2 权重量化的实施步骤

### 2.2.1 数据预处理和校准

在实施权重量化之前,数据预处理和校准是必须要进行的步骤。数据预处理通常包括数据归一化和增强等操作,以确保模型训练数据的质量。在量化过程中,校准是一个关键步骤,主要目的是确定量化参数。比如,在8位量化中,需要确定每层权重的最小值和最大值,然后将其映射到8位整数表示的范围内。

### 2.2.2 量化模型的训练和转换

在量化参数确定之后,就需要将浮点数的模型权重和激活值转换为整数。这通常涉及到缩放和截断的操作,把浮点值范围映射到整数表示。量化转换可以是简单的缩放加截断操作,但更复杂的方法会考虑如何最小化量化误差。

转换后的模型需要在量化后的环境中进行校验和调优,以确保模型性能满足要求。在一些情况下,通过引入量化感知训练,模型可以在训练阶段就适应量化带来的精度损失。

## 2.3 权重量化的效果评估

### 2.3.1 量化对性能的影响

量化可以带来显著的性能提升。例如,在8位量化情况下,模型的存储需求将减少到原来的1/4,同时,如果硬件支持量化运算,还可以获得更快的推理速度。量化对于GPU和专用的神经网络加速器来说,可以显著提高能效比,这对于移动和边缘设备特别有用。

### 2.3.2 量化对模型准确性的影响

尽管量化可以显著减少模型大小和提高运行速度,但同时也可能对模型的准确性产生负面影响。由于量化是通过截断小数部分或四舍五入到最近的量化级别来实现的,因此会带来一定的量化误差。在某些情况下,这些误差会累积,导致模型性能下降。因此,在量化后,通常需要对模型进行微调或选择适当的量化方案来最小化这种损失。

代码块示例:

```python

import tensorflow as tf

from tensorflow.keras.models import load_model

from tensorflow.keras.layers import Input

# 加载预训练模型

model = load_model('model.h5')

# 量化模型

converter = tf.lite.TFLiteConverter.from_keras_model(model)

converter.optimizations = [tf.lite.Optimize.DEFAULT]

converter.target_spec.supported_types = [tf.float16]

tflite_quant_model = converter.convert()

# 将量化后的模型保存

with open('model_quant.tflite', 'wb') as f:

f.write(tflite_quant_model)

```

逻辑分析及参数说明:

在上述代码中,我们使用了TensorFlow Lite转换器将Keras模型量化为TFLite模型。通过设置`optimizations`参数为`[tf.lite.Optimize.DEFAULT]`,我们启用了默认的优化流程,其中就包含了权重量化操作。`supported_types`参数设置为`[tf.float16]`指定了量化过程中使用16位浮点数进行计算,这可以减少量化误差。最终,量化模型被转换成TFLite格式并保存到磁盘上。

通过量化,我们能够减小模型尺寸、提升计算速度,并且若硬件支持,还能减少能耗,使模型更适用于移动和边缘设备。不过,量化操作可能会影响模型的准确性,因此量化后的模型需要经过充分的验证和微调。

# 3. CNN模型剪枝技术的实践应用

## 3.1 剪枝技术的理论基础

### 3.1.1 剪枝的动机和目标

在深度学习模型尤其是卷积神经网络(CNN)中,模型大小和计算复杂度往往限制了其在资源受限环境中的应用,如移动和边缘设备。模型剪枝技术应运而生,其核心动机是减少网络中的冗余参数和计算量,以达到压缩模型、提升推理速度和降低能耗的目标。

剪枝技术致力于在不显著降低模型性能的前提下,剔除掉对最终输出影响最小的网络参数或结构部分。通过剪枝,可以实现更加轻量级的模

0

0