自动驾驶中的CNN:构建感知系统与应对挑战的策略

发布时间: 2024-11-20 16:57:22 阅读量: 8 订阅数: 15

# 1. 自动驾驶技术概述

自动驾驶技术代表了未来交通系统的发展方向,它依赖于先进的计算系统,通过传感器和摄像头捕捉外部环境信息,使用复杂的算法进行数据解析和决策,从而实现车辆的自主驾驶。近年来,随着人工智能技术的不断进步,特别是深度学习的突破,自动驾驶技术在感知、决策和控制层面均取得显著的进展。本章将介绍自动驾驶技术的基本概念、核心组成部分以及技术发展现状,为后续章节中关于卷积神经网络(CNN)及其在自动驾驶感知系统中应用的深入分析打下基础。

# 2. 卷积神经网络(CNN)基础

### 2.1 CNN的理论框架

#### 2.1.1 神经网络的层级结构和作用

卷积神经网络(CNN)是一种深度学习模型,专为处理具有网格结构的数据而设计,如图像和视频等。CNN的主要层级结构包括输入层、卷积层、池化层、全连接层,以及输出层。

**输入层**负责接收原始数据,即图像的像素矩阵。图像数据通常以宽x高x颜色通道的形式呈现。

```plaintext

输入层 -> [宽 x 高 x 颜色通道]

```

**卷积层**通过一系列卷积操作来提取数据的局部特征。卷积操作通过应用一个可学习的滤波器(或称卷积核)在输入图像上滑动,提取图像的特征。卷积层是CNN的核心,负责特征的抽取工作。

```plaintext

卷积层 -> [特征图Feature Map]

```

**池化层**(或下采样层)的目的是减少特征图的空间维度,同时保留重要信息。常见的池化操作包括最大池化(Max Pooling)和平均池化(Average Pooling)。

```plaintext

池化层 -> [减少空间维度]

```

**全连接层**负责将学习到的特征映射到样本标记空间,是分类和回归任务的基础。

```plaintext

全连接层 -> [分类或回归]

```

**输出层**通常是一个softmax层,在分类任务中输出每个类别的概率分布。

```plaintext

输出层 -> [类别概率]

```

层级结构的设计让CNN可以逐层抽象和学习数据的复杂表示,从而在图像识别、分类等任务中达到人类水平甚至超越。

#### 2.1.2 卷积层、池化层的原理与作用

卷积层和池化层在CNN中起到了至关重要的作用。它们分别负责特征的提取和抽象,是CNN识别能力的核心部分。

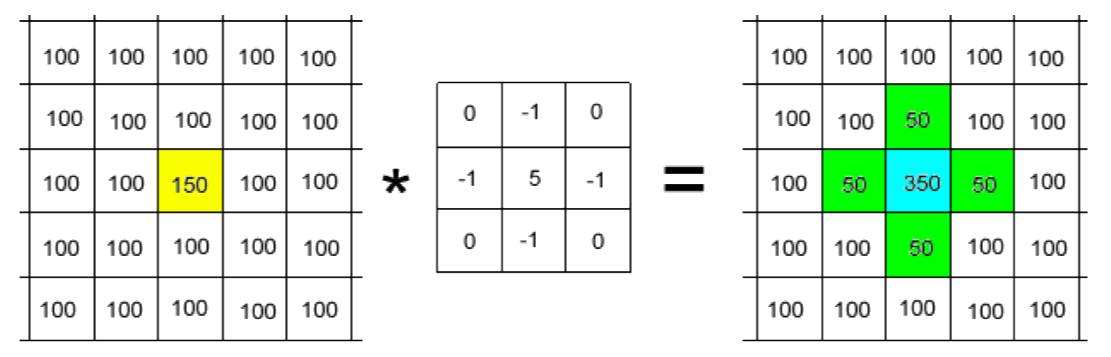

**卷积层的工作原理:** 卷积层通过卷积操作从输入数据中提取特征。一个卷积操作涉及多个可学习的滤波器或卷积核。每个滤波器在输入数据上滑动,执行元素相乘后累加的操作,从而生成一个特征图(Feature Map)。这一过程可以捕捉到输入数据中的局部特征,如边缘、角点等。

```python

# 示例代码块:单个卷积操作

filters = tf.Variable(tf.random.normal([3,3,1,16])) # 3x3滤波器, 16个

conv_layer = tf.nn.conv2d(input_image, filters, strides=[1, 1, 1, 1], padding='SAME')

```

**池化层的作用:** 池化层通过减少特征图的空间维度来简化计算并控制过拟合。它在特征提取过程中起到了降维和特征选择的作用。其中,最大池化是取局部区域的最大值,而平均池化则取平均值。这有利于保留图像的显著特征,同时减少计算量和模型参数。

```python

# 示例代码块:最大池化操作

max_pool = tf.nn.max_pool(input_image, ksize=[1, 2, 2, 1], strides=[1, 2, 2, 1], padding='SAME')

```

卷积层和池化层相互配合,使得CNN能够逐层提取越来越抽象和复杂的特征,这是CNN能够成功应用于图像识别等任务的根本原因。

### 2.2 CNN的关键技术

#### 2.2.1 权重和偏差的初始化方法

权重和偏差是卷积神经网络中用于执行线性转换的参数。它们的初始化方法对于神经网络的训练效率和最终性能至关重要。

**权重初始化的重要性:** 合适的初始化方法可以确保梯度在反向传播过程中不会过小或过大,避免了梯度消失或爆炸的问题。此外,它也有助于模型的快速收敛。

**常见的权重初始化方法:**

- **Xavier(Glorot)初始化:** 适用于使用sigmoid或tanh激活函数的网络。其思想是保持输入和输出的方差一致,从而使得信号在每一层传播时保持相似的尺度。

- **He初始化:** 特别适用于ReLU激活函数。其原理与Xavier相似,但考虑到ReLU在正区间的梯度为1,因此权重的初始方差是Xavier的两倍。

```python

# 示例代码块:权重初始化

he_initializer = tf.contrib.layers.variance_scaling_initializer()

weights = he_initializer([filter_height, filter_width, input_depth, output_depth])

```

选择合适的权重初始化方法能够提高CNN的训练效率和性能,是深度学习实践中的一个关键步骤。

#### 2.2.2 激活函数的选择与作用

激活函数为神经网络引入了非线性因素,使得模型能够学习和表示复杂的函数映射。

**激活函数的作用:**

1. **引入非线性:** 神经网络的每一层都可以看作是一个复合函数,如果激活函数是线性的,那么无论多少层的叠加,最终模型都等同于单层线性模型。

2. **帮助模型学习复杂的特征:** 在深层网络中,非线性激活函数允许网络捕捉复杂的模式和关系。

**常见的激活函数包括:**

- **Sigmoid:** 将输入压缩到0和1之间。曾广泛使用,但因为存在梯度消失问题,现代网络较少使用。

- **Tanh:** 类似sigmoid,但是输出值在-1到1之间。同样存在梯度消失问题。

- **ReLU:** 输出输入的正数部分,零以下则输出零。因其计算简单且缓解了梯度消失问题,被广泛应用于现代CNN中。

- **Leaky ReLU:** ReLU的一个变体,即使输入为负值,也不会输出零,而是输出一个很小的负值,有助于缓解ReLU的“死区”问题。

```python

# 示例代码块:ReLU激活函数应用

output = tf.nn.relu(input_tensor)

```

选择适当的激活函数对于模型训练的稳定性与效率至关重要,是优化CNN性能时的重要考虑因素。

#### 2.2.3 损失函数与优化算法

损失函数用于衡量神经网络输出与真实标签之间的差异,它是优化过程中指引模型调整参数的“指南针”。优化算法则负责更新网络的权重和偏差,以最小化损失函数。

**损失函数的选择:**

- **均方误差(MSE):** 常用于回归问题,衡量预测值与真实值之间的差异。

- **交叉熵损失(Cross-Entropy Loss):** 常用于分类问题,衡量概率分布之间的差异。相比于MSE,交叉熵在分类问题上更加灵敏,训练效率更高。

```python

# 示例代码块:交叉熵损失函数应用

labels = tf.placeholder(tf.float32, [None, num_classes])

predictions = tf.nn.softmax(logits)

loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits=logits, labels=labels))

```

**优化算法:**

- **随机梯度下降(SGD):** 最简单的优化算法,逐批次更新参数,但可能需要较小的学习率和更多的迭代次数。

- **动量优化(Momentum):** 引入动量项来加速学习过程,避免陷入局部最小值。

- **Adam优化器:** 结合了RMSprop和动量优化的优点,自适应调整学习率,适合多种问题。

```python

# 示例代码块:使用Adam优化器

optimizer = tf.train.AdamOptimizer(learning_rate=0.001).minimize(loss)

```

损失函数和优化算法的选择直接影响CNN模型的训练过程和性能,选择合适的组合是实现模型优化的关键。

# 3. CNN在自动驾驶感知系统中的应用

在自动驾驶技术的演进中,感知系统的构建至关重要。感知系统负责从车辆传感器收集的原始数据中解析出

0

0