实时视频分析优化:CNN高效算法与硬件加速技术的结合

发布时间: 2024-11-20 16:42:25 阅读量: 69 订阅数: 21

无缝集成:将DeepSORT嵌入视频分析系统的艺术

# 1. 实时视频分析的基础知识

实时视频分析是现代智能监控、自动驾驶、视频通话等领域不可或缺的技术之一。它涉及从原始视频流中提取有用信息并快速做出反应的能力。实时视频分析的核心目标是在尽量减少延迟的同时,准确理解视频内容,包括识别、跟踪、行为分析等。

## 1.1 视频分析流程简述

视频分析通常包括以下几个步骤:预处理(去噪、增强)、目标检测、特征提取、行为理解和决策制定。每个步骤都是实时视频分析系统不可或缺的组成部分。

## 1.2 关键技术与挑战

关键技术包括但不限于图像处理、机器学习、深度学习等。其中,深度学习中的卷积神经网络(CNN)由于其在图像识别方面的卓越性能,成为了实时视频分析领域内的核心算法。然而,实时性能的挑战仍然存在,包括算法的复杂度与计算资源的限制。优化这些算法以适应不同的硬件平台,是目前研究的热点。

```mermaid

graph TD;

A[视频分析流程] -->|预处理| B(预处理)

B -->|目标检测| C(目标检测)

C -->|特征提取| D(特征提取)

D -->|行为理解| E(行为理解)

E -->|决策制定| F[决策制定]

```

在接下来的章节中,我们将深入探讨CNN的架构、高效算法以及硬件加速技术,并分析它们如何协同工作以实现高效率的实时视频分析系统。

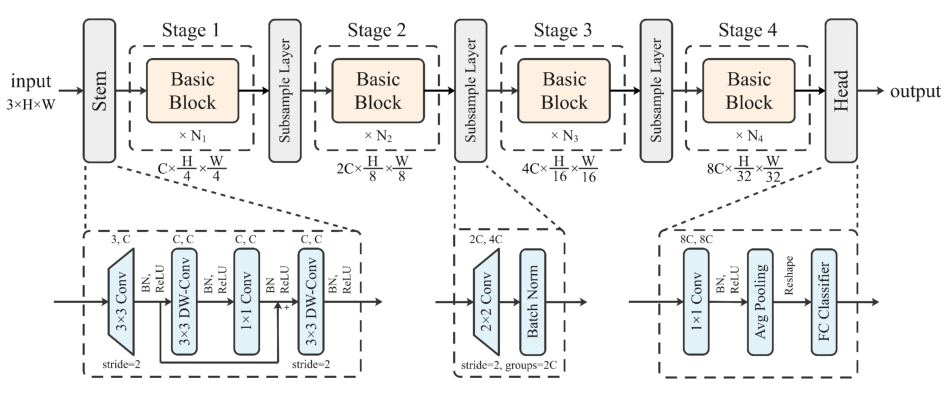

# 2. 卷积神经网络(CNN)基础与高效算法

## 2.1 CNN的基本原理和架构

### 2.1.1 卷积层、池化层、全连接层的作用与优化

卷积神经网络(CNN)是深度学习中一种应用广泛的网络结构,特别是在图像和视频分析领域。CNN的核心在于通过卷积层、池化层和全连接层的组合,提取输入数据的特征,并进行分类或回归分析。以下为这些关键层次的详细解读。

**卷积层**是CNN中最基础的构建模块,其作用是通过滤波器(或称为卷积核)在输入数据上进行卷积操作,以此提取局部特征。卷积层的优化通常涉及减少滤波器的数量、改变滤波器大小,以及应用不同类型的非线性激活函数,如ReLU(Rectified Linear Unit),以增加网络的非线性,提高特征提取能力。

```python

import torch.nn as nn

class ConvolutionalLayer(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size, stride=1, padding=0):

super(ConvolutionalLayer, self).__init__()

self.conv = nn.Conv2d(in_channels, out_channels, kernel_size, stride, padding)

def forward(self, x):

return self.conv(x) # 这里仅展示了前向传播函数

```

参数解释:

- `in_channels`: 输入数据的通道数,例如RGB图像的通道数为3。

- `out_channels`: 卷积核的数量,决定输出数据的通道数。

- `kernel_size`: 卷积核的大小,如3x3或5x5。

- `stride`: 卷积核移动的步长。

- `padding`: 边缘填充,保证输出尺寸的一致性。

卷积操作后通常会应用激活函数,常见的做法是使用ReLU激活函数,它能够帮助网络避免梯度消失的问题,并促进模型训练的效率。

**池化层**通过下采样减少特征图的尺寸,减少参数数量及计算量。池化操作包括最大池化(Max Pooling)和平均池化(Average Pooling)等。池化层优化通常涉及到池化核的大小调整。

**全连接层**在CNN的末端,用于对从前面卷积层提取的特征进行整合,并输出最终的分类结果或其他预测值。优化全连接层可以通过减少神经元的数量、正则化项(如L2惩罚项)以及使用dropout技术防止过拟合来实现。

### 2.1.2 常用的CNN模型及其特点

CNN模型历经数代发展,涌现了许多经典的模型,它们在不同类型的图像和视频处理任务中表现卓越。以下是几个著名的CNN模型及其特点的总结。

**LeNet-5**是最早的卷积神经网络之一,由Yann LeCun等人在1998年提出,主要用于手写数字识别任务。LeNet-5由交替的卷积层、池化层、全连接层组成,其结构虽然简单,但奠定了后续CNN发展的基础。

**AlexNet**在2012年ImageNet挑战赛中取得突破性成绩,标志着深度学习时代的来临。AlexNet由8层网络构成,包括5个卷积层和3个全连接层,使用ReLU激活函数,应用了局部响应归一化(Local Response Normalization, LRN)和Dropout正则化技术。

**VGGNet**通过重复使用简单的3x3卷积核,并将网络深度增加到16-19层,显著提升了图像分类的准确性。VGGNet强调了深度网络在提取复杂特征中的作用,但其缺点是参数众多,计算复杂。

**ResNet**(残差网络)引入了“残差学习”的概念,通过设计“跳跃连接”(skip connections)解决了深层网络训练时梯度消失的问题。ResNet能够在保持网络深度的同时提高训练的稳定性,使得网络可以达到百层以上。

## 2.2 高效CNN算法研究

### 2.2.1 深度可分离卷积与分解卷积

深度可分离卷积(Depthwise Separable Convolution)是高效的CNN设计的关键技术之一,它能显著减少计算量和模型大小,同时保持模型性能。深度可分离卷积将标准的卷积操作拆分为两个步骤:深度卷积和逐点卷积。

**深度卷积**(Depthwise Convolution)对每个输入通道独立进行卷积操作,与传统的卷积相比,大幅减少了参数和计算量。假设一个3x3的卷积核,在输入数据的每个通道上执行一次卷积操作。

**逐点卷积**(Pointwise Convolution)或称为1x1卷积,随后对深度卷积的结果进行降维或升维处理。它作为一个全连接层,对深度卷积后的特征进行重新组合。

```python

class DepthwiseSeparableConv(nn.Module):

def __init__(self, in_channels, out_channels):

super(DepthwiseSeparableConv, self).__init__()

self.depthwise = nn.Conv2d(in_channels, in_channels, kernel_size=3, padding=1, groups=in_channels)

self.pointwise = nn.Conv2d(in_channels, out_channels, kernel_size=1)

def forward(self, x):

x = self.depthwise(x)

x = self.pointwise(x)

return x

```

使用深度可分离卷积的一个显著优点是它极大减少了模型参数量和计算资源,非常适合移动和嵌入式设备。

### 2.2.2 空洞卷积与分组卷积的应用实例

**空洞卷积**(Dilated Convolution)或扩张卷积,通过在卷积核中引入“空洞”,在不增加额外参数的情况下扩大了卷积的感受野,使网络有能力捕捉更大范围的上下文信息。空洞卷积的参数`rate`控制着卷积核的扩张程度。

```python

class DilatedConv(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size, rate=1):

super(DilatedConv, self).__init__()

self.dilated = nn.Conv2d(in_channels, out_channels, kernel_size, padding=rate)

def forward(self, x):

return self.dilated(x)

```

在语义分割等任务中,空洞卷积能有效提高模型的分割精度。

**分组卷积**(Grouped Convolution)则是将输入通道和输出通道分成多个组,在组内独立执行卷积操作。这可以减少模型参数和计算量,同时保留一定的特征提取能力。分组卷积是ResNeXt网络的基础。

```python

class GroupedConv(nn.Module):

def __ini

```

0

0