【AdaBoost深度解析】:5个案例揭示分类问题中的最佳实践

发布时间: 2024-11-20 23:14:45 阅读量: 65 订阅数: 34

adaboost-knn:基于KNN的ADABOOST分类器在Java中使用多线程实现

# 1. AdaBoost算法概述

AdaBoost(Adaptive Boosting)算法作为提升学习(Boosting)领域的重要里程碑,已经在各种机器学习任务中显示出其强大的分类能力。提升学习的核心思想是将多个弱学习器组合起来构建一个强学习器,通过这种集成学习的方式,使得最终的学习器能够达到较高的预测精度。在众多提升算法中,AdaBoost以其独特的自适应更新机制,成为最受欢迎和研究最深入的算法之一。

本章将介绍AdaBoost的基本概念及其核心思想,并提供一个直观的理解,为后续章节中对其工作原理和实践应用的深入探讨打下基础。通过对AdaBoost算法的概述,我们将会看到,其在提升模型性能方面的潜力和优势,同时也会了解到,为了达到最佳性能,理解并掌握其背后的理论和实践是十分必要的。

# 2. 理论基础与AdaBoost原理

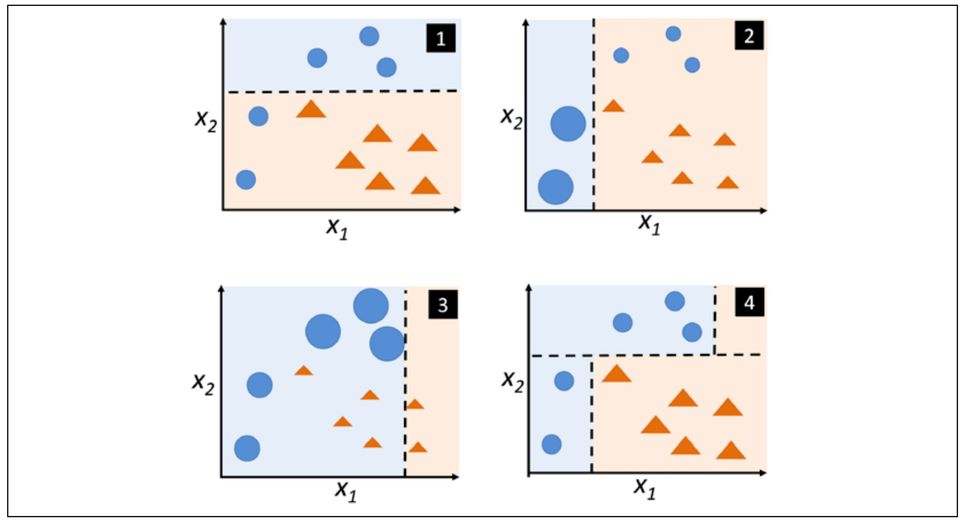

在深入探讨AdaBoost(Adaptive Boosting)算法之前,理解其理论基础和原理是至关重要的。Adaboost是一种迭代算法,它的核心思想是通过提高之前分类器分类错误的数据点的权重,使得新的分类器在迭代过程中能够更加专注于这些难以分类的数据,从而提升整体的分类性能。它属于提升(Boosting)技术的一个分支,该技术旨在将多个弱学习器提升为一个强学习器。

### 弱学习器与强学习器

#### 弱学习器定义及类型

在机器学习中,弱学习器通常指的是那些仅比随机猜测好一点的分类器。这并不是说弱学习器没有价值,相反,它们在组合成为强学习器的过程中扮演了关键角色。常见的弱学习器包括决策树桩(Decision Stump),即只包含单个决策节点的决策树,以及其他简单的模型,如逻辑回归和朴素贝叶斯分类器。

弱学习器的类型可以从多个角度进行划分:

- **决策树桩**:依据单一特征进行分类。

- **感知机**:一种简单的线性二分类模型。

- **简单线性模型**:如逻辑回归,在二分类问题中是弱学习器的一种形式。

- **K近邻算法**(K-NN):一种基于实例的学习算法,通过多数表决原则来分类。

#### 强学习器与提升方法

与弱学习器相比,强学习器在给定的训练集上具有较高的预测准确率。强学习器通常能够很准确地对数据进行分类,但构建强学习器的成本往往较高,因为它们可能是复杂的非线性模型或是包含大量参数的模型。

提升方法的核心在于结合多个弱分类器的预测结果,形成一个强分类器。这可以通过不同的技术实现,而AdaBoost是提升方法中的代表之一。在AdaBoost中,通过迭代地训练弱分类器,并根据前一个分类器的性能调整样本的权重,最终将这些分类器的预测结果进行加权求和,形成最终的决策。

### AdaBoost的核心算法

#### 权重更新规则

在每一轮的迭代中,AdaBoost算法会根据当前分类器的性能对样本的权重进行更新。具体来说,如果一个样本被分类器错误分类,它的权重会增加,而正确分类的样本权重则减少。这一过程可以用以下规则来表述:

- 对于正确分类的样本,新权重计算公式为:`w_i = w_i * exp(-alpha)`。

- 对于错误分类的样本,新权重计算公式为:`w_i = w_i * exp(alpha)`。

这里的`w_i`是样本的初始权重,`alpha`是当前迭代轮次中弱分类器的权重,它与分类器错误率有关。

#### 分类器组合策略

AdaBoost组合弱分类器的策略依赖于它们在每一轮中的表现。具体来说,每个弱分类器的权重取决于其分类错误率。错误率低的分类器会被分配更大的权重,反之则权重较小。最终,AdaBoost通过加权投票的方式决定最终的分类结果。如果分类器是二分类器,它会输出一个介于-1和+1之间的值。如果输出值为正,数据点被归类为一类;如果输出值为负,则归为另一类。

### 理论推导与数学模型

#### 损失函数的选择

AdaBoost使用指数损失函数来评估和优化模型。这种损失函数特别适合于处理分类问题,并且能够引导模型关注那些分类困难的样本。在每一轮迭代中,AdaBoost的目标是最小化加权指数损失函数:

\[ L(\alpha) = \sum_{i=1}^{n} w_i \exp(-y_i f(x_i)) \]

这里的`w_i`是样本权重,`y_i`是样本的真实标签(+1或-1),`f(x_i)`是第`i`个分类器的预测输出。

#### AdaBoost的优化目标

AdaBoost算法的优化目标是找到一系列弱分类器及其对应的权重,使得加权和预测结果与真实结果之间的损失最小。这可以被看作是寻找在加权样本上具有最小加权指数损失的分类器序列的问题。通过优化这一目标,AdaBoost能够构建出一个强分类器,该分类器在新的数据点上的泛化能力得到增强。

在接下来的章节中,我们将通过具体的实践案例来进一步展示AdaBoost算法如何在现实世界中得到应用,并分析其在处理特定问题时的表现和优化策略。

# 3. AdaBoost算法实践案例分析

在深入了解了AdaBoost算法的理论基础之后,我们将目光转向实践应用,以三个具体的案例来展示AdaBoost算法在不同类型问题中的应用。本章的目标是通过实践来加深对AdaBoost算法适用场景、实施步骤和效果评估的理解,以及对模型性能的深入分析。

## 3.1 案例一:AdaBoost在手写数字识别中的应用

手写数字识别是一个经典的机器学习问题,常被用作算法性能的基准测试。本小节将介绍如何应用AdaBoost算法来解决这一问题,包括数据集的介绍与预处理、模型构建与评估等步骤。

### 3.1.1 数据集介绍与预处理

在开始前,我们先简要介绍用于手写数字识别的常用数据集——MNIST。MNIST是一个包含了60,000个训练样本和10,000个测试样本的数据集,每个样本代表了一个0到9的手写数字图片,图片大小为28x28像素,以灰度值的形式展现。

为了使用AdaBoost算法,首先需要对数据进行预处理。这包括将原始数据进行归一化处理,以缩小不同特征值之间的差距,从而加快算法的收敛速度。以下是数据预处理的Python代码示例:

```python

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# 加载MNIST数据集

digits = datasets.load_digits()

# 数据集划分

X_train, X_test, y_train, y_test = train_test_split(digits.data, digits.target, test_size=0.2, random_state=42)

# 数据标准化

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

```

经过上述步骤,数据已经准备就绪,可以用于训练AdaBoost模型。

### 3.1.2 AdaBoost模型构建与评估

接下来,我们将构建AdaBoost模型。在本例中,我们使用`AdaBoostClassifier`,这是scikit-learn库提供的实现。我们将使用决策树作为基本的弱分类器,并构建一个由多个这样的分类器组成的强分类器。模型训练后,使用测试集进行评估。以下是构建和评估模型的Python代码:

```python

from sklearn.ensemble import AdaBoostClassifier

from sklearn.metrics import classification_report, accuracy_score

from sklearn.tree import DecisionTreeClassifier

# 初始化AdaBoost分类器

ada_clf = AdaBoostClassifier(

DecisionTreeClassifier(max_depth=1), n_estimators=200,

algorithm="SAMME.R", learning_rate=0.5, random_state=42

)

# 训练模型

ada_clf.fit(X_train, y_train)

# 预测和评估

y_pred = ada_clf.predict(X_test)

print(f"AdaBoost Accuracy: {accuracy_score(y_test, y_pred):.2f}")

print(classification_report(y_test, y_pred))

```

通过上述代码,我们完成了AdaBoost模型在手写数字识别任务上的应用。在实际应用中,还可以尝试不同的弱分类器、调整学习率和迭代次数等参数来进一步提升模型的性能。

## 3.2 案例二:AdaBoost在语音识别中的角色

在本小节中,我们将探索AdaBoost算法在语音识别场景中的应用。我们首先介绍如何进行特征提取和模型训练,然后进行误差分析和性能优化。

### 3.2.1 特征提取与模型训练

在语音识别任务中,常用的特征提取方法包括梅尔频率倒谱系数(MFCCs)、线性预测编码(LPCs)等。在本案例中,我们使用MFCCs作为音频特征进行处理。

以下是使用Python的librosa库进行MFCCs特征提取的示例代码:

```python

import librosa

import numpy as np

# 加载音频文件

audio_path = "path_to_audio.wav"

signal, sr = librosa.load(audio_path, sr=None)

# 提取MFCCs特征

mfccs = librosa.feature.mfcc(y=signal, sr=sr)

# 进行归一化处理

mfccs = librosa.util.normalize(mfccs)

```

接下来,我们构建AdaBoost模型进行训练:

```python

# 假设X_mfccs为音频文件的MFCCs特征矩阵,y为标签

X_train_mfccs, X_test_mfccs, y_train, y_test = train_test_split(mfccs, labels, test_size=0.2, random_state=42)

# 训练AdaBoost分类器

ada_clf.fit(X_train_mfccs, y_train)

# 预测

y_pred_mfccs = ada_clf.predict(X_test_mfccs)

```

### 3.2.2 误差分析与性能优化

训练完成后,我们需要对模型进行误差分析,以确定在哪些方面还有提升空间。可以通过混淆矩阵来分析错误分类的情况,并根据分析结果调整模型的参数。此外,还可以尝试采用不同的特征提取方法或进一步优化预处理步骤,来改进模型的识别能力。

## 3.3 案例三:AdaBoost在图像分类中的实践

本小节中,我们将探讨如何在图像分类任务中应用AdaBoost算法。这包括图像数据的预处理方法、分类效果的提升技巧等内容。

### 3.3.1 图像数据的预处理方法

图像数据的预处理通常包括灰度化、尺寸标准化、归一化等步骤。由于AdaBoost需要输入特征向量,所以还需要将处理后的图像转换成适配模型的格式。在Python中,我们可以使用OpenCV库来读取和处理图像数据,然后使用scikit-learn中的`ImageDataVectorizer`将其转换为特征矩阵。以下是一个简单的图像预处理流程的示例代码:

```python

import cv2

from sklearn.feature_extraction.image import ImageDataVectorizer

def image_preprocessing(image_path):

# 读取图像

image = cv2.imread(image_path, cv2.IMREAD_GRAYSCALE)

# 尺寸标准化

image = cv2.resize(image, (28, 28))

# 归一化

image = image / 255.0

return image

# 应用预处理函数到图像数据集

image_paths = ["path_to_image1.jpg", "path_to_image2.jpg", ...]

images = [image_preprocessing(path) for path in image_paths]

# 将图像列表转换为NumPy数组

images_array = np.array(images).reshape((-1, 28 * 28))

# 将图像数组转换为特征矩阵

image_data_vectorizer = ImageDataVectorizer()

images_features = image_data_vectorizer.fit_transform(images_array)

```

### 3.3.2 分类效果的提升技巧

在本案例中,我们展示了如何通过数据预处理和AdaBoost模型来提高图像分类的准确度。除了基本的模型优化外,我们还可以通过以下技巧进一步提升分类效果:

- 特征增强:通过旋转、缩放、平移等方法来增加训练数据的多样性。

- 集成学习:使用不同类型的弱分类器进行集成,利用AdaBoost算法对它们的预测结果进行组合。

- 超参数优化:尝试不同的AdaBoost参数,如学习率、分类器数量等,使用网格搜索或随机搜索方法找到最优解。

通过上述案例分析,我们对AdaBoost在不同类型问题中的应用有了更深入的理解。在接下来的章节中,我们将探讨AdaBoost算法的优化策略,以及它在不同领域的未来应用趋势。

# 4. AdaBoost算法优化策略

### 4.1 参数调整与模型调优

#### 4.1.1 学习率的影响分析

学习率是控制每次更新权重的步长,它在AdaBoost算法中起到至关重要的作用。在实际应用中,选择合适的学习率是提高分类器性能的关键。如果学习率过大,则可能导致分类器过度关注那些难以分类的样本,从而使模型容易过拟合。相反,如果学习率太小,则可能需要更多的迭代次数来达到最佳性能,增加了模型训练的时间成本。

下面是一个调整学习率参数的示例代码:

```python

from sklearn.ensemble import AdaBoostClassifier

from sklearn.datasets import make_classification

# 创建一个合成的二分类数据集

X, y = make_classification(n_samples=500, n_features=20, n_informative=2, n_redundant=10, random_state=42)

# 初始化AdaBoost分类器

adaboost = AdaBoostClassifier(n_estimators=50, random_state=42)

# 使用不同的学习率来训练模型

learning_rates = [0.01, 0.1, 0.5, 1.0]

for lr in learning_rates:

adaboost.set_params(learning_rate=lr)

adaboost.fit(X, y)

print(f"Learning Rate: {lr}, Accuracy: {adaboost.score(X, y)}")

```

在上述代码中,通过设置不同的学习率参数`learning_rate`,我们可以观察到不同的学习率对模型准确率的影响。

#### 4.1.2 分类器数量对性能的影响

在AdaBoost算法中,分类器的数量(`n_estimators`)也是一个重要的参数。增加分类器的数量能够提升模型的复杂度和拟合能力,但当分类器数量过多时,可能会导致过拟合,降低模型泛化能力。因此,合理选择分类器数量是模型优化的一个重要方面。

下面是一个调整分类器数量的示例代码:

```python

from sklearn.metrics import accuracy_score

# 设置学习率和分类器数量的范围

learning_rates = [0.1]

n_estimators_range = [5, 25, 50, 100, 200]

# 对每个学习率和分类器数量组合进行测试

for lr in learning_rates:

for n_estimators in n_estimators_range:

adaboost = AdaBoostClassifier(n_estimators=n_estimators, learning_rate=lr, random_state=42)

adaboost.fit(X_train, y_train)

y_pred = adaboost.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f"Learning Rate: {lr}, Number of Classifiers: {n_estimators}, Accuracy: {accuracy}")

```

在这个例子中,我们通过遍历不同的分类器数量,来评估其对模型准确率的影响。通过分析结果,我们可以选择一个最优的分类器数量。

### 4.2 面临的问题与解决方案

#### 4.2.1 过拟合问题的应对策略

过拟合是机器学习中常见的一种问题,尤其在使用AdaBoost等集成学习算法时更为常见。当模型过于复杂,或者训练集中的噪声和异常值较多时,模型可能会学习到训练数据中的噪声而非真正的模式,从而导致过拟合。

为了缓解过拟合,可以采取以下策略:

- **简化模型**:减少分类器的数量,或使用更简单的分类器。

- **使用正则化方法**:例如,在决策树中设置深度限制。

- **增加训练数据量**:更多的数据有助于模型学习到更一般的模式。

- **进行数据增强**:通过旋转、缩放、裁剪等方式增加样本多样性。

下面是一个使用正则化防止过拟合的决策树分类器示例:

```python

from sklearn.tree import DecisionTreeClassifier

# 初始化决策树分类器,设置一个较小的最大深度

dt = DecisionTreeClassifier(max_depth=3, random_state=42)

# 使用决策树作为AdaBoost的基础分类器

adaboost = AdaBoostClassifier(base_estimator=dt, n_estimators=100, learning_rate=1.0, random_state=42)

```

在这个例子中,通过设置决策树的最大深度为3,可以有效防止决策树过深而产生过拟合现象。

#### 4.2.2 处理不平衡数据集的方法

不平衡数据集是指样本中各类别的数量不等,这在许多实际情况中很常见。例如,在信用卡欺诈检测中,欺诈案例数量远小于正常交易。不平衡数据集可能导致模型偏向于多数类,从而忽略少数类。

为了处理不平衡数据集,可以采取以下策略:

- **重采样技术**:增加少数类样本数量或减少多数类样本数量。

- **调整类权重**:在算法中设置类权重,使得少数类获得更高的权重。

- **使用特定的评估指标**:例如F1分数、精确度、召回率等,而不仅仅是准确率。

下面是一个使用类权重调整方法的示例:

```python

from sklearn.ensemble import AdaBoostClassifier

# 初始化AdaBoost分类器,设置不平衡数据集的类权重

adaboost = AdaBoostClassifier(n_estimators=100, learning_rate=1.0, random_state=42)

adaboost.set_params(class_weight={0: 1, 1: 2}) # 假设类0为多数类,类1为少数类

# 训练分类器

adaboost.fit(X_train, y_train)

```

在这个例子中,通过设置`class_weight`参数,使得少数类(类1)在模型中的重要性增加,有助于提升模型对少数类的分类性能。

### 4.3 比较其他提升方法

#### 4.3.1 AdaBoost与其他提升技术的对比

AdaBoost是最著名的提升方法之一,但并非唯一。其他提升方法包括梯度提升机(GBM)、随机梯度提升机(GBRT)和XGBoost等。这些方法都利用了迭代加法建模的思想,但是在损失函数、树的构建以及正则化方法上有所不同。

下表简要比较了这些提升方法的关键特性:

| 方法 | 损失函数 | 树的构建方法 | 正则化方法 |

| ------ | -------- | ------------ | ---------- |

| AdaBoost | 指数损失 | 基于权重的贪心算法 | 不明显 |

| GBM | 任意可微分损失 | 基于梯度的贪心算法 | 剪枝和步长缩减 |

| GBRT | 任意可微分损失 | 随机化贪心算法 | 剪枝和步长缩减 |

| XGBoost | 任意可微分损失 | 基于梯度的贪心算法 | 剪枝、步长缩减、列抽样 |

从表中可以看出,虽然这些提升方法都致力于减少训练误差,但它们在实现细节上存在差异。例如,GBM和XGBoost在构建每棵树时使用梯度信息,这通常能更快地收敛到更优的模型。

#### 4.3.2 跨领域应用的拓展案例

提升方法已经被应用于多个领域,包括但不限于生物信息学、金融、工业自动化等。在这些领域中,提升方法通过增强模型的预测能力和提高预测精度,为解决实际问题提供了有力的工具。

以下是一个拓展案例,展示了AdaBoost在生物信息学中的应用:

- **问题描述**:在基因表达数据分析中,准确预测疾病状态对于个性化医疗至关重要。

- **方法实现**:使用AdaBoost模型结合基因选择方法,构建出能够区分健康和疾病状态的分类器。

- **结果展示**:通过实验验证,该方法相比单一分类器显著提升了预测的准确度。

这种拓展案例不仅展示了AdaBoost的实用性,也证明了其在跨领域的普适性和有效性。

# 5. 未来趋势与扩展应用

AdaBoost算法自从被提出以来,已经在多个领域展现出了其广泛的应用潜力,而随着机器学习和深度学习领域的发展,AdaBoost也在不断地进行着创新和优化。本章将探讨AdaBoost的变种,其在深度学习中的应用,行业应用前景,以及最新的研究动态。

## 5.1 AdaBoost的变种与创新

### 5.1.1 提升树与梯度提升机

提升树(Boosting Tree)和梯度提升机(Gradient Boosting Machine, GBM)是AdaBoost发展而来的两种重要算法。提升树是一种集成学习方法,通过顺序地构建一系列决策树,并在每一步中都关注之前所有树的预测错误。与AdaBoost相似,提升树也有一个优化过程,但不同的是,提升树在每一次迭代中构造的是一个回归树而不是加权的简单分类器。

梯度提升机是另一种基于梯度下降方法的提升算法,它通过迭代地添加新模型来修正前一个模型的残差。GBM能够使用任意可微损失函数,所以它能够适用于各种问题,包括回归、分类和排序问题。

```python

from sklearn.ensemble import GradientBoostingClassifier

# 示例代码:使用scikit-learn实现梯度提升分类器

gbc = GradientBoostingClassifier(n_estimators=100, learning_rate=1.0, max_depth=1)

gbc.fit(X_train, y_train)

predictions = gbc.predict(X_test)

```

在上述代码中,`GradientBoostingClassifier`是scikit-learn库提供的梯度提升分类器实现。`n_estimators`参数控制着树的数量,`learning_rate`控制着模型的学习步长,而`max_depth`控制着单个决策树的最大深度。

### 5.1.2 AdaBoost在深度学习中的应用

深度学习领域的一个重要问题是梯度消失或梯度爆炸,特别是在训练深层网络时。为了解决这一问题,研究者尝试将AdaBoost的思想应用于神经网络的训练中。

对于深度学习,AdaBoost可以用于多层感知机(MLP)中,选择重要的特征或子网络,然后通过AdaBoost的权重更新规则来更新这些重要特征或子网络的权重。这种策略能够在一定程度上缓解梯度消失或梯度爆炸的问题,并提高网络的训练速度和性能。

```python

from sklearn.ensemble import AdaBoostClassifier

from keras.models import Sequential

from keras.layers import Dense

# 示例代码:使用Keras构建MLP,并集成AdaBoost

mlp_model = Sequential()

mlp_model.add(Dense(12, input_dim=X.shape[1], activation='relu'))

mlp_model.add(Dense(1, activation='sigmoid'))

# 编译模型

mlp_model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# 使用AdaBoost进行模型集成

adaboost = AdaBoostClassifier(base_estimator=mlp_model, n_estimators=10)

adaboost.fit(X_train, y_train)

```

在上面的代码示例中,我们首先构建了一个简单的多层感知机模型,并将其作为AdaBoost的基学习器。这样,模型的训练将通过AdaBoost的权重更新来引导,使得模型能够更有效地学习数据中的重要特征。

## 5.2 行业应用前景

### 5.2.1 医疗诊断中的应用潜力

在医疗诊断领域,AdaBoost和其变种技术可以用来提高疾病预测的准确性,比如癌症、心脏病等的早期诊断。特别是在处理不平衡数据集方面,比如某些疾病在人群中发病率较低的情况,AdaBoost能够通过其独特的权重更新机制,使得模型更加关注那些难以预测的少数类样本。

```mermaid

graph LR

A[医疗数据] -->|预处理| B[特征提取]

B --> C[AdaBoost模型训练]

C --> D[疾病预测]

```

在上述流程中,从医疗数据开始,进行必要的预处理和特征提取,然后通过AdaBoost进行模型训练,最终实现对疾病的预测。

### 5.2.2 金融科技中的风险预测实例

在金融科技领域,AdaBoost可用来预测和管理风险。例如,它可以用于信用卡欺诈检测、信用评分等。由于金融数据通常包含大量的噪声和异常值,AdaBoost通过其迭代的错误校正过程,能够逐渐提高模型的鲁棒性,这对于风险预测至关重要。

```mermaid

graph LR

A[金融交易数据] -->|数据清洗| B[特征工程]

B --> C[AdaBoost模型构建]

C --> D[风险评估]

```

该流程说明了从金融交易数据开始,经过数据清洗和特征工程后,使用AdaBoost模型进行风险评估的过程。

## 5.3 研究的最新动态

### 5.3.1 国际上最新研究成果展示

最近的研究表明,AdaBoost算法可以被进一步优化,以适应更复杂的数据结构和动态变化的环境。例如,在一些研究中,通过集成深度学习技术,实现了对高维数据的高效学习,提高了在图像和语音识别任务上的性能。

此外,多模态数据的处理也是当前的研究热点。例如,结合视觉数据和文本数据进行信息检索的研究,使用AdaBoost算法来提升检索结果的相关性和准确性。

### 5.3.2 学术界对AdaBoost算法的展望

学术界对AdaBoost的未来展望主要集中在算法的效率、可解释性和泛化能力上。研究者希望进一步提高算法的效率,使之能够更快地处理大规模数据集。同时,算法的可解释性也是重要的研究方向,这关系到模型的可信度和是否能被实际应用。

在泛化能力方面,学者们致力于探索更多的损失函数和优化策略,希望AdaBoost能够在更多的机器学习任务中展示出强大的性能。此外,结合其他机器学习算法,如集成深度学习模型,也是未来研究的一个重要趋势。

通过本章节的介绍,我们可以看到AdaBoost算法在实际应用中的多样化以及其在理论和实践上的不断进步。未来,我们可以期待AdaBoost在更多领域的创新应用,并看到其在处理复杂数据结构上的进一步突破。

# 6. AdaBoost算法在网络安全中的应用

## 6.1 网络安全中的异常检测

在网络安全领域,异常检测是关键任务之一。通过利用AdaBoost算法,可以构建一个高效的学习模型,用于识别网络流量中的异常行为。这些异常行为可能表示潜在的恶意活动,例如入侵、病毒传播或DDoS攻击。

## 6.2 数据预处理与特征选择

在将AdaBoost应用于网络安全之前,需要进行仔细的数据预处理和特征选择步骤。网络流量数据通常含有大量特征,需要通过统计分析或信息增益等方法来选取最有助于区分正常和异常流量的特征。

### 示例代码:

```python

from sklearn.datasets import make_classification

from sklearn.feature_selection import SelectKBest, chi2

# 假设X和y分别是特征数据和标签

X, y = make_classification(n_samples=1000, n_features=25, n_informative=2, n_redundant=10, random_state=42)

# 使用卡方检验选择K个最佳特征

chi_best_features = SelectKBest(chi2, k=10)

X_new = chi_best_features.fit_transform(X, y)

```

## 6.3 AdaBoost模型的构建与训练

构建AdaBoost模型涉及到多个弱学习器的集成。在网络安全的上下文中,这可能意味着使用不同类型的分类器(如决策树、支持向量机等)来构建最终的提升模型。

### 示例代码:

```python

from sklearn.ensemble import AdaBoostClassifier

# 假设已经选择了最佳特征并进行了归一化处理

# 初始化AdaBoost分类器,并使用决策树作为基础分类器

clf = AdaBoostClassifier(n_estimators=50, learning_rate=1.0)

# 训练模型

clf.fit(X_new, y)

```

## 6.4 模型的评估与优化

在模型训练完成后,评估模型的性能是至关重要的一步。可以使用混淆矩阵、精确率、召回率和F1分数等指标来评估模型在检测网络异常方面的准确性。

### 示例代码:

```python

from sklearn.metrics import confusion_matrix, classification_report

# 预测测试集

predictions = clf.predict(X_new)

# 生成报告

report = classification_report(y, predictions)

print(report)

```

## 6.5 实际部署与监控

将模型部署到生产环境中后,需要持续监控其性能,并定期进行重新训练以适应网络流量模式的变化。此外,还可以集成实时数据流处理系统来实现快速响应潜在的安全威胁。

## 6.6 总结

在本章节中,我们探索了AdaBoost算法在网络安全中的应用。通过结合数据预处理、特征选择、模型构建和评估等步骤,AdaBoost能够有效提升异常检测的准确性,为网络安全提供一道坚实的防线。

0

0