【Hadoop吞吐量提升】:减少延迟与优化数据写入的4大策略

发布时间: 2024-10-28 09:07:52 阅读量: 7 订阅数: 8

# 1. Hadoop吞吐量与延迟概述

在大数据处理领域,Hadoop作为一个成熟稳定的分布式存储与计算平台,对吞吐量和延迟的优化至关重要。吞吐量指的是系统在单位时间内处理任务的总量,高吞吐量意味着系统可以更快速地处理大量数据;而延迟指的是完成一个任务所需的时间,低延迟则意味着系统处理单个请求更为迅速。

随着业务需求的日益复杂化,对Hadoop进行吞吐量与延迟的优化,能够显著提升数据处理效率,增强系统的响应速度,满足实时数据处理的需求。优化这两方面的性能,可以帮助企业从大数据中更快获得洞察,提高竞争优势。

在接下来的章节中,我们将深入探讨影响Hadoop吞吐量与延迟的多个因素,包括硬件资源、软件配置、数据写入流程等,并提供具体策略以实现性能的优化。我们会通过案例分析,展示如何在实际应用中操作和调整这些策略来提升系统性能。

# 2. 数据写入优化基础

### 2.1 Hadoop数据写入流程解析

Hadoop数据写入流程是理解如何优化数据写入操作的关键。在Hadoop生态系统中,数据写入操作通常是由HDFS(Hadoop Distributed File System)来完成的,这是一个高度容错性的系统,专为存储大型数据集而设计。

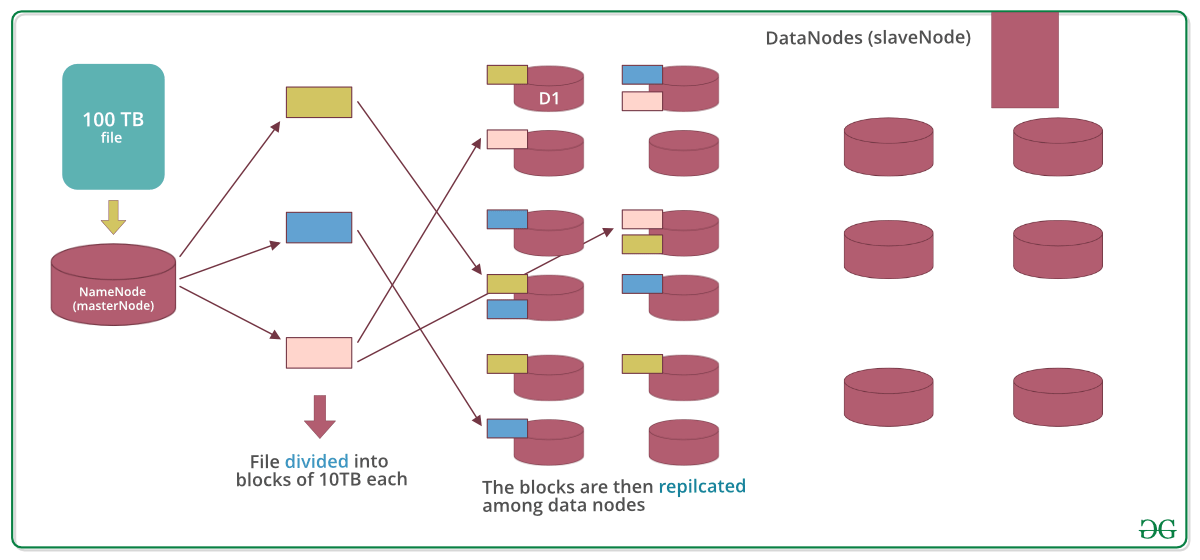

#### 2.1.1 数据节点的角色与任务

在Hadoop集群中,数据写入是由NameNode和DataNode共同完成的。NameNode是管理元数据的核心节点,它记录了文件系统中的所有文件和目录,以及这些文件和目录所对应的数据块位置。而DataNode则负责存储和检索数据块。

为了保证数据的高可用性,Hadoop通常将每个数据块复制到多个DataNode上,这个过程被称为数据的“复制”或“冗余”。NameNode根据配置的副本因子来决定每个数据块需要复制的份数。在默认配置下,Hadoop的副本因子为3,意味着每个数据块会被复制到3个不同的DataNode上。

#### 2.1.2 数据写入过程中的常见瓶颈

在数据写入过程中,有几个因素会导致瓶颈的出现:

- **磁盘IO**:如果DataNode的磁盘IO性能不足以应对数据写入速度,就可能出现瓶颈。

- **网络带宽**:数据在节点间传输可能会受到网络带宽的限制。

- **内存管理**:在数据写入过程中,内存管理不当也会导致性能问题,尤其是在使用写入缓存时。

- **配置不当**:Hadoop的配置参数如果设置得不合理,比如过小的缓冲区大小,也会导致性能瓶颈。

### 2.2 理解Hadoop吞吐量的影响因素

#### 2.2.1 硬件资源对吞吐量的影响

在Hadoop集群中,硬件资源是影响吞吐量的一个重要因素。具体到数据节点,磁盘性能、CPU和内存等硬件资源会直接影响数据的读写速度和处理能力。

- **磁盘类型和数量**:使用更高性能的磁盘(如SSD)或增加磁盘数量可以提高写入速度。

- **CPU资源**:CPU资源对于处理数据和执行MapReduce任务至关重要。

- **内存大小**:为DataNode分配足够的内存,可以提高数据缓存和处理的效率。

#### 2.2.2 软件配置对吞吐量的作用

除了硬件资源,软件层面的配置同样能影响Hadoop集群的吞吐量。

- **HDFS配置**:例如,`dfs.block.size`配置项决定了HDFS中数据块的大小,这对于吞吐量有直接影响。太大的数据块会增加单个磁盘的压力,而太小的数据块会增加NameNode的元数据管理负担。

- **YARN配置**:在资源管理和任务调度层面,YARN(Yet Another Resource Negotiator)的参数设置决定了集群资源的分配和任务调度的效率。

- **MapReduce配置**:调整MapReduce任务的参数,如并行度和内存分配,可以优化任务的执行速度。

```bash

# HDFS配置项示例

hdfs dfs -setrep -w 3 /path/to/file # 设置文件的副本因子为3

```

以上命令设置了文件的副本因子为3,这是影响Hadoop集群数据写入和副本管理的重要配置。通过调整这个参数,管理员可以控制数据的冗余度,从而影响整体集群的性能。

```mermaid

graph LR

A[客户端] -->|写入请求| B(NameNode)

B -->|元数据信息| C[DataNode1]

B -->|元数据信息| D[DataNode2]

B -->|元数据信息| E[DataNode3]

C -->|数据块| F[磁盘]

D -->|数据块| G[磁盘]

E -->|数据块| H[磁盘]

```

在上述流程中,客户端向NameNode发送写入请求,NameNode处理请求后,将元数据信息分发给各个DataNode。然后DataNode将数据块写入本地磁盘。

### 2.2.3 代码块解析与优化参数说明

在Hadoop中,我们可以通过调整参数来优化数据写入的性能。例如,调整`dfs.block.size`可以改变数据块的大小,从而影响写入性能。

```java

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

String src = "/path/to/sourcefile";

String dst = "/path/to/destfile";

fs.copyFromLocalFile(new Path(src), new Path(dst));

```

上面是一个简单的Java代码示例,展示了如何在Hadoop中使用FileSystem API进行文件的本地复制。在这个过程中,HDFS的数据块大小会直接影响写入速度和存储效率。通过代码中的`Configuration`类,管理员可以动态地调整HDFS的参数,实现性能的优化。

通过这种方式,我们不仅能够提升数据写入的速度,还能够合理地分配系统资源,提高Hadoop集群的总体吞吐量。下一章节将讨论如何降低延迟,并提供具体的优化策略。

# 3. 降低延迟的策略实施

## 3.1 网络延迟的优化方法

### 3.1.1 交换机和路由器的配置

网络延迟在网络通信中是一个不可忽视的因素,它直接影响到数据处理的速度和效率。优化网络延迟通常从基础设备配置开始,这包括了交换机和路由器的配置。

现代交换机和路由器已经支持很多高级配置,例如QoS(Quality of Service,服务质量),可以对特定类型的流量进行优先级划分。通过合理配置QoS,可以为Hadoop集群中的数据传输提供更高的优先级,从而降低网络延迟。

具体来说,需要在交换机和路由器上进行以下配置:

- 配置VLANs(虚拟局域网),将Hadoop集群中的不同节点划分在不同的VLAN中,以减少广播流量带来的影响。

- 配置端口优先级,确保Hadoop集群的数据流量具有较高的优先级,防止被非关键应用流量所挤压。

- 开启流量监控功能,对于发现的网络拥塞及时采取行动进行缓解。

### 3.1.2 节点间的网络拥塞控制

网络拥塞是导致延迟上升的一个主要原因。为了控制网络拥塞,我们可以采取以下几个策略:

- 利用网络拥塞控制协议,如TCP BBR(Bottleneck Bandwidth and RTT),这种协议可以在网络拥塞发生时动态调整发送窗口的大小,以避免网络中的队列溢出。

- 限制单个节点的并发连接数,从而避免同时产生过多的数据请求,造成网络拥塞。

- 定期进行网络压力测试,以监控网络性能,并在问题

0

0