CART决策树算法在决策支持系统中的中流砥柱:辅助决策与提升效率

发布时间: 2024-08-21 00:42:03 阅读量: 21 订阅数: 35

基于CART决策树算法的运营商客户流失预测

# 1. CART决策树算法概述**

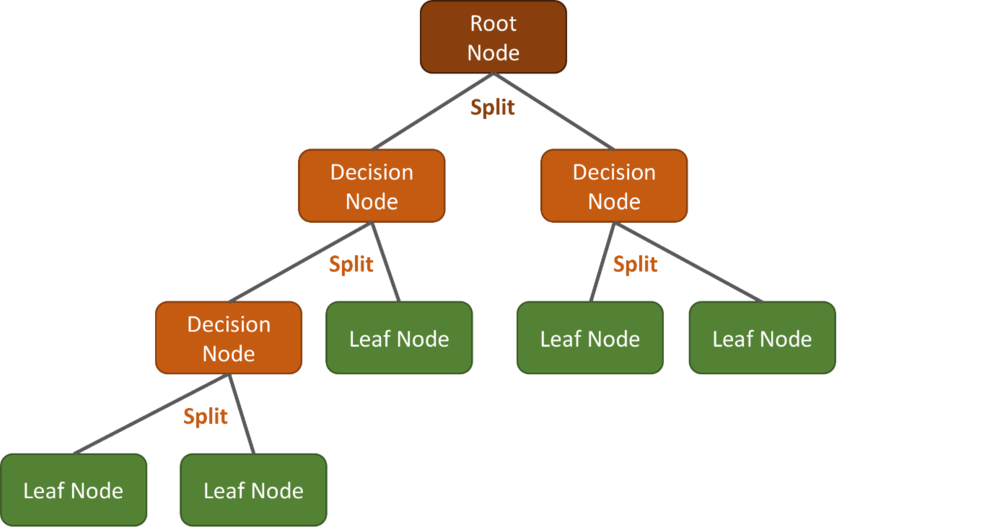

CART(分类和回归树)决策树算法是一种机器学习算法,用于预测目标变量的值。它通过递归地将数据分割成较小的子集来构建决策树,每个子集代表目标变量的不同值。CART算法使用信息增益或基尼不纯度等指标来选择最佳分割特征,并使用最小化目标变量方差的准则来确定每个子集的最佳分割点。

# 2.1 信息增益和信息熵

### 信息增益

信息增益是衡量特征对目标变量分类能力的指标。它表示在使用特征划分数据集后,目标变量的不确定性减少的程度。信息增益越大,特征对目标变量的分类能力越强。

信息增益的计算公式为:

```python

IG(S, A) = H(S) - H(S|A)

```

其中:

- `IG(S, A)` 表示特征 `A` 对数据集 `S` 的信息增益

- `H(S)` 表示数据集 `S` 的熵

- `H(S|A)` 表示在使用特征 `A` 划分数据集 `S` 后,数据集 `S` 的条件熵

### 信息熵

信息熵衡量数据集的不确定性程度。它表示数据集中的样本分布有多均匀。信息熵越大,数据集的不确定性越大。

信息熵的计算公式为:

```python

H(S) = -Σ(p_i * log2(p_i))

```

其中:

- `H(S)` 表示数据集 `S` 的信息熵

- `p_i` 表示数据集 `S` 中第 `i` 类样本的概率

### 示例

考虑一个二分类数据集,其中目标变量有 "是" 和 "否" 两类。数据集的样本分布如下:

| 样本 | 目标变量 |

|---|---|

| 1 | 是 |

| 2 | 是 |

| 3 | 否 |

| 4 | 否 |

该数据集的信息熵为:

```python

H(S) = -((1/4) * log2(1/4) + (1/4) * log2(1/4) + (1/4) * log2(1/4) + (1/4) * log2(1/4)) = 2

```

现在,我们使用特征 "年龄" 划分数据集。年龄小于 30 岁的样本被分配到子集 `S1`,年龄大于或等于 30 岁的样本被分配到子集 `S2`。

子集 `S1` 的样本分布如下:

| 样本 | 目标变量 |

|---|---|

| 1 | 是 |

| 2 | 是 |

子集 `S2` 的样本分布如下:

| 样本 | 目标变量 |

|---|---|

| 3 | 否 |

| 4 | 否 |

子集 `S1` 的信息熵为:

```python

H(S1) = -((1/2) * log2(1/2) + (1/2) * log2(1/2)) = 1

```

子集 `S2` 的信息熵为:

```p

```

0

0