CART决策树参数调优秘诀:提升模型性能的必备技巧

发布时间: 2024-08-21 00:08:13 阅读量: 66 订阅数: 35

ENVI扩展工具-CART决策树分类扩展插件RuleGen

# 1. CART决策树简介

CART决策树(分类与回归树)是一种广泛使用的机器学习算法,用于构建决策树模型。它通过递归地将数据集分割成更小的子集来工作,每个子集由一个特征的特定值定义。通过这种方式,CART决策树可以学习复杂的关系并对新数据进行预测。

CART决策树的构建过程涉及以下步骤:

- **特征选择:**选择一个特征将数据集分割成两个子集,使子集之间的差异最大化。

- **递归分割:**对每个子集重复此过程,直到满足停止条件(例如,达到最大深度或子集大小太小)。

- **生成决策树:**将递归分割的过程可视化为一棵树,其中每个节点代表一个特征,每个分支代表特征的特定值。

# 2. CART决策树参数调优理论基础

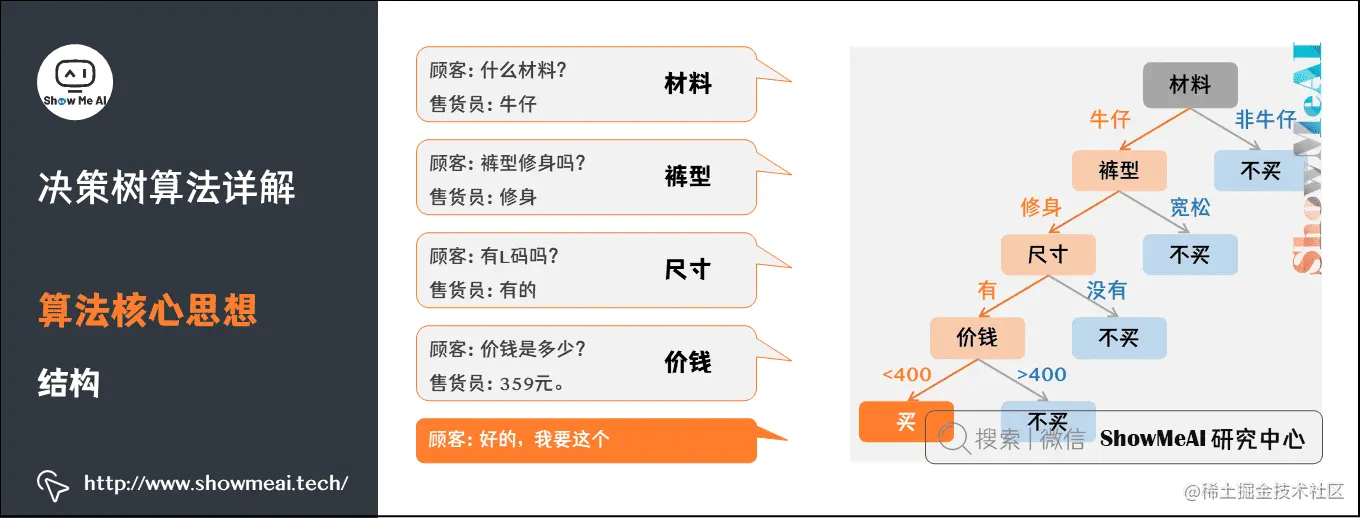

### 2.1 决策树的基本原理

决策树是一种机器学习算法,它使用树形结构来表示决策过程。每个节点代表一个属性,每个分支代表一个可能的决策。决策树通过递归地将数据集划分为更小的子集来构建。

### 2.2 CART决策树的构建过程

CART(分类和回归树)是一种决策树算法,它使用基尼不纯度或信息增益作为分裂准则。CART决策树的构建过程如下:

1. 从根节点开始,将整个数据集分配给该节点。

2. 选择一个分裂属性和分裂点,将数据集划分为两个子集。

3. 对每个子集重复步骤2,直到达到停止条件(例如,达到最大深度或所有样本属于同一类)。

4. 将每个叶节点标记为该叶节点中出现最频繁的类。

### 2.3 决策树的评估指标

决策树的性能通常使用以下指标进行评估:

- **准确率:**正确分类的样本数量与总样本数量之比。

- **召回率:**实际属于某一类的样本中被正确分类的样本数量与实际属于该类的样本总数之比。

- **F1分数:**准确率和召回率的调和平均值。

- **ROC曲线:**真正例率(TPR)与假正例率(FPR)之间的关系曲线。

- **AUC(ROC曲线下面积):**ROC曲线下的面积,表示模型区分正负样本的能力。

**代码块 1:**

```python

import numpy as np

import pandas as pd

from sklearn.tree import DecisionTreeClassifier

# 创建一个示例数据集

data = pd.DataFrame({

'feature1': [1, 2, 3, 4, 5],

'feature2': [6, 7, 8, 9, 10],

'target': [0, 1, 0, 1, 0]

})

# 创建一个决策树模型

model = DecisionTreeClassifier()

# 训练模型

model.fit(data[['feature1', 'feature2']], data['target'])

# 预测新数据

new_data = pd.DataFrame({

'feature1': [1.5, 2.5, 3.5, 4.5, 5.5],

'feature2': [6.5, 7.5, 8.5, 9.5, 10.5]

})

predictions = model.predict(new_data)

# 评估模型

print(f"Accuracy: {model.score(data[['feature1', 'feature2']], data['target'])}")

print(f"F1-score: {model.score(data[['feature1', 'feature2']], data['target'], average='macro')}")

```

**逻辑分析:**

这段代码演示了如何使用Scikit-Learn库构建和评估一个决策树模型。它加载了一个示例数据集,创建了一个决策树分类器,训练模型,并使用新数据对模型进行预测。最后,它打印出模型的准确率和F1分数。

**参数说明:**

- `DecisionTreeClassifier()`: 创建一个决策树分类器。

- `fit()`: 训练模型。

- `predict()`: 对新数据进行预测。

- `score()`: 评估模型的性能。

# 3. CART决策树参数调优实践指南

### 3.1 树的深度和节点数的调优

**树的深度**是指决策树中从根节点到最深叶节点的路径长度。**节点数**是指决策树中所有节点的总和。

**调优目标:**

* 避免过拟合:树的深度和节点数过大容易导致过拟合。

* 提高模型泛化能力:适当的树的深度和节点数可以提高模型在未知数据集上的预测性能。

**调优方法:**

* **交叉验证:**使用交叉验证来评估不同树的深度和节点数对模型性能的影响。

* **贪心搜索:**从一个较小的树开始,逐步增加树的深度和节点数,直到模型性能达到最佳。

* **正则化:**使用正则化项惩

0

0