对抗训练在生物识别安全中的应用:防止欺骗攻击

发布时间: 2024-08-20 01:13:11 阅读量: 23 订阅数: 22

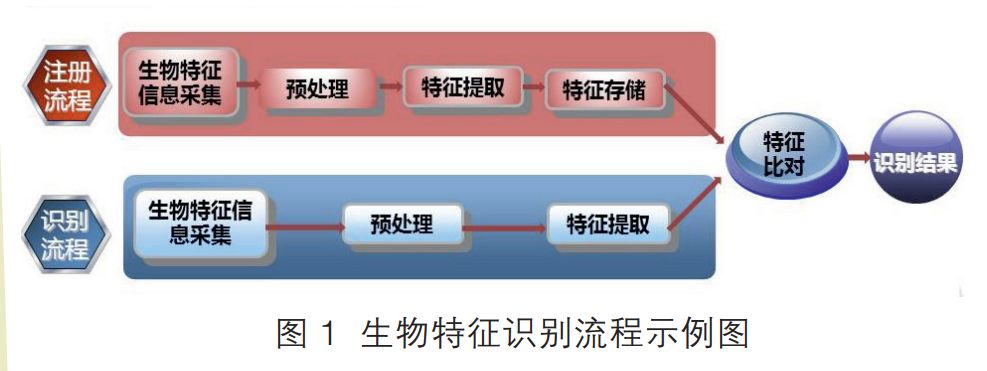

# 1. 生物识别安全概述

生物识别技术在身份验证和访问控制中发挥着至关重要的作用,因为它利用个人的独特生理或行为特征进行身份识别。然而,随着人工智能和机器学习技术的不断发展,生物识别系统面临着新的安全威胁,即对抗攻击。

对抗攻击利用精心设计的输入数据(对抗样本)来欺骗生物识别系统,使其将非授权用户识别为授权用户。这些对抗样本可能通过添加或移除某些特征、改变特征的顺序或强度等方式生成。对抗攻击对生物识别系统的安全构成严重威胁,因为它可能导致身份盗窃、欺诈和未经授权的访问。

# 2. 对抗训练的基本原理

### 2.1 对抗样本的概念和生成方法

**对抗样本**是指经过精心设计的输入数据,它可以欺骗机器学习模型做出错误的预测。对于生物识别系统,对抗样本可以是精心制作的人脸图像或指纹,它们可以绕过系统的安全措施并获得未经授权的访问。

对抗样本的生成方法有多种,其中最常见的是**快速梯度符号法(FGSM)**。FGSM通过计算模型损失函数的梯度,然后沿梯度方向对输入数据进行微小的扰动来生成对抗样本。其他生成对抗样本的方法包括**迭代 FGSM(IFGSM)**、**深度卷积生成对抗网络(DCGAN)**和**遗传算法**。

### 2.2 对抗训练的算法和技术

对抗训练是一种机器学习技术,旨在提高模型对对抗样本的鲁棒性。对抗训练通过向模型中引入对抗样本作为训练数据来实现。在训练过程中,模型学习识别和对抗对抗样本,从而提高其对真实世界攻击的鲁棒性。

对抗训练的算法有多种,其中最常见的是**对抗训练生成对抗网络(GAN)**。GAN 是一种生成模型,它可以生成与真实数据难以区分的对抗样本。在对抗训练中,GAN 被用作数据增强技术,为模型提供额外的对抗样本进行训练。

其他对抗训练算法包括**对抗性正则化**、**对抗性损失**和**对抗性数据增强**。这些算法通过修改模型的损失函数或训练数据来提高模型的鲁棒性。

**代码块:**

```python

import tensorflow as tf

# 定义模型

model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 定义损失函数

loss_fn = tf.keras.losses.SparseCategoricalCrossen

```

0

0