对抗训练在深度学习中的妙用:提升模型鲁棒性和泛化能力

发布时间: 2024-08-20 00:55:50 阅读量: 67 订阅数: 31

如何提高NLP模型鲁棒性和泛化能力?对抗训练论文综述.rar

# 1. 对抗训练概述

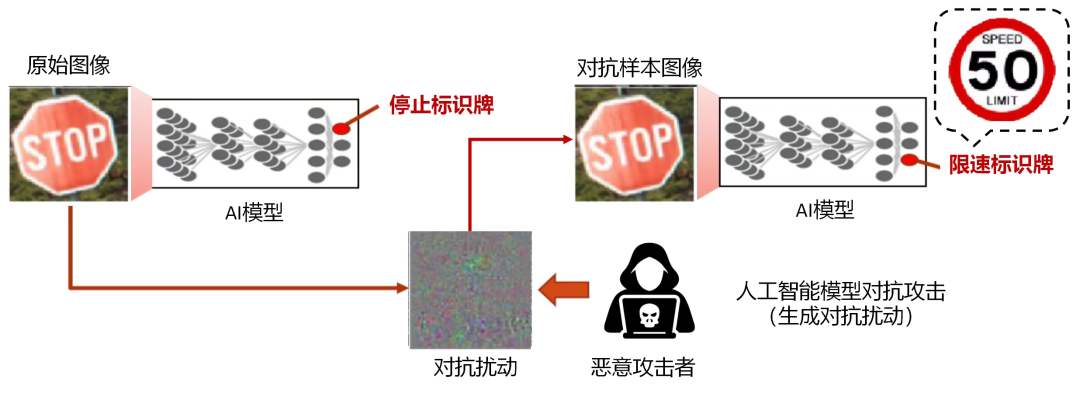

对抗训练是一种机器学习技术,旨在提高模型对对抗样本的鲁棒性。对抗样本是经过精心设计的输入,旨在欺骗机器学习模型,使其产生错误的预测。

对抗训练通过引入对抗样本到训练数据中来实现,迫使模型学习对抗样本的特征并调整其决策边界。通过这种方式,模型可以提高其对对抗样本的抵抗力,从而提高其在现实世界中的泛化能力。

# 2.1 对抗样本的生成机制

对抗样本是经过精心设计的输入,旨在欺骗机器学习模型,使其做出错误的预测。生成对抗样本的方法有多种,每种方法都利用了模型的特定弱点。

**1. 梯度上升法**

梯度上升法是生成对抗样本最常用的方法之一。该方法通过计算模型预测的梯度,然后沿着梯度方向对输入进行微小的扰动,逐步生成对抗样本。扰动的方向是使模型预测的损失函数最大化的方向。

```python

import numpy as np

import tensorflow as tf

# 定义模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(10, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 定义输入数据

x = np.array([[0.1, 0.2, 0.3, 0.4, 0.5]])

# 定义目标类别

y_target = np.array([1])

# 生成对抗样本

epsilon = 0.01

for i in range(100):

with tf.GradientTape() as tape:

tape.watch(x)

y_pred = model(x)

loss = tf.keras.losses.categorical_crossentropy(y_target, y_pred)

gradient = tape.gradient(loss, x)

x += epsilon * gradient

# 打印对抗样本

print(x)

```

**逻辑分析:**

* 该代码使用梯度上升法生成对抗样本。

* `epsilon`参数控制扰动的幅度。

* 循环迭代 100 次,每次沿着损失函数的梯度方向对输入进行扰动。

* 最终生成的 `x` 是对抗样本,它与原始输入非常相似,但会使模型做出错误的预测。

**2. 快速梯度符号法 (FGSM)**

FGSM 是梯度上升法的简化版本。它通过一次性沿着模型预测的梯度方向对输入进行扰动来生成对抗样本。

```python

import numpy as np

import tensorflow as tf

# 定义模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(10, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 定义输入数据

x = np.array([[0.1, 0.2, 0.3, 0.4, 0.5]])

# 定义目标类别

y_target = np.array([1])

# 生成对抗样本

epsilon = 0.01

gradient = tf.gradients(model(x), x)[0]

x_adv = x + epsilon * np.sign(gradient)

# 打印对抗样本

print(x_adv)

```

**逻辑分析:**

* FGSM 只执行一次梯度上升步骤。

* `np.sign()` 函数将梯度转换为二值掩码,其中正梯度为 1,负梯度为 -1。

* `x_adv` 是对抗样本,它与原始输入非常相似,但会使模型做出错误的预测。

**3. 投影梯度符号法 (PGD)**

PGD 是 FGSM 的扩展,它通过多次迭代梯度上升步骤来生成对抗样本。每次迭代都使用投影操作将对抗样本限制在允许的扰动范围内。

```python

import numpy as np

import tensorflow as tf

# 定义模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(10, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 定义输入数据

x = np.array([[0.1, 0.2, 0.3, 0.4, 0.5]])

# 定义目标类别

y_target = np.array([1])

# 生成对抗样本

epsilon = 0.01

num_iterations = 10

x_adv = x.copy()

for i in range(num_iterations):

gradient = tf.gradients(model(x_adv), x_adv)[0]

x_adv = x_adv + epsilon * np.sign(gradient)

x_adv = np.clip(x_adv, x - epsilon, x + epsilon)

# 打印对抗样本

print(x_adv)

```

**逻辑分析:**

* PGD 重复执行 FGSM 步骤 `num_iterations` 次。

* `np.clip()` 函数将对抗样本限制在允许的扰动范围内。

* `x_adv` 是对抗样本,它与原始输入非常相似,但会使模型做出错误的预测。

# 3. 对抗训练的实践应用

对抗训练的理论基础为其在实际应用中提供了坚实的基础。在本章节中,我们将探讨对抗训练在图像分类和自然语言处理任务中的具体应用,并分析其

0

0