GAN文本生成与翻译:解锁自然语言处理新境界

发布时间: 2024-08-20 00:39:12 阅读量: 26 订阅数: 22

# 1. GAN文本生成概述**

**1.1 GAN简介**

生成对抗网络(GAN)是一种深度学习模型,由生成器和判别器两个网络组成。生成器负责生成新数据,而判别器负责区分生成的数据和真实数据。GAN通过对抗训练,让生成器生成越来越逼真的数据,而判别器则越来越难以区分生成的数据和真实数据。

**1.2 GAN在文本生成中的应用**

GAN在文本生成领域有着广泛的应用,包括:

* **文本摘要:**生成简洁明了的文本摘要,提取文本中的关键信息。

* **文本翻译:**将一种语言的文本翻译成另一种语言,实现跨语言交流。

* **文本增强:**生成与原始文本相似的文本,用于数据增强和模型训练。

# 2. GAN文本生成技术

### 2.1 生成式对抗网络原理

#### 2.1.1 生成器网络

生成器网络是一个神经网络,其目标是生成逼真的文本样本。它接收一个随机噪声向量作为输入,并输出一个文本序列。生成器网络的架构通常是一个多层神经网络,其中每一层都由一个激活函数(如 ReLU 或 Leaky ReLU)和一个线性变换组成。

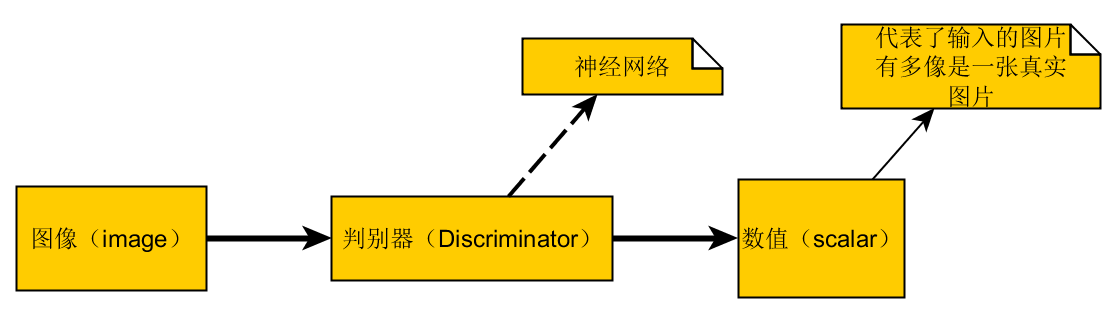

#### 2.1.2 判别器网络

判别器网络是一个神经网络,其目标是区分真实文本样本和生成器网络生成的文本样本。它接收一个文本序列作为输入,并输出一个二元分类结果(真实或虚假)。判别器网络的架构通常是一个多层神经网络,其中每一层都由一个激活函数(如 sigmoid 或 softmax)和一个线性变换组成。

### 2.2 GAN文本生成模型

#### 2.2.1 Seq2Seq GAN

Seq2Seq GAN是一种GAN模型,用于生成文本序列。它由一个编码器网络、一个解码器网络和一个判别器网络组成。编码器网络将输入文本序列编码为一个固定长度的向量,解码器网络将向量解码为一个新的文本序列,判别器网络则区分真实文本序列和生成的文本序列。

**代码块:**

```python

import torch

import torch.nn as nn

class Seq2SeqGAN(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim):

super(Seq2SeqGAN, self).__init__()

self.encoder = nn.LSTM(vocab_size, hidden_dim, num_layers=2)

self.decoder = nn.LSTM(hidden_dim, vocab_size, num_layers=2)

self.discriminator = nn.Linear(hidden_dim, 1)

def forward(self, x):

x = self.encoder(x)

x = self.decoder(x)

x = self.discriminator(x)

return x

```

**逻辑分析:**

* `encoder`网络将输入文本序列编码为一个固定长度的向量。

* `decoder`网络将向量解码为一个新的文本序列。

* `discriminator`网络区分真实文本序列和生成的文本序列。

#### 2.2.2 Transformer GAN

Transformer GAN是一种GAN模型,用于生成文本序列。它由一个编码器网络、一个解码器网络和一个判别器网络组成。编码器网络将输入文本序列转换为一个序列表示,解码器网络将序列表示转换为一个新的文本序列,判别器网络则区分真实文本序列和生成的文本序列。

**代码块:**

```python

import torch

import torch.nn as nn

class TransformerGAN(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, num_heads):

super(TransformerGAN, self).__init__()

self.encoder = nn.TransformerEncoder(nn.TransformerEncoderLayer(d_model=embedding_dim, nhead=num_heads), num_layers=6)

self.decoder = nn.TransformerDecoder(nn.TransformerDecoderLayer(d_model=embedding_dim, nhead=num_heads), num_layers=6)

self.discriminator = nn.Linear(embedding_dim, 1)

```

0

0