模型验证的绝对重要性:如何确保你的模型不是空中楼阁

浅谈数据分析在企业管理中的重要性.doc

1. 模型验证的基础和必要性

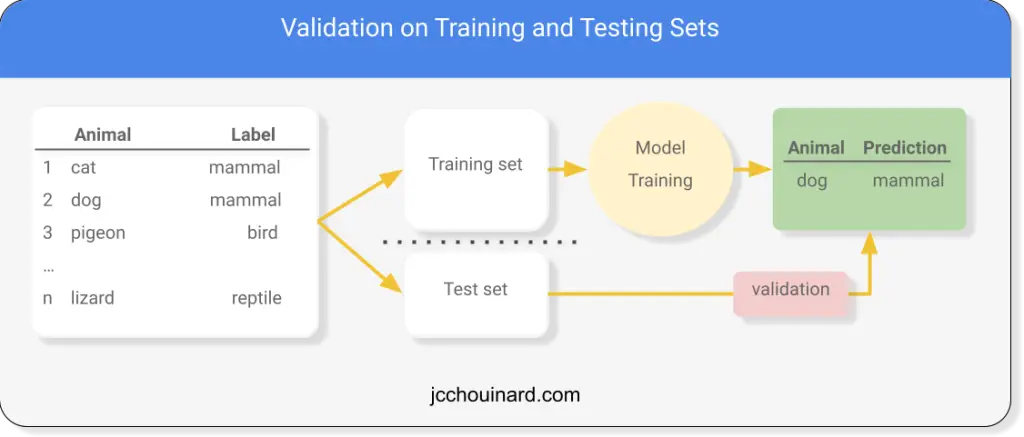

模型验证是数据科学领域中确保模型质量的核心步骤,它对提高模型的预测准确性以及保证模型在真实世界应用中的有效性和可靠性至关重要。验证流程能够帮助我们识别和校正模型偏差,评估模型的泛化能力,并且为模型选择提供数据支持。因此,无论是在学术研究还是实际的商业应用中,模型验证都扮演着不可或缺的角色。

接下来,我们将深入探讨模型验证的理论框架,包括其基本概念、验证方法论,以及模型误差的分解与分析。这些内容为我们深入理解和实施模型验证提供了必要的理论基础。

2. 模型验证的理论框架

2.1 模型验证的基本概念

2.1.1 定义和目标

模型验证是数据分析和机器学习领域的一个核心环节,它确保了一个模型在实际应用中的可靠性和有效性。在定义上,模型验证是指对模型预测准确度的评估过程,确保模型对于未知数据的表现符合预期。目标是识别并最小化模型在新数据上的预测误差,包括偏差(Bias)和方差(Variance)。

模型验证的实践目标是多方面的:

- 准确性评估:确定模型的预测性能是否达到业务或研究的标准。

- 稳健性测试:检验模型在不同数据集上的性能是否稳定。

- 偏差分析:识别并减少由于数据收集、处理或模型训练过程中引入的系统性误差。

为了达到这些目标,模型验证需要综合考虑多种评估方法和技术,包括但不限于交叉验证、自助法和误差分析。

2.1.2 验证的重要性

模型验证的重要性不可小觑,尤其是在需要高度精确预测的领域,如金融、医疗和安全等领域。验证过程通过以下方式对模型的可靠性和适用性提供保证:

- 提高预测准确性:通过在独立的测试数据集上评估模型性能,可以识别模型是否过度拟合训练数据集,从而提升模型泛化能力。

- 保障结果的可信度:用户或决策者通常需要通过模型验证来建立对模型预测结果的信任。

- 发现问题和改进方向:验证过程揭示模型可能存在的问题,如过拟合或欠拟合,以及通过误差分析指明改进的方向。

模型验证对于数据科学家和机器学习工程师来说,是模型开发流程中不可或缺的一环,它有助于优化模型的性能,并为模型部署和应用提供坚实的基础。

2.2 验证方法论

2.2.1 统计假设检验

统计假设检验是模型验证中的一个基础工具,它涉及到对模型性能的统计推断。在统计学中,一个假设检验通常包括以下步骤:

- 定义假设:明确零假设(H0)和备择假设(H1)。例如,在模型验证中,零假设可能是模型没有预测误差。

- 选择检验统计量:根据数据和假设的性质,选择合适的统计量,如t统计量、卡方统计量等。

- 确定显著性水平:设定一个阈值(α),这通常是0.05或0.01,用于判断拒绝或接受零假设。

- 计算检验统计量的值:使用统计方法和数据计算出检验统计量的观察值。

- 得出结论:根据观察值与阈值的比较结果,决定是否拒绝零假设。

通过假设检验,可以量化模型预测误差的统计显著性,从而决定是否接受模型的预测性能。

2.2.2 交叉验证和自助法

交叉验证和自助法是用于估计模型性能和减少过拟合风险的两种常用技术:

- 交叉验证:最常用的交叉验证技术是k折交叉验证。在k折交叉验证中,数据集被分成k个大小相等的子集。模型在k-1个子集上进行训练,在剩下的一个子集上进行验证,这一过程重复k次,每次使用不同的验证子集。最终的性能评估是基于k次验证的平均表现。代码示例如下:

- from sklearn.model_selection import cross_val_score

- from sklearn.linear_model import LinearRegression

- from sklearn.datasets import make_regression

- # 创建一个回归数据集

- X, y = make_regression(n_samples=100, n_features=20, noise=0.1)

- # 使用线性回归模型进行10折交叉验证

- linreg = LinearRegression()

- scores = cross_val_score(linreg, X, y, cv=10)

- print(f"Mean accuracy: {scores.mean()}")

- 自助法(Bootstrapping):自助法是一种有放回的抽样方法,用于从原始数据集中生成多个替代样本。模型在每个替代样本上进行训练,然后在一个独立的测试集上进行评估。这种方法可以提供模型性能的稳定估计,并有助于估计模型的预测不确定性。

2.3 模型误差的分解与分析

2.3.1 误差来源

模型误差通常可以分为两种主要类型:偏差和方差。理解这两种误差对于设计有效的验证策略至关重要。

- 偏差:指的是模型预测值与真实值之间的平均差异。偏差高通常表明模型过于简单,未能捕捉数据中的关键关系。

- 方差:指的是模型预测值在不同训练集上的一致性。方差高表明模型过于复杂,对训练数据中的随机波动过于敏感。

2.3.2 偏差与方差的权衡

在模型设计时需要在偏差和方差之间进行权衡,这通常被称为偏差-方差权衡(Bias-Variance Trade-off)。过高的偏差或方差都会损害模型的预测性能。模型选择和调整过程中,需要不断在模型复杂度和稳定性之间寻找平衡点。

在权衡过程中,通常的做法是:

- 减少偏差:通过增加模型复杂度,如使用更多的特征或增加模型参数。

- 减少方差:通过引入正则化技术,如L1或L2惩罚项,或使用集成方法,如随机森林或梯度提升树。

偏差和方差的分析对于模型的选择和优化具有指导意义,是模型验证过程中的关键环节。

在下一章节中,我们将深入探讨模型验证的实践操作,如何将上述理论框架应用于实际数据和模型中,以及在实际操作中可能遇到的挑战和解决策略。

3. 模型验证的实践操作

在理解了模型验证的理论基础之后,将这些理论应用到实际操作中是至关重要的一步。本章节将深入探讨模型验证在实践中的操作方式,包括数据预处理和特征工程、模型训练与选择以及验证过程中的实际问题处理。

3.1 数据预处理和特征工程

数据是构建模型的基础,而数据预处理和特征工程是确保模型有效性的关键步骤。在这一部分,我们将细致地了解如何清洗和处理数据,以及如何选择和降维特征,以便为模型训练做好准备。

3.1.1 数据清洗与预处理技术

在机器学习的实践中,数据往往不是干净整洁的。数据清洗是预处理中的首要步骤,旨在识别和处理缺失值、异常值、重复数据等问题。数据清洗的技术包括但不限于填充缺失值、剔除或插值异常值、合并重复记录等。

一个典型的缺失值处理方法是均值填充,代码示例如下:

- import pandas as pd

- from sklearn.impute import SimpleImputer

- # 加载数据集

- df = pd.read_csv('dataset.csv')

- # 简单的均值填充

- imputer = SimpleImputer(strategy='mean')

- df['feature'] = imputer.fit_transform(df[['feature']])

对于异常值的检测和处理,可以采用箱型图方法来识别异常值,然后根据具体情况决定是否剔除或进行其他处理。

数据归一化也是预处理中的重要技术,有助于提高模型的性能。常见的归一化方法包括最小-最大归一化和Z分数标准化。

- from sklearn.preprocessing import MinMaxScaler, StandardScaler

- # 最小-最大归一化

- min_max_scaler = MinMaxScaler()

- df['feature'] = min_max_scaler.fit_transform(df[['feature']])

- # Z分数标准化

- z_score_scaler = StandardScaler()

- df['feature'] = z_score_scaler.fit_transform(df[['feature']])

3.1.2 特征选择和降维方法

特征选择的目的是从原始数据中选择最有代表性的特征子集,以降低模型的复杂度和避免过拟合。特征选择的方法可以分为过滤式、包裹式和嵌入式三种。

过滤式方法根据特征和目标变量之间的统计关系进行选择,例如卡方检验、互信息法等。

包裹式方法通过选择不同的特征子集来训练模型,并使用性能评估指标来评分。

- from sklearn.feature_selection import RFE

- from sklearn.ensemble import RandomForestClassifier

- # 使用随机森林作为评估器进行特征递归选择

- selector = RFE(estimator=RandomForestClassifier(), n_features_to_select=5)

- selector = selector.fit(df.drop('target', axis=1), df['target'])

- selected_columns = df.columns[selector.support_]

嵌入式方法在模型训练过程中进行特征选择,例如L1正则化可以强制系数为0,从而实现特征选择。

降维是另一种特征工程方法,用于将高维数据降至较低维度空间,便于模型学习。主成分分析(PCA)是最常用的降维技术之一。

- from sklearn.decomposition import PCA

- # 使用PCA进行数据降维

- pca = PCA(n_components=2)

- df_reduced = pca.fit_transform(df.drop('target', axis=1))

通过以上预处理和特征工程步骤,可以提高模型的训练效率和准确性。接下来,我们将探讨如何进行模型训练和选择,以及在验证过程中可能遇到的实际问题。

3.2 模型训练与选择

在准备好的数据集上训练模型是机器学习流程中的核心部分。本节将讲解如何选择合适的评估指标以及模型选择的策略和方法。

3.2.1 选择合适的评估指标

选择评估指标是模型训练和验证过程中的关键决策之一,取决于具体的问题类型。对于分类问题,常用的评估指标包括准确率、精确率、召回率和F1分数。对于回归问题,常用的评估指标包括均方误差(MSE)、均方根误差(RMSE)和决定系数(R²)。

- from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, mean_squared_error, r2_score

- # 分类问题评估指标

- accuracy = accuracy_score(y_true, y_pred)

- precision = precision_score(y_true, y_pred)

- recall = recall_score(y_true, y_pred)

- f1 = f1_score(y_true, y_pred)

- # 回归问题评估指标

- mse = mean_squared_error(y_true, y_pred)

- r2 = r2_score(y_true, y_pred)

3.2.2 模型选择的策略和方法

模型选择通常涉及比较不同模型的性能,以找到最适合当前问题的模型。交叉验证是一种重要的模型选择策略,可以避免过拟合并提供更稳定的性能评估。

- from sklearn.model_selection import cross_val_score

- # 使用交叉验证评估模型性能

- cross_val_scores = cross_val_score(model, X, y, cv=5)

模型选择方法可以是基于规则的,如选择具有最高准确率的模型,也可以是基于机器学习的,如网格搜索(GridSearchCV)。

- from sklearn.model_selection import GridSearchCV

- # 设置模型参数

- param_grid = {'n_estimators': [10, 50, 100], 'max_depth': [2, 4, 6]}

- # 使用网格搜索进行模型选择

- grid_search = GridSearchCV(model, param_grid, cv=5)

- grid_search.fit(X, y)

- best_model = grid_search.best_estimator_

通过仔细选择评估指标和模型选择策略,可以确保选出最符合问题需求的模型。模型验证过程中还会遇到一些实际问题,例如过拟合和欠拟合,以及模型的泛化能力测试。我们将在下一小节深入探讨这些问题。

3.3 验证过程中的实际问题

验证过程中会遇到多种实际问题,其中过拟合和欠拟合是最常见的问题。本小节将详细讨论这些问题的原因、诊断和解决方法,以及如何测试模型的泛化能力。

3.3.1 过拟合和欠拟合的诊断

过拟合和欠拟合是模型训练过程中常遇到的问题。过拟合发生在模型在训练数据上表现很好,但在验证数据或测试数据上表现不佳;而欠拟合则是模型在所有数据上表现都不好。

诊断方法包括:

- 使用学习曲线来观察训练和验证误差随着训练样本数量的增加如何变化。

- 比较模型在训练数据和验证数据上的性能。

一个简单的学习曲线示例如下:

3.3.2 模型泛化能力的测试

模型的泛化能力指的是模型对未见数据的处理能力。测试模型泛化能力的常用方法是将数据集分为训练集、验证集和测试集。在模型训练和验证阶段之后,使用测试集来评估模型最终的泛化能力。

- from sklearn.model_selection import train_test_split

- # 分割数据集

- X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

- # 训练模型

- model.fit(X_train, y_train)

- # 使用测试集评估模型

- test_score = model.score(X_test, y_test)

模型验证的实践操作是确保模型有效性的重要步骤,包括数据的预处理、特征工程、模型训练与选择,以及解决实际问题的诊断方法。通过本章的探讨,我们可以获得将理论应用于实践中的详细指导,为构建高效、准确的模型打下坚实基础。

4. 高级模型验证技术

在模型验证领域,技术的深化与拓展是保持其适应性和有效性的关键。本章节将深入探讨模型验证中的复杂场景、可解释性以及最新进展。

4.1 模型验证中的复杂场景

模型验证技术在处理特定类型的数据时需要特别的考虑和方法,特别是时间序列数据和大数据情况下的不平衡数据。

4.1.1 时间序列数据的验证

时间序列数据因其内在的时间相关性而对验证提出了特别的要求。正确处理这种依赖性是确保模型有效性的关键。

- # Python 代码示例:时间序列数据的拆分和验证

- from sklearn.model_selection import TimeSeriesSplit

- # 假设 X, y 为时间序列数据和目标变量

- tscv = TimeSeriesSplit(n_splits=5)

- for train_index, test_index in tscv.split(X):

- X_train, X_test = X[train_index], X[test_index]

- y_train, y_test = y[train_index], y[test_index]

- # 在这里进行模型训练和评估

4.1.2 大数据和不平衡数据的验证

大数据环境下,验证工作往往受到计算资源的限制,同时也经常伴随着数据不平衡的问题,这要求我们采取特别的验证策略。

- # Python 代码示例:使用 SMOTE 进行不平衡数据处理

- from imblearn.over_sampling import SMOTE

- smote = SMOTE()

- X_train_sm, y_train_sm = smote.fit_resample(X_train, y_train)

- # 使用处理后的数据进行模型训练

4.2 模型可解释性和验证

随着机器学习模型变得更加复杂,了解模型决策过程的重要性也日益增加。

4.2.1 解释性模型的重要性

解释性模型不仅帮助我们理解模型的决策,而且是建立模型信任的关键。

- # Python 代码示例:使用 LIME 进行模型解释

- from lime import lime_tabular

- explainer = lime_tabular.LimeTabularExplainer(

- training_data=np.array(X_train),

- feature_names=np.array(feature_names),

- class_names=np.array(class_names),

- mode="classification"

- )

- # 生成一个预测样本的解释

- idx = 10 # 选择一个样本

- exp = explainer.explain_instance(X_test[idx], classifier.predict_proba, num_features=10)

- exp.show_in_notebook(show_all=False)

4.2.2 可解释性方法和工具

目前存在多种工具和技术来提高模型的透明度,例如 LIME(局部可解释模型-不透明模型的解释)、SHAP(SHapley Additive exPlanations)等。

4.3 模型验证的最新进展

在深度学习和自动化技术领域,模型验证技术也在不断进步。

4.3.1 深度学习中的模型验证

深度学习的复杂性使得验证变得更加重要,同时也带来了挑战。例如,评估深度学习模型的泛化能力就需要特殊的策略。

4.3.2 自动化验证框架和工具

自动化验证框架如 Keras Tuner、Ray Tune 等,已经开始支持自动化的模型验证流程。

在本章中,我们讨论了在复杂场景下进行模型验证的技术,介绍了模型可解释性的工具和方法,并探索了自动化验证框架和工具的最新进展。这些内容构成了模型验证领域内一些最前沿的话题,对进一步深化和推动模型验证技术的发展提供了基础。

5. 案例研究和未来展望

5.1 经典案例分析

5.1.1 成功的模型验证案例

在IT界,模型验证的成功案例无疑为整个行业树立了标杆。以机器学习领域的一个经典例子——Google的AlphaGo为例。AlphaGo在围棋界创造历史,成功战胜世界冠军李世石。在这个案例中,模型验证起到了至关重要的作用。

-

验证的准备阶段: 在AlphaGo的训练阶段,团队使用了海量的围棋对局数据来训练模型。同时,通过模拟对弈来调整模型参数,确保模型在面对复杂局面时也能做出正确的判断。

-

验证策略: 使用交叉验证的方式来评估模型的性能,确保结果的稳健性。并且在不同的阶段设置不同的验证集,以评估模型在学习过程中的泛化能力。

-

验证结果: AlphaGo不仅能够在训练数据上做出正确的预测,更重要的是,在从未见过的局面下也能够做出优秀的决策。它的成功验证了模型不仅仅是在“过拟合”已有的对局数据。

通过这个案例我们可以看到,有效的模型验证能够确保AI模型在真实世界中的表现,并且在商业和科研等多个领域推动技术的边界。

5.1.2 模型验证失败的教训

在成功的案例背后,模型验证失败的案例也提供了宝贵的经验教训。一个被广泛讨论的例子是2015年美国退伍军人事务部(VA)采用的预测性分析模型。

-

验证过程的缺失: VA的模型试图预测退伍军人的自杀风险,但实际使用中模型并未得到充分的验证。在模型上线后不久,该系统发出了过多的假警报,导致工作人员无法有效响应真正的危机。

-

问题的根源: 该模型未能通过适当的验证,以测试其在不同人群和环境中的准确性。此外,VA未能考虑模型在实际操作中的可操作性和实用性。

-

教训: 这个案例强调了验证不仅仅需要在模型开发阶段进行,更需要在模型部署后持续进行。因为现实世界的数据和情境比理想化的测试环境要复杂得多。

这个案例告诉我们在模型验证过程中,不仅需要关注模型的技术性能,还需要关注其实际应用中的问题。确保验证过程的全面性,防止在实际应用中出现重大偏差。

5.2 模型验证的未来趋势

5.2.1 模型验证技术的发展方向

随着技术的发展,模型验证技术也在不断进步。未来的发展趋势可以从以下几个方向来看:

-

自动化验证: 随着模型变得越来越复杂,人工进行验证变得越来越不切实际。自动化工具和框架的发展将允许快速而准确地进行模型验证,例如使用持续集成/持续部署(CI/CD)管道中的自动化测试。

-

解释性和可解释性: 机器学习模型的决策过程变得越来越透明化。解释性工具,如LIME和SHAP,将变得越来越普及,允许用户理解模型的预测。

5.2.2 伦理、法律和验证的关联性

模型验证不仅仅是一个技术问题,还涉及伦理和法律的考量。随着人工智能技术的普及,对其决策过程的透明度和可解释性要求将越来越高。

-

伦理合规性: 验证过程中必须确保模型不会因偏差而产生歧视性结果,这要求在数据收集和模型设计阶段就考虑伦理问题。

-

法律责任: 当模型的决策导致问题时,必须能够追溯和验证模型的决策过程。这将需要法律框架来界定责任边界,同时也要求模型验证能够提供足够的证据支持。

总结而言,模型验证是确保人工智能应用可靠性和有效性的关键环节。随着技术的持续发展,我们不仅需要关注技术的进步,还需要思考模型在社会中的应用对伦理和法律的影响。未来的模型验证将会是一个涉及多个学科的综合性领域,它将为人工智能的可持续发展提供保障。