交叉验证的5大技巧:解锁更准确的机器学习模型

发布时间: 2024-09-03 03:47:26 阅读量: 222 订阅数: 72

解锁数据的深层结构:在SPSS中进行因子分析

# 1. 交叉验证概述与基本原理

在模型训练与评估领域,交叉验证(Cross-validation)是一种强大的技术,用于更准确地估计模型在未知数据上的表现。本章将探讨交叉验证的基本概念和核心原理,为理解后续章节的深度理论和实践技巧奠定基础。

## 1.1 交叉验证的定义和优势

交叉验证是一种统计方法,通过将数据集划分为若干个小组(通常是k组),其中一组作为测试集,其余作为训练集。这种方法能够减少模型评估中由于数据集划分带来的随机性,提高对模型性能评估的稳定性。

## 1.2 交叉验证的工作流程

- 将原始数据分为k个大小相等的子集。

- 对于每个子集,依次将它作为测试集,其余的k-1个子集作为训练集。

- 对每个训练集训练模型,并对相应的测试集进行预测。

- 记录每个测试集上的预测结果,最后计算所有结果的平均值,得到最终的性能指标。

## 1.3 交叉验证的应用场景

交叉验证常用于机器学习中的模型选择和模型评估过程,尤其是在数据集较小或模型对初始数据划分敏感时。在实际应用中,它帮助开发者提高对模型泛化能力的信心,确保模型在新数据上的表现稳定可靠。

通过下一章的深入探讨,我们将进一步了解交叉验证的理论基础和不同类型,以及如何在不同数据和问题中应用交叉验证技术。

# 2. 交叉验证的理论基础

## 2.1 交叉验证的概念和重要性

### 2.1.1 模型验证的基本需求

在机器学习领域,模型验证是确保模型泛化能力的关键步骤。一个良好的模型验证流程需要满足几个基本需求。首先,它应该能够提供一个对模型未来表现的无偏估计。这意味着验证集需要与训练集保持一定的独立性,以避免过拟合。其次,模型验证应该尽可能利用所有的数据,这样可以增加模型估计的准确性。交叉验证技术正好满足了这两项需求。

### 2.1.2 交叉验证解决的问题

交叉验证是一种通过将数据集分隔成多个子集,轮流将其中一个子集作为验证集,其余的作为训练集的验证方法。它解决了传统单一划分验证方法的问题,例如留出法可能会受到单次划分随机性的影响。通过多次划分,交叉验证可以减少这种随机性的影响,使得模型的性能评估更加稳定和可靠。

## 2.2 交叉验证的主要类型

### 2.2.1 留出法(Holdout)

留出法是交叉验证中最简单的一种形式。在该方法中,数据集被分成两个不相交的集合:一个较大的集合用于训练模型(训练集),一个较小的集合用于评估模型性能(测试集或验证集)。留出法的一个关键点在于,训练集和验证集的划分应该是随机的,以减少由于特定数据样本的分布不均造成的偏差。

### 2.2.2 k折交叉验证(k-Fold)

k折交叉验证是留出法的扩展,它将数据集分成k个大小相等的子集。在k折交叉验证中,每个子集轮流用作验证集,其余的k-1个子集用作训练集。这将重复k次,每次使用不同的训练集和验证集组合。这样可以更充分地利用数据,并减少结果的方差。k的典型值为5或10。

### 2.2.3 留一法(Leave-One-Out)

留一法是k折交叉验证的一个特例,其中k等于样本数量。这意味着每次验证过程中,只留下一个样本作为验证集,其余的样本用于训练。留一法的计算代价较高,因为它需要训练模型与数据集的大小相同次数。然而,它提供了对模型性能最准确的估计。

## 2.3 交叉验证的性能指标

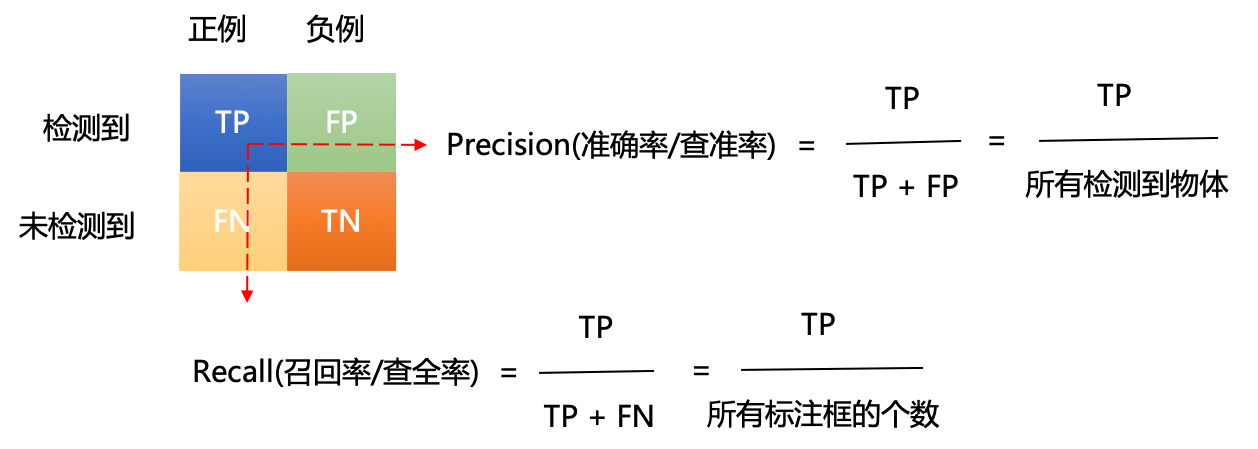

### 2.3.1 准确率、召回率和F1分数

在分类问题中,交叉验证用于评估模型的准确率(正确预测的比例)、召回率(模型成功识别出的正样本比例),以及F1分数(准确率和召回率的调和平均值)。这些指标帮助我们量化模型在不同类别上的表现,尤其适用于处理不平衡数据集。

### 2.3.2 ROC曲线下面积(AUC)

接收者操作特征曲线(ROC)下的面积(AUC)是另一种在分类问题中常用的性能指标。AUC衡量的是模型在不同阈值设置下分类正确率与错误率之间的关系。AUC值越接近1,表明模型的分类性能越好。

### 2.3.3 均方误差(MSE)和R平方(R²)

在回归问题中,我们通常使用均方误差(MSE)和R平方(R²)来衡量模型的预测准确性。MSE度量的是模型预测值与实际值之差的平方的平均值,而R²则提供了模型解释变异性的比例。R²的取值范围为0到1,其中值越接近1表示模型拟合效果越好。

为了进一步阐述交叉验证在模型评估中的应用,下面展示一个k折交叉验证在Python中的使用示例:

```python

import numpy as np

from sklearn.model_selection import KFold

from sklearn.metrics import mean_squared_error

from sklearn.linear_model import LinearRegression

# 创建数据集

X = np.random.rand(100, 1)

y = 2 * X.squeeze() + 0.1 * np.random.randn(100)

# 初始化模型和交叉验证对象

model = LinearRegression()

kf = KFold(n_splits=5)

# 5折交叉验证

for train_index, test_index in kf.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 模型训练

model.fit(X_train, y_train)

# 模型预测

predictions = model.predict(X_test)

# 计算均方误差

mse = mean_squared_error(y_test, predictions)

print(f"Fold MSE: {mse}")

```

在上述代码中,我们首先导入了所需的库和方法。我们创建了一个简单的线性回归问题,并使用5折交叉验证来训练和评估模型。每次迭代中,模型都会在训练集上进行训练,并在测试集上进行预测,随后计算MSE。通过多次迭代,可以得到一个对模型泛化性能的稳定估计。

# 3. 交叉验证的实践技巧

交叉验证不仅仅是一个理论上的概念,更是一种重要的实践技能。在实际应用中,数据科学家和机器学习工程师经常需要面对不同类型的挑战,比如数据不平衡、高维度特征空间以及模型参数调优等问题。本章将重点讨论这些实际问题,并提供相应的技巧和解决方案。

## 针对不平衡数据的交叉验证

在现实世界中,数据不平衡问题非常普遍,尤其在二分类问题中。不平衡数据集意味着在两个类别中的观测数分布不均,这会导致模型倾向于预测出现频率更高的类别,从而忽略了少数类。这种偏差会对交叉验证的效果产生负面影响。

### 重采样技术

在交叉验证过程中,重采样技术是一种常用的方法来处理不平衡数据。常见的重采样技术有两种:过采样少数类和欠采样多数类。其中,过采样可以通过简单地复制少数类的样本或者使用SMOTE(Synthetic Minority Over-sampling Technique)等算法来合成新的少数类样本,以达到平衡数据的目的。

```python

from imblearn.over_sampling import SMOTE

from sklearn.datasets import make_classification

from sklearn.model_selection import cross_val_score

# 生成不平衡数据集

X, y = make_classification(n_classes=2, class_sep=2,

weights=[0.1, 0.9], n_informative=3, n_redundant=1, flip_y=0,

n_features=20, n_clusters_per_class=1, n_samples=1000, random_state=10)

# 初始化SMOTE

sm = SMOTE(random_state=42)

# 应用SMOTE

X_res, y_res = sm.fit_resample(X, y)

# 使用交叉验证和模型

model = ... # 某个机器学习模型

scores = cross_val_score(model, X_res, y_res, cv=5)

print("Cross-validation scores for resampled dataset: ", scores)

```

通过上述代码,我们首先创建了一个不平衡的数据集,然后使用SMOTE技术来生成新的样本以平衡数据。最后,我们用交叉验证来评估模型的性能。

### 权重调整

除了重采样技术外,还可以通过给少数类赋予更高的权重来处理不平衡数据。在一些算法中,比如逻辑回归和SVM,可以通过调整`class_weight`参数来实现。这种方法不需要改变原始数据,而是通过惩罚错误分类少数类的代价,来引导模型更加关注少数类。

```python

from sklearn.linear_model import LogisticRegression

# 初始化逻辑回归模型,设置class_weight参数

model = LogisticRegression(class_weight='balanced')

# 使用交叉验证

scores = cross_val_score(model, X, y, cv=5)

print("Cross-validation scores for weighted logistic regression: ", scores)

```

在上述示例中,我们使用了逻辑回归模型,并将`class_weight`参数设置为`balanced`,这意味着模型会自动调整权重,以减少少数类的分类误差。

## 高维度数据的交叉验证

在许多实际问题中,尤其是涉及生物信息学或文本分析的任务,特征的数量往往远远大于样本数量。这种高维度数据可能导致模型过拟合和计算上的挑战。

### 特征选择

特征选择是解决高维度问题的重要策略。通过选择与目标变量最相关的特征,可以减少模型复杂度并提高模型的泛化能力。常见的特征选择方法包括递归特征消除(Recursive Feature Elimination,RFE)和基于模型的方法如随机森林的特征重要性。

```python

from sklearn.feature_selection import RFECV

from sklearn.ensemble import RandomForestClassifier

# 假定X为特征集,y为目标变量

X = ... # 特征集

y = ... # 目标变量

# 初始化随机森林模型

forest = RandomForestClassifier()

# 应用RFECV进行特征选择

selector = RFECV(estimator=forest, step=1, cv=5)

selector = selector.fit(X, y)

# 输出最优特征数量和被选中的特征索引

print("Optimal number of features : %d" % selector.n_features_)

print("Selected features : %s" % selector.support_)

```

上述代码展示了如何使用RFECV结合随机森林来选择特征,这不仅减少了特征数量,还通过交叉验证来确保选取的特征集的泛化性能。

### 正则化方法

正则化技术,如L1(Lasso)和L2(Ridge)惩罚项,可以在训练模型的同时减少过拟合的风险。这种方法在特征空间非常高维时非常有用,因为它能够在模型训练过程中自动进行特征选择。

```python

from sklearn.linear_model import LogisticRegressionCV

# 初始化L1正则化的逻辑回归模型,并通过交叉验证选择最佳的正则化强度

model = LogisticRegressionCV(cv=5, penalty='l1', solver='liblinear', max_iter=100)

# 使用交叉验证

scores = cross_val_score(model, X, y, cv=5)

print("Cross-validation scores for Logistic Regression with L1 penalty: ", scores)

```

在这段代码中,我们使用了`LogisticRegressionCV`,它在交叉验证中同时寻找最佳的正则化参数和特征子集。L1正则化通过引入系数的绝对值作为惩罚项,能够输出稀疏的系数矩阵,从而实现特征选择。

## 参数调优与模型选择

在构建机器学习模型时,模型参数的选择对于最终性能的影响至关重要。交叉验证是评估不同参数设置和选择最佳模型的有力工具。

### 网格搜索(Grid Search)

网格搜索是一种穷举搜索方法,通过遍历预定义的参数值来找到最佳的模型配置。这种方法虽然计算密集,但可以确保我们不会错过任何可能的最佳组合。

```python

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

# 定义参数网格

parameters = {'kernel':('linear', 'rbf'), 'C':[1, 10]}

# 初始化支持向量机模型

svc = SVC()

# 应用网格搜索和交叉验证

clf = GridSearchCV(svc, parameters, cv=5)

clf.fit(X, y)

# 输出最佳参数和得分

print("Best parameters set found on development set: ", clf.best_params_)

print("Grid scores on development set: ", clf.cv_results_)

```

上述代码展示了如何使用`GridSearchCV`来评估SVM的不同核函数和正则化参数C的组合。通过交叉验证,我们能够找到最优的参数组合。

### 随机搜索(Random Search)

与网格搜索不同,随机搜索不会尝试所有参数组合,而是从指定的分布中随机选择参数,这种方法在参数空间较大时更高效。通过随机搜索,我们可以更快地找到接近最优的参数组合。

```python

from sklearn.model_selection import RandomizedSearchCV

from scipy.stats import expon, reciprocal

# 定义参数分布

params_dist = {

'kernel': ['linear', 'rbf'],

'C': reciprocal(1, 10),

'gamma': expon(scale=1.0)

}

# 初始化支持向量机模型

svc = SVC()

# 应用随机搜索和交叉验证

clf = RandomizedSearchCV(svc, params_dist, n_iter=10, cv=5)

clf.fit(X, y)

# 输出最佳参数和得分

print("Best parameters set found on development set: ", clf.best_params_)

print("Randomized search scores on development set: ", clf.cv_results_)

```

在上述代码中,我们使用了`RandomizedSearchCV`来评估SVM的参数,并通过随机搜索从指定的参数分布中选择最佳组合。

### 贝叶斯优化

贝叶斯优化是一种更加智能的参数调优方法,它基于贝叶斯原理来构建一个概率模型,然后利用这个模型来选择那些最有可能改进目标函数的参数设置进行测试。与网格搜索和随机搜索相比,贝叶斯优化通常需要更少的迭代就能找到最佳参数。

```python

from skopt import BayesSearchCV

from sklearn.svm import SVC

from skopt.space import Real, Categorical, Integer

# 定义参数空间

param_space = {

'C': Real(1e-6, 1e+6, prior='log-uniform'),

'gamma': Real(1e-6, 1e+1, prior='log-uniform'),

'kernel': Categorical(['linear', 'rbf', 'poly'])

}

# 初始化支持向量机模型

svc = SVC()

# 应用贝叶斯搜索和交叉验证

clf = BayesSearchCV(svc, param_space, n_iter=32, random_state=0, cv=5)

clf.fit(X, y)

# 输出最佳参数和得分

print("Best parameters found on development set: ", clf.best_params_)

print("Bayes search scores on development set: ", clf.cv_results_)

```

上述示例中,我们使用了`BayesSearchCV`来进行贝叶斯优化搜索,这通常需要更少的迭代次数来找到最佳参数,且每次迭代都需要评估不同参数组合的模型性能。

通过上述几个小节,本章节展示了针对不同挑战的交叉验证实践技巧。无论是处理不平衡数据、高维特征空间,还是进行模型参数调优,交叉验证都是不可或缺的工具。在后续的章节中,我们将进一步探讨交叉验证的高级策略和实战案例分析。

# 4. 优化交叉验证的高级策略

在前几章我们已经了解了交叉验证的概念、重要性以及在实践中的各种应用。本章我们将深入探讨在特定场景下,如何优化交叉验证策略以提升模型性能和评估的准确性。

## 4.1 时间序列数据的交叉验证

时间序列数据因其内在的时序相关性,使得交叉验证变得复杂。以下是两种常用的时间序列交叉验证方法:

### 4.1.1 时间分割方法

时间分割方法根据时间序列的时间戳来分割数据。这种技术将数据分成几个连续的时间块,以保证数据的时序特性不受影响。一个常见的方法是将数据分割为训练集和测试集,其中测试集为最近的时间段。这种方法在股票价格预测、天气预报等任务中非常有用。

#### *.*.*.* 操作步骤

1. 对数据按时间排序。

2. 根据时间戳选择分割点,划分训练集和测试集。

3. 在训练集上训练模型。

4. 在测试集上评估模型性能。

#### *.*.*.* 代码逻辑解释

以下是一个简单的代码示例,展示如何使用Python进行时间分割方法的交叉验证。

```python

from sklearn.model_selection import TimeSeriesSplit

# 假设我们有一个时间序列数据集df

df = # ... 加载或生成时间序列数据 ...

# 划分训练集和测试集

tscv = TimeSeriesSplit(n_splits=5)

for train_index, test_index in tscv.split(df):

train, test = df.iloc[train_index], df.iloc[test_index]

# 在train上训练模型...

# 在test上评估模型...

```

在代码中,`TimeSeriesSplit`类用于生成训练和测试的索引。通过迭代,我们可以获得不同的训练集和测试集划分。

### 4.1.2 滚动时间窗口

滚动时间窗口方法同样适用于时间序列数据,该方法在每次迭代中都向前滚动窗口以产生新的训练和测试集。

#### *.*.*.* 操作步骤

1. 选择一个初始窗口大小和步长。

2. 在选定的时间窗口内训练模型,并在窗口外测试模型。

3. 移动窗口,重复步骤2直到达到数据集的末尾。

#### *.*.*.* 代码逻辑解释

下面的代码段展示了如何实现滚动时间窗口的交叉验证。

```python

def rolling_window_cv(df, window_size, step_size):

train_indices = []

test_indices = []

for i in range(0, len(df) - window_size, step_size):

train_indices.append(df.iloc[i:i+window_size].index)

test_indices.append(df.iloc[i+window_size:i+window_size+step_size].index)

for train_idx, test_idx in zip(train_indices, test_indices):

train, test = df.loc[train_idx], df.loc[test_idx]

# 在train上训练模型...

# 在test上评估模型...

rolling_window_cv(df, window_size=100, step_size=1)

```

在上面的函数中,`df`是时间序列数据集,`window_size`是窗口大小,`step_size`是滚动的步长。函数计算出训练集和测试集的索引,并输出以供模型训练和评估使用。

## 4.2 分组交叉验证和多层次交叉验证

在某些数据集中,可能存在一些特定的分组,比如同一家人或同一地理位置的数据点,这些数据点之间的相似性可能比其他数据点更高。此时,就需要特殊的交叉验证策略。

### 4.2.1 分组交叉验证的概念

分组交叉验证(Grouped k-fold)是一种特殊的交叉验证方法,它保证每个折中不会出现重复的分组。这种技术适用于个体水平的重复测量或相似数据点的聚类情况。

#### *.*.*.* 操作步骤

1. 确定分组依据,例如,每个小组可能代表一个个体或一组具有相关特征的个体。

2. 使用分组交叉验证方法,确保每个折的训练集和测试集中不包含同一组内的个体。

3. 在每个折上训练模型,并在相应的测试集上进行评估。

#### *.*.*.* 代码逻辑解释

以下是一个分组交叉验证的示例代码,使用scikit-learn库中的GroupKFold。

```python

from sklearn.model_selection import GroupKFold

# 假设我们有分组数据df和对应的group标签

groups = df['group'].values

# GroupKFold交叉验证

group_kfold = GroupKFold(n_splits=5)

for train_index, test_index in group_kfold.split(df, groups=groups):

train, test = df.iloc[train_index], df.iloc[test_index]

# 在train上训练模型...

# 在test上评估模型...

```

在上述代码中,`GroupKFold`是scikit-learn库提供的一个类,用于执行分组交叉验证。我们通过迭代生成训练集和测试集的索引,并用它们来训练和评估模型。

### 4.2.2 多层次交叉验证的应用场景

多层次交叉验证是针对具有自然层次结构的数据进行的交叉验证,如医院病历记录、多中心临床试验等。该方法旨在评估模型在多个层面(如医院、医生、患者)上的稳健性。

#### *.*.*.* 操作步骤

1. 确定数据集的层次结构。

2. 为每个层次设计交叉验证方案,通常是从最高层开始。

3. 在每个层次上执行交叉验证,确保在模型训练和测试中考虑到所有层次。

#### *.*.*.* 代码逻辑解释

多层次交叉验证通常需要复杂的逻辑处理,下面展示一个简化的示例。

```python

def nested_cross_validation多层次(df):

for hospital in df['hospital'].unique():

df_hospital = df[df['hospital'] == hospital]

# 对每个医院的数据执行交叉验证

# ...

# 假设df包含hospital字段

nested_cross_validation多层次(df)

```

在这个示例中,我们先按医院分组,然后对每个组内的数据进行交叉验证。这确保了在医院之间进行测试的同时,内部还进行了模型训练和评估。

## 4.3 蒙特卡洛交叉验证

蒙特卡洛交叉验证是一种随机化的交叉验证技术,它通过随机选择测试集来改进交叉验证的稳定性。

### 4.3.1 蒙特卡洛方法简介

蒙特卡洛方法基于概率和统计理论,通过随机抽样来求解数值问题。在交叉验证中使用蒙特卡洛方法,可以克服数据集划分的偶然性带来的偏差。

#### *.*.*.* 操作步骤

1. 确定交叉验证的次数,例如,进行100次交叉验证。

2. 在每次交叉验证中随机划分训练集和测试集。

3. 使用测试集评估模型性能,并计算平均性能指标。

#### *.*.*.* 代码逻辑解释

以下是一个蒙特卡洛交叉验证的示例代码。

```python

import numpy as np

def monte_carlo_cv(X, y, model, n_splits=100):

scores = []

for _ in range(n_splits):

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

model.fit(X_train, y_train)

score = model.score(X_test, y_test)

scores.append(score)

return np.mean(scores), np.std(scores)

# 假设X和y是我们要交叉验证的数据和标签

# model是我们的模型实例

mean_score, std_score = monte_carlo_cv(X, y, model, n_splits=100)

```

在这个代码中,我们使用了`train_test_split`函数随机划分数据,并记录了每次迭代的性能评分。最后,我们计算了平均评分和标准差,作为模型稳定性的指标。

### 4.3.2 蒙特卡洛交叉验证的实际应用

蒙特卡洛交叉验证的一个主要优势在于其灵活性和结果的稳健性。它特别适用于大数据集和复杂模型的评估。由于其随机特性,它能减少由于数据划分方式不同而导致的性能波动。

#### *.*.*.* 实际应用案例

在金融风险评估或客户流失预测等场景中,数据量往往很大,数据分布复杂,传统的交叉验证方法可能不足以全面评估模型的泛化能力。蒙特卡洛交叉验证在这种情况下更为适用,因为它能够更全面地探索模型在不同数据集上的表现。

## 本章小结

在本章中,我们探讨了针对特定数据类型和复杂场景下的交叉验证高级策略。我们学习了时间序列数据的交叉验证方法、分组交叉验证以及蒙特卡洛交叉验证。这些方法能够帮助我们在更加复杂和实际的应用中,提升模型的评估质量和结果的可靠性。在下一章中,我们将通过实战案例,进一步展示如何应用这些策略来评估和优化机器学习模型。

# 5. 交叉验证的实战案例分析

## 5.1 使用交叉验证评估模型性能

### 5.1.1 实际数据集的处理

在使用交叉验证评估模型性能时,数据集的处理尤为关键。实际数据集通常包含噪声、缺失值和异常值,这会直接影响模型的性能评估。因此,在应用交叉验证之前,需要对数据进行彻底的清洗和预处理。

数据清洗包括删除重复的记录、填充或删除缺失值、识别和处理异常值。在数据预处理阶段,常用的方法包括数据标准化、归一化和特征编码。例如,在处理信用卡交易数据时,会将日期时间转换为星期几、一天中的时段等更有意义的特征,以帮助模型捕捉到时间序列中的模式。

### 5.1.2 不同模型的比较

在不同模型间进行性能比较是交叉验证的常见用途。我们以两个模型A和B为例,通过交叉验证来评估它们在特定数据集上的表现。首先,设定交叉验证的折数,例如5折交叉验证,然后重复以下步骤多次(这里以5次为例):

1. 将数据集随机分为5份。

2. 选择其中一份作为验证集,剩余四份作为训练集。

3. 在训练集上训练模型A和模型B。

4. 在验证集上评估模型A和模型B的性能。

5. 记录模型的性能指标,如准确率、召回率和F1分数等。

最后,统计每个模型在所有折数上的性能指标,通过计算平均值和标准差来对比模型A和模型B的总体表现。下面是一个简单的Python代码示例,展示如何使用交叉验证比较模型:

```python

from sklearn.model_selection import cross_val_score

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.svm import SVC

# 生成模拟数据集

X, y = make_classification(n_samples=1000, n_features=20, n_informative=2, n_redundant=10, random_state=42)

# 定义两个模型

modelA = LogisticRegression()

modelB = SVC()

# 5折交叉验证

cross_val_scores_A = cross_val_score(modelA, X, y, cv=5, scoring='accuracy')

cross_val_scores_B = cross_val_score(modelB, X, y, cv=5, scoring='accuracy')

print(f"Model A Accuracy: {cross_val_scores_A.mean():.2f} +/- {cross_val_scores_A.std():.2f}")

print(f"Model B Accuracy: {cross_val_scores_B.mean():.2f} +/- {cross_val_scores_B.std():.2f}")

```

在上述代码中,我们使用了`cross_val_score`函数来进行交叉验证,通过设置`cv=5`实现5折交叉验证。通过比较不同模型的平均准确率和标准差,我们可以判断哪个模型在该数据集上表现更为稳定和优秀。

## 5.2 应用交叉验证解决实际问题

### 5.2.1 信用卡欺诈检测

信用卡欺诈检测是一个典型的二分类问题。在这个案例中,使用交叉验证可以帮助我们选择一个最合适的模型,并优化其参数以提高检测的准确性。首先,我们需要一个包含历史交易数据的数据集,这些数据包括交易金额、时间、商家类别、用户历史行为等信息。

在实际操作中,我们需要进行特征工程,例如提取时间特征、编码类别特征等。之后,应用交叉验证来评估不同算法的性能,如逻辑回归、随机森林或神经网络等。通过交叉验证,我们可以确定最佳模型,并根据交叉验证结果调整模型参数,以进一步提高模型对欺诈交易的检测率。

### 5.2.2 医学诊断预测

在医学诊断预测中,交叉验证用于评估预测模型的可靠性,以确保模型在不同患者群体上的泛化能力。假设我们有一个关于某疾病的预测模型,这个模型基于患者的一系列生理和生化指标,如血压、胆固醇水平、血糖等。

在此案例中,我们将交叉验证应用于数据集,以评估模型对新患者的诊断准确性。这有助于医疗专家选择最准确、最可靠的模型。使用交叉验证还可以评估模型在面对不同性别、年龄和种族的患者时的表现差异,从而为个性化医疗提供依据。

## 5.3 交叉验证的常见问题与误区

### 5.3.1 过度拟合的风险

交叉验证虽然是一种强大的工具,但也有其局限性。其中,过度拟合是一个常见的问题。过度拟合发生在模型在训练集上表现良好,但在验证集(或测试集)上表现不佳的情况下。在使用交叉验证时,如果模型过于复杂或训练数据太少,模型可能会学习到训练数据中的噪声而非其底层分布,导致过度拟合。

为避免过度拟合,可以通过以下策略:

- 简化模型,比如限制决策树的深度。

- 使用正则化方法,如L1或L2正则化。

- 增加数据量,使模型有更多样化的样本学习。

### 5.3.2 计算成本的考虑

虽然交叉验证能够提供更稳定的性能评估,但其计算成本通常也比简单的单次分割验证要高。在大数据集上或在模型训练开销很大的情况下,使用交叉验证可能会非常耗时。

为了在计算成本和评估准确性之间取得平衡,可以采用以下方法:

- 使用部分样本进行交叉验证,而不是使用全部数据。

- 在初步模型选择阶段使用单次划分验证,然后仅在选定的最佳模型上应用交叉验证。

- 利用并行计算资源,通过并行化处理来减少总体计算时间。

在实际应用中,计算成本和准确性之间的权衡取决于具体问题的需求和可用资源。理解交叉验证的这些常见问题和误区,可以帮助我们更合理地使用这一技术,从而在实际项目中取得更好的效果。

# 6. 交叉验证未来的发展趋势

随着机器学习和人工智能领域的迅猛发展,交叉验证方法也在不断地演变和进化。本章将探讨未来交叉验证可能出现的新趋势和研究方向,以及它在AI领域的应用前景。

## 6.1 新兴交叉验证方法的研究

### 6.1.1 自适应交叉验证技术

传统的交叉验证方法如k折交叉验证是预先设定参数的,它可能无法适应数据集的内在特性。自适应交叉验证技术试图通过算法自动选择最佳的交叉验证参数,以适应特定数据集的特性。

自适应技术的一个重要研究方向是模型选择时能够动态调整k值或保留数据集的比例。例如,可以设计一种算法,根据数据集的大小和特征分布来动态设定k的值,从而找到最佳的泛化能力。代码示例如下:

```python

from sklearn.model_selection import KFold

def adaptive_k_fold(X, y, min_k, max_k):

"""

根据数据集特性自适应选择k值的交叉验证方法

:param X: 特征数据集

:param y: 目标变量

:param min_k: 最小的k值

:param max_k: 最大的k值

:return: 最佳k值的交叉验证结果

"""

# 这里只是概念性代码,实际实现需要根据数据集特性进行复杂的计算和选择。

# ...

pass

```

### 6.1.2 基于深度学习的交叉验证策略

深度学习模型具有高度的参数复杂性,传统的交叉验证方法可能无法充分评估其性能。研究者们正在探索针对深度学习模型的交叉验证策略,比如在每次迭代中调整神经网络的超参数,或者结合贝叶斯优化等高级技术进行模型调优。

一种可能的方法是将交叉验证与神经网络的权重更新结合,通过动态地在不同的数据子集上调整模型参数来提升模型的泛化能力。该策略的伪代码如下:

```python

def deep_learning_cv(X, y, model, loss_function, optimizer, epochs, num_folds):

"""

基于深度学习的交叉验证策略

:param X: 特征数据集

:param y: 目标变量

:param model: 深度学习模型

:param loss_function: 损失函数

:param optimizer: 优化器

:param epochs: 训练的轮数

:param num_folds: 折数

:return: 验证结果

"""

# 这里省略了具体的训练和验证过程,实际实现需要根据深度学习框架进行。

# ...

pass

```

## 6.2 交叉验证在AI领域的应用前景

### 6.2.1 交叉验证在深度学习中的挑战

深度学习的模型通常需要大量的数据和计算资源来进行训练和验证。如何高效地利用交叉验证来评估深度学习模型的性能,同时控制计算成本,是当前研究的一个重大挑战。

另一个挑战是如何处理深度学习模型的超参数空间。由于深度学习模型具有大量的超参数,传统的参数搜索方法可能不够高效。因此,研究者们正在探索新的优化算法,例如基于元学习的参数搜索策略,来快速找到最佳的模型配置。

### 6.2.2 交叉验证与强化学习结合的可能性

在强化学习中,评估一个策略的好坏通常需要在实际环境中进行大量的试错,这使得交叉验证的应用变得复杂。然而,学者们也在考虑将交叉验证的思想引入到强化学习的评估过程中,通过在训练过程中模拟不同的环境变化来评估策略的稳健性。

通过使用模拟环境进行交叉验证,可以在不大幅增加实际交互成本的前提下,对策略进行有效的评估。这要求构建能够模拟现实复杂性的高质量环境,以及能够捕捉策略性能的关键指标。

交叉验证的未来充满了无限的可能性。随着技术的进步,我们有理由相信交叉验证方法会继续进化,更好地服务于机器学习和人工智能领域的发展。

0

0