深度学习模型压缩技术:如何在保持性能的同时减小模型体积

发布时间: 2024-09-03 04:40:27 阅读量: 123 订阅数: 77

深度学习模型压缩与加速综述.pdf

# 1. 深度学习模型压缩技术概述

随着深度学习技术的快速发展,模型的规模和计算需求也在不断增加。这不仅对硬件资源提出了更高要求,而且限制了深度学习模型在资源受限环境中的应用。深度学习模型压缩技术应运而生,旨在通过各种算法和策略来减小模型大小、降低计算复杂度,同时尽可能保持模型性能。

## 模型压缩的需求和意义

在移动设备和边缘计算等场景中,对模型的体积和运算速度有更高的要求。模型压缩技术通过消除冗余信息、简化模型结构和近似运算等方式,使得复杂模型能够在这些平台上有效运行,满足实时性和功耗等限制条件。

## 模型压缩技术的分类

模型压缩技术主要分为以下几类:

- **模型剪枝**:识别并去除神经网络中的冗余参数。

- **知识蒸馏**:将大模型的知识转移到小模型中,使得小模型能近似大模型的性能。

- **低秩分解和参数共享**:通过分解高维参数矩阵来降低模型复杂度。

- **量化与二值化**:通过减少参数和激活值的精度来减小模型体积。

模型压缩技术不仅能够减轻硬件负担,还能提升模型的泛化能力和运行速度,为深度学习技术的广泛应用提供了可能。接下来的章节将详细介绍这些压缩技术的理论基础、实践操作以及案例研究。

# 2. 模型剪枝技术

## 2.1 剪枝的理论基础

### 2.1.1 剪枝的概念及其对模型性能的影响

在深度学习模型压缩的众多技术中,剪枝技术是最早被提出并广泛应用的一种。剪枝技术的核心思想是去除神经网络中的冗余参数和结构,即剪掉对模型性能影响最小的权重和神经元,从而达到减少模型复杂度、提升计算效率的目的。

剪枝技术对于模型性能的影响是双向的。一方面,合理的剪枝可以在不损失太多模型精度的情况下,显著减少模型大小和计算量,从而加速模型的推理速度,降低存储和传输要求。另一方面,如果剪枝操作过于激进,可能会导致重要信息的丢失,使得模型性能下降。因此,找到剪枝的“临界点”非常关键,这就需要对剪枝的参数和策略进行精细的调整。

### 2.1.2 剪枝的关键参数和剪枝策略

剪枝的关键参数通常包括剪枝率、剪枝方式(如权重剪枝、神经元剪枝)、剪枝步骤和剪枝策略。剪枝率直接决定了剪枝后模型的稀疏程度,即模型中被剪枝掉的参数占比。剪枝方式则会影响剪枝后的模型结构。剪枝策略包括了迭代剪枝、一次性剪枝、基于门控的剪枝等等。

不同的剪枝策略各有优劣。例如,迭代剪枝可以在每一步中更细致地调整剪枝比例,有利于找到更好的性能与复杂度的平衡点。而一次性剪枝则实现简单,对模型的快速部署比较有利。

## 2.2 剪枝的实践操作

### 2.2.1 实际的剪枝流程和步骤

剪枝的实践操作流程可以分为几个关键步骤:

1. **模型训练:** 首先需要有一个训练好的、性能满足要求的模型。

2. **剪枝标准设定:** 设定剪枝的阈值和剪枝比例。

3. **权重或神经元的排序:** 对模型的权重或神经元进行重要性排序,重要性可以通过梯度大小、权重大小、激活值等指标来衡量。

4. **剪枝:** 根据排序结果去除不重要的权重或神经元。

5. **模型微调:** 对剪枝后的模型进行微调,以恢复因剪枝而损失的性能。

6. **重复剪枝与微调:** 重复上述步骤,直到达到所需的剪枝率或者模型性能不再提升。

### 2.2.2 剪枝算法的比较和选择

剪枝算法的选择取决于多种因素,如模型的类型、剪枝的目标、资源的限制等。一些常用的剪枝算法包括随机剪枝、基于阈值的剪枝、敏感度分析剪枝、优化器辅助的剪枝和基于L1/L2范数的剪枝等。每种方法都有其特定的应用场景和优缺点。例如,基于敏感度的剪枝通常能找到更有效的剪枝点,但计算成本较高。而L1范数剪枝则容易实现并且计算效率较高。

在选择剪枝算法时,应考虑如下因素:

- 模型的复杂性:对于更复杂的模型,可能需要更精细的剪枝算法。

- 可接受的性能损失:不同的算法会对模型性能产生不同程度的影响。

- 资源限制:剪枝的执行时间和计算资源是实际操作中需要考虑的重要因素。

- 实现的简易度:简易的算法更容易集成到现有的工作流程中。

### 2.2.3 使用现有工具进行模型剪枝

现有的一些深度学习框架和库提供了剪枝的功能,方便用户直接使用。例如,TensorFlow的Model Optimization Toolkit和PyTorch的Pruning Tutorial等。下面是一个使用PyTorch进行权重剪枝的简单示例代码:

```python

import torch

import torch.nn.utils.prune as prune

# 假设已经有一个训练好的模型 model

model = ...

# 使用L1范数剪枝,剪枝比例设为20%

prune.l1_unstructured(model, name='weight', amount=0.2)

# 打印剪枝后的模型结构

prune.print_model.prune(model, format='1')

# 微调剪枝后的模型

# optimizer = torch.optim.SGD(model.parameters(), ...)

# for epoch in range(num_epochs):

# optimizer.zero_grad()

# output = model(input)

# loss = criterion(output, target)

# loss.backward()

# optimizer.step()

```

以上代码展示了如何使用PyTorch的Pruning工具对模型进行剪枝操作,并设置L1范数的剪枝比例为20%。

## 2.3 剪枝案例研究

### 2.3.1 典型模型剪枝案例分析

在本案例中,我们将分析一个使用迭代剪枝对AlexNet进行剪枝的案例。首先,通过设置一个初始的剪枝比例开始迭代剪枝。在每一轮迭代中,移除一部分权重后,对模型进行微调,以保证模型的精度。通过逐步增加剪枝比例,最终达到目标剪枝率。

### 2.3.2 剪枝效果评估与性能对比

在完成剪枝后,我们需要对模型的性能进行评估,主要评估指标包括:

- **精度保留:** 剪枝后模型与原始模型在相同数据集上的准确率对比。

- **模型大小:** 剪枝后模型的参数数量和模型文件大小。

- **推理速度:** 在同一硬件上,剪枝后模型的推理时间对比。

通过一系列的实验验证,我们发现,在剪枝率不超过30%的情况下,模型的精度下降非常有限,同时模型大小和推理速度有了明显的改善。这验证了剪枝技术在优化深度学习模型性能方面的有效性。

以上是模型剪枝技术的详细章节内容,接下来我们将继续探讨深度学习模型压缩的其他关键方法。

# 3. 知识蒸馏技术

## 3.1 知识蒸馏的理论基础

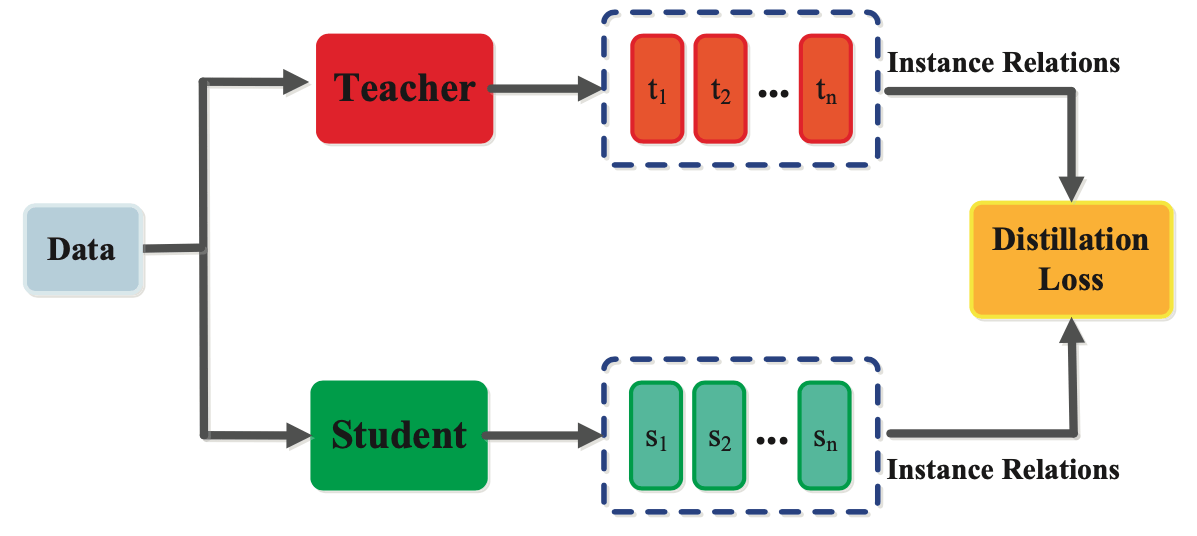

知识蒸馏是一种模型压缩技术,主要通过迁移一个大型、预训练好的深度神经网络(教师模型)的知识到一个小型、轻量级的网络(学生模型)中。这种技术的关键在于,学生模型通过模仿教师模型的输出,学习到教师模型的泛化能力和预测能力。

### 3.1.1 知识蒸馏的概念和原理

知识蒸馏的概念最初由Hinton等人在2015年提出。其原理是利用大型模型在训练过程中产生的软标签(soft labels),即输出层的类概率分布信息,来训练小型模型。软标签能够提供比硬标签(hard labels,即one-hot编码)更丰富的信息,使得小型模型在训练过程中能更好地模拟大型模型的行为,提升自身性能。

蒸馏过程中,除了考虑训练数据的真实标签之外,还将大型模型输出的软标签作为额外的监督信息来指导小型模型的训练。这有助于学生模型捕捉到教师模型的深层知识,如类别之间的关系和相似性。

### 3.1.2 蒸馏过程中损失函数的选择与设计

损失函数在知识蒸馏过程中起到了关键作用。传统的交叉熵损失函数只利用了硬标签,而在知识蒸馏中,损失函数需要结合软标签和硬标签。通常采用的损失函数形式如下:

```

L = α * L_{hard} + (1 - α) * L_{soft}

```

这里,L_{hard} 是传统的交叉熵损失,而 L_{soft} 是指包含软标签信息的损失项,α 是平衡两者的权重参数。通过调整 α 参数,可以控制蒸馏过程中软标签和硬标签的相对重要性。

在设计蒸馏损失函数时,必须考虑如何更好地融合教师模型的知识。比如,使用温度扩展(temperature scaling)的方法来平滑软标签的分布,有助于引导学生模型学习到更准确的类别概率。

## 3.2 知识蒸馏的实践操作

知识蒸馏操作涉及将知识从教师模型转移到学生模型的具体步骤,包括选择合适的网络架构、选择蒸馏策略、设置温度参数等。

### 3.2.1 实际的蒸馏过程和步骤

实际的蒸馏过程包括以下步骤:

1. **预训练教师模型**:首先使用大量数据预训练一个性能良好的大型模型作为教师模型。

2. **生成软

0

0