POSIX线程同步在Python中的实现:锁与条件变量的深入解析

发布时间: 2024-10-13 08:09:23 阅读量: 35 订阅数: 23

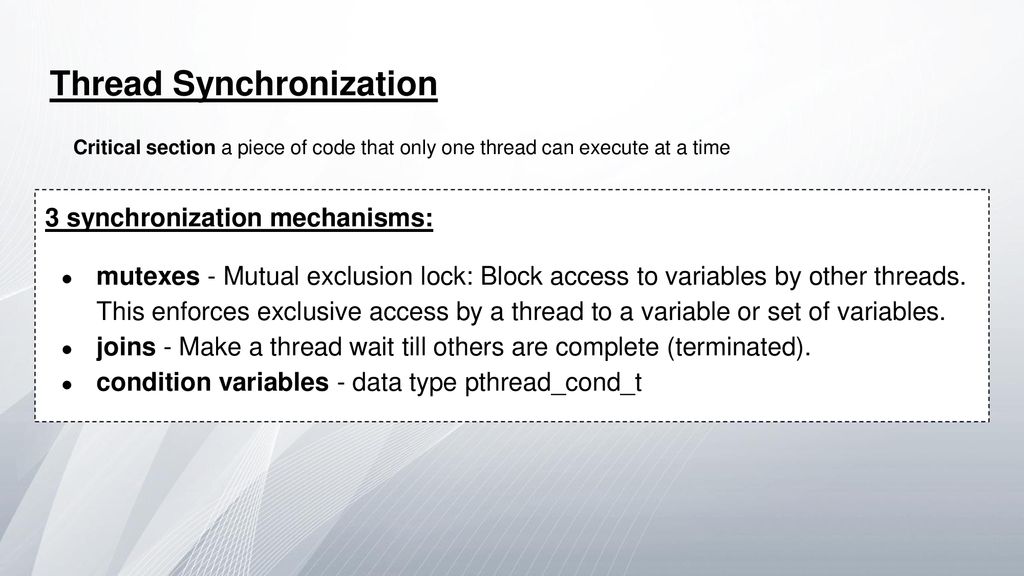

# 1. POSIX线程同步的概念和重要性

在多线程编程中,同步是确保数据一致性、避免竞态条件和资源冲突的关键技术。POSIX线程(通常称为Pthreads)提供了多种同步机制,这些机制对于编写健壮的多线程应用程序至关重要。本章将深入探讨POSIX线程同步的基本概念,包括互斥锁(mutexes)、条件变量(condition variables)等,并解释它们在多线程环境中的重要性。

## 1.1 什么是线程同步?

线程同步是指在多线程程序中,控制多个线程访问共享资源的顺序,确保数据的一致性和完整性。没有同步机制,多个线程可能会同时访问和修改同一资源,导致不可预测的行为和数据损坏。

### 1.1.1 同步机制的目的

同步机制的主要目的是控制对共享资源的访问,防止竞态条件。通过锁定共享资源,确保在任何时刻只有一个线程可以对其进行操作。

### 1.1.2 同步机制的重要性

正确的同步机制可以避免数据竞争,保证线程安全,这对于构建可靠的应用程序至关重要。它还有助于提高程序的性能和稳定性,避免资源冲突和死锁。

通过本章的学习,我们将了解POSIX线程同步机制的基本概念,为后续章节中使用Python实现和应用这些概念打下坚实的基础。

# 2. Python中的线程同步工具

### 2.1 Python的threading模块基础

#### 2.1.1 threading模块的引入和线程的创建

在本章节中,我们将深入探讨Python中的线程同步工具,首先从threading模块的基础开始。threading模块是Python中用于多线程编程的核心模块,它提供了许多函数和类来支持线程的创建和管理。通过本章节的介绍,我们将学习如何引入threading模块以及如何创建和启动线程。

在Python中,线程的创建通常通过继承`threading.Thread`类并重写其`run`方法来实现。以下是一个简单的例子,展示了如何创建和启动一个线程:

```python

import threading

# 定义一个继承自Thread的类

class MyThread(threading.Thread):

def run(self):

print(f"{self.name} is running")

# 创建一个线程实例

t = MyThread()

# 启动线程

t.start()

```

在这个例子中,我们定义了一个名为`MyThread`的类,它继承自`threading.Thread`。在`run`方法中,我们打印出线程的名称和状态。然后我们创建了一个`MyThread`的实例`t`,并调用`start`方法来启动线程。

#### 2.1.2 线程的基本操作和状态

线程一旦启动,就会进入一个运行状态,直到它的`run`方法执行完毕。Python的threading模块还提供了多种方法来操作线程,例如:

- `join()`:等待线程结束

- `name`:获取或设置线程的名称

- `ident`:获取线程的标识符

线程的状态可以通过`threading.enumerate()`函数获取,它会返回一个包含当前所有活动线程的列表。

```python

# 获取当前所有线程

threads = threading.enumerate()

for thread in threads:

print(f"Thread name: {thread.name}, State: {thread.state}")

```

这段代码将打印出所有活动线程的名称和状态。线程的状态包括`NEW`, `RUNNABLE`, `BLOCKED`, `WAITING`, `TIMED_WAITING`, 和`TERMINATED`。

### 2.2 锁在Python中的实现和应用

#### 2.2.1 锁的基本概念和类型

在多线程编程中,锁是一种用于线程同步的基本工具,它确保在任何时刻只有一个线程可以访问共享资源。Python提供了两种类型的锁:

- `threading.Lock`:基本的锁定机制

- `threading.RLock`:可重入锁,允许同一个线程多次获取锁

通过本章节的介绍,我们将学习如何使用这些锁来避免竞态条件和解决同步问题。

```python

import threading

# 创建一个锁

lock = threading.Lock()

# 创建一个线程函数,尝试获取锁

def thread_function(name):

with lock:

print(f"{name} has the lock")

# 创建线程并启动

t1 = threading.Thread(target=thread_function, args=("Thread-1",))

t2 = threading.Thread(target=thread_function, args=("Thread-2",))

t1.start()

t2.start()

t1.join()

t2.join()

```

在这个例子中,我们创建了一个`thread_function`函数,它尝试获取锁并打印线程名称。然后我们创建了两个线程`t1`和`t2`,并启动它们。

#### 2.2.2 锁的获取和释放

锁的获取是通过`acquire`方法实现的,释放则是通过`release`方法。为了避免忘记释放锁,推荐使用`with`语句,因为它可以自动管理锁的获取和释放。

```python

# 获取锁

lock.acquire()

try:

# 临界区

print("Lock acquired by thread:", threading.current_thread().name)

finally:

# 释放锁

lock.release()

```

在这个例子中,我们使用`acquire`和`release`方法来获取和释放锁。`with`语句确保即使在临界区发生异常时锁也能被正确释放。

#### 2.2.3 死锁的避免和处理

死锁是指两个或多个线程互相等待对方释放锁,从而导致程序挂起的情况。为了避免死锁,可以采用以下策略:

- 尽量减少锁的数量

- 使用锁的顺序获取

- 设置超时时间

通过本章节的介绍,我们将学习如何识别和处理死锁。在实际应用中,死锁的检测通常需要依赖于外部工具或调试技巧。

# 3. POSIX线程同步的Python实践

在本章节中,我们将深入探讨如何在Python中实践POSIX线程同步。我们将通过具体的代码示例和案例分析,展示如何使用锁和条件变量来解决线程同步问题,并讨论如何进行错误处理和性能优化。

## 3.1 使用锁解决同步问题

### 3.1.1 共享资源的竞争条件示例

在多线程编程中,共享资源的竞争条件是一个常见的问题。当多个线程同时访问和修改同一个资源时,如果没有适当的同步机制,可能会导致数据不一致和不可预期的结果。

#### 示例代码:

```python

import threading

# 共享资源

shared_resource = 0

# 访问共享资源的函数

def access_shared_resource():

global shared_resource

temp = shared_resource

# 模拟资源处理过程中的延迟

threading.Event().wait(0.1)

shared_resource = temp + 1

# 创建线程列表

threads = []

for i in range(10):

thread = threading.Thread(target=access_shared_resource)

threads.append(thread)

thread.start()

# 等待所有线程完成

for thread in threads:

thread.join()

print(f'最终的共享资源值为: {shared_resource}')

```

#### 逻辑分析:

在这个示例中,我们创建了一个全局变量 `shared_resource` 作为共享资源,并定义了一个函数 `access_shared_resource` 来模拟对共享资源的访问。我们创建了10个线程,每个线程都会尝试增加共享资源的值。由于没有同步机制,我们可能会观察到不同的结果,因为线程可能会在资源处理过程中被调度器中断。

### 3.1.2 锁的实践应用和案例分析

为了防止竞争条件,我们可以使用锁(Lock)来同步对共享资源的访问。锁可以保证在任何时刻只有一个线程能够执行被锁保护的代码段。

#### 锁的应用代码:

```python

import threading

# 共享资源

shared_resource = 0

lock = threading.Lock()

# 访问共享资源的函数

def access_shared_resource():

global shared_resource

with lock:

temp = shared_resource

# 模拟资源处理过程中的延迟

threading.Event().wait(0.1)

shared_resource = temp + 1

# 创建线程列表

threads = []

for i in range(10):

thread = threading.Thread(target=access_shared_resource)

threads.append(thread)

thread.start()

# 等待所有线程完成

for thread in threads:

thread.join()

print(f'最终的共享资源值为: {shared_resource}')

```

#### 逻辑分析:

在这个修正后的代码中,我们引入了 `threading.Lock()` 对象 `lock`。在 `access_shared_resource` 函数中,我们使用 `with` 语句来确保在执行关键代码段时获取锁。这样,即使线程在处理过程中被中断,也不会有其他线程能够访问共享资源,直到当前线程释放锁。

### 3.1.3 死锁的避免和处理

在使用锁的过程中,一个常见的问题是死锁。死锁发生在一个线程等待一个永远不会被释放的锁时。

#### 死锁避免和处理代码示例:

```python

import threading

# 定义资源和锁

resource_a = 0

resource_b = 0

lock_a = threading.Lock()

lock_b = threading.Lock()

# 访问资源A的函数

def access_resource_a():

global resource_a

with lock_a:

threading.Event().wait(0.1)

resource_a += 1

# 访问资源B的函数

def access_resource_b():

global resource_b

with lock_b:

threading.Event().wait(0.1)

resource_b += 1

# 创建线程列表

threads_a = []

threads_b = [

```

0

0