Spark数据库分布式计算:大数据处理的利器

发布时间: 2024-07-24 09:45:46 阅读量: 41 订阅数: 26

# 1. Spark数据库分布式计算概述**

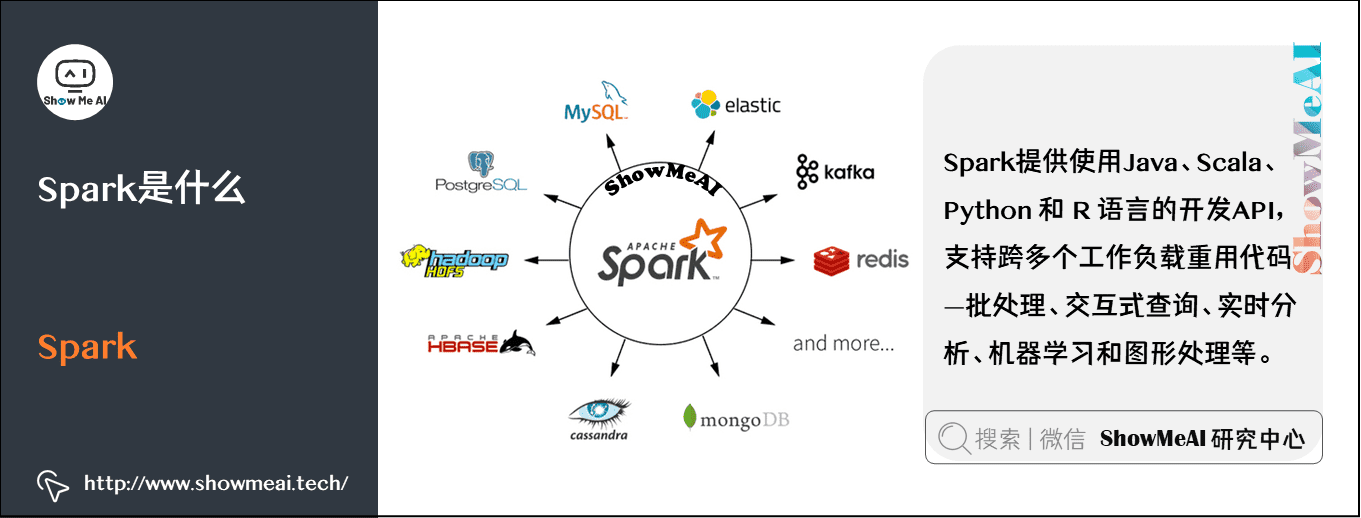

Spark是一种分布式计算框架,专为处理大规模数据集而设计。它利用集群中的多个节点来并行处理数据,从而显著提高计算效率。

Spark的优势在于其易于使用、可扩展性和容错性。它提供了一个统一的编程接口,允许开发人员使用熟悉的语言(如Scala、Python、Java)编写分布式程序。此外,Spark的弹性分布式数据集(RDD)抽象使数据处理变得简单高效。

# 2. Spark数据库分布式计算原理

### 2.1 Spark架构和组件

Spark是一个分布式计算框架,它提供了对大规模数据集进行快速高效处理的能力。Spark架构由多个组件组成,每个组件负责处理特定任务。

#### 2.1.1 Spark Core

Spark Core是Spark框架的核心组件,它提供了分布式计算的基础设施。它负责任务调度、内存管理和容错处理。

#### 2.1.2 Spark SQL

Spark SQL是一个基于Spark Core构建的模块,它提供了对结构化数据的支持。它允许用户使用SQL查询和操作数据,并支持多种数据源,如Hive、Parquet和JSON。

#### 2.1.3 Spark Streaming

Spark Streaming是一个用于处理实时数据的模块。它提供了一个流式处理引擎,允许用户从各种来源(如Kafka、Flume和Twitter)摄取数据并对其进行处理。

### 2.2 Spark数据处理流程

Spark数据处理流程通常涉及以下步骤:

#### 2.2.1 数据读写

Spark可以通过各种连接器从多种数据源读取数据,包括文件系统(如HDFS、S3)、数据库(如MySQL、PostgreSQL)和流式数据源(如Kafka)。它还支持将数据写入各种目标,包括文件系统、数据库和流式数据源。

#### 2.2.2 数据转换

Spark提供了丰富的转换操作,允许用户对数据进行各种操作,如过滤、映射、分组、连接和聚合。这些操作可以以分布式方式执行,从而提高处理效率。

#### 2.2.3 数据聚合

Spark支持各种聚合函数,允许用户对数据进行汇总和分析。这些函数包括求和、求平均值、求最大值和求最小值。Spark还支持窗口函数,允许用户对数据进行分组和聚合,并根据时间或其他条件进行计算。

### 代码示例

以下代码示例演示了如何使用Spark Core、Spark SQL和Spark Streaming进行数据处理:

```scala

// Spark Core

val spark = SparkSession.builder().appName("Spark Example").master("local").getOrCreate()

// Spark SQL

val df = spark.read.json("data.json")

df.show()

// Spark Streaming

val streamingDf = spark.readStream.format("kafka").option("kafka.bootstrap.servers", "localhost:9092").option("subscribe", "test-topic").load()

streamingDf.writeStream.outputMode("append").format("console").start().awaitTermination()

```

### 参数说明

* `appName`:Spark应用程序的名称。

* `master`:Spark应用程序运行的模式(如本地模式或集群模式)。

* `data.json`:要读取的JSON文件路径。

* `test-topic`:要订阅的Kafka主题名称。

* `outputMode`:流式数据写入模式(如追加模式或完全模式)。

* `format`:流式数据写入格式(如控制台格式或文件格式)。

### 逻辑分析

* Spark Core负责创建Spark应用程序并管理分布式计算。

* Spark SQL使用DataFrame API来查询和操作结构化数据。

* Spark Streaming使用流式处理引擎来处理实时数据。

* 数据读取操作使用连接器从数据源读取数据

0

0