【概率分布精要】:掌握随机事件的数学规律与数据分析密钥

发布时间: 2024-11-22 10:52:28 阅读量: 24 订阅数: 31

VTK开发精要:数据结构与管线机制

# 1. 概率分布的基本概念

概率分布是描述随机变量取值规律的数学模型,在统计学和数据分析领域占有核心地位。理解概率分布,首先要了解随机变量的概念,它是指其取值具有不确定性的变量。按照取值的性质,随机变量分为离散型和连续型两种。离散型随机变量可取有限个或可数无限多个值,其概率分布通常用概率质量函数(PMF)来描述;而连续型随机变量则在一定区间内可取任何值,其概率分布则通过概率密度函数(PDF)来表达。

概率分布不仅在理论上建立了数据的随机性结构,而且在实际应用中,如市场调研、质量控制、风险评估和生物统计等领域,都有着广泛的应用。它能够帮助我们预测事件发生的可能性,以及如何对数据进行合理解释和决策支持。

在本章的后续部分,我们将进一步探讨概率分布的基本性质,以及如何通过概率分布对随机现象进行建模和分析。这为后续章节中对不同类型的概率分布及其应用的深入讨论打下坚实的基础。

# 2. 常见离散型概率分布

### 2.1 二项分布

#### 二项分布的定义与性质

二项分布是概率论中非常基本且广泛应用于实际问题的离散型概率分布之一。它描述了在固定次数的独立实验中,成功次数的概率分布,其中每一次实验的成功概率是固定的。二项分布具有两个参数:试验次数 \(n\) 和每次试验成功的概率 \(p\)。

数学表达式如下:

\[ P(X = k) = \binom{n}{k} p^k (1-p)^{n-k} \]

这里,\(X\) 表示成功次数,\(k\) 是成功次数的具体取值,\(\binom{n}{k}\) 表示从 \(n\) 次实验中选择 \(k\) 次成功的组合数。二项分布图形呈现为以期望值 \(np\) 为中心的对称或偏态曲线,具体形状取决于 \(p\) 的大小。

二项分布的一些重要性质包括:

1. 期望值和方差:\(E(X) = np\),\(Var(X) = np(1-p)\)

2. 只能取整数值,即 \(k = 0, 1, 2, ..., n\)

3. 若 \(n = 1\),则二项分布退化为伯努利分布

### 实践中的应用:质量控制

二项分布广泛应用于质量控制领域,用于描述产品生产过程中的合格品比例问题。考虑一个简单的例子:一个工厂生产灯泡,每只灯泡合格的概率是 \(p\)。我们需要计算生产 100 只灯泡时,恰好有 90 只合格的概率。

```python

import scipy.stats as stats

# 定义参数

n = 100 # 试验次数

p = 0.9 # 每次试验成功的概率

k = 90 # 成功次数

# 计算概率

binom_prob = stats.binom.pmf(k, n, p)

print(f"恰好有 {k} 只合格的概率为: {binom_prob}")

```

代码解释:`stats.binom.pmf(k, n, p)` 计算的是二项分布概率质量函数(PMF),即恰好有 \(k\) 次成功的概率。

在质量控制中,企业会使用这一概率分布模型来预测和评估生产线的性能,并据此调整生产流程和质量检验标准,以确保产品达到规定的合格率。

# 3. 连续型概率分布

## 3.1 均匀分布

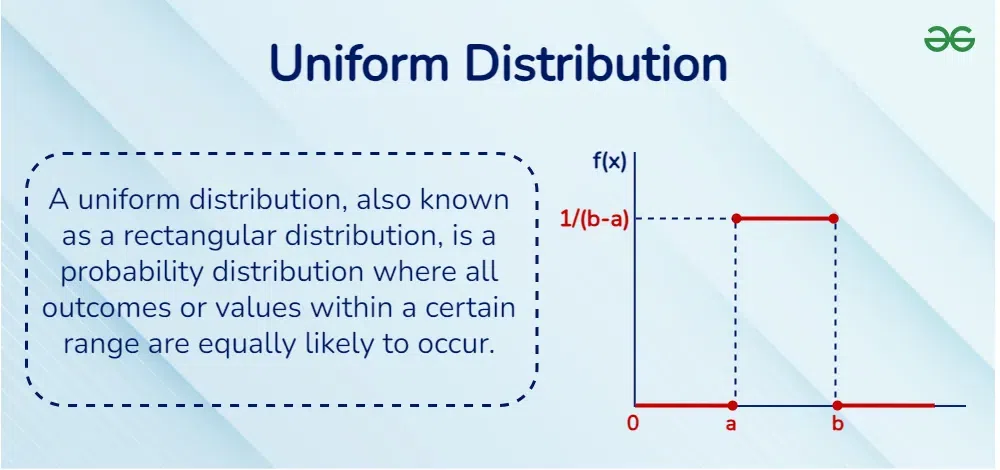

在概率论和统计学中,连续型概率分布对随机变量的行为建模有着重要的作用,尤其是在分析那些可以在某一区间内取任意值的随机现象时。均匀分布(Uniform Distribution)是连续型分布中最简单的一种,它为区间内的每个值赋予了相同的概率密度。

### 3.1.1 均匀分布的理论基础

均匀分布可以定义在一个闭区间 [a, b] 上,此时随机变量 X 在该区间内任取一值的概率都是相等的。数学上,均匀分布的概率密度函数(PDF)可以表示为:

```

f(x; a, b) = 1 / (b - a), for a ≤ x ≤ b

```

其中,a 和 b 是分布的下限和上限,且必须满足 a < b。均匀分布的概率密度函数在区间 [a, b] 内是一个常数,在区间外为零。这个性质可以用来简化很多概率和统计的计算,尤其是那些涉及到“均匀随机”概念的情形。

### 3.1.2 实际应用:模拟与预测

均匀分布的应用范围很广,特别是在计算机科学中,它是最常见的分布之一,用于生成伪随机数。在实际中,均匀分布的使用常常与模拟和预测紧密相关。

例如,考虑一个简单的系统,它的性能指标 Y 在 [0, 100] 之间均匀分布。我们想要预测该系统在一次操作中的性能表现。此时,我们可以简单地选择一个介于 0 到 100 之间的值作为可能的结果。这个选择可以是通过生成一个介于 0 到 1 之间的随机数然后乘以 100 获得,也可以是直接使用 [0, 100] 区间内的均匀分布随机数。

**代码示例:使用Python进行均匀分布的随机数生成**

```python

import numpy as np

# 设定均匀分布的参数

a, b = 0, 100

# 生成 10 个均匀分布的随机数

uniform_samples = np.random.uniform(a, b, 10)

print(uniform_samples)

```

在上述代码中,`np.random.uniform(a, b, size)` 函数调用生成了一个服从 [a, b] 区间均匀分布的随机数数组。`size` 参数指定了要生成的随机数个数。这段代码演示了如何用 Python 实现连续型概率分布的模拟,这是一个在数据分析和模拟实验中非常实用的技巧。

均勻分布在实际中的另一个重要应用是蒙特卡洛模拟。这是一种基于随机抽样的数值计算方法,广泛应用于求解复杂的数学和物理问题,如积分计算、系统模拟、风险分析等。

## 3.2 正态分布

正态分布(Normal Distribution),也称高斯分布(Gaussian Distribution),是连续型概率分布中最重要的一种。它在自然科学和社会科学领域内广泛应用,因其特殊的钟形曲线形状,也被称为钟形曲线。正态分布在误差分析、质量控制、社会科学调查数据的分析等方面都有着广泛的应用。

### 3.2.1 正态分布的数学描述

正态分布的概率密度函数可以用以下公式表示:

```

f(x; μ, σ^2) = (1 / (σ * √(2π))) * exp(- (x - μ)^2 / (2σ^2))

```

其中,μ (mu) 是分布的均值,σ (sigma) 是分布的标准差。均值决定了分布的中心位置,标准差影响曲线的宽度和陡峭程度。

### 3.2.2 实例探究:数据分析中的正态检验

在数据分析中,我们经常需要检验一组数据是否服从正态分布。这一步骤至关重要,因为许多统计方法假设数据是正态分布的,如果数据不符合这一假设,我们可能需要采取其他分析方法。

**代码示例:使用Python进行正态分布的检验**

```python

from scipy import stats

import numpy as np

# 生成一组数据,假设它服从正态分布

data = np.random.normal(loc=0, scale=1, size=1000)

# 正态检验

normal_test = stats.normaltest(data)

print(normal_test)

```

在这段代码中,我们使用了 `scipy.stats.normaltest` 函数来检验数据是否服从正态分布。这个函数基于 D'Agostino's K^2 统计量和 Jarque-Bera 统计量进行检验。`normaltest` 函数返回一个包含两个值的对象:检验统计量和对应的 p 值。如果 p 值较小(通常小于 0.05),我们可以拒绝原假设(原假设是样本来自正态分布),认为样本数据不完全符合正态分布的特性。

正态分布检验在实际数据分析中至关重要,特别是涉及到假设检验和置信区间的计算时。理解并掌握正态分布的检验方法,对于数据分析师来说是必须的技能。

## 3.3 指数分布

指数分布是一种描述事件发生时间间隔的连续型概率分布,它在可靠性理论、生存分析和排队论等领域有着广泛的应用。指数分布的数学模型简单且易于处理,这使得它成为建模和预测中非常重要的一个工具。

### 3.3.1 指数分布的应用领域

指数分布的概率密度函数为:

```

f(x; λ) = λ * exp(- λx), for x ≥ 0

```

其中,λ > 0 是分布的率参数,决定了分布曲线的形状。指数分布的特点是,它从原点开始并且随着 x 的增加单调递减,其形状受 λ 影响。

指数分布通常用于模拟两个连续事件之间的时间间隔,尤其是在假设事件发生的概率在时间上是恒定的情况下。一个典型的例子是,电子设备的寿命、网页访问者在网页上的停留时间等都可以用指数分布来建模。

### 3.3.2 实际案例:可靠性和生存分析

在可靠性工程中,指数分布是描述非修复系统的寿命分布的基础。假设我们有一个灯泡,它的失效是随机的,并且在任意时间区间内的失效概率是相等的,那么这个灯泡的寿命就可以用指数分布来描述。

**代码示例:使用Python进行指数分布的生存函数计算**

```python

from scipy.stats import expon

import matplotlib.pyplot as plt

# 指数分布的参数

lam = 0.1

# 创建指数分布对象

exp_dist = expon(scale=1/lam)

# 计算生存函数的值

survival_function = exp_dist.sf(10) # 生存10个时间单位的概率

print(f"生存函数在 x=10 处的值: {survival_function}")

# 绘制概率密度函数图

x = np.linspace(0, 40, 200)

plt.plot(x, exp_dist.pdf(x))

plt.title('Exponential Distribution PDF')

plt.xlabel('Time')

plt.ylabel('Probability Density')

plt.grid(True)

plt.show()

```

在这段代码中,我们使用了 `scipy.stats.expon` 来创建一个指数分布对象,并计算了在 10 单位时间后灯泡仍然工作的概率(生存函数)。此外,我们还绘制了概率密度函数的图像,通过可视化的方式展示了指数分布的形状。生存函数的计算和可视化有助于我们对系统的可靠性进行评估。

指数分布不仅在生存分析中有应用,在排队理论中也经常用来模拟顾客在系统中的等待时间。理解指数分布及其应用对于解决现实世界的实际问题具有非常重要的意义。

# 4. 概率分布的高级主题

在深入探讨了概率分布的基本类型和它们在实践中的应用之后,我们现在转向更高级的主题,这些主题在复杂数据分析和模型构建中发挥着至关重要的作用。本章将涵盖多变量概率分布、大数定律与中心极限定理,以及概率分布的参数估计。

## 4.1 多变量概率分布

### 4.1.1 联合分布与边缘分布

多变量概率分布描述了两个或两个以上随机变量的联合概率行为。理解这些分布是处理多变量数据集的基础,无论是分析多个相关特征还是评估多个随机事件的同时发生概率。

联合分布涉及到多个随机变量,给出了所有变量同时发生的概率。例如,在掷两枚骰子的情境下,我们可以使用一个联合分布来描述两个骰子的点数和。联合分布可以用概率质量函数(对于离散随机变量)或概率密度函数(对于连续随机变量)来表示。

边缘分布则是从联合分布中获得的,它描述了单个随机变量的分布,而忽略了其他随机变量。边缘分布可以从联合分布中通过求和或积分得到。

### 4.1.2 条件概率分布的理解

条件概率分布考虑了给定一个或多个其他随机变量的值时,一个随机变量的概率分布。它是概率论中一个极其重要的概念,广泛应用于贝叶斯统计和机器学习模型中。

条件分布的数学表达通常写作 P(X|Y=y),表示给定 Y=y 的情况下 X 的概率分布。其关键在于条件概率密度函数或概率质量函数是在假设某个条件已经满足的情况下的分布。

## 4.2 大数定律与中心极限定理

### 4.2.1 大数定律的理论框架

大数定律是概率论中的一个重要定理,它说明了当试验次数足够多时,样本均值将趋近于总体均值。这个定理是统计推断和随机过程理论的基石。

大数定律有两个常见的形式:弱大数定律和强大数定律。弱大数定律指出,随着样本数量的增加,样本均值会以概率收敛到期望值。强大数定律则表明,样本均值几乎必然收敛到期望值。

### 4.2.2 中心极限定理的实际意义

中心极限定理是概率论中的另一个核心定理,它表明在特定条件下,大量独立随机变量之和经过适当的标准化后,近似服从标准正态分布。

中心极限定理对于统计学的意义在于,它允许我们使用正态分布的知识来处理非正态分布的随机变量,只要这些变量是大量独立同分布的随机变量之和。

## 4.3 概率分布的参数估计

### 4.3.1 点估计与区间估计

参数估计是统计学中对总体参数进行估计的过程。点估计是指给出一个具体的数值作为总体参数的估计值。例如,样本均值可以作为总体均值的点估计。

区间估计则提供了一个区间,我们相信该区间以一定的概率覆盖了未知的总体参数。这个区间被称为置信区间。置信区间的宽度受样本大小和置信水平的影响。

### 4.3.2 贝叶斯参数估计的介绍

贝叶斯参数估计是基于贝叶斯定理来更新参数的概率分布,从先验分布开始,结合数据信息,最终得到后验分布。

在贝叶斯估计中,参数被视为随机变量,并具有先验分布。当我们得到新的数据后,我们使用贝叶斯定理来更新我们对参数的看法,得到后验分布。这种参数估计的方法在处理不确定性和小样本数据时特别有用。

在这第四章的详细探讨中,我们已经深入了解了概率分布的多个高级主题,这些主题对于理解数据分析和概率建模的基本原理至关重要。在下一章,我们将进一步探讨这些概念在数据分析中的具体应用。

# 5. 概率分布在数据分析中的应用

数据分析是一个不断增长的领域,其中概率分布扮演着核心角色,它们不仅用于描述数据的潜在模式,还用于统计推断、假设检验、回归分析和风险评估。本章深入探讨这些应用,揭示概率分布如何在各种数据分析任务中发挥作用。

## 5.1 统计推断与假设检验

统计推断是数据分析的关键部分,它允许我们从样本数据中推断总体参数。概率分布在这里提供了理论支持,它们描述了数据是如何生成的,并使得我们可以量化这些推断的不确定性。

### 5.1.1 假设检验的基本流程

假设检验是对统计假设进行系统的检验,以便决定是否接受或者拒绝这些假设。其核心是p值的概念,即在零假设为真的前提下,观察到当前样本结果或更极端结果的概率。这个值通常与一个事先定义的显著性水平α比较。如果p值小于α,那么我们拒绝零假设。

```python

from scipy import stats

# 示例:检验一个硬币是否公平

observed_heads = 55 # 观察到正面的次数

n_flips = 100 # 总投掷次数

# 计算在零假设为真的情况下的p值

p_value = stats.binom_test(observed_heads, n_flips, p=0.5)

print(f"The p-value is {p_value}")

if p_value < 0.05:

print("Reject the null hypothesis (the coin is not fair)")

else:

print("Fail to reject the null hypothesis (the coin is fair)")

```

### 5.1.2 概率分布与p值的计算

在假设检验中,不同的检验方法会用到不同的概率分布。例如,t检验使用t分布,而卡方检验使用卡方分布。这些分布在计算p值时至关重要,因为它们定义了在零假设下,观测到特定统计量或更极端情况的概率。

### 5.1.3 使用Python进行假设检验

Python提供了强大的统计库如`scipy`和`statsmodels`,它们内置了多种概率分布,并提供了检验统计假设的工具。以下是一个使用Python中的`ttest_1samp`函数进行单样本t检验的例子:

```python

import numpy as np

from scipy import stats

# 随机数据集

data = np.random.randn(100)

# 进行单样本t检验,检验均值是否显著不同于0

t_statistic, p_value = stats.ttest_1samp(data, 0)

print(f"T-statistic: {t_statistic}, P-value: {p_value}")

if p_value < 0.05:

print("Reject the null hypothesis")

else:

print("Fail to reject the null hypothesis")

```

在数据分析中,这些工具使得进行假设检验变得既快速又简单。

## 5.2 回归分析与概率分布

回归分析是研究变量间相关关系的统计工具。最常用的是线性回归,其中概率分布出现在残差分析中。残差是实际观测值和模型预测值之间的差异,理想情况下,这些残差应当是独立同分布的,并且通常假设是正态分布的。

### 5.2.1 线性回归模型与残差分析

线性回归模型可以用来预测一个因变量Y,根据一个或多个自变量X。残差分析是对回归模型是否恰当的重要检查。如果残差没有显示出明显的模式,且大致符合正态分布,那么模型就可能是合适的。

```python

import statsmodels.api as sm

# 示例数据集

X = np.random.rand(100, 1)

X = sm.add_constant(X) # 添加截距项

Y = np.random.randn(100)

# 拟合线性回归模型

model = sm.OLS(Y, X).fit()

# 查看残差

residuals = model.resid

# 绘制残差图

import matplotlib.pyplot as plt

plt.scatter(X[:, 1], residuals)

plt.title('Residuals vs. Explanatory Variable')

plt.xlabel('Explanatory Variable')

plt.ylabel('Residuals')

plt.axhline(y=0, color='r', linestyle='--')

plt.show()

```

### 5.2.2 概率分布对回归模型的影响

概率分布在回归分析中的一个重要作用是作为误差项的概率模型。通过理解这些误差项的分布,我们可以对回归模型的性能做出更准确的预测和改进。

## 5.3 风险评估与概率分布

风险评估涉及识别和量化潜在的风险,概率分布在这里用于建模不确定性和变异性。在金融、保险和工程等领域,风险评估对于决策制定至关重要。

### 5.3.1 风险管理中的概率分布应用

在风险管理中,概率分布可以帮助我们预测未来事件的可能性。例如,在投资组合管理中,可以使用正态分布来模拟资产的收益,并据此计算不同投资策略的风险和回报。

### 5.3.2 金融模型中的分布假设

金融模型中常见的分布假设包括资产价格遵循对数正态分布,以及资产收益的波动性遵循GARCH模型。正确假设分布对于定价衍生品、评估投资组合风险和其他金融决策都是至关重要的。

概率分布的应用不仅仅是理论上的;在实际操作中,它们提供了分析数据、预测未来并做出明智决策的工具。从假设检验到风险评估,再到回归分析,概率分布无处不在,它们是数据科学领域不可或缺的基础。随着我们继续深入数据分析的世界,对概率分布的理解和应用将会变得更加关键。

# 6. 概率分布的软件实现

在数据分析和统计推断中,概率分布的计算与可视化是不可或缺的。随着计算机技术的发展,软件工具如Python和R语言已经广泛应用于这一领域。本章将探讨如何使用这两种语言实现概率分布的相关计算、分析和可视化。

## 6.1 使用Python进行概率分布计算

Python作为一门多功能的编程语言,拥有强大的数学计算和统计分析库。在概率分布的计算中,`scipy.stats`模块提供了丰富的概率分布函数。

### 6.1.1 Python中的概率分布库介绍

`scipy.stats`模块为各种概率分布提供了统一的接口,包括离散分布和连续分布。每个分布都遵循以下的一般接口:

- `pdf(x, *args, loc=0, scale=1)`: 概率密度函数(PDF)

- `cdf(x, *args, loc=0, scale=1)`: 累积分布函数(CDF)

- `sf(x, *args, loc=0, scale=1)`: 生存函数(1-CDF)

- `ppf(q, *args, loc=0, scale=1)`: 分位数函数

- `rvs(size, *args, loc=0, scale=1)`: 随机变量的抽样

`*args` 是分布参数,例如正态分布的均值(mean)和标准差(std);`loc` 和 `scale` 参数分别用于位置和尺度变换,通常默认为0和1。

### 6.1.2 实例操作:编程实现概率计算

假设我们想要在Python中计算一个正态分布的PDF和CDF。以下是相应的代码实现:

```python

import numpy as np

from scipy.stats import norm

# 正态分布参数

mu, sigma = 0, 1

# 定义分布

norm_dist = norm(mu, sigma)

# 生成数据点

x = np.linspace(-3, 3, 100)

# 计算PDF和CDF

pdf = norm_dist.pdf(x)

cdf = norm_dist.cdf(x)

# 打印结果

print("PDF values at different x:")

for i in range(len(x)):

print(f"x={x[i]:.2f}, PDF={pdf[i]:.4f}")

print("\nCDF values at different x:")

for i in range(len(x)):

print(f"x={x[i]:.2f}, CDF={cdf[i]:.4f}")

```

上述代码首先导入了`numpy`和`scipy.stats`模块中的`norm`函数,然后定义了一个均值为0,标准差为1的正态分布对象。接着,我们生成了从-3到3的100个均匀分布的点,计算了这些点处的PDF和CDF值,并打印输出。

## 6.2 使用R语言进行数据分析

R语言是数据科学领域的另一项强大工具。它内置了大量的统计分析函数,可以直接用于各种概率分布的计算和图形绘制。

### 6.2.1 R语言中的概率分布函数

R语言中有专门的函数用于计算概率分布的PDF和CDF。这些函数通常遵循以下命名规则:

- `dxxx(x, ...)`:计算概率密度函数(离散分布使用`xxx`表示)

- `pxxx(q, ...)`:计算累积分布函数

- `qxxx(p, ...)`:计算分位数函数

- `rxxx(n, ...)`:生成随机样本

其中`xxx`代表具体的分布类型,例如`norm`代表正态分布。

### 6.2.2 R语言在统计分析中的应用案例

以下是一个使用R语言进行正态分布统计分析的示例:

```R

# 设置随机数种子以保证结果可复现

set.seed(123)

# 生成正态分布随机样本

samples <- rnorm(100, mean=0, sd=1)

# 计算样本的均值和标准差

sample_mean <- mean(samples)

sample_sd <- sd(samples)

# 计算概率密度函数的值

pdf_values <- dnorm(samples, mean=sample_mean, sd=sample_sd)

# 计算累积分布函数的值

cdf_values <- pnorm(samples, mean=sample_mean, sd=sample_sd)

# 打印结果

print(paste("Sample mean:", sample_mean))

print(paste("Sample standard deviation:", sample_sd))

# 绘制直方图和正态分布曲线

hist(samples, freq=FALSE, breaks=30)

curve(dnorm(x, mean=sample_mean, sd=sample_sd), add=TRUE, col="blue", lwd=2)

```

在这段代码中,我们首先生成了一个正态分布的随机样本。然后计算样本的均值和标准差,并用这些参数来计算概率密度函数(PDF)和累积分布函数(CDF)。最后,我们使用`hist`函数绘制了样本的直方图,并使用`curve`函数叠加绘制了拟合的正态分布曲线。

## 6.3 概率分布的可视化与解读

数据可视化是数据分析中不可或缺的一部分,它帮助我们更好地理解数据分布和相关模式。概率分布的可视化尤其关键,因为它可以直观地展示数据的统计特性。

### 6.3.1 数据可视化的基本原则

在进行概率分布的可视化时,应遵循以下基本原则:

- 简洁性:图表应该清晰、简洁,避免不必要的装饰。

- 准确性:图表必须准确地反映数据和统计结果。

- 可读性:图表的设计应便于观察者理解和解读。

- 突出重点:重要信息和关键发现应该突出显示。

### 6.3.2 概率分布图表的制作与解读

为了有效地展现概率分布,我们可以使用直方图、箱线图、概率密度图和累积分布图等。Python和R语言提供了丰富的绘图库,如`matplotlib`、`seaborn`、`ggplot2`等,可以方便地创建这些图表。

以下是使用Python的`matplotlib`库绘制正态分布的直方图和密度图的示例:

```python

import matplotlib.pyplot as plt

# 使用之前计算的数据

plt.figure(figsize=(10, 5))

# 绘制直方图

plt.hist(x, bins=30, density=True, alpha=0.6, color='g')

# 绘制密度曲线

plt.plot(x, pdf, 'k', linewidth=2)

# 添加标题和标签

plt.title('Histogram and PDF of Normal Distribution')

plt.xlabel('x')

plt.ylabel('Probability Density')

# 显示图表

plt.show()

```

此代码绘制了一个正态分布的直方图,并在其上叠加了相应的概率密度曲线。通过这种方式,我们可以直观地看出数据分布的形状和特性。

在概率分布的可视化解读方面,重点是观察图形的形状、中心位置、分散程度和尾部特性。例如,正态分布的形状呈现对称的钟形,而偏态分布则呈现出不对称的形态。

通过本章的探讨,我们可以看到软件实现概率分布的灵活性和便捷性。无论是使用Python还是R语言,都可以有效地进行概率分布的计算和分析,同时还可以借助这些工具丰富的可视化库来直观地展示数据特性。对于IT和数据科学领域的专业人士而言,掌握这些工具和方法将极大地提升工作效率和分析质量。

0

0