贝叶斯定理重塑概率理解:概率分布的全新视角

发布时间: 2024-11-22 11:19:06 阅读量: 24 订阅数: 33

贝叶斯理论视角下先验分布和后验分布的概念及应用

# 1. 贝叶斯定理的历史与原理

贝叶斯定理是概率论中的一个基本定理,由英国数学家托马斯·贝叶斯(Thomas Bayes)提出,其在数据分析、机器学习及统计决策等领域具有极其重要的地位。

## 1.1 贝叶斯定理的历史背景

贝叶斯定理的历史可以追溯到18世纪。托马斯·贝叶斯提出了一种基于先前知识,通过新数据不断更新概率的逆向概率理论。他去世后,其好友理查德·普莱斯整理并发表了贝叶斯的遗作《论有关机遇问题的求解方法》,其中包含的定理便是后来的贝叶斯定理。

## 1.2 贝叶斯定理的基本原理

从数学的角度,贝叶斯定理可以表述为:后验概率 = (先验概率 × 似然性)/ 边际似然。其中,后验概率是在考虑新的证据后,对假说正确的概率的新估计;先验概率是未考虑新证据之前,对假说正确的概率的估计;似然性是考虑新证据后,假说正确的概率;边际似然则是一个标准化常数,确保后验概率是一个有效的概率值。

## 1.3 贝叶斯定理的意义

贝叶斯定理的意义在于它提供了一个理论框架,使得我们可以从统计的角度来处理不确定性和信息更新。在机器学习中,贝叶斯方法允许模型利用先验知识并随着新数据的到来不断调整其预测。在统计推断中,贝叶斯方法提供了一种计算复杂模型参数置信区间的有效手段。

在下一章中,我们将深入探讨概率分布的基础知识,为理解贝叶斯定理在更复杂场景中的应用打下坚实的基础。

# 2. 概率分布的基础知识

### 2.1 随机变量与概率分布

#### 2.1.1 随机变量的概念

随机变量是概率论中的一个基本概念,它是将随机试验的结果映射到实数轴上的一个函数。随机变量分为两类:离散随机变量和连续随机变量。离散随机变量的结果是可数的,如掷骰子得到的点数;连续随机变量的结果是不可数的,如测量误差或人的身高。了解随机变量的性质对于深入研究概率分布至关重要。

随机变量的分布函数给出了随机变量取值小于或等于某个具体值的概率,它是定义在实数轴上的非降函数,其值域在0到1之间。对于离散随机变量,我们通常使用概率质量函数(probability mass function, PMF)来描述其取值的概率,而对于连续随机变量,则使用概率密度函数(probability density function, PDF)。

#### 2.1.2 常见的概率分布类型

概率论中存在多种常见的概率分布,每种分布都有其独特的性质和应用领域。以下是一些最为常见的概率分布:

- 二项分布(Binomial Distribution)

- 泊松分布(Poisson Distribution)

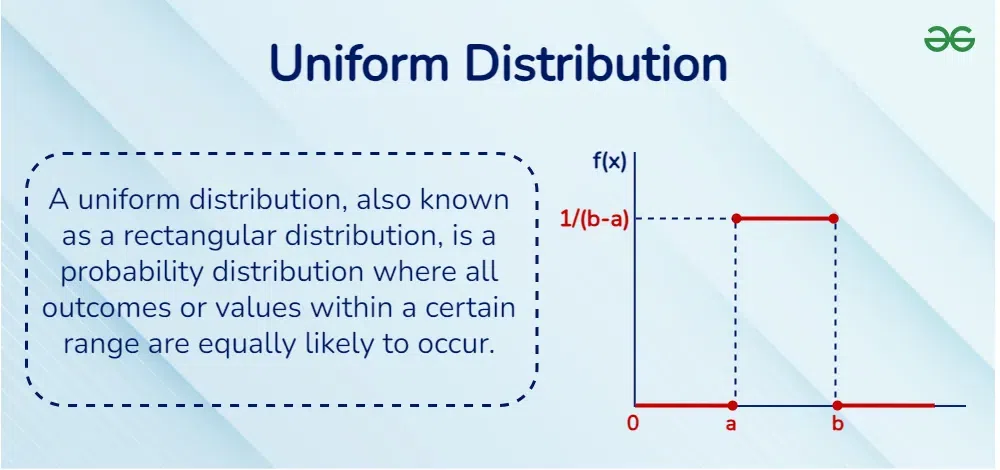

- 均匀分布(Uniform Distribution)

- 正态分布(Normal Distribution)

- 指数分布(Exponential Distribution)

- 伽玛分布(Gamma Distribution)

这些分布中的每一个都有一系列参数,比如均值(mean)、方差(variance)和形状参数(shape parameter),这些参数定义了分布的形状和中心位置。

### 2.2 贝叶斯视角下的概率更新

#### 2.2.1 先验、似然与后验

贝叶斯定理中的概率更新过程涉及到三个主要概念:先验概率、似然和后验概率。先验概率是根据历史数据或主观判断得到的概率,它反映了在收集到新数据之前对某个假设的信心程度。似然函数则表示在假设为真的条件下,观测到特定数据的概率。后验概率是结合先验概率和似然函数,利用贝叶斯定理得到的在考虑了新数据之后对假设为真的概率评估。

- 先验概率:P(H),表示假设H在考虑新证据之前的概率。

- 似然函数:P(D|H),表示在假设H为真的条件下,观测到数据D的概率。

- 后验概率:P(H|D),表示在观测到数据D之后,假设H为真的概率。

通过贝叶斯定理,我们能够得到后验概率的数学表达式:

\[ P(H|D) = \frac{P(D|H) \cdot P(H)}{P(D)} \]

其中,P(D)是边缘似然,可以视为数据D发生的总概率,通常是通过积分或求和来计算。

#### 2.2.2 贝叶斯推断实例分析

考虑一个简单的贝叶斯推断问题:一个工厂生产的产品,其不良品率是未知的。我们抽取了一个大小为10的产品样本,并观察到其中有2个是不良品。我们希望使用贝叶斯推断来估计这个工厂的不良品率。

- 先验概率:我们可能知道该工厂之前生产的产品不良品率为10%,但在本例中我们使用非信息性先验,即认为所有不良品率的可能性都是一样的。

- 似然函数:假设不良品率服从贝塔分布(Beta distribution),参数为α和β。那么似然函数表示为抽取到2个不良品和8个良品的概率。

- 后验概率:在给定先验和似然函数后,我们使用贝叶斯定理来更新我们关于不良品率的信念,并得到后验概率。

下面是一个简单的Python代码,演示了如何使用贝叶斯推断来估计不良品率:

```python

import numpy as np

from scipy.stats import beta

# 先验分布参数

alpha_prior = 1

beta_prior = 1

# 观测数据

defective_count = 2

sample_size = 10

# 更新先验为后验

alpha_posterior = alpha_prior + defective_count

beta_posterior = beta_prior + sample_size - defective_count

# 计算后验概率密度

x = np.linspace(0, 1, 100)

pdf_posterior = beta.pdf(x, alpha_posterior, beta_posterior)

# 输出后验概率密度值

for i in range(len(x)):

print(f"{x[i]:.2f} : {pdf_posterior[i]:.4f}")

```

### 2.3 条件概率与独立性

#### 2.3.1 条件概率的定义与计算

条件概率是事件A在另一个事件B已经发生的条件下发生的概率。条件概率的数学表示是P(A|B),读作“事件A在事件B发生的条件下的概率”。

当我们说P(A|B),我们实际上是说“在B发生的背景下,A发生的可能性有多大”。条件概率可以使用以下公式来计算:

\[ P(A|B) = \frac{P(A \cap B)}{P(B)} \]

这个公式告诉我们,要找到事件A在事件B发生的条件下的概率,就要看A和B同时发生的概率,然后除以B发生的概率。

#### 2.3.2 独立事件的概率乘法法则

独立事件是两个或多个事件发生时,任一事件的发生不受其他事件发生的影响。如果事件A和事件B是独立的,那么P(A|B) = P(A)且P(B|A) = P(B)。

独立事件的概率乘法法则说明了两个独立事件同时发生的概率等于各自发生的概率的乘积:

\[ P(A \cap B) = P(A) \cdot P(B) \]

这个法则可以推广到多个独立事件的情况:

\[ P(A_1 \cap A_2 \cap \ldots \cap A_n) = P(A_1) \cdot P(A_2) \cdot \ldots \cdot P(A_n) \]

例如,抛掷一枚公平的硬币两次,两次都是正面朝上的概率可以通过独立事件的概率乘法法则来计算:

\[ P(正 \cap 正) = P(第一次正面) \cdot P(第二次正面) = \frac{1}{2} \cdot \frac{1}{2} = \frac{1}{4} \]

利用条件概率和独立性,我们可以解决一系列概率问题,这些都为深入理解随机变量和概率分布提供了重要的数学工具。

# 3. 贝叶斯定理在数据分析中的应用

## 3.1 贝叶斯网络的基本原理

### 3.1.1 贝叶斯网络的构建与拓扑结构

贝叶斯网络,也称为信念网络或有向无环图模型,是一种图形化的模型,用于表达一组变量之间的条件依赖关系,是概率论和图论相结合的产物。在贝叶斯网络中,节点代表随机变量,而有向边则表示变量间的因果关系,边的方向由原因指向结果。每个节点都有一个条件概率表(CPT),表示在给定其父节点的状态时,该节点状态出现的概率。

构建贝叶斯网络通常包括以下步骤:

1. **识别变量**:首先确定问题域中的所有变量,这些变量可以是可观测的也可以是隐含的。

2. **定义因果关系**:确定变量之间的因果关系,从而决定变量间的依赖方向。

3. **构建网络结构**:根据因果关系构建有向无环图(DAG),即没有循环依赖的图结构。

4. **分配条件概率**:为每个节点分配条件概率表(CPT),这些概率通常基于历史数据或者专家知识。

举例来说,考虑一个简单医疗诊断问题,其中有两个变量:症状(S)和疾病(D)。如果疾病会导致症状,则我们创建一个有向边从疾病指向症状。每个变量的CPT需要根据数据或经验知识来定义。

### 3.1.2 网络中的概率推理方法

概率推理是贝叶斯网络的核心应用之一,它指的是根据已知信息推断未知变量概

0

0