机器学习的数学基石:在算法中运用概率分布

发布时间: 2024-11-22 11:28:08 阅读量: 35 订阅数: 31

shenlan学院机器学习数学基础(源码+课件)

# 1. 概率论基础与机器学习的关系

## 1.1 概率论与机器学习的交汇点

在机器学习领域,算法往往需要处理不确定性和随机性,而这正是概率论的核心研究内容。概率论为机器学习提供了数学基础,帮助我们量化不确定性,构建出能够从数据中学习并做出预测的模型。例如,朴素贝叶斯分类器依赖概率论中的贝叶斯定理,而隐马尔可夫模型则利用概率分布来建模时序数据。

## 1.2 概率论的数学表达与机器学习的桥梁

机器学习中,模型的预测与决策过程通常涉及到概率的计算和推断。这需要我们理解概率的数学表达,包括随机变量、概率分布以及期望、方差等统计量。掌握这些概念,我们就能在机器学习中,如参数估计、模型评估和优化等环节中更有效地运用概率论原理。

## 1.3 概率论的实践应用:从理论到实现

在实践中,概率论原理的应用需要我们实现具体的算法和模型。无论是概率图模型的构建,还是概率分布参数的估计,都要求我们对概率论有着深刻的理解,并能够将理论应用到实际的机器学习问题中。通过编程实现概率论中的公式和算法,我们可以加深对机器学习工作流程的认识,并提高解决实际问题的能力。

通过以上的分析,我们可以看出概率论在机器学习中的重要性以及如何将其理论应用到实践中。下一章将深入探讨各种常见概率分布及其性质,以进一步理解其在机器学习中的作用。

# 2. 常见概率分布及其性质

### 2.1 离散型概率分布

#### 2.1.1 伯努利分布和二项分布

伯努利分布是最简单的一种离散型概率分布,它描述了单次实验中只有两种可能结果(成功或失败)的情况,例如抛硬币的正面和反面。设随机变量X服从伯努利分布,则其概率质量函数(PMF)为:

```math

P(X = x) = p^x(1-p)^{1-x} , x ∈ {0, 1}

```

其中,`p`表示成功发生的概率,`x`为成功或失败的二元结果。

在多个独立的伯努利实验中,成功次数的分布被称作二项分布。若令`X`表示在`n`次独立实验中成功的次数,则`X`的概率质量函数为:

```math

P(X = k) = C(n, k)p^k(1-p)^{n-k} , k = 0, 1, ..., n

```

其中`C(n, k)`是组合数,表示从`n`次实验中选择`k`次成功的方式数。

二项分布是许多机器学习模型的基础,比如朴素贝叶斯分类器中,模型基于特征的独立假设判断类别的概率。

#### 2.1.2 泊松分布及其应用

泊松分布描述的是在一定时间或空间内随机事件发生次数的概率分布。当事件发生的概率很低,且单位时间(或单位面积)内发生次数的期望值`λ`是已知时,这个随机变量就服从泊松分布。

泊松分布的概率质量函数为:

```math

P(X = k) = \frac{e^{-λ}λ^k}{k!} , k = 0, 1, 2, ...

```

其中`e`为自然对数的底数,`k`是事件发生的次数。

泊松分布在自然语言处理、交通流量分析、疾病发生次数统计等领域有着广泛的应用。例如,用于预测某段时间内网站收到的访问量或某个地区的救护车呼叫次数。

### 2.2 连续型概率分布

#### 2.2.1 均匀分布的特点与使用

均匀分布是一个在指定区间上具有相等概率密度的连续型概率分布。如果有随机变量X服从区间`[a, b]`上的均匀分布,其概率密度函数(PDF)表达式为:

```math

f(x) =

\begin{cases}

\frac{1}{b-a} & \text{if } x \in [a, b] \\

0 & \text{otherwise}

\end{cases}

```

均匀分布常用于模拟那些在某个范围内的值有相等机会被选中的情形,比如计算机生成的伪随机数。

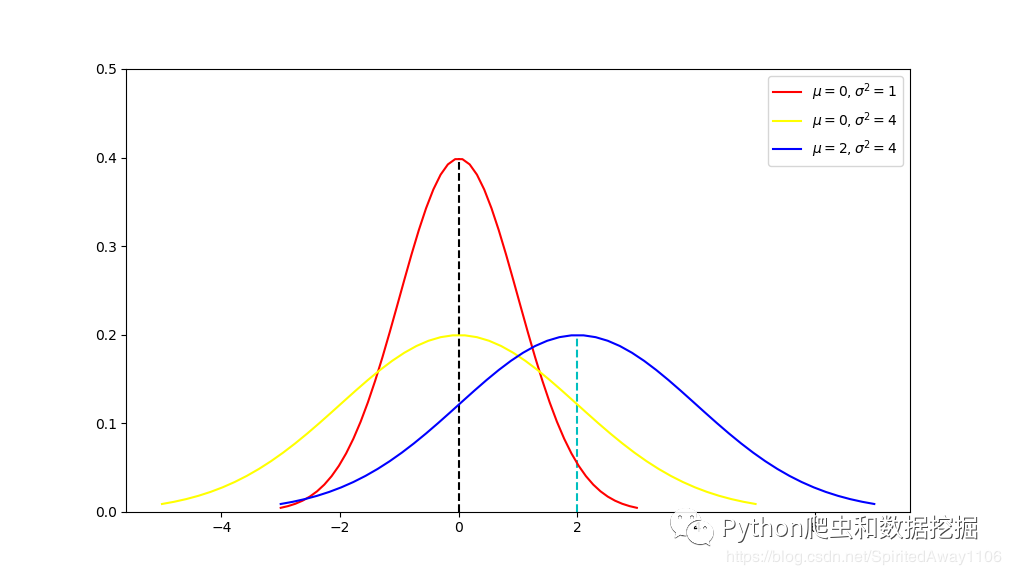

#### 2.2.2 正态分布的中心极限定理

正态分布,又称为高斯分布,是连续型概率分布中最重要的一种。其概率密度函数由均值`μ`和标准差`σ`两个参数决定:

```math

f(x) = \frac{1}{σ\sqrt{2π}} e^{-\frac{(x-μ)^2}{2σ^2}}

```

中心极限定理指出,只要样本量足够大,无论总体分布如何,样本均值的分布都将趋近于正态分布。这一定理在机器学习的参数估计中至关重要,因为许多参数估计方法都依赖于数据符合正态分布的假设。

#### 2.2.3 指数分布与可靠性分析

指数分布用来描述某个事件发生间隔的概率分布,常用于可靠性分析、生存分析等领域。若随机变量`X`服从参数为`λ`的指数分布,其概率密度函数为:

```math

f(x) = λe^{-λx}, x \geq 0

```

指数分布是无记忆性质的,意味着过去发生的事件不会影响未来事件发生的概率。在机器学习中,它用于建模设备故障或客户流失等事件的时间间隔。

### 2.3 多变量概率分布

#### 2.3.1 联合概率分布的理解

当有两个或更多随机变量时,它们之间的联合概率分布描述了这些变量同时取值的概率。例如,有两个随机变量X和Y,它们的联合分布给出了P(X=x, Y=y)。如果X和Y是连续型随机变量,其联合概率密度函数是:

```math

f(x, y) \geq 0

```

并且满足:

```math

\int_{-\infty}^{\infty}\int_{-\infty}^{\infty} f(x, y) dx dy = 1

```

联合概率分布有助于理解多个随机变量之间的相关性或独立性。

#### 2.3.2 条件概率分布及其推导

条件概率分布描述了在给定一个或多个其他随机变量的条件下,一个随机变量的概率分布。如果X和Y是连续型随机变量,Y给定X的条件概率密度函数`f(y|x)`可以由联合概率密度函数推导得到:

```math

f(y|x) = \frac{f(x, y)}{f_X(x)}

```

其中`f_X(x)`是边缘概率密度函数,可以通过对Y积分获得:

```math

f_X(x) = \int_{-\infty}^{\infty} f(x, y) dy

```

条件概率分布广泛应用于机器学习中,比如在贝叶斯网络和隐马尔可夫模型中。

#### 2.3.3 边缘概率分布的应用

边缘概率分布是单个随机变量的概率分布,它是联合分布对其他变量的积分或求和。如果X和Y是连续型随机变量,X的边缘概率密度函数`f_X(x)`定义为:

```math

f_X(x) = \int_{-\infty}^{\infty} f(x, y) dy

```

如果X和Y是离散型随机变量,边缘概率质量函数`P(X=x)`则是:

```math

P(X=x) = \sum_{y} P(X=x, Y=y)

```

边缘概率分布有助于分析一个变量单独出现的概率,无论其他变量的状态如何。在实际应用中,例如数据分析和概率推断,边缘概率分布提供了一种通过考虑部分变量来简化问题的方法。

```mermaid

graph TD;

A[概率分布] -->|离散型| B[伯努利分布和二项分布]

A -->|连续型| C[均匀分布]

A -->|连续型| D[正态分布]

A -->|连续型| E[指数分布]

B -->|扩展| F[泊松分布]

C -->|特性分析| G[均匀分布的特点]

D -->|中心极限定理| H[正态分布的中心极限定理]

E -->|应用领域| I[指数分

```

0

0