【Gensim新手入门】:构建高效词向量模型的7个步骤

发布时间: 2024-09-30 17:59:49 阅读量: 13 订阅数: 19

# 1. Gensim简介与词向量模型基础

在自然语言处理(NLP)的世界中,Gensim 是一个流行的 Python 库,专用于无监督语义建模,它特别专注于主题建模和文档相似性分析。Gensim 擅长处理大型文本集合,尤其是在处理向量化和模型构建方面表现卓越。

## 1.1 Gensim 功能概览

Gensim 的核心功能包括:

- **主题建模:** 使用 Latent Semantic Analysis (LSA) 和 Latent Dirichlet Allocation (LDA) 等算法。

- **词向量模型:** 实现了 Word2Vec 和 FastText 等先进的词嵌入技术。

- **相似性查询:** 提供高效的文档或词向量相似性检索。

- **分布式计算:** 支持并行化处理,以便在多核和集群环境中运行。

## 1.2 词向量模型基础

**词向量** 是将词语转换为数值向量的过程,这些数值向量捕捉了词语的语义信息。模型背后的直觉是,语义上相似的词语应该在向量空间中彼此接近。

### 词向量模型的关键点包括:

- **高维空间:** 单词被嵌入到几百到几千维度的空间中。

- **语义信息:** 通过上下文信息来推断单词的含义。

- **分布式假设:** 相似的上下文意味着相似的单词含义。

词向量模型是现代 NLP 的基石,为机器理解自然语言提供了强大的工具。在此基础上,我们可以构建更复杂的模型,比如文本分类器、聊天机器人等。接下来,我们将深入探讨如何使用 Gensim 构建并训练自己的词向量模型。

# 2. 数据准备与预处理

### 2.1 数据收集和清洗

在构建有效的自然语言处理模型之前,高质量的原始数据是不可或缺的。本节将详细介绍如何确定合适的数据源以及如何使用各种工具抓取所需数据,并介绍一些高效的数据清洗技巧和方法。

#### 2.1.1 确定数据源和抓取工具

在开始数据收集之前,首先需要明确数据的用途以及数据量的要求。例如,如果项目是关于新闻领域的文本分析,那么新闻网站、RSS订阅源和新闻API服务都是合适的数据源。对于社交媒体分析,可能需要Twitter、Reddit等平台的数据。

对于数据抓取,可以使用各种工具,包括但不限于:

- **BeautifulSoup**:用于解析HTML和XML文档,适合于小到中等规模的数据抓取。

- **Scrapy**:一个快速的高层次的网页爬虫框架,适合大规模数据抓取。

- **Requests**:一个简单易用的HTTP库,与BeautifulSoup结合可以方便地发送请求和解析响应。

- **Selenium**:一个用于自动化Web浏览器操作的工具,适合那些需要与JavaScript交互或进行复杂交互的网页抓取。

#### 2.1.2 数据清洗技巧和方法

获取的数据往往包含噪声和无关信息,因此需要进行清洗。以下是一些常见的数据清洗技巧:

- **去除HTML标签**:使用BeautifulSoup等库,可以轻松地从文本中剥离HTML标签。

- **移除特殊字符和数字**:正则表达式可以帮助我们去除文本中的特殊字符和数字,保留单词和标点符号。

- **规范化文本**:转换所有字符为小写,这样“Word”和“word”会被统一处理,便于后续的文本分析。

清洗数据的代码示例如下:

```python

import re

from bs4 import BeautifulSoup

def clean_text(text):

# 移除HTML标签

text = BeautifulSoup(text, "html.parser").get_text()

# 移除特殊字符和数字

text = re.sub(r'[^a-zA-Z\s]', '', text, re.I|re.A)

text = re.sub(r'\d+', '', text)

# 转换为小写

text = text.lower()

return text

# 示例文本

sample_text = "<p>Hello, <b>World</b>! 123#example text.</p>"

print(clean_text(sample_text))

```

### 2.2 文本预处理技术

文本预处理是将原始文本转化为适合机器学习算法处理的格式的关键步骤。本节将探讨分词、去除停用词、词干提取和词形还原等预处理技术。

#### 2.2.1 分词与去除停用词

分词是将连续的文本切分成单独的单词或符号的过程。在英文中,分词相对简单,只需按照空格分隔即可。中文分词则复杂得多,通常需要使用专门的分词工具如HanLP或Jieba。

去除停用词是预处理中的一个常用步骤。停用词是指文本中常见的但对特定任务帮助不大的词语,如“的”、“是”、“在”等。它们在文本中频繁出现,但不会对分析结果产生太大影响。

```python

# 使用nltk库进行英文分词和去除停用词

import nltk

from nltk.corpus import stopwords

nltk.download('punkt')

nltk.download('stopwords')

def tokenize_and_remove_stopwords(text):

words = nltk.word_tokenize(text)

stop_words = set(stopwords.words('english'))

filtered_words = [word for word in words if word.lower() not in stop_words]

return filtered_words

# 示例文本

sample_text = "NLTK is a leading platform for building Python programs to work with human language data."

print(tokenize_and去除停用词使用示例(text))

```

#### 2.2.2 词干提取和词形还原

词干提取和词形还原是处理词汇不同形式的方法。词干提取通常只涉及去除词缀,而词形还原则尝试将词汇还原为其基本形式。

在Python中,可以使用NLTK库的`PorterStemmer`和`WordNetLemmatizer`来进行词干提取和词形还原。

```python

from nltk.stem import PorterStemmer, WordNetLemmatizer

stemmer = PorterStemmer()

lemmatizer = WordNetLemmatizer()

def stem_and_lemmatize(words):

stemmed_words = [stemmer.stem(word) for word in words]

lemmatized_words = [lemmatizer.lemmatize(word) for word in words]

return stemmed_words, lemmatized_words

# 示例文本

sample_words = ["running", "runner", "runs"]

print(stem_and_lemmatize(sample_words))

```

### 2.3 数据集的构建和准备

构建文本语料库和将文档词汇向量化是准备数据集的关键环节。这一步骤为后续模型的训练打下了基础。

#### 2.3.1 构建文本语料库

文本语料库是由大量经过预处理的文本文件组成的集合。语料库中通常包含各种主题的文本,以增加模型的泛化能力。构建语料库一般包括以下步骤:

- **文本采集**:从数据源采集文本数据。

- **文本清洗**:应用前文介绍的清洗技巧去除无关信息。

- **文本分割**:将长文本分割成小片段,如段落或句子。

#### 2.3.2 文档和词汇的向量化

文档向量化是将文本数据转化为数值型数据的过程。常用的方法有:

- **词袋模型(Bag of Words)**:忽略单词的顺序,记录单词在文档中出现的频率。

- **TF-IDF**:在词袋模型的基础上,赋予重要单词更高的权重。

- **Word2Vec**:将单词转化为固定长度的向量,捕捉上下文含义。

以下是一个使用`gensim`库实现Word2Vec的示例代码:

```python

from gensim.models import Word2Vec

from gensim.parsing.preprocessing import preprocess_string

# 示例文本列表

texts = [

"NLTK is a leading platform for building Python programs to work with human language data.",

"Gensim is a Python library for topic modeling, document similarity, and other natural language processing.",

# ... 更多文本

]

# 预处理文本

processed_texts = [preprocess_string(text) for text in texts]

# 训练Word2Vec模型

model = Word2Vec(processed_texts, vector_size=100, window=5, min_count=1, workers=4)

# 查看向量

print(model.wv['python'])

```

构建完语料库和向量化后,数据集就可以用于模型的训练了。在下一章节中,我们将深入探讨Gensim中词向量模型的构建和训练过程。

# 3. Gensim词向量模型的构建与训练

随着本章内容的展开,我们将深入探讨如何使用Gensim库构建和训练词向量模型。我们将从基础模型的介绍开始,然后详细讨论训练过程中参数设置的重要性和方法,以及如何对训练好的模型进行评估和保存。

## 3.1 Gensim中的词向量模型介绍

在深度学习和自然语言处理领域中,词向量模型是一种基础且重要的技术。它将词汇转换为多维的密集向量形式,使得语义上接近的词汇在向量空间中也彼此接近。Gensim是一个强大的库,它提供了多种模型用于训练词向量。

### 3.1.1 Word2Vec模型原理

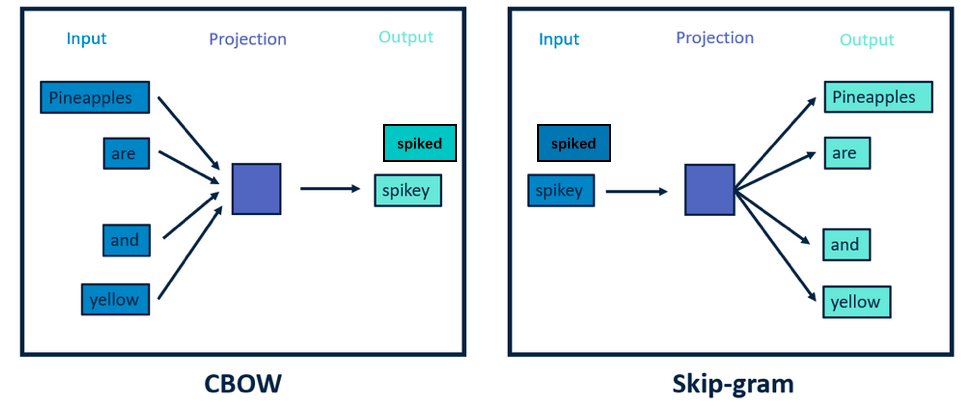

Word2Vec模型是Gensim库中最著名的词向量模型之一。它是由Tomas Mikolov等人在2013年提出的,分为CBOW(Continuous Bag of Words)和Skip-gram两种架构。CBOW模型通过给定上下文来预测目标词,而Skip-gram模型则是通过目标词来预测其上下文。

*CBOW模型*通过一个平均的上下文词向量来预测目标词,这使得它在训练时速度较快,而且对于较常见的词效果更好。而*Skip-gram模型*则预测给定目标词的上下文,这种方法在处理罕见词时更加有效,但它通常需要更长的训练时间,并且需要更大的训练数据集。

### 3.1.2 其他Gensim词向量模型简介

除了Word2Vec模型之外,Gensim还支持其他的词向量模型,例如FastText、GloVe和Text2Vec等。FastText在处理具有大量形态变化的语言时尤其有效,它通过考虑子词信息来学习词向量。GloVe模型则是基于全局词频统计信息来训练词向量,它将统计信息整合进一个全局矩阵中,并通过矩阵分解的方式来学习词向量。

每种模型都有其优势和限制,选择哪种模型取决于具体的应用场景和数据特性。例如,如果数据集较小且关注于对罕见词的表征,FastText可能是更好的选择。而对于需要高效率处理的大规模数据集,Word2Vec可能是更合适的选择。

## 3.2 训练模型的参数设置与优化

在开始训练之前,我们需要理解并设置好各种参数,以确保模型训练的效率和质量。

### 3.2.1 学习率与迭代次数的调整

学习率是控制模型权重更新速度的参数,它对于模型的收敛速度和效果都有重要影响。如果学习率过高,模型可能会震荡甚至发散;如果学习率过低,训练过程又会非常缓慢,甚至陷入局部最优。

迭代次数(epochs)决定了训练数据将被模型学习多少次。过多的迭代次数可能导致过拟合,而太少的迭代次数则可能导致模型未能充分学习数据中的特征。

### 3.2.2 上下文窗口大小与维度设置

上下文窗口大小决定了将多少个词视为目标词的上下文,窗口大小的选择依赖于数据集的特性和研究问题。较小的窗口可能捕捉不到远距离的词汇关系,而较大的窗口可能导致过多的噪声。

维度大小(dimensionality)是指词向量的维度,增加维度可以增加模型的表征能力,但过高的维度也会导致计算成本增加和过拟合的风险。通常,维度大小设置在50到300之间。

## 3.3 模型的评估与保存

完成模型训练后,需要对模型进行评估以确保其质量,并且要妥善保存模型以供后续使用。

### 3.3.1 准确性和效率的评估方法

模型的准确性评估通常可以通过一个独立的测试集进行。对于Word2Vec模型,可以使用类比任务来评估词向量的质量,例如,“man:king::woman:?”通过计算不同候选词(如 queen, palace, husband 等)与目标词(king)之间的余弦相似度,找出最相似的词。

效率评估主要是针对模型的处理速度和内存消耗,这对于将模型部署到生产环境中尤为重要。效率和准确性之间需要进行权衡,以确保模型的实际可用性。

### 3.3.2 模型的存储和加载技巧

模型训练完成后,应将其保存到磁盘以备后用。Gensim提供了简洁的方法来保存和加载模型,这使得我们可以很方便地重新加载训练好的模型进行评估或者应用。

在Python代码中,保存和加载模型的代码如下:

```python

# 保存模型

model.save('word2vec.model')

# 加载模型

from gensim.models import Word2Vec

model = Word2Vec.load('word2vec.model')

```

保存的模型可以用于进一步分析或直接用于下游任务,如文本分类、情感分析等。

通过本章的深入介绍,我们已经对Gensim中的词向量模型的构建与训练有了全面的了解。下一章我们将继续探索基于Gensim模型的文本分析与应用,以及如何将这些模型运用到实际问题中。

# 4. 基于Gensim模型的文本分析与应用

在本章节中,我们将深入探讨如何使用Gensim模型进行文本分析和应用。我们将详细解析词向量相似度计算的方法、探索语义关系的可视化工具,并且讨论模型的微调和领域适应策略。通过这一章节,读者将能够有效地利用Gensim进行实际的文本分析工作,并对模型进行优化以适应特定领域的需求。

## 4.1 词向量相似度计算和应用

### 4.1.1 计算单词间的相似度

在文本分析中,计算单词间的相似度是了解文本内容、进行语义理解和检索的基础。Gensim库中的模型可以有效地计算词向量之间的相似度。词向量是通过训练得到的单词的数值表示,这些向量捕捉了单词之间的语义关系。

一个常用的相似度计算方法是余弦相似度,它测量两个非零向量之间的夹角的余弦值。如果两个词向量的余弦相似度很高,说明这两个词在语义上是相近的。Gensim库中的Word2Vec模型和文档向量模型Doc2Vec都支持计算余弦相似度。

```python

from gensim.models import Word2Vec, KeyedVectors

from sklearn.metrics.pairwise import cosine_similarity

# 加载训练好的Word2Vec模型

model = KeyedVectors.load("word2vec_model.bin")

# 计算两个单词的相似度

word1 = "king"

word2 = "queen"

similarity = model.similarity(word1, word2)

# 打印相似度结果

print(f"The similarity between '{word1}' and '{word2}' is: {similarity}")

# 余弦相似度计算示例

vector1 = model[word1]

vector2 = model[word2]

similarity = cosine_similarity([vector1], [vector2])

print(f"The cosine similarity between '{word1}' and '{word2}' is: {similarity[0][0]}")

```

在上述代码中,我们首先加载了Word2Vec模型,并使用`similarity()`方法直接计算两个单词的相似度。接着,我们展示了如何通过获取两个词向量,并使用`cosine_similarity()`函数来计算它们之间的余弦相似度。这两种方法都可以有效地评估单词间的语义相似度。

### 4.1.2 应用场景:文档分类和主题建模

词向量的相似度计算不仅仅局限于单词间的比较,还可以扩展到文档级别。通过将文档转换为向量表示,可以对文档进行分类和主题建模。文档的向量化可以通过词袋模型(Bag of Words)、TF-IDF或其他向量化技术实现,然后使用词向量模型来增强向量的语义表示。

在文档分类任务中,我们可以使用词向量计算文档间的相似度,然后基于相似度来进行分类决策。主题建模则是识别文档集合中潜藏的主题,可以使用诸如隐含狄利克雷分配(LDA)等算法,结合词向量的语义信息来改进主题的识别质量。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.cluster import KMeans

import numpy as np

# 示例文档集

documents = ["I love natural language processing",

"Text mining is an interesting field",

"Natural language processing is very useful",

"Data mining is not easy"]

# 文档向量化

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(documents)

feature_names = vectorizer.get_feature_names_out()

# 将TF-IDF向量转换为词向量表示

word_vectors = KeyedVectors.load("word2vec_model.bin")

doc_vectors = []

for doc in documents:

word_vecs = [word_vectors[word] for word in doc.split() if word in word_vectors]

if word_vecs:

doc_vector = np.mean(word_vecs, axis=0)

doc_vectors.append(doc_vector)

# K均值聚类进行文档分类

kmeans = KMeans(n_clusters=2, random_state=0).fit(np.array(doc_vectors))

labels = kmeans.labels_

# 打印文档及其分类结果

for i, label in enumerate(labels):

print(f"Document '{documents[i]}' is in cluster {label}")

```

在上面的代码中,我们首先将文档集转换为TF-IDF向量,然后对每个文档中的单词使用Word2Vec模型找到对应的词向量,并计算文档向量的平均值。接着使用K均值聚类算法对文档向量进行聚类,最终得到每个文档的分类结果。这一过程展示了如何利用词向量技术进行文档分类和主题建模的应用。

## 4.2 语义关系的探索与可视化

### 4.2.1 词向量空间的几何性质

词向量模型中,单词在向量空间中的位置具有丰富的语义信息。通过观察和分析词向量在空间中的位置关系,我们可以理解单词之间的语义和句法关系。例如,几何运算如向量加减可以揭示出有趣的语义规律。例如,`king - man + woman` 的结果可能接近 `queen` 的向量表示,这表明模型捕捉到了“国王”和“女王”之间的性别关系。

```python

from gensim.models import KeyedVectors

# 加载预训练的Word2Vec模型

word_vectors = KeyedVectors.load_word2vec_format("word2vec.bin.gz", binary=True)

# 计算词向量运算

result = word_vectors["king"] - word_vectors["man"] + word_vectors["woman"]

# 寻找最接近的词

closest_words = word_vectors.most_similar(positive=[result], topn=5)

print("Closest words to 'king - man + woman':")

for word, similarity in closest_words:

print(f"{word} with similarity {similarity}")

```

在上述代码中,我们通过词向量的加减运算得到一个新的向量,然后使用`most_similar`方法找到与该向量最相似的几个单词。通常我们会发现结果中的单词与“queen”有很高的相似度,这说明模型已经学习到了性别角色的概念。

### 4.2.2 可视化工具和案例分析

为了更好地理解词向量在高维空间中的分布,可视化是一个非常有用的工具。借助可视化,我们可以直观地看到单词间的语义关系和模式。常用的可视化工具包括t-SNE和PCA(主成分分析),它们可以帮助我们将高维向量降维到二维或三维,以便在二维平面上进行观察。

```python

import numpy as np

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

from sklearn.manifold import TSNE

# 使用PCA进行降维

pca = PCA(n_components=2)

pca_result = pca.fit_transform(np.array(doc_vectors))

# 使用t-SNE进行降维

tsne = TSNE(n_components=2, random_state=0)

tsne_result = tsne.fit_transform(np.array(doc_vectors))

# 绘制PCA结果

plt.figure(figsize=(12, 6))

plt.subplot(1, 2, 1)

plt.scatter(pca_result[:, 0], pca_result[:, 1])

plt.title("PCA Visualization")

# 绘制t-SNE结果

plt.subplot(1, 2, 2)

plt.scatter(tsne_result[:, 0], tsne_result[:, 1])

plt.title("t-SNE Visualization")

plt.show()

```

在上面的代码中,我们首先使用PCA对文档向量进行降维处理,并将结果绘制在图上。然后使用t-SNE做同样的降维,并绘制结果进行对比。这两种可视化方法可以帮助我们从不同角度理解词向量在低维空间中的分布,以便于发现数据中可能存在的模式和结构。

## 4.3 模型的微调与领域适应

### 4.3.1 微调现有模型的策略

当利用Gensim训练出词向量模型后,通常需要进行微调以适应特定的任务或领域。微调是指在原有模型的基础上,使用特定领域的新数据进行再训练,以提高模型在该领域的性能。微调时需要考虑保持已有知识和学习新知识之间的平衡,过度微调可能会导致过拟合,而微调不足则无法充分利用领域特定的数据。

```python

from gensim.models import Word2Vec

# 加载预训练模型

model = Word2Vec.load("word2vec_model.bin")

# 微调模型

new_texts = [

"text mining techniques",

"natural language processing trends",

# 添加更多领域特定的语料

]

model.build_vocab(new_texts, update=True)

model.train(new_texts, total_examples=model.corpus_count, epochs=model.epochs)

# 保存微调后的模型

model.save("fine_tuned_word2vec.bin")

```

在上述代码中,我们首先加载了一个预训练的Word2Vec模型,然后使用新的领域特定文本数据对模型进行微调。我们首先使用`build_vocab`方法更新词汇表,然后用`train`方法对模型进行训练。注意,在微调时设置`update=True`允许模型更新已有词汇的向量表示,并学习新词汇的表示。最后,我们保存了微调后的模型以供后续使用。

### 4.3.2 领域特定语料的适应方法

为了使词向量模型更加适应特定的应用领域,我们需要用该领域的语料对模型进行训练。这样可以确保模型学习到的词向量能够反映出领域内的特殊语义和语境。获取领域特定语料的方式通常包括收集专业文本、学术论文、行业报告等。

```python

# 示例:使用领域特定语料进行训练的伪代码

from gensim.models import Word2Vec

# 准备领域特定语料

domain_specific_texts = [

"domain specific sentence one",

"domain specific sentence two",

# 添加更多领域特定的语料

]

# 加载预训练模型(可选)

model = Word2Vec.load("word2vec_model.bin")

# 训练模型

model.build_vocab(domain_specific_texts, update=False)

model.train(domain_specific_texts, total_examples=model.corpus_count, epochs=model.epochs)

# 保存训练后的模型

model.save("domain_specific_word2vec.bin")

```

在上述代码中,我们准备了领域特定的语料并用其训练了一个Word2Vec模型。注意,在调用`build_vocab`时设置`update=False`,意味着我们不会更新原有模型的词汇表,而是用新的语料训练一个新的词汇表。这样可以确保领域特定的词汇被正确地学习和表示。最后保存模型,以便在特定的领域应用中使用。

通过本章节的学习,我们不仅掌握了一般性的Gensim模型使用技巧,还深入理解了如何通过相似度计算和微调等高级技术来增强模型在特定领域的应用效果。我们介绍的案例和代码示例都是基于实际应用和研究需求,目的是让读者能够真正将Gensim库应用到实际工作中,并通过实践提升文本分析能力。在下一章节中,我们将进一步探讨Gensim模型的性能优化和真实世界的应用案例。

# 5. 性能调优与实践案例

性能调优是确保任何机器学习模型,尤其是Gensim模型,能够在实际环境中高效运行的关键。在这一章节中,我们将探讨与Gensim词向量模型相关的高性能计算技巧、内存管理方法,以及如何在生产环境中部署和维护Gensim模型。同时,我们还将通过案例分析,分享如何在实际应用中构建和优化Gensim词向量模型,并从中获得宝贵的实践经验。

## 5.1 高效计算技巧和内存管理

在使用Gensim进行大规模文本数据处理时,计算效率和内存消耗是两个主要关注点。下面我们将深入探讨如何通过更高效的数据结构和内存优化策略来提升性能。

### 5.1.1 使用更高效的数据结构

在Gensim中,词向量通常存储在`KeyedVectors`或`Word2Vec`类的实例中。为了减少内存占用和提高计算速度,可以采用压缩数据结构如`Int32`而不是默认的`Float32`,或者使用稀疏矩阵来存储数据。

**代码块示例**:

```python

from gensim.models import KeyedVectors

import numpy as np

# 加载模型

model = KeyedVectors.load_word2vec_format('model.bin', binary=True)

# 查看默认的向量类型

print(type(model.vectors[0]))

# 使用int32类型优化存储

vectors = np.array(model.vectors).astype('int32')

```

### 5.1.2 内存优化策略

Gensim模型可以非常庞大,尤其是在处理大量词汇的情况下。为了优化内存使用,可以考虑以下几个策略:

1. **分批处理数据**:当处理超出内存容量的数据集时,可以将数据集分成小批次进行处理。

2. **使用`smart_open`库**:对于需要从文件读取大量文本数据的情况,使用`smart_open`可以有效地处理大文件。

3. **内存映射文件**:对于需要访问大模型的场景,可以使用`numpy.memmap`来将模型文件映射到内存,而不是完全加载到内存。

**代码块示例**:

```python

import smart_open

# 使用smart_open来读取大文件

with smart_open.open('large_text_file.txt', 'rb') as fin:

for line in fin:

# 处理每一行

pass

```

## 5.2 Gensim模型的生产环境部署

部署Gensim模型到生产环境涉及多个步骤,包括模型的服务器部署、监控、维护和自动化。

### 5.2.1 模型的服务器部署方法

在服务器上部署Gensim模型涉及以下几个步骤:

1. **选择合适的服务器**:根据模型的大小和预期的负载量,选择具有合适内存和存储空间的服务器。

2. **使用容器技术**:通过Docker等容器技术封装应用,可以简化部署和运维过程。

3. **利用Web框架**:使用如Flask或FastAPI等Web框架,可以将模型封装成API接口供前端或其他服务调用。

**代码块示例**:

```python

# 示例使用Flask创建一个简单的模型服务

from flask import Flask, request, jsonify

from gensim.models import KeyedVectors

app = Flask(__name__)

model = KeyedVectors.load('model.bin')

@app.route('/similar_words', methods=['GET'])

def get_similar_words():

word = request.args.get('word')

topn = int(request.args.get('topn', 10))

return jsonify(model.most_similar(word, topn))

if __name__ == '__main__':

app.run(host='*.*.*.*', port=5000)

```

### 5.2.2 监控和维护生产模型

监控和维护是保证Gensim模型长期稳定运行的重要方面。常见的监控指标包括延迟、吞吐量、内存使用率等。对于维护来说,可以设置自动化的脚本来定期更新模型和进行健康检查。

## 5.3 实际案例分析与经验分享

### 5.3.1 案例研究:构建新闻文章的词向量模型

构建一个用于新闻文章的词向量模型,不仅要考虑文本预处理和模型训练的准确性,还要兼顾性能。以下是一个简化的过程和分析:

1. **数据收集**:利用爬虫从新闻网站抓取文章。

2. **文本预处理**:对文本进行分词、去除停用词、词干提取和词形还原等处理。

3. **模型构建**:使用Gensim的Word2Vec模型训练词向量。

4. **性能优化**:对训练过程中的参数进行优化,并使用压缩数据结构减少内存消耗。

5. **模型评估**:通过相似度计算和主题建模等方法评估模型性能。

### 5.3.2 从实践中获得的经验与教训

在实践过程中,我们发现以下几点对提升Gensim模型性能和稳定性至关重要:

1. **参数调优**:合理设置学习率、迭代次数、维度大小等参数对模型性能有显著影响。

2. **硬件资源管理**:合理分配CPU和内存资源,并使用高效的数据结构和算法。

3. **持续监控和日志记录**:实时监控模型性能,并通过日志记录异常,以便及时响应和处理问题。

通过这些案例和经验分享,我们可以更好地理解在实际应用中如何构建和优化Gensim词向量模型,确保其在处理大量文本数据时的高性能和稳定性。

# 6. 未来趋势与研究方向

## 6.1 Gensim的未来发展方向

### 6.1.1 新兴算法与模型的集成

随着自然语言处理技术的不断进步,未来Gensim将会集成更多的新兴算法和模型,以满足日益增长的用户需求和处理复杂任务的能力。例如,集成基于 transformer 架构的预训练语言模型,如BERT、GPT等,这些模型在多语言理解和文本生成方面表现出色。

```python

from gensim.models import KeyedVectors

from gensim.models import Word2Vec, FastText

# 未来可能集成的模型

transformer_model = KeyedVectors.load_word2vec_format('path/to/transformer_model.bin', binary=True)

```

代码块展示了如何加载一个预先训练好的词向量模型。其中,尽管代码示例是加载一个word2vec格式的文件,未来Gensim可能会直接集成加载其他更先进模型的方式。

### 6.1.2 社区和开发者支持的展望

Gensim的持续发展不仅取决于其自身能力的提升,还依赖于一个活跃的社区和开发者支持。未来,Gensim可能会提供更多工具和框架来简化模型的开发、测试和部署,比如集成CI/CD流程、提供更多的开源示例和教程。

## 6.2 词向量技术的前沿研究

### 6.2.1 跨语言和多模态词向量模型

语言的多样性和多模态信息的融合是当前自然语言处理研究的热点。未来,词向量技术不仅限于处理文本数据,还可能跨入多模态数据处理,如结合图像、音频和视频信息。模型将能够处理跨语言的文本信息,有助于构建更加通用的自然语言处理系统。

```python

from gensim.models import KeyedVectors

# 假设的未来代码,加载跨语言词向量模型

multi_language_model = KeyedVectors.load('path/to/multi_language_model.bin')

```

### 6.2.2 深度学习与词向量技术的融合

深度学习将继续在词向量技术中扮演重要角色,未来的词向量模型将更加深入地与深度学习技术融合。例如,使用神经网络来生成更好的词嵌入,以及利用词向量进行特征提取和增强深度学习模型的性能。

## 6.3 推广和应用的潜在机会

### 6.3.1 行业内的应用案例

随着技术的发展,词向量技术已经在多个行业中得到了应用,如社交媒体分析、搜索引擎优化、情感分析和推荐系统等。未来,更多的行业可能会发现并利用词向量技术的优势,将自然语言处理能力整合到他们的业务中去。

### 6.3.2 未来应用场景的展望

展望未来,词向量技术可能会被运用到更多的场景中,如辅助医疗诊断、智能客服、自动化报告生成等。随着技术的成熟和应用的普及,词向量技术将成为许多行业的必备工具。

通过深入分析和探讨Gensim和词向量技术的未来趋势,我们看到的不仅是技术的前进方向,还有它所带来的潜在改变和创新机会。这不仅能激发研究人员的热情,也能为实际应用的开发者提供指导。随着越来越多的创新和突破,词向量技术将在未来的信息处理领域扮演着核心的角色。

0

0