【Gensim进阶秘籍】:文档相似度分析的优化技巧,让你秒变专家

发布时间: 2024-09-30 18:03:21 阅读量: 67 订阅数: 39

# 1. Gensim简介与文档相似度分析基础

文档相似度分析是自然语言处理(NLP)中的一个重要分支,它的核心目的是衡量两个文档之间的相似性。Gensim是一个广泛使用的Python库,专注于文档相似度分析和主题建模。

## 1.1 Gensim概述

Gensim库专门为处理大量文本数据而设计,它能够高效地实现文档向量化、相似度计算和主题建模等任务。通过Gensim,开发者可以轻松地应用TF-IDF、Word2Vec、LDA等模型进行深度分析。

## 1.2 文档相似度分析基础

文档相似度分析可以简单地理解为找出文本之间的相似关系,这在信息检索、文本挖掘和推荐系统等领域有着广泛的应用。为了计算文档的相似度,我们需要将文档从自然语言转化为机器可以理解的数值形式,即文档向量化。

下面,我们将探讨文档向量化的基础,然后进一步深入到Gensim的高级相似度计算方法,直至讨论其在特定场景的优化应用及未来发展。

# 2. 深入理解文档向量化

## 2.1 向量化模型的原理与选择

### 2.1.1 TF-IDF模型

在处理文本数据时,TF-IDF(Term Frequency-Inverse Document Frequency)是一种广泛应用于信息检索和文本挖掘的加权技术。该模型试图反映一个词对于一个文件集或一个语料库中的其中一份文件的重要程度。该重要程度由两部分组成:词频(TF)和逆文档频率(IDF)。词频表示词条在文档中出现的频率,而逆文档频率则衡量的是一个词在所有文档中出现的频率的逆向指标。

以下是TF-IDF模型的基本计算公式:

```python

def compute_tf(word, doc):

return doc.count(word) / len(doc)

def compute_idf(word, doc_list):

doc_count = sum(1 for doc in doc_list if word in doc)

return math.log(len(doc_list) / (1 + doc_count))

def tf_idf(word, doc, doc_list):

return compute_tf(word, doc) * compute_idf(word, doc_list)

```

在上面的代码中:

- `compute_tf` 函数用于计算词频(TF),表示词在当前文档中出现的频率。

- `compute_idf` 函数用于计算逆文档频率(IDF),表示词的普遍重要性。

- `tf_idf` 函数结合了 TF 和 IDF 的计算结果,得到 TF-IDF 值。

### 2.1.2 Word2Vec模型

Word2Vec 是一种预训练的词嵌入模型,通过训练可以得到每个词的密集向量表示。与TF-IDF不同的是,Word2Vec不是为整个文档生成一个向量,而是为文档中的每个词生成一个向量。Word2Vec 模型基于语料库中的词序列来训练,可以捕捉词之间的关系,使得语义或语法上相似的词在向量空间中距离更近。

### 2.1.3 其他模型对比分析

在文档向量化的过程中,除了TF-IDF和Word2Vec,还有其他多种模型可供选择,包括但不限于 Latent Semantic Analysis (LSA)、Global Vectors (GloVe) 以及最近出现的 BERT。这些模型各有优势,通常的选择依据是具体的应用场景和性能需求。

- **LSA**(隐语义分析)通过奇异值分解(SVD)来发现文档中的隐含主题,可以捕捉词语之间的隐含联系。

- **GloVe** 是一种基于全局矩阵分解的词嵌入方法,结合了全局词频统计和局部上下文窗口的优势,因此在某些情况下比 Word2Vec 表现更好。

- **BERT**(双向编码器表示)模型在大规模文本语料上预训练后,能够生成更深一层的语义嵌入,适合捕捉句子乃至文档级别的语义。

## 2.2 文档向量的构建与优化

### 2.2.1 文档预处理技巧

文档预处理是向量化过程的第一步,目的是将文本转换为机器可以理解的格式。常用的预处理步骤包括:

- **分词(Tokenization)**:将文档文本分割成单独的词语或符号。

- **去除停用词(Stopword Removal)**:删除语言中的常用词,如“的”、“和”、“在”等,这些词往往不具备区分度。

- **词干提取/词形还原(Stemming/Lemmatization)**:将单词还原为基本形式,词干提取比词形还原更激进,可能导致非词汇项。

- **大小写归一化(Case Normalization)**:将所有字符转换为小写或大写,以消除大小写变化带来的影响。

### 2.2.2 向量化参数调整与优化

在向量化过程中,需要对参数进行调整和优化,以达到更好的结果。以TF-IDF为例,常见的参数调整包括:

- **n-gram**:除了单个词以外,也可以考虑相邻的两个词(bigram)或三个词(trigram)来捕捉短语信息。

- **权重归一化**:通过标准化处理,可以减少高频词对最终结果的影响。

- **文档长度标准化**:对每个文档的向量进行标准化处理,以确保文档长度不会对向量值产生不公平的影响。

### 2.2.3 向量化流程的代码实现

下面展示了如何使用Python中的Scikit-learn库来实现文档的TF-IDF向量化过程。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.feature_extraction.text import CountVectorizer

# 示例文档数据集

doc_list = [

"This is the first document.",

"This document is the second document.",

"And this is the third one.",

"Is this the first document?",

]

# 使用TF-IDF模型

tfidf_vectorizer = TfidfVectorizer()

tfidf_matrix = tfidf_vectorizer.fit_transform(doc_list)

# 转换为数组形式以便分析

tfidf_array = tfidf_matrix.toarray()

# 打印每个文档的TF-IDF向量

for doc_id, vector in enumerate(tfidf_array):

print(f"Document {doc_id}:")

print(vector)

```

上述代码段执行了以下步骤:

- 导入必要的Scikit-learn模块。

- 定义了一个文档列表作为示例数据。

- 初始化`TfidfVectorizer`,并使用`.fit_transform()`方法应用到文档数据上,得到TF-IDF矩阵。

- 将TF-IDF矩阵转换为数组格式,便于展示和进一步分析。

- 遍历每个文档,并打印出对应的TF-IDF向量。

在实际应用中,向量化过程会根据具体需求调整参数,以达到最佳效果。通过本章节的介绍,我们了解了文档向量化的重要性以及不同模型的原理和应用。在下一小节中,我们将深入探讨向量化参数的调整与优化策略。

# 3. Gensim的高级相似度计算方法

在处理文本数据时,计算文档间的相似度是一项核心任务。Gensim库不仅支持传统的TF-IDF和Word2Vec等向量化方法,还提供多种高级相似度计算手段,让文本分析的精确度和效率得到提升。本章将深入探讨这些高级相似度计算方法,并分享在实践中的技巧和性能优化策略。

## 3.1 相似度计算理论框架

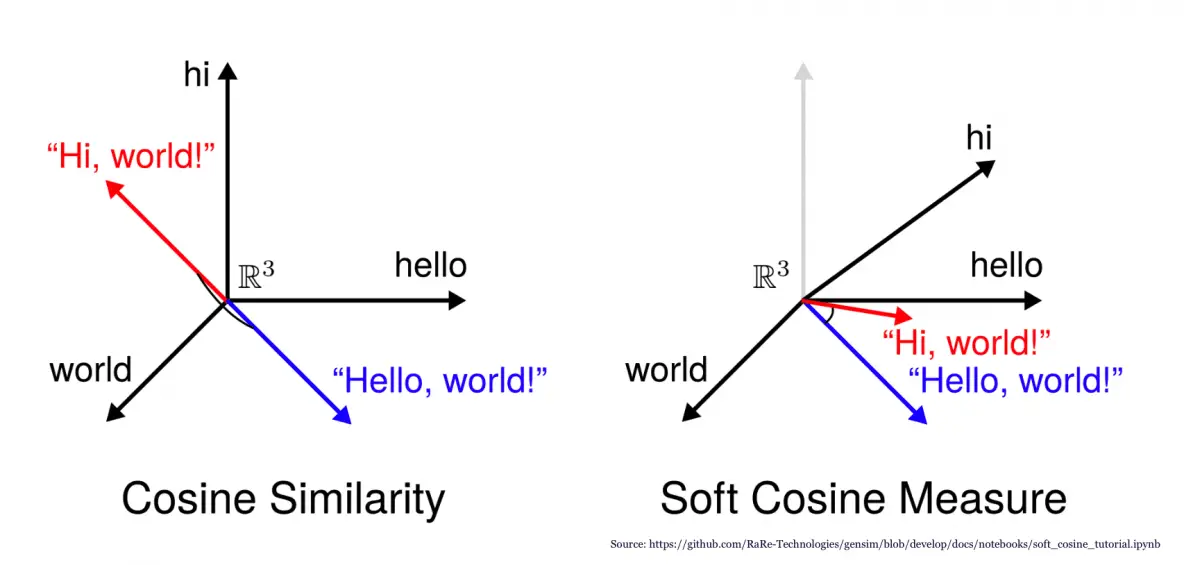

### 3.1.1 余弦相似度

余弦相似度是衡量两个非零向量空间中夹角的余弦值,该值反映了两个向量的相似程度。在文档相似度计算中,通常用于衡量不同文档向量之间的相似性。余弦相似度的计算公式为:

\[ \text{similarity} = \frac{\sum_{i=1}^{n}A_i \times B_i}{\sqrt{\sum_{i=1}^{n}{A_i}^2} \times \sqrt{\sum_{i=1}^{n}{B_i}^2}} \]

其中,\(A_i\) 和 \(B_i\) 分别是两个文档向量的分量。

在Python中,使用Gensim库计算两个文档的余弦相似度可以通过以下代码实现:

```python

from gensim import corpora, models

from gensim.matutils import cossim

# 假设我们已经有了两个文档向量 doc_vec1 和 doc_vec2

doc_vec1 = [...] # 文档1的向量

doc_vec2 = [...] # 文档2的向量

# 计算余弦相似度

similarity = cossim(doc_vec1, doc_vec2)

print("The cosine similarity is:", similarity)

```

### 3.1.2 Jaccard相似度

Jaccard相似度用于衡量两个集合的相似程度,它通过集合交集的大小除以集合并集的大小来计算。在文档相似度计算中,可以将文档看作是由词项组成的集合。

计算公式如下:

\[ \text{Jaccard Similarity} = \frac{A \cap B}{A \cup B} \]

其中,\(A\) 和 \(B\) 分别是两个文档的词项集合。

在Python中,可以利用集合运算来计算Jaccard相似度:

```python

# 假设我们有两个文档的词项集合 set_a 和 set_b

set_a = set([...]) # 文档1的词项集合

set_b = set([...]) # 文档2的词项集合

# 计算Jaccard相似度

similarity = len(set_a.intersection(set_b)) / len(set_a.union(set_b))

print("The Jaccard similarity is:", similarity)

```

### 3.1.3 相似度计算的其他方法

除了余弦相似度和Jaccard相似度之外,还有许多其他方法可用于文档相似度计算,例如:

- **欧氏距离(Euclidean distance)**:衡量空间中两点之间的直线距离。

- **皮尔逊相关系数(Pearson correlation)**:衡量两个变量之间的线性相关性。

- **Sørensen–Dice系数**:与Jaccard相似度类似,但权重不同。

每种方法都有其独特的应用场景和优势,选择合适的相似度计算方法取决于具体的业务需求和数据特征。

## 3.2 实践中的相似度计算技巧

### 3.2.1 相似度计算的性能优化

随着文档数量的增加,相似度计算的性能成为一大挑战。性能优化的关键在于减少不必要的计算和使用高效的数据结构。

一个常见的优化技巧是使用近似最近邻搜索(Approximate Nearest Neighbors),这种方法通过牺牲一定的精度来获得更快的搜索速度。例如,Gensim提供了`ANN`模块来实现这一点。

```python

from gensim.similarities import AnnArray

# 假设我们已经有了一个文档向量矩阵 doc_vec_matrix

doc_vec_matrix = [...] # 文档向量矩阵

# 创建近似最近邻搜索对象

ann_array = AnnArray(doc_vec_matrix, num_best=10, threshold=1.0)

# 查询相似度

doc_id = 0 # 需要查询相似度的文档索引

similar_docs = ann_array[doc_id]

```

### 3.2.2 大规模数据集的相似度计算

大规模数据集的相似度计算通常需要分布式处理或流式计算。Gensim支持使用Redis作为后端,以实现高效的相似度计算。

```python

from gensim.similarities import SoftCosineSimilarity

from gensim.similarities.annoy import AnnoyIndexer

import redis

# 连接到Redis服务器

redis_server = redis.StrictRedis(host='localhost', port=6379, db=0)

# 使用Annoy构建索引

analyzer = ... # 文档分析器,如Word2Vec模型

index = AnnoyIndexer(analyzer, numTrees=10)

# 创建软余弦相似度搜索对象

index = SoftCosineSimilarity(doc_vec_matrix, index, num_best=10)

index.save('/path/to/index')

# 从Redis加载索引

index = SoftCosineSimilarity.load('/path/to/index', redis_server)

```

### 3.2.3 结果的评估与误差分析

评估相似度计算结果的准确性至关重要。常见的评估指标包括:

- **准确率(Precision)**:检索出的相关文档占所有检索出文档的比例。

- **召回率(Recall)**:检索出的相关文档占所有相关文档的比例。

- **F1分数(F1 Score)**:准确率和召回率的调和平均数。

使用这些指标可以帮助我们理解模型的性能,并进行相应的误差分析:

```python

from sklearn.metrics import precision_score, recall_score, f1_score

# 假设 pred 和 true 分别是相似度计算结果和真实标签

pred = [...] # 预测标签

true = [...] # 真实标签

# 计算各种评估指标

precision = precision_score(true, pred)

recall = recall_score(true, pred)

f1 = f1_score(true, pred)

print("Precision:", precision)

print("Recall:", recall)

print("F1 Score:", f1)

```

通过这些评估方法,我们能深入分析相似度计算中可能出现的问题,并持续优化模型性能。

# 4. Gensim在特定应用场景下的优化

Gensim库以其简洁的API和高效的文档处理能力受到数据科学家的青睐,尤其在文本相似度分析方面,它的应用范围已不限于英文领域。本章节将深入探讨Gensim在特定场景下的优化策略,涵盖特定领域文档的相似度分析、跨语言文档相似度分析以及实时文档相似度分析。

## 4.1 特定领域文档的相似度分析

在特定领域内进行文档相似度分析时,对于领域知识的理解以及领域相关特征的提取至关重要。领域内文档通常涉及特定的术语和表达方式,这要求我们在预处理和特征提取时需要考虑到这些因素。

### 4.1.1 领域数据的预处理

在处理特定领域文档时,普通的文本预处理步骤如分词、去除停用词等可能不足以应对领域特有的问题。例如,在医学领域,专业术语、缩写词和复杂的词汇组合是常见的,这就要求我们开发专门的分词规则或者引入特定领域的词典来准确地进行文本预处理。

```python

# 示例代码块:领域特定的文本预处理流程

from gensim.parsing.preprocessing import preprocess_string

import re

def domain_specific_preprocessing(text):

# 定义领域特定的分词规则

pattern = ***pile(r'\b(?:medication|diagnosis|treatment)\b', re.IGNORECASE)

text = pattern.sub(lambda match: '<{}>'.format(match.group()), text)

# 应用通用的文本预处理步骤

processed_text = preprocess_string(text)

return processed_text

# 示例文本

sample_text = "The new medication prescribed for your diagnosis has shown significant improvement in treatment."

# 执行领域特定的预处理

processed_text = domain_specific_preprocessing(sample_text)

print(processed_text)

```

在上述代码中,我们首先定义了一个正则表达式模式来识别特定的领域术语,并在文本中用标记替换。然后,我们使用了Gensim的`preprocess_string`方法来进行通用的文本预处理,如转换为小写、去除标点和数字等。

### 4.1.2 领域相关特征的提取

对于特定领域,可以通过构建专门的词汇表和模式识别来提取更有意义的特征。在某些情况下,向量化模型需要针对领域内的数据进行微调,以便更好地捕捉文档间的相似性。

```python

# 示例代码块:领域相关特征的提取

from gensim.models import Word2Vec

# 假设我们已经有一个特定领域的大规模文本语料库

domain_corpus = [...]

# 使用Word2Vec模型来提取特征,注意这一步可能需要对模型进行领域特定的微调

model = Word2Vec(domain_corpus, vector_size=100, window=5, min_count=1, workers=4)

# 从模型中提取文档向量

def extract_features(doc):

return model.wv[doc]

# 为示例文本提取特征

document_features = extract_features(processed_text)

```

在本例中,我们首先构建了一个Word2Vec模型来捕捉领域内词汇之间的关系。之后,我们定义了一个函数`extract_features`来为给定的文档提取特征向量。尽管此处未深入展示,实际应用中对Word2Vec模型的微调将是必要的,可能包括调整窗口大小、最小计数等参数,以优化模型在特定领域的表现。

## 4.2 跨语言文档相似度分析

处理跨语言文档的相似度分析时,语言差异带来的挑战比领域特异性问题更为复杂。在不同语言间寻找文档相似度,首先需要解决的是语言理解的差异性,其后需要提取语言无关的特征以实现有效匹配。

### 4.2.1 语言模型的构建

构建跨语言文档相似度分析的系统时,首先需要针对每种语言构建独立的语言模型,并进行向量化处理。

```python

# 示例代码块:跨语言文档的向量化处理

from gensim.models import FastText

# 假设我们有两组文档,一组是中文文档,另一组是英文文档

chinese_corpus = [...]

english_corpus = [...]

# 分别为中文和英文文档构建模型

chinese_model = FastText(chinese_corpus, vector_size=300, window=5, min_count=5, sg=1)

english_model = FastText(english_corpus, vector_size=300, window=5, min_count=5, sg=1)

# 为中文和英文文档分别提取向量表示

chinese_vectors = [chinese_model.wv[word] for word in chinese_corpus]

english_vectors = [english_model.wv[word] for word in english_corpus]

```

在上述代码中,我们使用了Gensim中的FastText模型分别对中文和英文语料进行向量化处理。FastText通过考虑子词单元的方式,对于包含丰富形态变化的语言,如中文,能够提供更好的表征。在实际操作中,由于跨语言的特性,可能还需要结合语言模型的多语种版本或者通过多语言嵌入空间来实现。

### 4.2.2 语言无关特征的提取

跨语言文档相似度分析中,需要提取那些不受语言限制的特征,如主题分布、关键词等。这些特征往往能够跨越语言障碍,找到文档内容层面的相似性。

```python

# 示例代码块:跨语言文档相似度分析

from sklearn.feature_extraction.text import TfidfVectorizer

from scipy.spatial.distance import cosine

# 假设我们有一组跨语言文档,已经被翻译成一种共同语言

translated_corpus = [...]

# 使用TF-IDF模型提取特征

tfidf_vectorizer = TfidfVectorizer()

tfidf_matrix = tfidf_vectorizer.fit_transform(translated_corpus)

# 计算两篇文档间的余弦相似度

def calculate_cosine_similarity(doc1, doc2):

vec1 = tfidf_matrix[doc1]

vec2 = tfidf_matrix[doc2]

return 1 - cosine(vec1, vec2)

# 假设doc_index1和doc_index2是我们要计算相似度的文档索引

similarity_score = calculate_cosine_similarity(doc_index1, doc_index2)

print(f"相似度评分:{similarity_score}")

```

本节中,我们利用了TF-IDF模型对一组已经翻译好的跨语言文档进行特征提取。然后,通过计算得到的TF-IDF向量之间的余弦相似度,来量化文档间的相似性。

### 4.2.3 实例分析:跨语言文档匹配

为了更具体地说明如何进行跨语言文档的相似度分析,我们可以设想一个案例:一家跨国公司的客户服务部门希望自动匹配客户查询和常见问题解答(FAQs)。通过使用上述技术,我们可以首先将客户查询和FAQs翻译成同一语言,然后运用TF-IDF和余弦相似度来找到最相关的FAQs。

## 4.3 实时文档相似度分析

在需要对实时数据流进行处理的场景下,例如社交媒体监控或新闻聚合,能够迅速地识别相似文档是至关重要的。为了达到这一目的,必须考虑如何有效地在流数据上实施相似度分析。

### 4.3.1 实时数据流的处理

处理实时数据流时,数据通常会以连续的流形式到达。为了有效地进行相似度分析,需要一个能够不断学习并快速响应的系统。

```python

# 示例代码块:使用gensim在线模型处理实时数据流

from gensim.models import OnlineLDA

# 假设我们有一个实时数据流

streaming_corpus = [...]

# 初始化在线LDA模型

lda_model = OnlineLDA(corpus=streaming_corpus, num_topics=10, alpha=0.1, beta=0.1, decay=0.5)

# 在数据到达时不断更新模型

for document in streaming_corpus:

lda_model.update([document])

```

在上述代码中,我们使用了Gensim的`OnlineLDA`模型来处理实时数据流。该模型适合于连续的数据流,因为它能够通过不断更新来反映最新的数据分布。

### 4.3.2 在线学习模型的应用

在线学习模型可以在不断接收新数据的同时更新自身状态,这对于实时数据流分析来说至关重要。在相似度分析的场景下,这意味着模型能够根据新到的数据调整其参数,从而保持对当前数据的敏感性。

```python

# 示例代码块:在线学习模型在相似度分析中的应用

# 假设我们已经有了一个更新后的在线学习模型

# 现在需要实时计算新文档与现有文档集之间的相似度

def online_similarity_analysis(new_doc, model):

new_doc_vector = model.inference([new_doc])[0]

similarities = []

for doc in model.corpus:

doc_vector = model.inference([doc])[0]

similarity = 1 - cosine(new_doc_vector, doc_vector)

similarities.append(similarity)

return similarities

# 假设new_doc是新到达的文档,model是已经更新的在线LDA模型

similarities = online_similarity_analysis(new_doc, lda_model)

```

在本示例中,我们定义了一个函数`online_similarity_analysis`,它接收一个新文档并使用已经更新的在线LDA模型来计算它与当前数据集中文档的相似度。

### 4.3.3 实时分析的性能挑战

实时文档相似度分析面临的一个主要挑战是性能。当数据流不断涌入时,如何在保证计算效率的同时,实现对新数据的有效学习和处理,是实现高效实时分析的关键。

```mermaid

graph LR

A[数据流到达] --> B[在线模型更新]

B --> C[相似度分析]

C --> D[返回分析结果]

```

上图展示了实时分析的流程,其中,数据流持续不断地到达,并触发在线模型的更新和相似度分析的计算。在实际操作中,可能需要考虑多种策略来提升性能,例如使用多线程处理、优化数据结构或者使用分布式系统来处理大规模的实时数据。

通过本章的介绍,我们已经了解到如何在特定应用场景下对Gensim进行优化。从领域特定的文档预处理和特征提取,到跨语言文档的匹配,再到对实时数据流的高效分析,每一种场景都展现了Gensim强大的适应性和扩展性。接下来,我们将进入Gensim的扩展应用与未来发展,探索其如何与其他工具集成以及未来的改进和演进方向。

# 5. Gensim的扩展应用与未来发展

Gensim库在自然语言处理领域内已经得到了广泛的应用,但其潜力远不止于此。本章节将探讨Gensim如何与其他工具集成,其性能改进和优化方法,以及未来可能的发展方向。

## 5.1 Gensim与其他工具的集成

随着机器学习和大数据技术的不断发展,Gensim也需要与其他工具相结合以拓展其应用范围。

### 5.1.1 与机器学习框架的结合

Gensim库支持将文档向量作为特征输入,用于构建监督学习模型。对于需要将文本数据转换为数值特征的机器学习算法,Gensim提供了一个理想的中间件。

- **使用Scikit-Learn与Gensim集成**

Scikit-Learn是Python中广泛使用的机器学习库。我们可以利用Gensim来生成文档向量,然后使用Scikit-Learn进行分类或回归任务。

```python

from gensim.models import Word2Vec

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import accuracy_score

# 假设已经有了分词后的文档数据

documents = ['document1', 'document2', ...]

# 使用Word2Vec生成文档向量

model = Word2Vec(sentences=documents, vector_size=100, window=5, min_count=1, workers=4)

# 获取文档向量

X = [model.wv.doc2vec(doc) for doc in documents]

# 假设已经有了标签数据

y = [0, 1, ...] # 分类标签

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# 使用随机森林分类器进行分类

classifier = RandomForestClassifier()

classifier.fit(X_train, y_train)

# 预测测试集结果

y_pred = classifier.predict(X_test)

# 计算准确度

accuracy = accuracy_score(y_test, y_pred)

print(f'Accuracy: {accuracy:.2f}')

```

上述代码段展示了如何将Word2Vec生成的文档向量集成到Scikit-Learn的随机森林分类器中。

### 5.1.2 与大数据技术的整合

对于大数据技术,Gensim可以与Apache Spark等框架集成,处理大规模文本数据集。

- **使用PySpark集成Gensim**

PySpark是Spark的Python API,它可以和Gensim一起处理分布式文本数据。

```python

from pyspark.ml.feature import Word2Vec

from pyspark.sql import SparkSession

# 初始化Spark

spark = SparkSession.builder.appName('GensimIntegration').getOrCreate()

# 加载数据

documents = spark.createDataFrame([

(['word1', 'word2', 'word3']),

(['word4', 'word5', 'word6']),

...

], ['doc'])

# 构建Word2Vec模型

word2vec = Word2Vec(vectorSize=100, minCount=2, inputCol="doc", outputCol="result")

# 训练模型

model = word2vec.fit(documents)

# 对文档进行向量化处理

result = model.transform(documents)

# 展示结果

result.show()

```

在这个例子中,我们利用PySpark加载数据,然后通过Word2Vec模型处理这些数据,最终得到文档向量。

## 5.2 Gensim的性能改进与优化

Gensim库本身也有优化的空间,特别是在处理大量数据时。

### 5.2.1 并行计算在Gensim中的应用

为了提高计算效率,Gensim可以利用多核处理器进行并行计算。

- **Gensim的并行计算选项**

大多数Gensim的模型支持多线程处理,通过设置`workers`参数可以调整并行工作的线程数。

```python

model = Word2Vec(sentences=documents, vector_size=100, window=5, min_count=1, workers=4)

```

在这个例子中,`workers`参数被设置为4,意味着在训练模型时,最多可以同时运行4个线程进行处理。

### 5.2.2 代码级别的优化技巧

代码级别的优化可以大幅提高Gensim的性能,包括内存管理、使用更有效的数据结构等。

- **使用更高效的数据结构**

在Gensim模型训练前,对文本数据进行预处理,例如使用`gensim.utils.simple_preprocess`简化预处理步骤,并使用`smart_open`库读取大文件,从而提高内存使用效率。

```python

from gensim.utils import simple_preprocess

from smart_open import smart_open

# 使用smart_open库读取数据

with smart_open('large_text_file.txt') as fin:

for line in fin:

# 对每行文本进行预处理

doc = simple_preprocess(line, deacc=True)

# 处理向量化等操作

...

```

## 5.3 Gensim的未来发展方向

Gensim作为文档相似度分析的利器,未来还有很多可能的发展方向。

### 5.3.1 算法创新与模型演进

随着研究的进步,Gensim可能会集成更多的先进算法,如BERT等预训练语言模型。

### 5.3.2 社区贡献与生态系统构建

Gensim的未来发展离不开社区的贡献。通过建立一个更加开放和协作的生态系统,Gensim可以不断进步和完善。

通过集成新的算法、优化性能和推动社区发展,Gensim将继续巩固其在文档相似度分析领域的领导地位,并在自然语言处理的其他方面发挥重要作用。

0

0