深度强化学习中的可解释性:理解模型决策的依据,构建透明人工智能

发布时间: 2024-08-21 12:19:04 阅读量: 93 订阅数: 28

基于深度强化学习的资源调度研究.zip

# 1. 深度强化学习简介**

深度强化学习(DRL)是一种机器学习方法,它使代理能够通过与环境交互来学习最佳行为。与监督学习不同,DRL 不依赖于标记数据集,而是通过试错来学习。

DRL 模型由以下组件组成:

* **代理:**与环境交互并采取行动的实体。

* **环境:**代理与其交互的外部世界,提供奖励和惩罚。

* **奖励函数:**定义代理行为的期望结果。

DRL 算法使用值函数或策略函数来指导代理的行为。值函数估计特定状态下的预期奖励,而策略函数确定代理在给定状态下采取的最佳行动。

# 2. 可解释性在深度强化学习中的重要性

可解释性在深度强化学习中至关重要,因为它为模型开发和部署以及伦理和社会影响提供了关键的见解。

### 2.1 可解释性对模型开发和部署的影响

**模型开发**

* **调试和故障排除:**可解释性有助于识别模型中的错误和偏差,从而简化调试和故障排除过程。

* **模型选择:**通过了解不同模型的决策过程,可以对模型进行明智的选择,以满足特定任务和应用的需求。

* **超参数优化:**可解释性可以指导超参数优化,帮助确定影响模型性能的关键参数。

**模型部署**

* **信任和可靠性:**可解释性增强了对模型决策的信任,提高了模型的可靠性和可接受性。

* **风险管理:**通过了解模型的决策过程,可以识别和减轻潜在风险,确保模型安全和负责任地部署。

* **持续监控:**可解释性允许持续监控模型的性能,检测性能下降或偏差,并及时采取纠正措施。

### 2.2 可解释性对伦理和社会影响

**伦理影响**

* **公平性:**可解释性有助于确保模型决策的公平性,防止歧视或偏见。

* **透明度:**可解释性增强了模型的透明度,使利益相关者能够理解和评估模型的决策过程。

* **问责制:**可解释性促进了问责制,允许对模型的决策进行审查和质疑。

**社会影响**

* **社会接受度:**可解释性提高了公众对深度强化学习模型的接受度,因为它增强了对模型决策的理解和信任。

* **政策制定:**可解释性为政策制定者提供了信息,使他们能够制定明智的监管措施,以确保人工智能系统的安全和负责任的使用。

* **教育和培训:**可解释性促进了对深度强化学习模型的教育和培训,使更广泛的受众能够理解和使用这些模型。

# 3.1 基于规则的方法

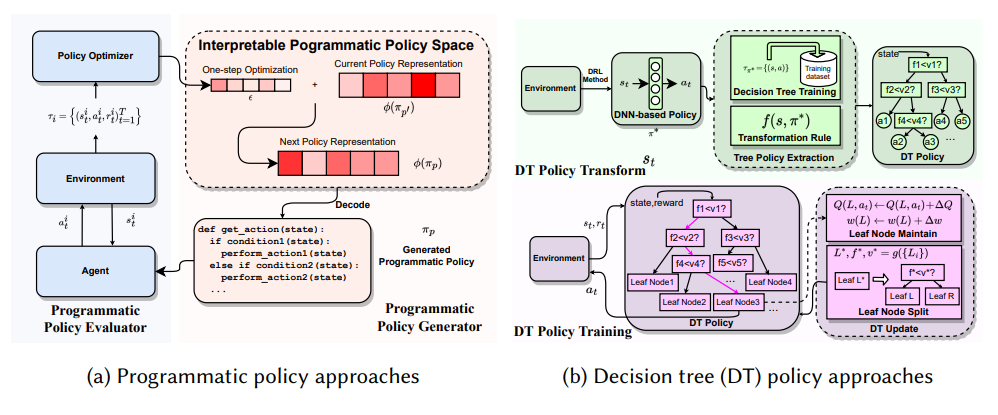

基于规则的方法将深度强化学习模型表示为一组规则或决策树。这些规则或决策树可以手动创建,也可以通过从数据中学习自动生成。

**3.1.1 决策树**

决策树是一种树形结构,其中每个内部节点表示一个特征,每个叶节点表示一个决策。在预测时,模型通过从根节点开始并根据观察到的特征值向下遍历树,直到到达叶节点,从而对新数据点进行预测。

```python

# 导入决策树库

from sklearn.tree import DecisionTreeClassifier

# 创建决策树分类器

clf = DecisionTreeClassifier()

# 训练决策树

clf.fit(X_train, y_train)

# 预测新数据点

y_pred = clf.predict(X_test)

```

**逻辑分析:**

* `DecisionTreeClassifier()` 创建一个决策树分类器。

* `fit()` 方法使用训练数据训练决策树。

* `predict()` 方法使用决策树对新数据点进行预测。

**参数说明:**

* `criterion`:决策树分裂节点时使用的准则,默认值为“基尼不纯度”。

* `max_depth`:决策树的最大深度,默认值为无穷大。

* `min_samples_split`:每个内部节点所需的最少样本数,默认值为 2。

* `min_samples_leaf`:每个叶节点所需的最少样本数,默认值为 1。

**3.1.2 决策图**

决策图是一种有向图,其中节点表示状态或动作,而边表示状态或动作之间的转换。决策图可以手动创建,也可以通过从数据中学习自动生成。

```mermaid

graph LR

A[Start] --> B[State 1]

B

```

0

0