深度强化学习与传统机器学习的比较:优势与局限,洞悉技术差异

发布时间: 2024-08-21 12:23:31 阅读量: 170 订阅数: 37

# 1. 深度强化学习与传统机器学习的概述**

深度强化学习(DRL)和传统机器学习(ML)都是机器学习领域的重要分支,但它们在目标、方法和应用上存在着显著差异。

**1.1 目标**

* **传统ML:**从标记数据中学习特定任务的输入-输出映射。

* **DRL:**在交互式环境中通过试错学习最佳行为策略,以最大化长期奖励。

**1.2 方法**

* **传统ML:**使用监督学习或无监督学习算法从数据中提取模式。

* **DRL:**使用强化学习算法,通过与环境交互并接收奖励信号来更新策略。

**1.3 应用**

* **传统ML:**图像分类、自然语言处理、预测建模。

* **DRL:**机器人控制、游戏、资源优化。

# 2. 深度强化学习的优势

### 2.1 深度强化学习的模型表征能力

#### 2.1.1 神经网络的强大表征能力

深度强化学习利用神经网络作为其模型表征,而神经网络具有强大的表征能力。神经网络可以从数据中学习复杂模式和非线性关系,这使其能够有效地处理高维和连续的状态空间。

#### 2.1.2 连续动作空间和高维状态空间的处理

传统机器学习算法通常假设动作空间是离散的,状态空间是低维的。然而,在许多实际应用中,动作空间是连续的,状态空间是高维的。深度强化学习通过使用神经网络作为模型表征,可以有效地处理连续动作空间和高维状态空间。

### 2.2 深度强化学习的决策能力

#### 2.2.1 值函数和策略函数的估计

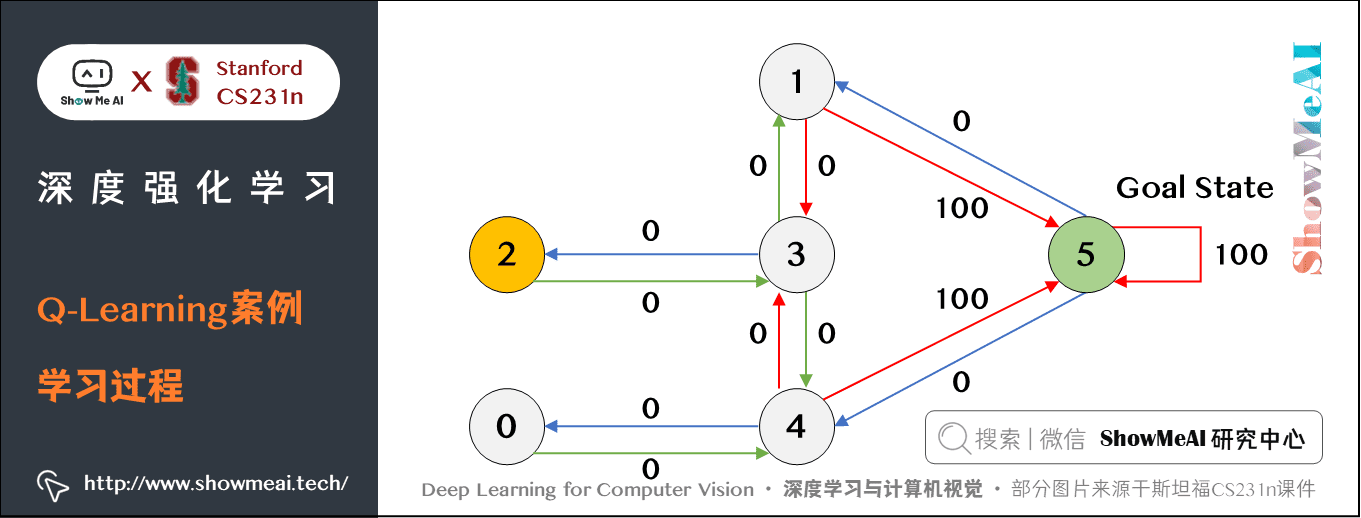

深度强化学习算法通过估计值函数和策略函数来做出决策。值函数估计状态的价值,而策略函数估计采取特定动作的价值。通过迭代地更新值函数和策略函数,深度强化学习算法可以学习最优策略,即在给定状态下采取的最佳动作。

#### 2.2.2 探索与利用的平衡

在强化学习中,探索与利用之间的平衡至关重要。探索涉及尝试新动作以发现更好的策略,而利用涉及利用当前策略以最大化奖励。深度强化学习算法使用各种技术来平衡探索与利用,例如 ε-贪婪策略和软马尔可夫决策过程。

```python

import numpy as np

def epsilon_greedy_policy(Q, state, epsilon):

"""

ε-贪婪策略

参数:

Q: 值函数

state: 当前状态

```

0

0